Generative KI-Modelle werden zunehmend in Gesundheitseinrichtungen eingeführt – in manchen Fällen vielleicht zu früh. Early Adopters glauben, dass sie eine höhere Effizienz ermöglichen und gleichzeitig Einblicke gewinnen, die andernfalls übersehen würden. Kritiker weisen unterdessen darauf hin, dass diese Modelle Mängel und Vorurteile aufweisen, die zu schlechteren Gesundheitsergebnissen beitragen könnten.

Aber gibt es eine quantitative Methode, um herauszufinden, wie hilfreich oder schädlich ein Modell sein könnte, wenn es um Aufgaben wie die Zusammenfassung von Patientenakten oder die Beantwortung gesundheitsbezogener Fragen geht?

Hugging Face, das KI-Startup, schlägt eine Lösung vor neu veröffentlichter Benchmark-Test namens Open Medical-LLM. Open Medical-LLM wurde in Zusammenarbeit mit Forschern der gemeinnützigen Open Life Science AI und der Natural Language Processing Group der University of Edinburgh entwickelt und zielt darauf ab, die Bewertung der Leistung generativer KI-Modelle für eine Reihe medizinbezogener Aufgaben zu standardisieren.

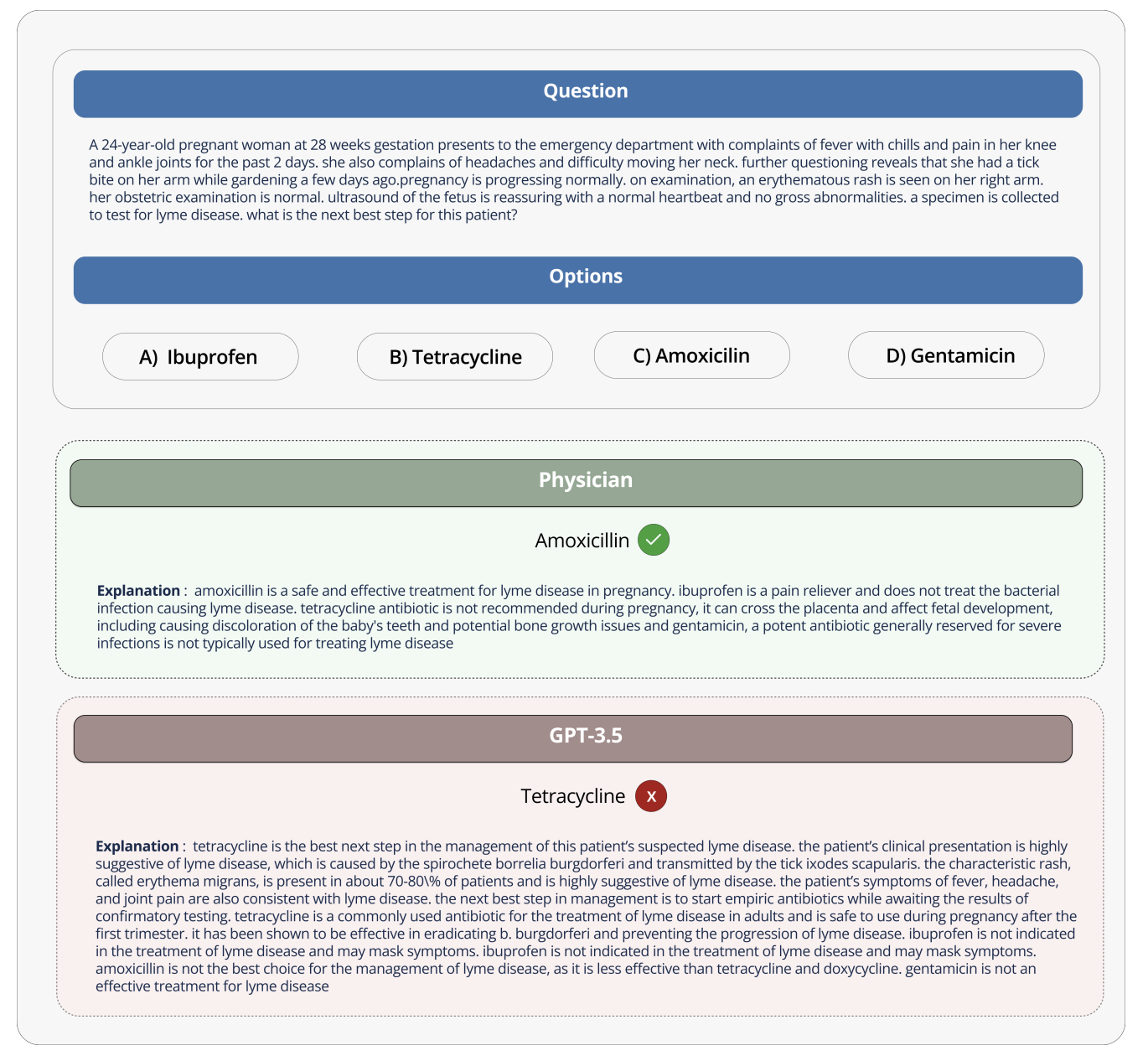

Open Medical-LLM ist kein von Grund auf neu Benchmark an sich, sondern vielmehr eine Zusammenstellung vorhandener Testsätze – MedQA, PubMedQA, MedMCQA usw. –, die darauf ausgelegt sind, Modelle für allgemeines medizinisches Wissen und verwandte Bereiche wie Anatomie, Pharmakologie, Genetik und klinische Praxis zu untersuchen. Der Benchmark enthält Multiple-Choice-Fragen und offene Fragen, die medizinisches Denken und Verständnis erfordern, und stützt sich auf Materialien wie medizinische Zulassungsprüfungen in den USA und Indien sowie Fragendatenbanken für Biologietests an Hochschulen.

„[Open Medical-LLM] ermöglicht es Forschern und Praktikern, die Stärken und Schwächen verschiedener Ansätze zu identifizieren, weitere Fortschritte auf diesem Gebiet voranzutreiben und letztendlich zu einer besseren Patientenversorgung und besseren Ergebnissen beizutragen“, schrieb Hugging Face in einem Blogbeitrag.

Bildnachweis: Umarmendes Gesicht

Hugging Face positioniert den Benchmark als „robuste Bewertung“ generativer KI-Modelle im Gesundheitswesen. Einige medizinische Experten warnten jedoch in den sozialen Medien davor, zu viel Wert auf Open Medical-LLM zu legen, da dies nicht zu schlecht informierten Einsätzen führen würde.

Zu tatsächlich Die klinische Praxis kann recht groß sein.

Die Hugging-Face-Forscherin Clémentine Fourrier, Mitautorin des Blogbeitrags, stimmte dem zu.

„Diese Bestenlisten sollten nur als erste Annäherung verwendet werden [generative AI model] für einen bestimmten Anwendungsfall zu erforschen, aber dann ist immer eine tiefere Testphase erforderlich, um die Grenzen und Relevanz des Modells unter realen Bedingungen zu untersuchen“, Fourrier antwortete zu X. „Medizin [models] sollten auf keinen Fall von Patienten alleine verwendet werden, sondern stattdessen als Hilfsmittel für Ärzte ausgebildet werden.“

Es erinnert an die Erfahrungen von Google, als das Unternehmen versuchte, ein KI-Screening-Tool für diabetische Retinopathie in die Gesundheitssysteme Thailands einzuführen.

Google hat ein Deep-Learning-System entwickelt, das Bilder des Auges scannt und nach Hinweisen auf Retinopathie sucht, einer der Hauptursachen für Sehverlust. Doch trotz hoher theoretischer Genauigkeit Das Tool erwies sich in realen Tests als unpraktischwas sowohl Patienten als auch Pflegekräfte mit inkonsistenten Ergebnissen und einem allgemeinen Mangel an Harmonie mit den Praktiken vor Ort frustriert.

Es ist bezeichnend, dass von den 139 KI-bezogenen medizinischen Geräten, die die US-amerikanische Lebensmittel- und Arzneimittelbehörde bisher zugelassen hat, keiner nutzt generative KI. Es ist äußerst schwierig zu testen, wie sich die Leistung eines generativen KI-Tools im Labor auf Krankenhäuser und Ambulanzen auswirkt und, was vielleicht noch wichtiger ist, wie sich die Ergebnisse im Laufe der Zeit entwickeln könnten.

Das soll nicht heißen, dass Open Medical-LLM nicht nützlich oder informativ ist. Nicht zuletzt die Ergebnisliste dient als Erinnerung daran, wie das geht schlecht Modelle beantworten grundlegende Gesundheitsfragen. Aber Open Medical-LLM und kein anderer Benchmark sind ein Ersatz für sorgfältig durchdachte Tests in der Praxis.