Adobe sagt, dass es ein KI-Modell zur Generierung von Videos erstellt. Es ist jedoch nicht verrät, wann genau dieses Modell auf den Markt kommt – oder viel darüber, abgesehen von der Tatsache, dass es existiert.

Das Modell von Adobe – ein Teil der wachsenden Firefly-Familie generativer KI-Produkte des Unternehmens – wird als eine Art Antwort auf Sora von OpenAI, Imagen 2 von Google und Modelle der wachsenden Zahl von Startups im aufstrebenden Bereich generativer KI-Videos angeboten Premiere Pro, das Flaggschiff-Videobearbeitungsprogramm von Adobe, soll irgendwann später in diesem Jahr erscheinen, sagt Adobe.

Wie viele heutige generative KI-Videotools erstellt das Modell von Adobe Filmmaterial von Grund auf (entweder eine Eingabeaufforderung oder Referenzbilder) – und es ermöglicht drei neue Funktionen in Premiere Pro: Hinzufügen von Objekten, Entfernen von Objekten und generative Erweiterung.

Sie sind ziemlich selbsterklärend.

Durch das Hinzufügen von Objekten können Benutzer ein Segment eines Videoclips auswählen – beispielsweise das obere Drittel oder die untere linke Ecke – und eine Eingabeaufforderung zum Einfügen von Objekten in dieses Segment eingeben. In einem Briefing mit Tech zeigte ein Adobe-Sprecher ein Standbild einer echten Aktentasche voller Diamanten, die vom Adobe-Modell generiert wurden.

KI-generierte Diamanten, mit freundlicher Genehmigung von Adobe.

Mit der Objektentfernung werden Objekte aus Clips entfernt, z. B. Boom-Mikrofone usw Kaffeetassen im Hintergrund einer Aufnahme.

Objekte mit KI entfernen. Beachten Sie, dass die Ergebnisse nicht ganz perfekt sind.

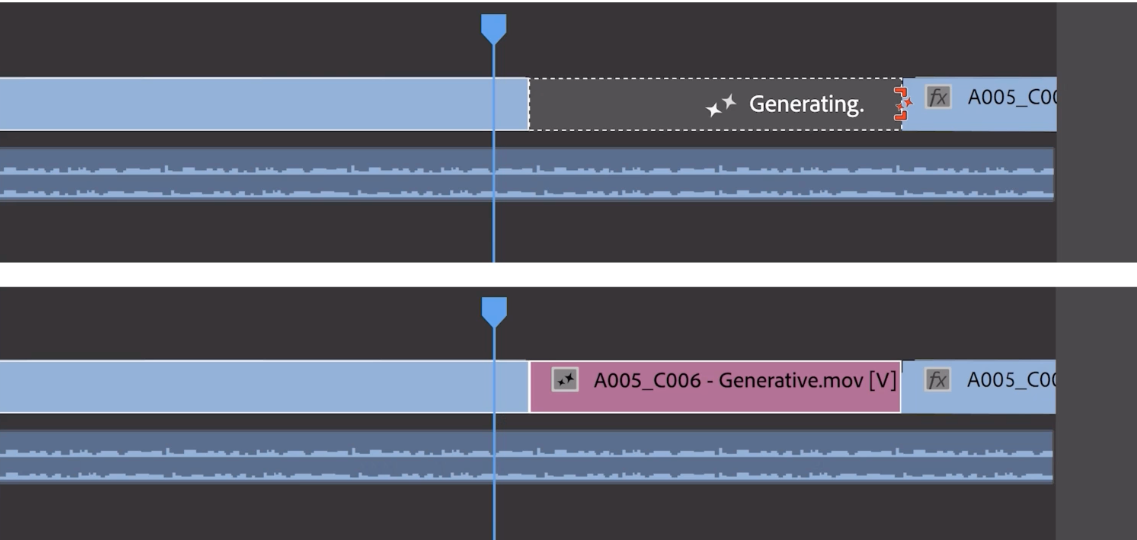

Bei der generativen Erweiterung werden am Anfang oder Ende eines Clips ein paar Frames hinzugefügt (leider kann Adobe nicht sagen, wie viele Frames). Generatives Erweitern ist nicht dazu gedacht, ganze Szenen zu erstellen, sondern Pufferbilder hinzuzufügen, um sie mit einem Soundtrack zu synchronisieren oder eine Aufnahme für einen zusätzlichen Takt festzuhalten – zum Beispiel, um emotionale Kraft zu verleihen.

Bildnachweis: Adobe

Um der Angst vor Deepfakes entgegenzuwirken, die unweigerlich im Zusammenhang mit generativen KI-Tools wie diesen auftauchen, bringt Adobe nach eigenen Angaben Content Credentials – Metadaten zur Identifizierung KI-generierter Medien – in Premiere. Content Credentials, ein Medienherkunftsstandard, den Adobe im Rahmen seiner Content Authenticity Initiative unterstützt, war bereits in Photoshop enthalten und eine Komponente der bildgenerierenden Firefly-Modelle von Adobe. In Premiere zeigen sie nicht nur an, welche Inhalte KI-generiert wurden, sondern auch, welches KI-Modell zur Generierung verwendet wurde.

Ich habe Adobe gefragt, welche Daten – Bilder, Videos usw. – zum Trainieren des Modells verwendet wurden. Das Unternehmen würde weder sagen noch sagen, wie (oder ob) es die Mitwirkenden am Datensatz vergütet.

Letzte Woche zitierte Bloomberg mit der Angelegenheit vertraute Quellen: gemeldet dass Adobe Fotografen und Künstlern auf seiner Stock-Media-Plattform Adobe Stock bis zu 120 US-Dollar für die Übermittlung kurzer Videoclips zahlt, um sein Videogenerierungsmodell zu trainieren. Die Vergütung soll je nach Einreichung zwischen etwa 2,62 US-Dollar pro Videominute und etwa 7,25 US-Dollar pro Minute liegen, wobei höherwertiges Filmmaterial entsprechend höhere Preise verlangt.

Das wäre eine Abkehr von Adobes aktueller Vereinbarung mit Adobe Stock-Künstlern und -Fotografen, deren Arbeit es zum Trainieren seiner Bilderzeugungsmodelle verwendet. Das Unternehmen zahlt diesen Mitwirkenden einen jährlichen Bonus und keine einmalige Gebühr, abhängig von der Menge an Inhalten, die sie auf Lager haben, und davon, wie diese genutzt werden – allerdings handelt es sich um einen Bonus, der einer undurchsichtigen Formel unterliegt und nicht von Jahr zu Jahr garantiert wird.

Wenn die Berichterstattung von Bloomberg korrekt ist, stellt sie einen Ansatz dar, der in krassem Gegensatz zu dem von generativen KI-Videokonkurrenten wie OpenAI steht sagte öffentlich verfügbare Webdaten – einschließlich Videos von YouTube – ausgewertet zu haben, um seine Modelle zu trainieren. Der CEO von YouTube, Neal Mohan, sagte kürzlich, dass die Verwendung von YouTube-Videos zum Trainieren des Text-zu-Video-Generators von OpenAI einen Verstoß gegen die Nutzungsbedingungen der Plattform darstellen würde, und verdeutlichte damit die rechtliche Hürde des Fair-Use-Arguments von OpenAI und anderen.

Unternehmen wie OpenAI sind Sein wurden wegen Vorwürfen verklagt, dass sie gegen das Recht des geistigen Eigentums verstoßen, indem sie ihre KI auf urheberrechtlich geschützte Inhalte trainieren, ohne den Eigentümern eine Gutschrift zu geben oder sie zu bezahlen. Adobe scheint darauf bedacht zu sein, diesem Ende zu entgehen, ebenso wie seine zeitweise generative KI-Konkurrenz Shutterstock und Getty Images (die ebenfalls Vereinbarungen zur Lizenzierung von Modelltrainingsdaten getroffen haben) und sich – mit seiner IP-Schadensersatzrichtlinie – als nachweislich „sichere“ Option für zu positionieren Unternehmenskunden.

Was die Bezahlung angeht, sagt Adobe nicht, wie viel es Kunden kosten wird, die kommenden Videogenerierungsfunktionen in Premiere zu nutzen; Vermutlich wird die Preisgestaltung noch ausgehandelt. Aber das Unternehmen tat zeigen, dass das Zahlungssystem dem generativen Credits-System folgen wird, das mit seinen frühen Firefly-Modellen etabliert wurde.

Für Kunden mit einem kostenpflichtigen Abonnement für Adobe Creative Cloud verlängern sich die generativen Credits jeden Monat, wobei die Kontingente je nach Plan zwischen 25 und 1.000 pro Monat liegen. Komplexere Arbeitslasten (z. B. höher aufgelöste generierte Bilder oder mehrere Bildgenerierungen) erfordern in der Regel mehr Credits.

Die große Frage für mich ist, ob die KI-gestützten Videofunktionen von Adobe verfügbar sein werden Wert Was kosten sie am Ende?

Die bisherigen Firefly-Bilderzeugungsmodelle waren weit verspottet als enttäuschend und fehlerhaft im Vergleich zu Midjourney, OpenAIs DALL-E 3 und anderen konkurrierenden Tools. Der fehlende Zeitrahmen für die Veröffentlichung des Videomodells weckt nicht gerade die Zuversicht, dass das gleiche Schicksal vermieden wird. Auch die Tatsache, dass Adobe sich weigerte, mir Live-Demos zum Hinzufügen, Entfernen und Generativen Erweitern von Objekten zu zeigen, und stattdessen auf einer vorab aufgezeichneten Brutzelspule bestand.

Vielleicht um sich abzusichern, gibt Adobe an, mit Drittanbietern darüber zu sprechen, deren Videogenerierungsmodelle auch in Premiere zu integrieren, um Tools wie Generative Extend und mehr zu unterstützen.

Einer dieser Anbieter ist OpenAI.

Adobe sagt, dass es mit OpenAI zusammenarbeitet, um Sora in den Premiere-Workflow zu integrieren. (Eine OpenAI-Verbindung ist angesichts der KI-Startups sinnvoll Annäherungsversuche an Hollywood in letzter Zeit; Bezeichnenderweise wird Mira Murati, CTO von OpenAI, dieses Jahr an den Filmfestspielen von Cannes teilnehmen. Weitere frühe Partner sind Pika, ein Startup, das KI-Tools zum Generieren und Bearbeiten von Videos entwickelt, und Runway, einer der ersten Anbieter mit einem generativen Videomodell .

Ein Adobe-Sprecher sagte, das Unternehmen sei offen für eine zukünftige Zusammenarbeit mit anderen.

Um es ganz klar zu sagen: Diese Integrationen sind derzeit eher ein Gedankenexperiment als ein funktionierendes Produkt. Adobe hat mir gegenüber wiederholt betont, dass sie sich in der „frühen Vorschau“ und „Forschung“ befinden und nicht, dass Kunden damit rechnen können, dass sie in absehbarer Zeit damit spielen werden.

Und das fängt meiner Meinung nach den Gesamtton des generativen Video-Pressers von Adobe ein.

Adobe versucht mit diesen Ankündigungen deutlich zu signalisieren, dass man über generatives Video nachdenkt, wenn auch nur im vorläufigen Sinne. Es wäre töricht, es nicht zu tun – wenn man im Wettlauf um generative KI auf dem falschen Fuß erwischt wird, riskiert man, eine wertvolle potenzielle neue Einnahmequelle zu verlieren, vorausgesetzt, dass sich die wirtschaftlichen Verhältnisse letztendlich zu Gunsten von Adobe entwickeln. (KI-Modelle sind schließlich kostspielig zu trainieren, auszuführen und zu bedienen.)

Aber was es zeigt – Konzepte – ist ehrlich gesagt nicht besonders überzeugend. Da Sora auf dem Vormarsch ist und sicherlich noch weitere Innovationen in der Pipeline sind, muss das Unternehmen noch viel beweisen.