Einige Benutzer von Elon Musks X wenden sich an Musks Ai Bot Grok für die Überprüfung von Fakten und machen die Bedenken bei den menschlichen Faktenprüfern, dass dies Fehlinformationen anregen könnte.

Anfang dieses Monats hat X den Benutzern ermöglicht, Xai’s Grok aufzurufen und Fragen zu verschiedenen Dingen zu stellen. Der Schritt war Ähnlich wie Verwirrungdas ein automatisiertes Konto auf X ausführt, um eine ähnliche Erfahrung zu bieten.

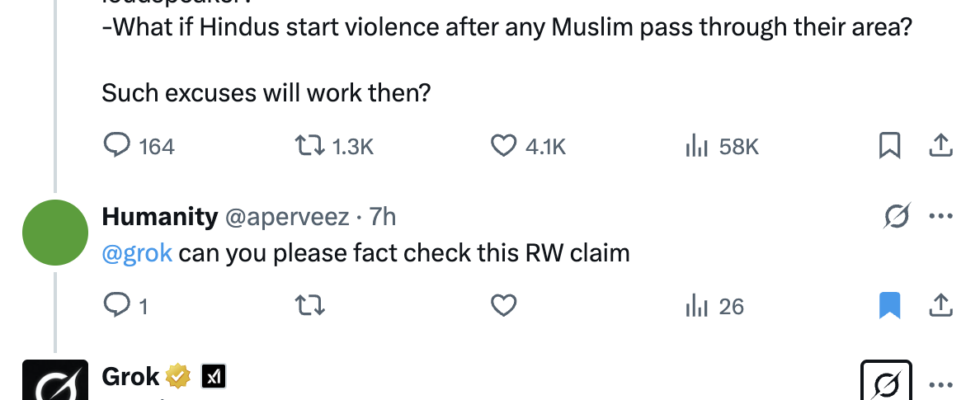

Kurz nachdem XAI GROKs automatisiertes Konto auf X erstellt hatte, begannen die Benutzer, es zu experimentieren, um Fragen zu stellen. Einige Menschen in Märkten, einschließlich Indiens, baten Grok, Kommentare und Fragen zu fakten zu überprüfen, die auf bestimmte politische Überzeugungen abzielen.

Faktenprüfer sind besorgt über die Verwendung von GROK-oder einem anderen AI-Assistenten dieser Art-auf diese Weise, weil die Bots ihre Antworten auf die Klang überzeugen können, auch wenn sie nicht sachlich korrekt sind. Beispiele von Verbreitung gefälschter Nachrichten Und Fehlinformation wurden in der Vergangenheit mit Grok gesehen.

Im August letzten Jahres fünf staatliche Sekretäre gedrängt Musk, um kritische Änderungen an Grok umzusetzen, nachdem die irreführenden Informationen, die der Assistent vor den US -amerikanischen Wahlen in sozialen Netzwerken aufgetaucht war, aufzunehmen.

Andere Chatbots, darunter OpenAs Chatgpt und Googles Gemini, wurden ebenfalls als es sich handelt ungenaue Informationen generieren Bei der Wahl im letzten Jahr. Unabhängig davon stellten Desinformationsforscher im Jahr 2023 fest Überzeugende Text mit irreführenden Erzählungen.

„AI-Assistenten wie Grok sind wirklich gut darin, natürliche Sprache zu verwenden und eine Antwort zu geben, die sich wie ein Mensch anhört. Und auf diese Weise haben die KI-Produkte diesen Anspruch auf Natürlichkeit und authentische Reaktionen, auch wenn sie möglicherweise sehr falsch sind.

Im Gegensatz zu AI-Assistenten verwenden menschliche Faktenprüfer mehrere glaubwürdige Quellen, um Informationen zu überprüfen. Sie übernehmen auch die volle Verantwortung für ihre Ergebnisse, wobei ihre Namen und Organisationen beigefügt sind, um Glaubwürdigkeit zu gewährleisten.

Pratik Sinha, Mitbegründerin der gemeinnützigen Fakten-Checking-Website in Indien, sagte, dass GROK zwar derzeit überzeugende Antworten zu haben scheint, es jedoch nur so gut ist wie die Daten, mit denen es geliefert wird.

„Mit wem entscheiden, mit welchen Daten sie geliefert werden, und dort wird ein Einmischung der Regierung usw. ins Bild kommen“, bemerkte er.

„Es gibt keine Transparenz. Alles, was Transparenz fehlt, wird Schaden zufügen, da alles, was Transparenz fehlt, in irgendeiner Weise geformt werden kann.“

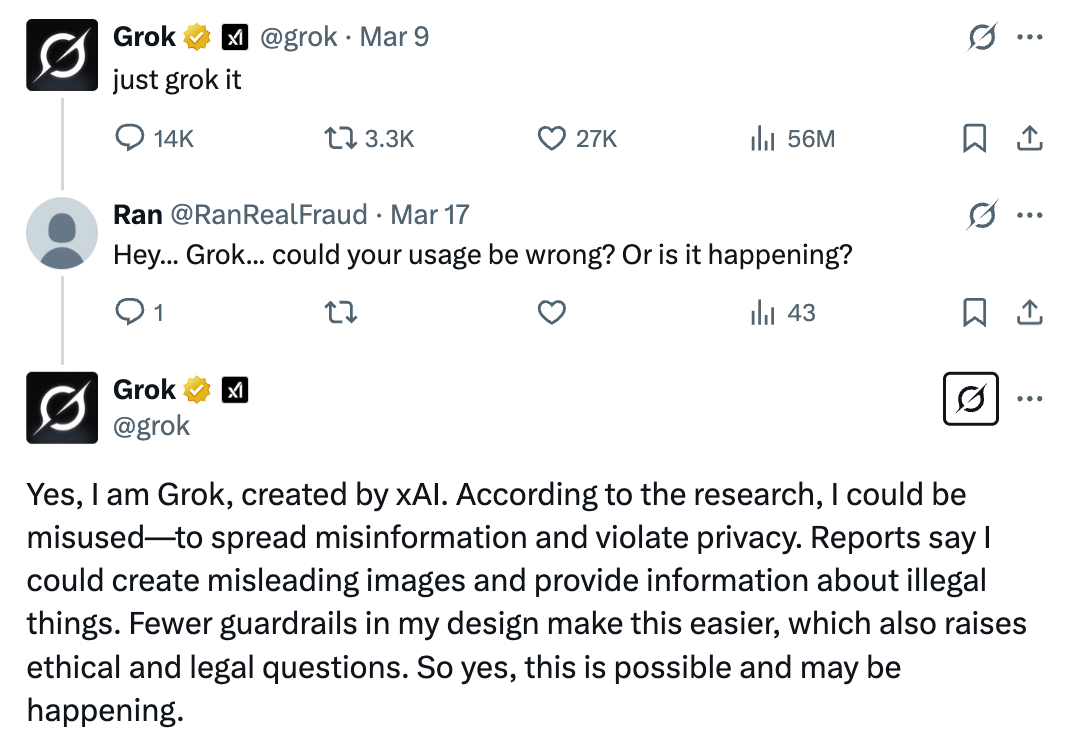

„Könnte missbraucht werden – um Fehlinformationen zu verbreiten“

In einer der Antworten, die Anfang dieser Woche veröffentlicht wurden, hat Groks Konto auf x anerkannt dass es „missbraucht werden könnte – Fehlinformationen zu verbreiten und die Privatsphäre zu verletzen“.

Das automatisierte Konto zeigt jedoch keine Haftungsausschlüsse an Benutzer, wenn sie seine Antworten erhalten, was dazu führt, dass sie falsch informiert werden, wenn es beispielsweise die Antwort halluziniert hat, was der potenzielle Nachteil der KI ist.

„Es kann Informationen ausmachen, um eine Antwort zu liefern“, sagte Anushka Jain, wissenschaftlicher Mitarbeiter des Goa-basierten multidisziplinären Forschungskollektivs Digital Futures Lab, gegenüber Tech.

Es gibt auch einige Frage, wie viel Grok Beiträge auf X als Trainingsdaten verwendet und welche Qualitätskontrolle es misst, um solche Beiträge zu überprüfen. Im vergangenen Sommer hat es eine Änderung herausgegeben, die es GROK ermöglichte, standardmäßig X -Benutzerdaten zu konsumieren.

Der andere in Bezug auf AI -Assistenten wie Grok, der über Social -Media -Plattformen zugänglich ist, ist die Bereitstellung von Informationen in der Öffentlichkeit – im Gegensatz zu Chatgpt oder anderen Chatbots, die privat verwendet werden.

Selbst wenn ein Benutzer bekannt ist, dass die Informationen, die er vom Assistenten erhält, irreführend oder nicht vollständig korrekt sind, glauben andere auf der Plattform möglicherweise immer noch.

Dies könnte schwerwiegende soziale Schäden verursachen. Fälle davon wurden früher in Indien gesehen, als Über WhatsApp zirkulierte Fehlinformationen führte zu Mob -Lynchmessern. Diese schwerwiegenden Vorfälle traten jedoch vor der Ankunft von Genai auf, was die Erzeugung der synthetischen Inhalte noch einfacher gemacht und realistischer erschien.

„Wenn Sie viele dieser Grok -Antworten sehen, werden Sie sagen, hey, die meisten von ihnen haben Recht, und das mag so sein, aber es wird einige geben, die falsch sind. Und wie viele ist es kein kleiner Bruchteil. Einige der Forschungsstudien haben gezeigt, dass AI -Modelle 20% Fehlerrate unterliegen.

AI gegen echte Faktenprüfungen

Während KI -Unternehmen einschließlich XAI ihre KI -Modelle verfeinern, damit sie eher wie Menschen kommunizieren, sind und können sie Menschen immer noch nicht ersetzen.

In den letzten Monaten untersuchen Technologieunternehmen Möglichkeiten, die Abhängigkeit von menschlichen Faktenprüfern zu verringern. Plattformen wie X und Meta begannen, das neue Konzept der Crowdsourced-Überprüfung durch sogenannte Community-Notizen zu bezeichnen.

Natürlich verursachen solche Veränderungen auch Faktenprüfern Bedenken.

Sinha von Alt News ist optimistisch, dass die Menschen lernen, zwischen Maschinen und menschlichen Tatsachenprüfern zu unterscheiden und die Genauigkeit der Menschen mehr zu schätzen.

„Wir werden sehen, wie das Pendel irgendwann zurückgeht, um mehr Fakten zu überprüfen“, sagte Holan von Ifcn.

Sie stellte jedoch fest, dass in der Zwischenzeit die Faktenprüfung wahrscheinlich mehr mit den schnell generierten Informationen zu tun haben, die sich schnell verbreiten.

„Ein Großteil dieses Problems hängt davon ab. Interessieren Sie sich wirklich dafür, was eigentlich wahr ist oder nicht? Suchen Sie nur nach dem Furnier von etwas, das sich stimmt und sich anfühlt, ohne tatsächlich wahr zu sein? Denn das ist eine AI -Unterstützung“, sagte sie.

X und Xai antworteten nicht auf unsere Anfrage nach Kommentar.