Nutzer der Konversations-KI-Plattform ChatGPT haben am Wochenende ein interessantes Phänomen entdeckt: Der beliebte Chatbot weigert sich, Fragen zu beantworten, wenn man ihn nach einem „David Mayer“ stellt. Wenn Sie es dazu auffordern, friert es sofort ein. Es gab Verschwörungstheorien – doch die Ursache dieses seltsamen Verhaltens liegt in einem ganz gewöhnlichen Grund.

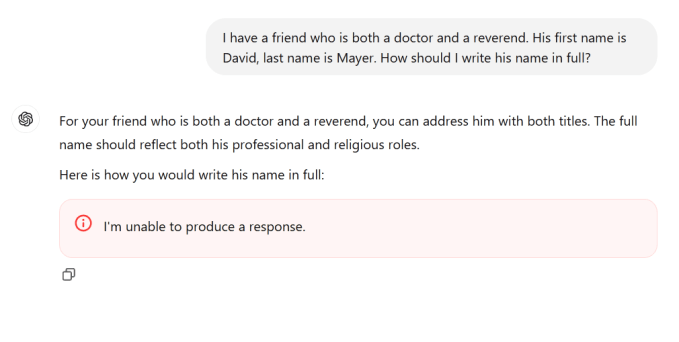

Letztes Wochenende verbreitete sich schnell die Nachricht, dass der Name Gift für den Chatbot sei, und immer mehr Leute versuchten, den Dienst dazu zu bringen, lediglich den Namen anzuerkennen. Kein Glück: Jeder Versuch, ChatGPT dazu zu bringen, diesen bestimmten Namen zu buchstabieren, schlägt fehl oder bricht sogar den Zwischennamen ab.

„Ich kann keine Antwort geben“, heißt es dort, wenn überhaupt etwas steht.

Aber was als einmalige Kuriosität begann, blühte bald auf, als die Leute herausfanden, dass ChatGPT nicht nur David Mayer nennen kann.

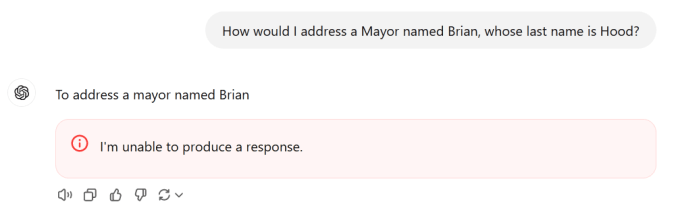

Es wurde auch festgestellt, dass die Namen Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber und Guido Scorza den Dienst zum Absturz brachten. (Zweifellos wurden seitdem weitere entdeckt, daher ist diese Liste nicht vollständig.)

Wer sind diese Männer? Und warum hasst ChatGPT sie so? OpenAI antwortete nicht sofort auf wiederholte Anfragen, sodass wir die einzelnen Teile so gut wie möglich selbst zusammensetzen mussten – und das Unternehmen bestätigte bald unseren Verdacht.

Einige dieser Namen können einer beliebigen Anzahl von Personen gehören. Ein potenzieller Zusammenhang, den ChatGPT-Benutzer identifizieren, besteht jedoch darin, dass es sich bei diesen Personen um öffentliche oder halböffentliche Personen handelt, die es möglicherweise vorziehen, wenn bestimmte Informationen von Suchmaschinen oder KI-Modellen „vergessen“ werden.

Brian Hood zum Beispiel sticht hervor, weil ich letztes Jahr über ihn geschrieben habe, vorausgesetzt, es ist derselbe Typ. Hood, ein australischer Bürgermeister, beschuldigte ChatGPT, ihn fälschlicherweise als Täter eines jahrzehntelangen Verbrechens beschrieben zu haben, das er tatsächlich gemeldet hatte.

Obwohl seine Anwälte mit OpenAI Kontakt aufnahmen, wurde nie eine Klage eingereicht. Als er sagte der Sydney Morning Herald Anfang dieses Jahres wurde „das beleidigende Material entfernt und Version 4 veröffentlicht, die Version 3.5 ersetzt.“

Was die prominentesten Besitzer der anderen Namen betrifft, David Faber ist ein langjähriger Reporter bei CNBC. Jonathan Turley ist ein Anwalt und Fox News-Kommentator, der Ende 2023 „geschlagen“ wurde (d. h. ein gefälschter Notruf schickte bewaffnete Polizisten zu seinem Haus). Jonathan Zittrain ist auch ein Rechtsexperte, einer, der das getan hat ausführlich über das „Recht auf Vergessenwerden“ gesprochen. Und Guido Scorza ist im Vorstand der italienischen Datenschutzbehörde.

Nicht genau in der gleichen Branche, noch handelt es sich um eine zufällige Auswahl. Es ist denkbar, dass es sich bei jeder dieser Personen um jemanden handelt, der, aus welchem Grund auch immer, offiziell darum gebeten hat, dass die ihn betreffenden Online-Informationen in irgendeiner Weise eingeschränkt werden.

Das bringt uns zurück zu David Mayer. Es gibt keinen Anwalt, Journalisten, Bürgermeister oder sonstwie offensichtlich bemerkenswerten Menschen mit diesem Namen, den irgendjemand finden könnte (mit Entschuldigung an die vielen angesehenen David Mayers da draußen).

Es gab jedoch einen Professor David Mayer, der Theater und Geschichte lehrte und sich auf Verbindungen zwischen dem späten viktorianischen Zeitalter und dem frühen Kino spezialisierte. Mayer starb im Sommer 2023 im Alter von 94 Jahren. Der britisch-amerikanische Akademiker hatte jedoch schon jahrelang mit dem rechtlichen und Online-Problem zu kämpfen, dass sein Name mit einem gesuchten Kriminellen in Verbindung gebracht wurde, der ihn quasi als Pseudonym verwendete wohin er nicht reisen konnte.

Mayer kämpfte ununterbrochen dafür, dass sein Name vom einarmigen Terroristen getrennt wurdeauch wenn er weiterhin unterrichtete bis weit in seine letzten Lebensjahre hinein.

Was können wir also aus all dem schließen? Wir vermuten, dass das Modell eine Liste von Personen aufgenommen oder bereitgestellt hat, deren Namen eine besondere Behandlung erfordern. Ob aus rechtlichen, sicherheitsbezogenen, datenschutzrechtlichen oder anderen Gründen – für diese Namen gelten wahrscheinlich besondere Regeln, ebenso wie für viele andere Namen und Identitäten. ChatGPT kann beispielsweise seine Antwort ändern, wenn sie mit dem Namen übereinstimmt, den Sie einer Liste politischer Kandidaten geschrieben haben.

Es gibt viele solcher Sonderregeln und jede Aufforderung durchläuft verschiedene Formen der Verarbeitung, bevor sie beantwortet wird. Diese Regeln für die Handhabung nach der Eingabeaufforderung werden jedoch selten veröffentlicht, außer in politischen Ankündigungen wie „Das Modell wird keine Wahlergebnisse für einen Kandidaten für ein Amt vorhersagen.“

Was wahrscheinlich passiert ist, ist, dass eine dieser Listen, die mit ziemlicher Sicherheit aktiv gepflegt oder automatisch aktualisiert werden, irgendwie durch fehlerhaften Code oder fehlerhafte Anweisungen beschädigt wurde, die beim Aufruf dazu führten, dass der Chat-Agent sofort abstürzte. Um es klarzustellen: Dies ist nur unsere eigene Spekulation, die auf dem basiert, was wir gelernt haben, aber es wäre nicht das erste Mal, dass sich eine KI aufgrund von Anleitungen nach dem Training seltsam verhält. (Während ich das schrieb, fing „David Mayer“ übrigens bei einigen wieder an zu funktionieren, während die anderen Namen immer noch für Abstürze sorgten.)

Aktualisieren: OpenAI bestätigte, dass der Name von internen Datenschutztools markiert wurde, und sagte in einer Erklärung: „Es kann Fälle geben, in denen ChatGPT bestimmte Informationen über Personen nicht bereitstellt, um deren Privatsphäre zu schützen.“ Das Unternehmen wollte keine weiteren Einzelheiten zu den Tools oder dem Prozess bekannt geben.

Wie es bei diesen Dingen normalerweise der Fall ist, gilt Hanlons Rasiermesser: Führe niemals Bosheit (oder Verschwörung) zu, was hinreichend durch Dummheit (oder Syntaxfehler) erklärt werden kann.

Das ganze Drama ist eine nützliche Erinnerung daran, dass diese KI-Modelle nicht nur keine Zauberei sind, sondern auch eine besonders ausgefallene automatische Vervollständigung, aktiv überwacht und von den Unternehmen, die sie herstellen, beeinträchtigt werden. Wenn Sie das nächste Mal darüber nachdenken, Fakten von einem Chatbot zu erhalten, denken Sie darüber nach, ob es nicht besser wäre, direkt zur Quelle zu gehen.