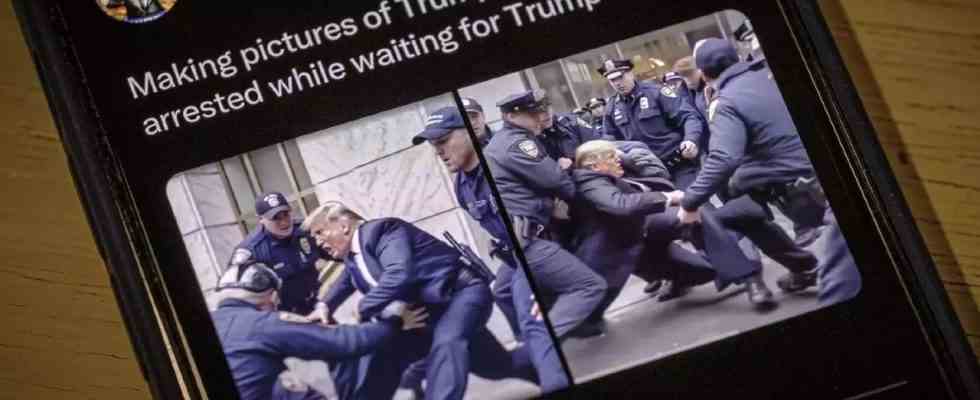

NEW YORK: Der frühere US-Präsident Donald Trumpf von New Yorker Polizisten in Kampfausrüstung angegriffen zu werden. Der russische Präsident Wladimir Putin in Gefängnisgrau hinter den Gitterstäben einer schwach beleuchteten Betonzelle. Die hochdetaillierten, sensationellen Bilder haben in den letzten Tagen Twitter und andere Plattformen überschwemmt, inmitten von Nachrichten, dass Trump möglicherweise strafrechtlich verfolgt wird und der Internationale Strafgerichtshof einen Haftbefehl gegen Putin erlassen hat.

Aber keines der visuellen Elemente ist im entferntesten real. Die Bilder – und Dutzende von Variationen, die die sozialen Medien verunreinigen – wurden mit immer ausgefeilteren und allgemein zugänglichen Bildgeneratoren produziert, die von künstlicher Intelligenz angetrieben werden.

Experten für Fehlinformationen warnen, dass die Bilder Vorboten einer neuen Realität sind: Wellen gefälschter Fotos und Videos, die nach großen Nachrichtenereignissen die sozialen Medien überschwemmen und Fakten und Fiktionen in entscheidenden Zeiten für die Gesellschaft weiter verwirren.

„Es fügt bei Krisenereignissen Lärm hinzu. Es erhöht auch den Grad des Zynismus“, sagte Jevin West, Professor an der University of Washington in Seattle, der sich auf die Verbreitung von Fehlinformationen konzentriert. „Man beginnt, das Vertrauen in das System und die Informationen, die man bekommt, zu verlieren.“

Während die Möglichkeit, Fotos zu manipulieren und gefälschte Bilder zu erstellen, nicht neu ist, sind KI-Bildgenerator-Tools von Zwischendurch, DALL-E und andere sind einfacher zu verwenden. Sie können schnell realistische Bilder – komplett mit detaillierten Hintergründen – in großem Maßstab mit wenig mehr als einer einfachen Texteingabe von Benutzern erstellen.

Einige der jüngsten Bilder wurden durch die Veröffentlichung einer neuen Version von Midjourneys Text-zu-Bild-Synthesemodell in diesem Monat vorangetrieben, das nun unter anderem überzeugende Bilder erzeugen kann, die den Stil von Nachrichtenagenturfotos nachahmen.

In einem weit verbreiteten Twitter-Thread verwendete Eliot Higgins, Gründer von Bellingcat, einem in den Niederlanden ansässigen Kollektiv für investigativen Journalismus, die neueste Version des Tools, um Dutzende dramatischer Bilder von Trumps fiktiver Verhaftung heraufzubeschwören.

Die Bilder, die Zehntausende Male geteilt und geliked wurden, zeigten eine Gruppe uniformierter Beamter, die den republikanischen Milliardär packten und ihn gewaltsam auf den Bürgersteig zogen.

Higgins, der auch hinter einer Reihe von Bildern steckte Putin festgenommen, vor Gericht gestellt und dann inhaftiert wurde, sagt er, er habe die Bilder ohne böse Absicht gepostet. In seinem Twitter-Thread erklärte er sogar deutlich, dass die Bilder von KI generiert wurden.

Dennoch reichten die Bilder laut Higgins aus, um ihn vom Midjourney-Server auszuschließen. Das in San Francisco ansässige unabhängige Forschungslabor antwortete nicht auf E-Mails mit der Bitte um Stellungnahme.

„Das Trump-Verhaftungsbild zeigte wirklich nur beiläufig, wie gut und schlecht Midjourney echte Szenen wiedergeben konnte“, schrieb Higgins in einer E-Mail. „Die Bilder fingen an, eine Art Erzählung zu bilden, als ich Eingabeaufforderungen in Midjourney einfügte, also fügte ich sie in eine Erzählung ein und beschloss, die Geschichte zu beenden.“

Er wies darauf hin, dass die Bilder alles andere als perfekt seien: Auf einigen ist Trump seltsamerweise mit einem Polizeigürtel zu sehen. Bei anderen sind Gesichter und Hände deutlich verzerrt.

Aber es reicht nicht aus, dass Nutzer wie Higgins in ihren Posts klar sagen, dass die Bilder KI-generiert sind und ausschließlich der Unterhaltung dienen, sagt Shirin Anlen, Medientechnologin bei Witness, einer in New York ansässigen Menschenrechtsorganisation, die sich auf visuelle Beweise konzentriert.

Zu oft werden die visuellen Elemente schnell von anderen ohne diesen entscheidenden Kontext erneut geteilt, sagte sie. Tatsächlich erhielt ein Instagram-Post, der einige von Higgins‘ Bildern von Trump so teilte, als ob sie echt wären, mehr als 79.000 Likes.

„Du siehst nur ein Bild, und wenn du etwas einmal gesehen hast, kannst du es nicht wieder rückgängig machen“, sagte Anlen.

In einem anderen aktuellen Beispiel teilten Social-Media-Nutzer ein synthetisches Bild, das Putin angeblich kniend und die Hand des chinesischen Führers Xi Jinping küsst. Das Bild, das kursierte, als der russische Präsident Xi diese Woche im Kreml begrüßte, wurde schnell zu einem plumpen Meme.

Es ist nicht klar, wer das Bild erstellt oder welches Werkzeug sie verwendet haben, aber einige Hinweise verrieten die Fälschung. Die Köpfe und Schuhe der beiden Anführer waren beispielsweise leicht verzerrt, und die Einrichtung des Raums passte nicht zu dem Raum, in dem das eigentliche Treffen stattfand.

Da synthetische Bilder immer schwieriger von der Realität zu unterscheiden sind, ist der beste Weg, visuelle Fehlinformationen zu bekämpfen, ein besseres öffentliches Bewusstsein und Aufklärung, sagen Experten.

„Es wird so einfach und so billig, diese Bilder zu machen, dass wir alles tun sollten, um der Öffentlichkeit bewusst zu machen, wie gut diese Technologie geworden ist“, sagte West.

Higgins schlägt vor, dass sich Social-Media-Unternehmen auf die Entwicklung von Technologien konzentrieren könnten, um KI-generierte Bilder zu erkennen und diese in ihre Plattformen zu integrieren.

Twitter hat eine Richtlinie, die „synthetische, manipulierte oder kontextlose Medien“ mit dem Potenzial zu Täuschung oder Schaden verbietet. An einige Tweets wurden Anmerkungen von Community Notes, dem Crowdsourcing-Faktenprüfungsprojekt von Twitter, angehängt, um den Kontext aufzunehmen, dass die Trump-Bilder von der KI generiert wurden.

Als das Unternehmen am Donnerstag für einen Kommentar erreicht wurde, schickte es nur eine automatisierte Antwort per E-Mail zurück.

Meta, die Muttergesellschaft von Facebook und Instagram, lehnte eine Stellungnahme ab. Einige der fabrizierten Trump-Bilder wurden durch das Faktenprüfprogramm eines Drittanbieters, an dem der AP teilnimmt, entweder als „falsch“ oder „fehlender Kontext“ gekennzeichnet.

Arthur Holland Michel, ein Mitarbeiter des Carnegie Council for Ethics in International Affairs in New York, der sich auf neue Technologien konzentriert, sagte, er mache sich Sorgen, dass die Welt nicht bereit für die bevorstehende Sintflut sei.

Er fragt sich, wie Deepfakes, an denen normale Menschen beteiligt sind – beispielsweise schädliche gefälschte Bilder eines Ex-Partners oder eines Kollegen – reguliert werden.

„Aus politischer Sicht bin ich mir nicht sicher, ob wir bereit sind, mit diesem Ausmaß an Desinformation auf allen Ebenen der Gesellschaft umzugehen“, schrieb Michel in einer E-Mail. „Mein Gefühl ist, dass es eines noch nie dagewesenen technischen Durchbruchs bedarf, um dem endgültig ein Ende zu bereiten.

Aber keines der visuellen Elemente ist im entferntesten real. Die Bilder – und Dutzende von Variationen, die die sozialen Medien verunreinigen – wurden mit immer ausgefeilteren und allgemein zugänglichen Bildgeneratoren produziert, die von künstlicher Intelligenz angetrieben werden.

Experten für Fehlinformationen warnen, dass die Bilder Vorboten einer neuen Realität sind: Wellen gefälschter Fotos und Videos, die nach großen Nachrichtenereignissen die sozialen Medien überschwemmen und Fakten und Fiktionen in entscheidenden Zeiten für die Gesellschaft weiter verwirren.

„Es fügt bei Krisenereignissen Lärm hinzu. Es erhöht auch den Grad des Zynismus“, sagte Jevin West, Professor an der University of Washington in Seattle, der sich auf die Verbreitung von Fehlinformationen konzentriert. „Man beginnt, das Vertrauen in das System und die Informationen, die man bekommt, zu verlieren.“

Während die Möglichkeit, Fotos zu manipulieren und gefälschte Bilder zu erstellen, nicht neu ist, sind KI-Bildgenerator-Tools von Zwischendurch, DALL-E und andere sind einfacher zu verwenden. Sie können schnell realistische Bilder – komplett mit detaillierten Hintergründen – in großem Maßstab mit wenig mehr als einer einfachen Texteingabe von Benutzern erstellen.

Einige der jüngsten Bilder wurden durch die Veröffentlichung einer neuen Version von Midjourneys Text-zu-Bild-Synthesemodell in diesem Monat vorangetrieben, das nun unter anderem überzeugende Bilder erzeugen kann, die den Stil von Nachrichtenagenturfotos nachahmen.

In einem weit verbreiteten Twitter-Thread verwendete Eliot Higgins, Gründer von Bellingcat, einem in den Niederlanden ansässigen Kollektiv für investigativen Journalismus, die neueste Version des Tools, um Dutzende dramatischer Bilder von Trumps fiktiver Verhaftung heraufzubeschwören.

Die Bilder, die Zehntausende Male geteilt und geliked wurden, zeigten eine Gruppe uniformierter Beamter, die den republikanischen Milliardär packten und ihn gewaltsam auf den Bürgersteig zogen.

Higgins, der auch hinter einer Reihe von Bildern steckte Putin festgenommen, vor Gericht gestellt und dann inhaftiert wurde, sagt er, er habe die Bilder ohne böse Absicht gepostet. In seinem Twitter-Thread erklärte er sogar deutlich, dass die Bilder von KI generiert wurden.

Dennoch reichten die Bilder laut Higgins aus, um ihn vom Midjourney-Server auszuschließen. Das in San Francisco ansässige unabhängige Forschungslabor antwortete nicht auf E-Mails mit der Bitte um Stellungnahme.

„Das Trump-Verhaftungsbild zeigte wirklich nur beiläufig, wie gut und schlecht Midjourney echte Szenen wiedergeben konnte“, schrieb Higgins in einer E-Mail. „Die Bilder fingen an, eine Art Erzählung zu bilden, als ich Eingabeaufforderungen in Midjourney einfügte, also fügte ich sie in eine Erzählung ein und beschloss, die Geschichte zu beenden.“

Er wies darauf hin, dass die Bilder alles andere als perfekt seien: Auf einigen ist Trump seltsamerweise mit einem Polizeigürtel zu sehen. Bei anderen sind Gesichter und Hände deutlich verzerrt.

Aber es reicht nicht aus, dass Nutzer wie Higgins in ihren Posts klar sagen, dass die Bilder KI-generiert sind und ausschließlich der Unterhaltung dienen, sagt Shirin Anlen, Medientechnologin bei Witness, einer in New York ansässigen Menschenrechtsorganisation, die sich auf visuelle Beweise konzentriert.

Zu oft werden die visuellen Elemente schnell von anderen ohne diesen entscheidenden Kontext erneut geteilt, sagte sie. Tatsächlich erhielt ein Instagram-Post, der einige von Higgins‘ Bildern von Trump so teilte, als ob sie echt wären, mehr als 79.000 Likes.

„Du siehst nur ein Bild, und wenn du etwas einmal gesehen hast, kannst du es nicht wieder rückgängig machen“, sagte Anlen.

In einem anderen aktuellen Beispiel teilten Social-Media-Nutzer ein synthetisches Bild, das Putin angeblich kniend und die Hand des chinesischen Führers Xi Jinping küsst. Das Bild, das kursierte, als der russische Präsident Xi diese Woche im Kreml begrüßte, wurde schnell zu einem plumpen Meme.

Es ist nicht klar, wer das Bild erstellt oder welches Werkzeug sie verwendet haben, aber einige Hinweise verrieten die Fälschung. Die Köpfe und Schuhe der beiden Anführer waren beispielsweise leicht verzerrt, und die Einrichtung des Raums passte nicht zu dem Raum, in dem das eigentliche Treffen stattfand.

Da synthetische Bilder immer schwieriger von der Realität zu unterscheiden sind, ist der beste Weg, visuelle Fehlinformationen zu bekämpfen, ein besseres öffentliches Bewusstsein und Aufklärung, sagen Experten.

„Es wird so einfach und so billig, diese Bilder zu machen, dass wir alles tun sollten, um der Öffentlichkeit bewusst zu machen, wie gut diese Technologie geworden ist“, sagte West.

Higgins schlägt vor, dass sich Social-Media-Unternehmen auf die Entwicklung von Technologien konzentrieren könnten, um KI-generierte Bilder zu erkennen und diese in ihre Plattformen zu integrieren.

Twitter hat eine Richtlinie, die „synthetische, manipulierte oder kontextlose Medien“ mit dem Potenzial zu Täuschung oder Schaden verbietet. An einige Tweets wurden Anmerkungen von Community Notes, dem Crowdsourcing-Faktenprüfungsprojekt von Twitter, angehängt, um den Kontext aufzunehmen, dass die Trump-Bilder von der KI generiert wurden.

Als das Unternehmen am Donnerstag für einen Kommentar erreicht wurde, schickte es nur eine automatisierte Antwort per E-Mail zurück.

Meta, die Muttergesellschaft von Facebook und Instagram, lehnte eine Stellungnahme ab. Einige der fabrizierten Trump-Bilder wurden durch das Faktenprüfprogramm eines Drittanbieters, an dem der AP teilnimmt, entweder als „falsch“ oder „fehlender Kontext“ gekennzeichnet.

Arthur Holland Michel, ein Mitarbeiter des Carnegie Council for Ethics in International Affairs in New York, der sich auf neue Technologien konzentriert, sagte, er mache sich Sorgen, dass die Welt nicht bereit für die bevorstehende Sintflut sei.

Er fragt sich, wie Deepfakes, an denen normale Menschen beteiligt sind – beispielsweise schädliche gefälschte Bilder eines Ex-Partners oder eines Kollegen – reguliert werden.

„Aus politischer Sicht bin ich mir nicht sicher, ob wir bereit sind, mit diesem Ausmaß an Desinformation auf allen Ebenen der Gesellschaft umzugehen“, schrieb Michel in einer E-Mail. „Mein Gefühl ist, dass es eines noch nie dagewesenen technischen Durchbruchs bedarf, um dem endgültig ein Ende zu bereiten.