Intel, Google, Microsoft, Meta und andere Schwergewichte der Technologiebranche gründen eine neue Industriegruppe, die Ultra Accelerator Link (UALink) Promoter Group, um die Entwicklung der Komponenten zu leiten, die KI-Beschleunigerchips in Rechenzentren miteinander verbinden.

Die UALink Promoter Group – zu deren Mitgliedern auch AMD (aber nicht Arm), Hewlett Packard Enterprise, Broadcom und Cisco zählen – schlägt am Donnerstag einen neuen Industriestandard zur Verbindung der KI-Beschleunigerchips vor, die in immer mehr Servern zu finden sind. Allgemein definiert sind KI-Beschleuniger Chips von GPUs bis hin zu maßgeschneiderten Lösungen, um das Training, die Feinabstimmung und den Betrieb von KI-Modellen zu beschleunigen.

„Die Branche braucht einen offenen Standard, der sehr schnell vorangetrieben werden kann, in einer offenen [format] „Das ermöglicht es mehreren Unternehmen, einen Mehrwert für das gesamte Ökosystem zu schaffen“, sagte Forrest Norrod, AMDs GM für Rechenzentrumslösungen, Reportern am Mittwoch in einem Briefing. „Die Branche braucht einen Standard, der Innovationen in einem rasanten Tempo ermöglicht, das nicht von einem einzelnen Unternehmen behindert wird.“

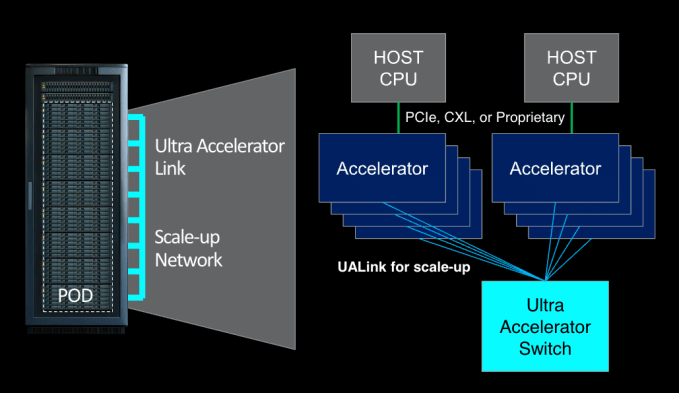

Version eins des vorgeschlagenen Standards, UALink 1.0, wird bis zu 1.024 KI-Beschleuniger – nur GPUs – über einen einzigen Computer-„Pod“ verbinden. (Die Gruppe definiert einen Schote als ein oder mehrere Racks in einem Server.) UALink 1.0, basierend auf „offenen Standards“ einschließlich AMDs Infinity Fabricermöglicht direktes Laden und Speichern zwischen dem an KI-Beschleuniger angeschlossenen Speicher und erhöht laut der UALink Promoter Group im Vergleich zu vorhandenen Verbindungsspezifikationen allgemein die Geschwindigkeit bei gleichzeitiger Verringerung der Datenübertragungslatenz.

Die Gruppe will im dritten Quartal ein Konsortium, das UALink Consortium, gründen, das die Weiterentwicklung der UALink-Spezifikation überwachen soll. UALink 1.0 wird etwa zur gleichen Zeit den Unternehmen zur Verfügung gestellt, die dem Konsortium beitreten, während eine aktualisierte Spezifikation mit höherer Bandbreite, UALink 1.1, im vierten Quartal 2024 erscheinen soll.

Die ersten UALink-Produkte werden „in den nächsten paar Jahren“ auf den Markt kommen, sagte Norrod.

Auffällig abwesend in der Liste der Mitglieder der Gruppe ist Nvidia, der mit Abstand größte Hersteller von KI-Beschleunigern mit einem geschätzt 80 bis 95 Prozent des Marktes. Nvidia wollte sich zu diesem Artikel nicht äußern. Es ist jedoch nicht nachvollziehbar, warum der Chiphersteller UALink nicht mit Begeisterung unterstützt.

Zum einen bietet Nvidia eine eigene proprietäre Verbindungstechnologie für die Verbindung von GPUs innerhalb eines Rechenzentrumsservers an. Das Unternehmen ist wahrscheinlich nicht besonders daran interessiert, eine Spezifikation zu unterstützen, die auf konkurrierenden Technologien basiert.

Hinzu kommt, dass Nvidia aus einer Position enormer Stärke und Einflusses operiert.

Im letzten Geschäftsquartal von Nvidia (Q1 2025) stiegen die Umsätze des Unternehmens im Bereich Rechenzentren, zu denen auch die Umsätze seiner KI-Chips gehören, im Vergleich zum Vorjahresquartal um mehr als 400 %. Wenn Nvidia geht weiter Wenn es sich weiterhin so entwickelt, wird das Unternehmen im Laufe des Jahres Apple als zweitwertvollstes Unternehmen der Welt überholen.

Kurz gesagt: Nvidia muss nicht mitspielen, wenn es nicht will.

Was Amazon Web Services (AWS) betrifft, den einzigen öffentlichen Cloud-Giganten, der nicht zu UALink beiträgt, so könnte dieser sich in einer „Abwarte-und-Sehen“-Haltung befinden, während er an seinen verschiedenen internen Beschleuniger-Hardware-Bemühungen arbeitet (kein Wortspiel beabsichtigt). Es könnte auch sein, dass AWS, das den Markt für Cloud-Dienste fest im Griff hat, keinen großen strategischen Sinn darin sieht, sich gegen Nvidia zu stellen, das einen Großteil der GPUs liefert, die es seinen Kunden liefert.

AWS antwortete nicht auf die Bitte von Tech um einen Kommentar.

Tatsächlich scheinen die größten Nutznießer von UALink – neben AMD und Intel – Microsoft, Meta und Google zu sein, die zusammen Milliarden von Dollar für Nvidia-GPUs ausgegeben haben, um ihre Clouds zu betreiben und ihre ständig wachsenden KI-Modelle zu trainieren. Sie alle versuchen, sich von einem Anbieter zu lösen, der ihrer Meinung nach das KI-Hardware-Ökosystem als besorgniserregend dominant betrachtet.

Google verfügt über maßgeschneiderte Chips zum Trainieren und Ausführen von KI-Modellen, TPUs und Axion. Amazon hat mehrere KI-Chipfamilien im Angebot. Microsoft ist letztes Jahr mit Maia und Cobalt in den Wettbewerb eingestiegen. Und Meta verfeinert seine eigene Beschleunigerreihe.

Inzwischen haben Microsoft und sein enger Partner OpenAI Berichten zufolge planen, mindestens 100 Milliarden Dollar für einen Supercomputer auszugeben, um KI-Modelle zu trainieren, die mit zukünftigen Versionen von Cobalt- und Maia-Chips ausgestattet werden. Diese Chips werden etwas brauchen, das sie verbindet – und vielleicht wird es UALink sein.