Letzte Woche habe ich über ein KI-Startup geschrieben, das eine Technologie entwickelt, die in Echtzeit den Akzent der Sprache einer Person verändern kann. Was aber, wenn das KI-Ziel stattdessen darin besteht, es Menschen zu ermöglichen, so zu sprechen, wie sie es tun, so verstanden zu werden, wie sie sind, und dabei einige der Vorurteile zu beseitigen, die vielen KI-Systemen innewohnen? Auch dafür besteht ein großer Bedarf, und jetzt rief ein britisches Startup an Speechmatik – das KI entwickelt hat, um Sprache in Text zu übersetzen, unabhängig vom Akzent oder der Art und Weise, wie die Person spricht – kündigt eine Finanzierung in Höhe von 62 Millionen US-Dollar an, um sein Geschäft auszubauen.

Susquehanna Growth Equity aus den USA führte die Runde mit britischen Investoren an AlbionVC und Auch IQ Capital ist dabei. Diese Serie B ist ein großer Schritt nach oben für Speechmatics. Das Unternehmen wurde ursprünglich im Jahr 2006 von Gründer Dr. Tony Robinson aus der KI-Forschung in Cambridge ausgegliedert und hatte zuvor nur rund 10 Millionen US-Dollar gesammelt (Albion und IQ gehören zu diesen früheren Unterstützern, zusammen mit dem von der CIA unterstützten In-Q -Tel und andere).

In der Zwischenzeit hat es einen Kundenstamm von etwa 170 aufgebaut – es verkauft nur B2B, um verbraucher- oder geschäftsorientierte Dienstleistungen zu betreiben – und obwohl es nicht die vollständige Liste offenlegt, beinhalten einige der Namen what3words, 3Play Media, Veritone, Deloitte UK und Vonage, die die Technologie unterschiedlich nutzen, nicht nur um Transkriptionen im traditionellen Sinne zu erstellen; sondern um gesprochene Wörter aufzunehmen, um andere Aspekte einer App-Funktion zu unterstützen, wie z. B. automatische Untertitelung, oder um breitere Barrierefreiheitsfunktionen zu aktivieren.

Seine Engine ist heute in der Lage, Sprache in Text in 34 Sprachen zu übersetzen, und zusätzlich zur Verwendung der Finanzierung sowohl zur weiteren Verbesserung der Genauigkeit dort als auch für die Geschäftsentwicklung wird es auch weitere Sprachen hinzufügen und verschiedene Anwendungsfälle untersuchen, wie z B. zum Aufbau von Sprache zu Text, die in der schwierigeren Umgebung von Kraftfahrzeugen verwendet werden kann (wo Motorgeräusche und Vibrationen die Art und Weise beeinflussen, wie KIs die Geräusche aufnehmen können).

„Wir haben Millionen von Stunden an Daten gesammelt, um KI-Voreingenommenheit zu bekämpfen. Unser Ziel ist es, jede und jede Stimme in mehreren Sprachen zu verstehen“, sagte Katy Wigdahl, CEO des Startups (ein Titel, den sie gemeinsam mit Robinson innehatte, der kürzlich von einer Führungsrolle zurückgetreten ist).

Dies manifestiert sich sowohl in der Produktorientierung als auch in der Mission des Unternehmens, und das möchte es auch ausbauen.

„Die Art und Weise, wie wir Sprache betrachten, ist global“, sagte Wigdahl. „Google wird für jede Englischversion ein anderes Paket haben, aber unser einziges Paket wird jede verstehen.“ Es stellte seine Technologie zunächst nur über eine private API zur Verfügung, die es an Kunden verkaufte; Um mehr Benutzer und möglicherweise mehr zahlende Benutzer zu gewinnen, bietet es Entwicklern jetzt auch mehr offene API-Tools, um mit der Technologie zu spielen, und einen Drag-and-Drop-Sampler auf seiner Website.

Und in der Tat, wenn eine der Herausforderungen von Speechmatics darin besteht, die KI zu trainieren, menschlicher in ihrem Verständnis dafür zu sein, wie Menschen sprechen, besteht die andere darin, sich gegenüber anderen großen Anbietern von Sprache-zu-Text-Technologie einen Namen zu machen.

Laut Wigdahl konkurriert das Unternehmen heute mit „Big Tech“ – das heißt großen Unternehmen wie Amazon, Google und Microsoft (das jetzt Nuance hat), die Spracherkennungs-Engines entwickelt haben und die Technologie als Service für Dritte anbieten.

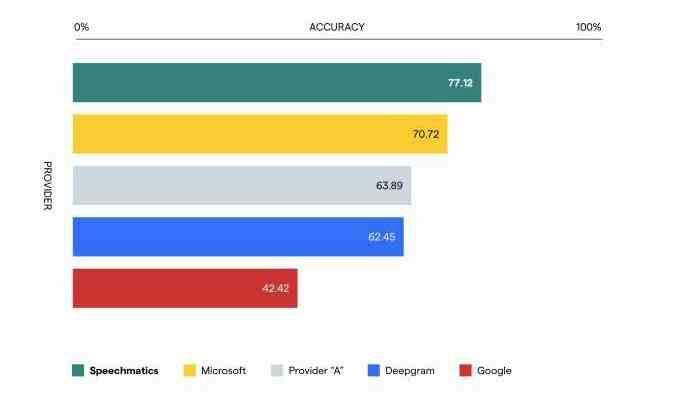

Aber es sagt, dass es in Tests durchweg besser abschneidet als diese, wenn es darum geht, zu verstehen, wann Sprachen auf die vielen Arten gesprochen werden, die sie sind. (Ein Test, der mir gegenüber zitiert wurde, war Stanfords „Racial Disparities in Rede Anerkennungsstudie, wo es verzeichnete „eine Gesamtgenauigkeit von 82,8 % für afroamerikanische Stimmen im Vergleich zu Google (68,6 %) und Amazon (68,6)“. Darin hieß es: „entspricht einer Reduzierung um 45 % Rede Erkennungsfehler – das Äquivalent von drei Wörtern in einem durchschnittlichen Satz. Es lieferte TC auch einen „mit Wettbewerbern gewichteter Durchschnitt“:

Bildnachweis: Sprachwissenschaft (öffnet in einem neuen Fenster)

Hier gibt es jedoch tatsächlich eine enorme Chance, wenn man bedenkt, dass es zwischen kleineren Entwicklern und riesigen, übergroßen Technologiegiganten wie Apple, Google, Microsoft und Amazon Hunderte von riesigen Unternehmen gibt, die möglicherweise nicht ganz auf dem Niveau (oder Interesse) von sind Eigene KI für diesen Zweck zu bauen, aber wenn Sie zum Beispiel ein Unternehmen wie Spotify nehmen, das definitiv daran interessiert ist und es definitiv vorziehen würde, nicht auf diese großen Unternehmen angewiesen zu sein, die manchmal auch ihre Konkurrenten sind, und manchmal ihre eigenen regelrechte Folien. (Um das klarzustellen, Wigdahl hat mir nicht gesagt, dass Spotify ein Kunde ist, aber gesagt, dass dies ein typisches Beispiel für die Art von Größe und Situation ist, in der jemand an Speechmatics Tür klopfen könnte.)

Auch das war teilweise der Grund, warum Investoren dieses Unternehmen so sehr finanzieren wollen. Susquehanna hat eine Geschichte der Unterstützung von Unternehmen, die den Anschein erwecken, als könnten sie den Powerplayern Konkurrenz machen (es war ein früher und großer Unterstützer von Tik Tok).

„Das Speechmatics-Team ist zweifellos ein anderer Stammbaum von Technologen“, sagte Jonathan Klahr, MD von Susquehanna Growth Equity, in einer Erklärung. „Wir begannen Speechmatics zu verfolgen, als uns unsere Portfoliounternehmen mitteilten, dass Speechmatics immer wieder durch Genauigkeit gegenüber allen anderen Optionen, einschließlich denen von ‚Big Tech‘-Playern, gewinnt. Wir sind bereit, mit dem Team zusammenzuarbeiten, um sicherzustellen, dass mehr Unternehmen diese überlegene Technologie kennenlernen und übernehmen können.“ Klahr steigt mit dieser Runde in den Vorstand ein.

In der Tat, da die Technologie immer mehr eingebürgert wird und diejenigen, die sie herstellen, nach mehr Wegen suchen, um alle Reibungen zu verringern, die es bei der Nutzung dieser Technologie geben könnte, hat sich die Stimme zu einem großen Chancenpunkt, aber auch zu einem Schmerzpunkt entwickelt. Eine Technologie, die beim „Lesen“ und Verstehen aller Arten von Stimmen funktioniert, kann also potenziell auf alle möglichen Arten angewendet werden.

„Unserer Ansicht nach wird die Stimme zur immer dominanteren Mensch-Maschine-Schnittstelle und Speechmatics ist führend in der Kategorie bei der Anwendung von Deep Learning auf Sprache, mit kategoriedefinierender Genauigkeit und Verständnis für alle Anwendungsfälle und Anforderungen der Branche“, fügte Robert Whitby-Smith, ein Partner, hinzu bei AlbionVC. „Wir haben das beeindruckende Wachstum des Teams und des Produkts in den letzten Jahren seit unserer Investition der Serie A im Jahr 2019 miterlebt, und als verantwortungsbewusste Investoren freuen wir uns, die umfassende Mission des Unternehmens zu unterstützen, jede Stimme weltweit zu verstehen.“