Untersuchungen zeigen das bis 2026, über 80 % der Unternehmen werden generative KI-Modelle, APIs oder Anwendungen nutzen, heute sind es weniger als 5 %.

Diese schnelle Einführung wirft neue Überlegungen zu Cybersicherheit, Ethik, Datenschutz und Risikomanagement auf. Unter den Unternehmen, die heute generative KI einsetzen, sind nur 38 % mindern Cybersicherheitsrisikenund nur 32 % arbeiten daran, Modellungenauigkeiten zu beheben.

Meine Gespräche mit Sicherheitsexperten und Unternehmern haben sich auf drei Schlüsselfaktoren konzentriert:

- Die Einführung generativer KI in Unternehmen bringt zusätzliche Komplexität bei Sicherheitsherausforderungen mit sich, wie etwa überprivilegierten Zugriff. Während beispielsweise herkömmliche Tools zur Verhinderung von Datenverlust den Datenfluss in KI-Anwendungen effektiv überwachen und steuern, sind sie bei unstrukturierten Daten und differenzierteren Faktoren wie ethischen Regeln oder voreingenommenen Inhalten in Eingabeaufforderungen häufig unzureichend.

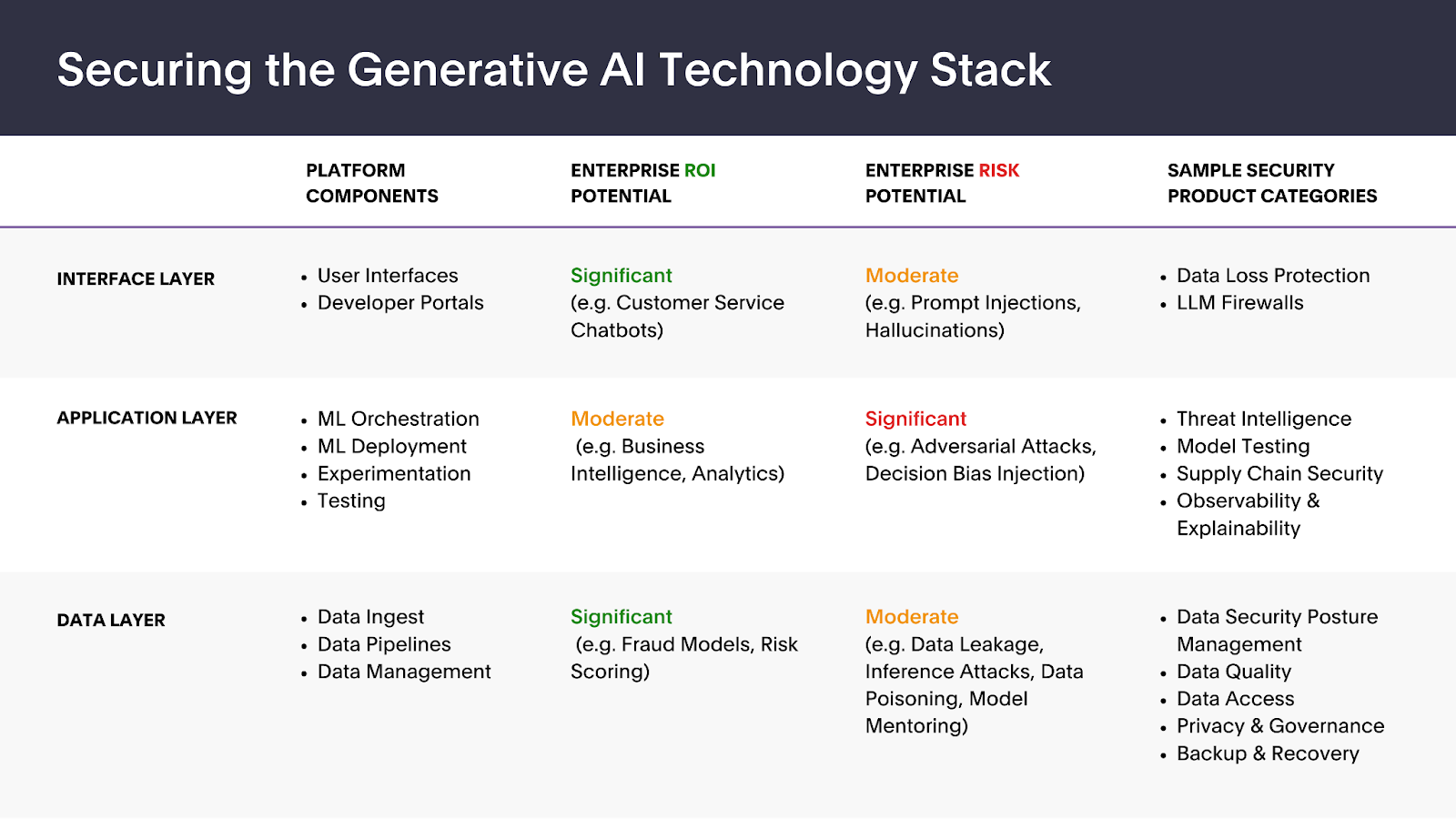

- Die Marktnachfrage nach verschiedenen GenAI-Sicherheitsprodukten ist eng mit dem Kompromiss zwischen ROI-Potenzial und inhärenten Sicherheitslücken der zugrunde liegenden Anwendungsfälle verknüpft, für die die Anwendungen eingesetzt werden. Dieses Gleichgewicht zwischen Chance und Risiko entwickelt sich aufgrund der fortlaufenden Weiterentwicklung der KI-Infrastrukturstandards und der Regulierungslandschaft weiter.

- Ähnlich wie herkömmliche Software muss generative KI auf allen Architekturebenen gesichert werden, insbesondere auf der Kernschnittstellen-, Anwendungs- und Datenebene. Nachfolgend finden Sie eine Momentaufnahme verschiedener Sicherheitsproduktkategorien innerhalb des Technologie-Stacks, die Bereiche hervorhebt, in denen Sicherheitsverantwortliche ein erhebliches ROI- und Risikopotenzial erkennen.

Bildnachweis: Forgepoint Capital

Die weit verbreitete Einführung von GenAI-Chatbots wird der Fähigkeit Priorität einräumen, Eingaben und entsprechende Ausgaben in großem Maßstab genau und schnell abzufangen, zu überprüfen und zu validieren, ohne die Benutzererfahrung zu beeinträchtigen.

Schnittstellenschicht: Benutzerfreundlichkeit und Sicherheit in Einklang bringen

Unternehmen sehen ein enormes Potenzial in der Nutzung kundenorientierter Chatbots, insbesondere maßgeschneiderter Modelle, die auf branchen- und unternehmensspezifischen Daten trainiert werden. Die Benutzeroberfläche ist anfällig für Prompt-Injections, eine Variante von Injektionsangriffen, die darauf abzielen, die Reaktion oder das Verhalten des Modells zu manipulieren.

Darüber hinaus stehen Chief Information Security Officers (CISOs) und Sicherheitsverantwortliche zunehmend unter dem Druck, GenAI-Anwendungen in ihren Organisationen zu ermöglichen. Während die Konsumerisierung des Unternehmens ein anhaltender Trend ist, hat die schnelle und weit verbreitete Einführung von Technologien wie ChatGPT einen beispiellosen, von den Mitarbeitern geleiteten Drang nach ihrem Einsatz am Arbeitsplatz ausgelöst.

Die weit verbreitete Einführung von GenAI-Chatbots wird der Fähigkeit Priorität einräumen, Eingaben und entsprechende Ausgaben in großem Maßstab genau und schnell abzufangen, zu überprüfen und zu validieren, ohne die Benutzererfahrung zu beeinträchtigen. Bestehende Datensicherheitstools basieren häufig auf voreingestellten Regeln, was zu Fehlalarmen führt. Tools wie Protect AI’s Abfuhr Und Harmonische Sicherheit Nutzen Sie KI-Modelle, um dynamisch zu bestimmen, ob die Daten, die eine GenAI-Anwendung durchlaufen, vertraulich sind oder nicht.