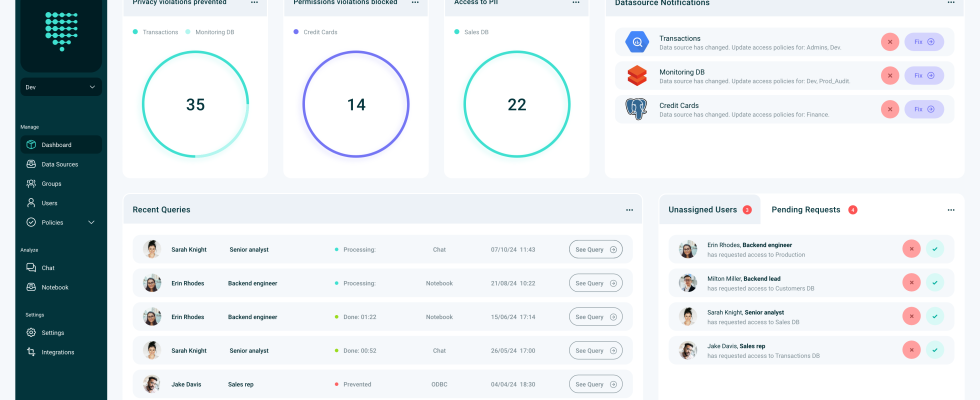

Unternehmen horten mehr Daten denn je, um ihre KI-Ambitionen voranzutreiben, machen sich aber gleichzeitig auch Sorgen darüber, wer auf diese Daten zugreifen kann, die oft sehr privater Natur sind. PVML bietet eine interessante Lösung, indem es ein ChatGPT-ähnliches Tool zur Datenanalyse mit den Sicherheitsgarantien der differenziellen Privatsphäre kombiniert. Mithilfe der Retrieval-Augmented Generation (RAG) kann PVML auf die Daten eines Unternehmens zugreifen, ohne diese zu verschieben, wodurch ein weiterer Sicherheitsaspekt entfällt.

Das in Tel Aviv ansässige Unternehmen gab kürzlich bekannt, dass es eine von NFX angeführte Seed-Runde in Höhe von 8 Millionen US-Dollar unter Beteiligung von FJ Labs und Gefen Capital abgeschlossen hat.

Bildnachweis: PVML

Das Unternehmen wurde von einem Ehepaar gegründet Schachar Schnapp (CEO) und Rina Galperin (CTO). Schnapp promovierte in Informatik mit Spezialisierung auf differenzielle Privatsphäre und arbeitete anschließend bei General Motors im Bereich Computer Vision, während Galperin ihren Master in Informatik mit Schwerpunkt auf KI und Verarbeitung natürlicher Sprache machte und an maschinellen Lernprojekten bei Microsoft arbeitete.

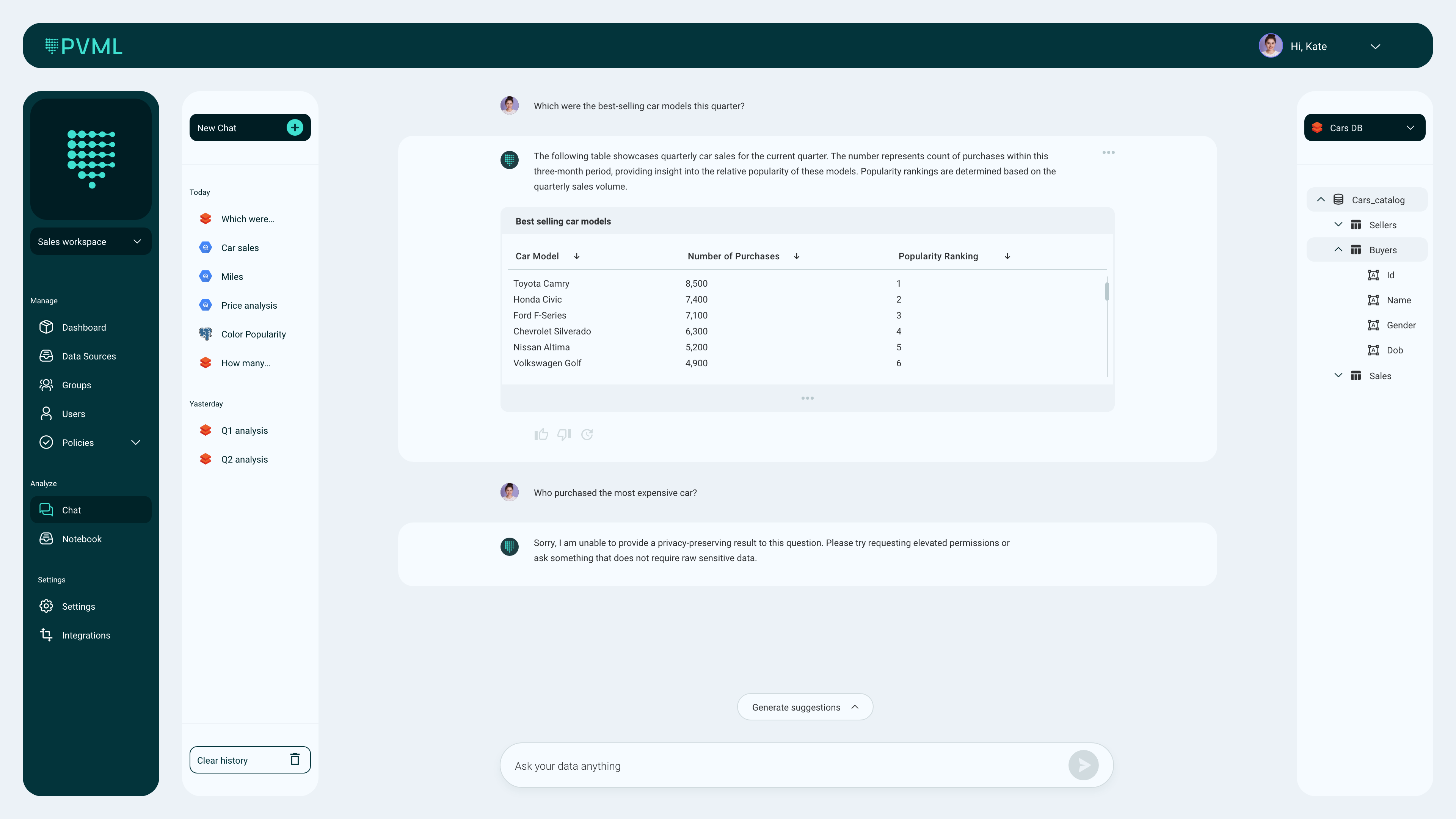

„Ein Großteil unserer Erfahrungen in diesem Bereich stammt aus unserer Arbeit in großen Konzernen und großen Unternehmen, wo wir gesehen haben, dass die Dinge vielleicht nicht so effizient sind, wie wir es uns als naive Studenten erhofft hatten“, sagte Galperin. „Der Hauptwert, den wir Organisationen als PVML bieten wollen, ist die Demokratisierung von Daten. Dies kann nur passieren, wenn man einerseits diese sehr sensiblen Daten schützt, andererseits aber einen einfachen Zugriff darauf ermöglicht, was heute gleichbedeutend mit KI ist. Jeder möchte Daten mithilfe von Freitext analysieren. Es ist viel einfacher, schneller und effizienter – und unser Geheimrezept, Differential Privacy, ermöglicht diese Integration ganz einfach.“

Differenzierte Privatsphäre ist alles andere als ein neues Konzept. Die Kernidee besteht darin, die Privatsphäre einzelner Benutzer in großen Datenmengen zu gewährleisten und dafür mathematische Garantien bereitzustellen. Eine der gebräuchlichsten Methoden, dies zu erreichen, besteht darin, ein gewisses Maß an Zufälligkeit in den Datensatz einzuführen, jedoch auf eine Weise, die die Datenanalyse nicht verändert.

Das Team argumentiert, dass die heutigen Datenzugriffslösungen ineffektiv sind und viel Overhead verursachen. Beispielsweise müssen häufig viele Daten entfernt werden, um Mitarbeitern einen sicheren Zugriff auf Daten zu ermöglichen. Dies kann jedoch kontraproduktiv sein, da Sie die geschwärzten Daten möglicherweise nicht effektiv für einige Aufgaben (und darüber hinaus) nutzen können Die Vorlaufzeit für den Zugriff auf die Daten bedeutet, dass Echtzeit-Anwendungsfälle oft unmöglich sind.

Bildnachweis: PVML

Das Versprechen, differenziellen Datenschutz zu nutzen, bedeutet, dass PVML-Benutzer keine Änderungen an den Originaldaten vornehmen müssen. Dadurch wird nahezu der gesamte Overhead vermieden und diese Informationen sicher für KI-Anwendungsfälle freigegeben.

Praktisch alle groß Technik Firmen nutzen nun in der einen oder anderen Form Differential Privacy und stellen ihre Tools und Bibliotheken Entwicklern zur Verfügung. Das PVML-Team argumentiert, dass es von den meisten Daten-Communitys noch nicht wirklich in die Praxis umgesetzt wurde.

„Das aktuelle Wissen über unterschiedliche Privatsphäre ist eher theoretisch als praktisch“, sagte Schnapp. „Wir haben beschlossen, es von der Theorie in die Praxis umzusetzen. Und genau das haben wir getan: Wir entwickeln praktische Algorithmen, die am besten mit Daten in realen Szenarien funktionieren.“

Keine der differenzierten Datenschutzarbeiten würde von Bedeutung sein, wenn die tatsächlichen Datenanalysetools und die Plattform von PVML nicht nützlich wären. Der offensichtlichste Anwendungsfall ist hier die Möglichkeit, mit Ihren Daten zu chatten, und das alles mit der Garantie, dass keine sensiblen Daten in den Chat gelangen können. Mithilfe von RAG kann PVML Halluzinationen auf nahezu Null reduzieren und der Aufwand ist minimal, da die Daten an Ort und Stelle bleiben.

Es gibt aber auch andere Anwendungsfälle. Schnapp und Galperin stellten fest, dass der differenzierte Datenschutz es Unternehmen nun auch ermöglicht, Daten zwischen Geschäftsbereichen auszutauschen. Darüber hinaus kann es einigen Unternehmen auch ermöglichen, den Zugriff auf ihre Daten beispielsweise für Dritte zu monetarisieren.

„Auf dem heutigen Aktienmarkt werden 70 % der Transaktionen durch KI durchgeführt“, sagte Gigi Levy-Weiss, NFX-General Partner und Mitbegründer. „Das ist ein Vorgeschmack auf die Zukunft, und Unternehmen, die heute KI einführen, werden morgen einen Schritt voraus sein. Aber Unternehmen haben Angst davor, ihre Daten mit KI zu verknüpfen, weil sie die Offenlegung fürchten – und das aus guten Gründen. Die einzigartige Technologie von PVML schafft eine unsichtbare Schutzschicht und demokratisiert den Zugriff auf Daten, ermöglicht Monetarisierungsanwendungsfälle heute und ebnet den Weg für morgen.“