Der nächste Durchbruch, der die KI-Welt im Sturm erobern wird, könnten 3D-Modellgeneratoren sein. Diese Woche hat OpenAI Open-Source Point-E veröffentlicht, ein maschinelles Lernsystem, das ein 3D-Objekt bei einer Texteingabeaufforderung erstellt. Laut a Papier neben veröffentlicht CodebasisPoint-E kann 3D-Modelle in 1 bis 2 Minuten auf einer einzigen Nvidia V100-GPU erstellen.

Point-E erstellt keine 3D-Objekte im herkömmlichen Sinne. Vielmehr erzeugt es Punktwolken oder diskrete Sätze von Datenpunkten im Raum, die eine 3D-Form darstellen – daher die freche Abkürzung. (Das „E“ in Point-E ist die Abkürzung für „Effizienz“, weil es angeblich schneller ist als frühere Ansätze zur 3D-Objektgenerierung.) Punktwolken sind aus rechnerischer Sicht einfacher zu synthetisieren, aber sie erfassen nicht die Feinkörnigkeit eines Objekts Form oder Textur – derzeit eine wichtige Einschränkung von Point-E.

Um diese Einschränkung zu umgehen, trainierte das Point-E-Team ein zusätzliches KI-System, um die Punktwolken von Point-E in Meshes umzuwandeln. (Netze – die Sammlungen von Scheitelpunkten, Kanten und Flächen, die ein Objekt definieren – werden häufig in der 3D-Modellierung und im Design verwendet.) In der Veröffentlichung wird jedoch darauf hingewiesen, dass das Modell manchmal bestimmte Teile von Objekten übersehen kann, was zu blockigen oder verzerrten Formen führt.

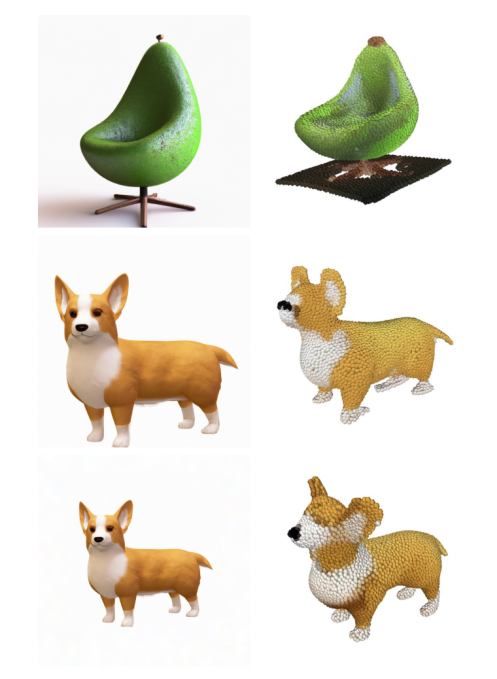

Bildnachweis: OpenAI

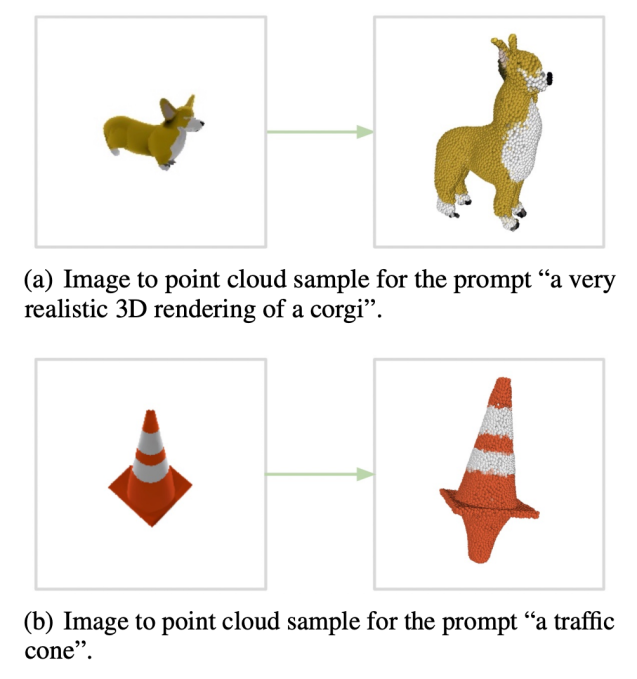

Abgesehen von dem Mesh-generierenden Modell, das allein steht, besteht Point-E aus zwei Modellen: einem Text-zu-Bild-Modell und einem Bild-zu-3D-Modell. Das Text-zu-Bild-Modell, ähnlich generativen Kunstsystemen wie OpenAIs eigenem DALL-E 2 und Stable Diffusion, wurde an beschrifteten Bildern trainiert, um die Assoziationen zwischen Wörtern und visuellen Konzepten zu verstehen. Das Bild-zu-3D-Modell hingegen wurde mit einer Reihe von Bildern gepaart mit 3D-Objekten gefüttert, damit es lernte, effektiv zwischen den beiden zu übersetzen.

Wenn eine Textaufforderung gegeben wird – zum Beispiel „ein 3D-druckbares Zahnrad, ein einzelnes Zahnrad mit einem Durchmesser von 3 Zoll und einem halben Zoll dick“ – generiert das Text-zu-Bild-Modell von Point-E ein synthetisches gerendertes Objekt, das dem Bild-zu-Bild-Prozess zugeführt wird. 3D-Modell, das dann eine Punktwolke generiert.

Nach dem Training der Modelle mit einem Datensatz von „mehreren Millionen“ 3D-Objekten und zugehörigen Metadaten konnte Point-E farbige Punktwolken erzeugen, die häufig mit Texteingabeaufforderungen übereinstimmten, sagen die OpenAI-Forscher. Es ist nicht perfekt – das Bild-zu-3D-Modell von Point-E kann manchmal das Bild aus dem Text-zu-Bild-Modell nicht verstehen, was zu einer Form führt, die nicht mit der Texteingabeaufforderung übereinstimmt. Dennoch ist es um Größenordnungen schneller als der vorherige Stand der Technik – zumindest laut dem OpenAI-Team.

Konvertieren der Point-E-Punktwolken in Meshes.

„Während unsere Methode bei dieser Bewertung schlechter abschneidet als modernste Techniken, produziert sie Proben in einem kleinen Bruchteil der Zeit“, schrieben sie in der Zeitung. „Dies könnte es für bestimmte Anwendungen praktischer machen oder die Entdeckung von 3D-Objekten mit höherer Qualität ermöglichen.“

Was genau sind die Anwendungen? Nun, die OpenAI-Forscher weisen darauf hin, dass die Punktwolken von Point-E zur Herstellung realer Objekte verwendet werden könnten, beispielsweise durch 3D-Druck. Mit dem zusätzlichen Mesh-Converting-Modell könnte das System – wenn es etwas ausgefeilter ist – auch in die Workflows der Spiele- und Animationsentwicklung Einzug halten.

OpenAI ist vielleicht das neueste Unternehmen, das in den Kampf um 3D-Objektgeneratoren einsteigt, aber – wie bereits erwähnt – ist es sicherlich nicht das erste. Anfang dieses Jahres veröffentlichte Google DreamFusion, eine erweiterte Version von Dream Fields, einem generativen 3D-System, das das Unternehmen bereits 2021 vorstellte. Im Gegensatz zu Dream Fields erfordert DreamFusion keine vorherige Schulung, was bedeutet, dass es 3D-Darstellungen von Objekten ohne 3D-Daten erstellen kann.

Während derzeit alle Augen auf 2D-Kunstgeneratoren gerichtet sind, könnte die modellsynthetisierende KI der nächste große Branchenstörer sein. 3D-Modelle werden häufig in Film und Fernsehen, Innenarchitektur, Architektur und verschiedenen Wissenschaftsbereichen verwendet. Architekturbüros verwenden sie zum Beispiel, um vorgeschlagene Gebäude und Landschaften zu demonstrieren, während Ingenieure Modelle als Entwürfe für neue Geräte, Fahrzeuge und Strukturen nutzen.

Point-E-Fehlerfälle.

Die Herstellung von 3D-Modellen dauert jedoch normalerweise eine Weile – zwischen mehreren Stunden und mehreren Tagen. KI wie Point-E könnte das ändern, wenn die Knicke eines Tages behoben werden, und OpenAI damit einen respektablen Gewinn einbringen.

Die Frage ist, welche Art von Streitigkeiten über geistiges Eigentum im Laufe der Zeit auftreten können. Es gibt einen großen Markt für 3D-Modelle mit mehreren Online-Marktplätzen, darunter CGStudio und CreativeMarket, die es Künstlern ermöglichen, von ihnen erstellte Inhalte zu verkaufen. Wenn sich Point-E durchsetzt und seine Modelle ihren Weg auf die Marktplätze finden, könnten Modellkünstler protestieren und auf Beweise verweisen, dass die moderne generative KI stark von ihren Trainingsdaten borgt – in Point-E’s Fall von bestehenden 3D-Modellen. Wie DALL-E 2 erwähnt oder zitiert Point-E keinen der Künstler, die seine Generationen beeinflusst haben könnten.

Aber OpenAI verschiebt dieses Thema für einen anderen Tag. Weder im Point-E-Papier noch auf der GitHub-Seite wird das Urheberrecht erwähnt.

Zu ihrer Ehre, die Forscher tun erwähnen, dass sie davon ausgehen, dass Point-E darunter leiden wird andere Probleme, wie aus den Trainingsdaten geerbte Verzerrungen und fehlende Sicherheitsvorkehrungen in Bezug auf Modelle, die zur Erstellung „gefährlicher Objekte“ verwendet werden könnten. Das ist vielleicht der Grund, warum sie Point-E sorgfältig als „Ausgangspunkt“ bezeichnen, von dem sie hoffen, dass er „weitere Arbeiten“ auf dem Gebiet der Text-zu-3D-Synthese anregen wird.