OpenAI stellte am Donnerstag GPT-4o mini vor, sein neuestes kleines KI-Modell. Das Unternehmen sagt GPT-4o minidas günstiger und schneller ist als die aktuellen hochmodernen KI-Modelle von OpenAI, wird ab heute für Entwickler sowie über die ChatGPT-Web- und Mobil-App für Verbraucher veröffentlicht. Unternehmensbenutzer erhalten nächste Woche Zugriff.

Das Unternehmen sagt, dass GPT-4o mini branchenführende kleine KI-Modelle bei Denkaufgaben mit Text und Bild übertrifft. Da sich kleine KI-Modelle verbessern, werden sie bei Entwicklern aufgrund ihrer Geschwindigkeit und Kosteneffizienz im Vergleich zu größeren Modellen wie GPT-4 Omni oder Claude 3.5 Sonnet immer beliebter. Sie sind eine nützliche Option für umfangreiche, einfache Aufgaben, für deren Ausführung Entwickler möglicherweise wiederholt ein KI-Modell aufrufen.

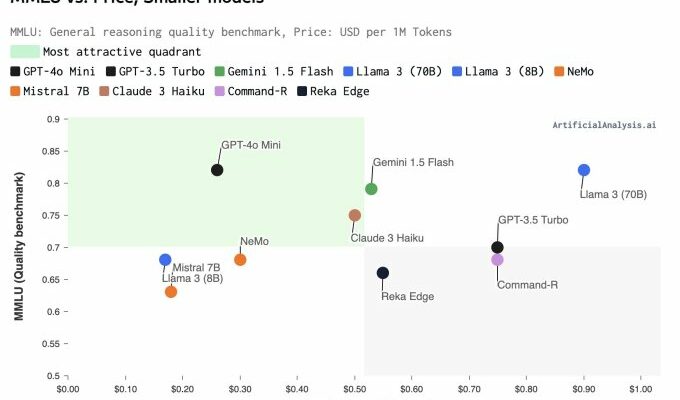

GPT-4o mini wird GPT-3.5 Turbo als kleinstes Modell ersetzen, das OpenAI anbietet. Das Unternehmen behauptet, dass sein neuestes KI-Modell 82 % bei MMLU erreicht, einem Benchmark zur Messung des Denkvermögens, verglichen mit 79 % bei Gemini 1.5 Flash und 75 % bei Claude 3 Haiku, laut Daten von Künstliche Analyse. Bei MGSM, das das mathematische Denkvermögen misst, erreichte GPT-4o mini 87 %, verglichen mit 78 % für Flash und 72 % für Haiku.

Darüber hinaus ist GPT-4o mini laut OpenAI deutlich kostengünstiger im Betrieb als seine Vorgängermodelle und mehr als 60 % günstiger als GPT-3.5 Turbo. Heute unterstützt GPT-4o mini Text und Vision in der API, und OpenAI sagt, dass das Modell in Zukunft Video- und Audiofunktionen unterstützen wird.

„Damit jeder Winkel der Welt durch KI gestärkt werden kann, müssen wir die Modelle viel erschwinglicher machen“, sagte Olivier Godement, Leiter der Produkt-API von OpenAI, in einem Interview mit Tech. „Ich denke, GPT-4o mini ist in dieser Richtung ein wirklich großer Schritt nach vorne.“

Für Entwickler, die auf der API von OpenAI aufbauen, kostet GPT4o mini 15 Cent pro Million Eingabetoken und 60 Cent pro Million Ausgabetoken. Das Modell hat ein Kontextfenster von 128.000 Token, ungefähr die Länge eines Buches, und einen Wissensschluss von Oktober 2023.

OpenAI wollte nicht genau verraten, wie groß GPT-4o mini ist, sagte aber, dass es ungefähr auf derselben Stufe wie andere kleine KI-Modelle wie Llama 3 8b, Claude Haiku und Gemini 1.5 Flash liegt. Das Unternehmen behauptet jedoch, dass GPT-4o mini schneller, kosteneffizienter und intelligenter sei als branchenführende kleine Modelle, basierend auf Tests vor der Markteinführung im Chatbot-Bereich von LMSYS.org. Erste unabhängige Tests scheinen dies zu bestätigen.

„Im Vergleich zu vergleichbaren Modellen ist GPT-4o mini mit einer mittleren Ausgabegeschwindigkeit von 202 Token pro Sekunde sehr schnell“, sagte George Cameron, Mitbegründer von Artificial Analysis, in einer E-Mail an Tech. „Das ist mehr als doppelt so schnell wie GPT-4o und GPT-3.5 Turbo und stellt ein überzeugendes Angebot für geschwindigkeitsabhängige Anwendungsfälle dar, darunter viele Verbraucheranwendungen und agentische Ansätze zur Verwendung von LLMs.“

Unabhängig davon kündigte OpenAI am Donnerstag neue Tools für Unternehmenskunden an. In einem Blogeintraghat OpenAI die Enterprise Compliance API angekündigt, um Unternehmen in stark regulierten Branchen wie dem Finanz- und Gesundheitswesen, dem Rechtssektor und dem öffentlichen Dienst dabei zu helfen, Protokollierungs- und Prüfungsanforderungen einzuhalten.

Das Unternehmen sagt, dass diese Tools es Administratoren ermöglichen werden, ihre ChatGPT Enterprise-Daten zu prüfen und entsprechende Maßnahmen zu ergreifen. Die API wird Aufzeichnungen zeitgestempelter Interaktionen bereitstellen, darunter Konversationen, hochgeladene Dateien, Arbeitsbereichsbenutzer und mehr.

OpenAI gibt Administratoren außerdem eine genauere Kontrolle über Workspace-GPTs, eine benutzerdefinierte Version von ChatGPT, die für bestimmte geschäftliche Anwendungsfälle erstellt wurde. Bisher konnten Administratoren GPT-Aktionen, die in ihrem Workspace erstellt wurden, nur vollständig zulassen oder blockieren. Jetzt können Workspace-Besitzer jedoch eine genehmigte Liste von Domänen erstellen, mit denen GPTs interagieren können.