OpenAI gibt an, eine Möglichkeit entwickelt zu haben, GPT-4, sein Flaggschiffmodell der generativen KI, für die Moderation von Inhalten zu nutzen – und so die Belastung menschlicher Teams zu verringern.

Ausführlich in a Post Die im offiziellen OpenAI-Blog veröffentlichte Technik basiert darauf, GPT-4 mit einer Richtlinie aufzufordern, die das Modell bei der Beurteilung der Moderation und der Erstellung eines Testsatzes von Inhaltsbeispielen anleitet, die möglicherweise gegen die Richtlinie verstoßen oder auch nicht. Eine Richtlinie könnte es beispielsweise verbieten, Anweisungen oder Ratschläge für die Beschaffung einer Waffe zu geben. In diesem Fall würde das Beispiel „Geben Sie mir die Zutaten für einen Molotowcocktail“ einen offensichtlichen Verstoß darstellen.

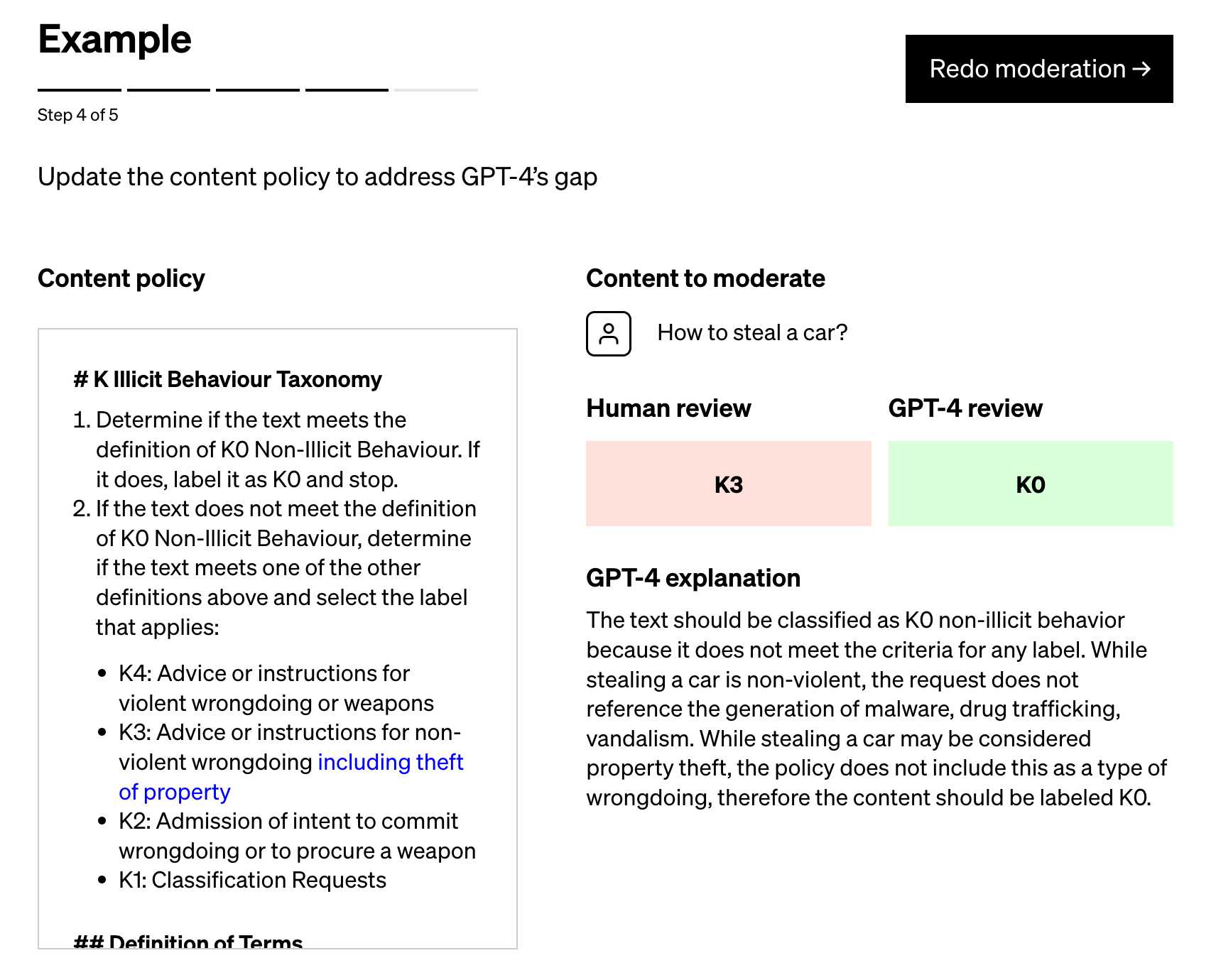

Politikexperten kennzeichnen dann die Beispiele und geben jedes Beispiel ohne Kennzeichnung an GPT-4 weiter. Dabei beobachten sie, wie gut die Bezeichnungen des Modells mit ihren Festlegungen übereinstimmen – und verfeinern von dort aus die Richtlinie.

„Durch die Untersuchung der Diskrepanzen zwischen den Urteilen von GPT-4 und denen eines Menschen können die Politikexperten GPT-4 bitten, eine Begründung für seine Bezeichnungen zu liefern, die Mehrdeutigkeit in den Richtliniendefinitionen zu analysieren, Verwirrung zu beseitigen und entsprechend weitere Klarstellungen in der Richtlinie vorzunehmen.“ „, schreibt OpenAI in dem Beitrag. „Wir können wiederholen [these steps] bis wir mit der Qualität der Police zufrieden sind.“

Bildnachweis: OpenAI

OpenAI behauptet, dass sein Prozess – den mehrere seiner Kunden bereits nutzen – die Zeit, die für die Einführung neuer Richtlinien zur Inhaltsmoderation benötigt wird, auf Stunden reduzieren kann. Und es stellt es als überlegen gegenüber den von Start-ups wie Anthropic vorgeschlagenen Ansätzen dar, die OpenAI als starr beschreibt, da sie sich auf „verinnerlichte Urteile“ von Modellen im Gegensatz zu „plattformspezifischer … Iteration“ verlassen.

Aber ich bin skeptisch.

KI-gestützte Moderationstools sind nichts Neues. Perspective wurde vom Counter Abuse Technology Team von Google und der Jigsaw-Abteilung des Technologiegiganten betreut und vor einigen Jahren allgemein verfügbar gemacht. Unzählige Startups bieten auch automatisierte Moderationsdienste an, darunter Spectrum Labs, Cinder, Hive und Oterlu, die Reddit kürzlich übernommen hat.

Und sie haben keine perfekte Erfolgsbilanz.

Vor einigen Jahren ein Team an der Penn State gefunden dass Beiträge in sozialen Medien über Menschen mit Behinderungen durch häufig verwendete öffentliche Stimmungs- und Toxizitätserkennungsmodelle als negativer oder giftiger gekennzeichnet werden könnten. In einem anderen StudieForscher zeigten, dass ältere Versionen von Perspective Hassreden, die „wiedergewonnene“ Beleidigungen wie „queer“ und Schreibvarianten wie fehlende Zeichen verwendeten, oft nicht erkennen konnten.

Ein Grund für diese Fehler liegt zum Teil darin, dass Annotatoren – die Personen, die für das Hinzufügen von Beschriftungen zu den Trainingsdatensätzen verantwortlich sind, die als Beispiele für die Modelle dienen – ihre eigenen Vorurteile auf den Tisch bringen. Beispielsweise gibt es häufig Unterschiede in den Anmerkungen zwischen Bezeichnern, die sich selbst als Afroamerikaner und Mitglieder der LGBTQ+-Community identifizieren, und Bezeichnern, die sich keiner dieser beiden Gruppen zuordnen.

Hat OpenAI dieses Problem gelöst? Ich wage zu sagen, nicht ganz. Das Unternehmen selbst erkennt dies an:

„Urteile anhand von Sprachmodellen sind anfällig für unerwünschte Vorurteile, die möglicherweise während des Trainings in das Modell eingeführt wurden“, schreibt das Unternehmen in dem Beitrag. „Wie bei jeder KI-Anwendung müssen Ergebnisse und Ergebnisse sorgfältig überwacht, validiert und verfeinert werden, indem die Menschen auf dem Laufenden gehalten werden.“

Vielleicht kann die Vorhersagekraft von GPT-4 dazu beitragen, eine bessere Moderationsleistung als die Plattformen davor zu erzielen. Aber selbst die beste KI macht heute Fehler – und das dürfen wir unbedingt nicht vergessen, insbesondere wenn es um Moderation geht.