Während sich die Investoren nach Sam Altmans kurzerhand Entlassung aus OpenAI auf den Atomausstieg vorbereiteten und Altman seine Rückkehr in das Unternehmen plante, beschäftigten sich die Mitglieder des Superalignment-Teams von OpenAI eifrig mit dem Problem, wie man KI steuern kann, die intelligenter als Menschen ist.

Zumindest ist das der Eindruck, den sie vermitteln möchten.

Diese Woche nahm ich einen Anruf mit drei Mitgliedern des Superalignment-Teams – Collin Burns, Pavel Izmailov und Leopold Aschenbrenner – entgegen, die in New Orleans waren bei NeurIPS, der jährlichen Konferenz für maschinelles Lernen, präsentieren OpenAIs neueste Arbeit zur Sicherstellung, dass sich KI-Systeme wie vorgesehen verhalten.

OpenAI gründete im Juli das Superalignment-Team, um Möglichkeiten zur Steuerung, Regulierung und Steuerung „superintelligenter“ KI-Systeme zu entwickeln – also theoretische Systeme mit einer Intelligenz, die die des Menschen weit übersteigt.

„Heute können wir im Grunde Modelle angleichen, die dümmer sind als wir oder vielleicht auf menschlicher Ebene maximal“, sagte Burns. „Ein Modell auszurichten, das tatsächlich intelligenter ist als wir, ist viel, viel weniger offensichtlich – wie können wir das überhaupt tun?“

Die Superalignment-Bemühungen werden von Ilya Sutskever, Mitbegründer und Chefwissenschaftler von OpenAI, geleitet, was im Juli nicht für Aufsehen sorgte – jetzt aber sicherlich, wenn man bedenkt, dass Sutskever zu denen gehörte, die ursprünglich auf Altmans Entlassung drängten. Während ein paar Berichterstattung deutet darauf hin, dass sich Sutskever nach Altmans Rückkehr in einem „Zustand der Schwebe“ befindet. Die PR von OpenAI sagt mir, dass Sutskever tatsächlich – zumindest bis heute – immer noch das Superalignment-Team leitet.

Superalignment ist in der KI-Forschungsgemeinschaft ein heikles Thema. Einige argumentieren, dass das Unterfeld verfrüht sei; andere meinen, es sei ein Ablenkungsmanöver.

Während Altman zu Vergleichen zwischen OpenAI und dem Manhattan-Projekt aufgerufen hat und sogar ein Team zusammengestellt hat, um KI-Modelle zum Schutz vor „katastrophalen Risiken“, einschließlich chemischer und nuklearer Bedrohungen, zu untersuchen, sagen einige Experten, dass es kaum Anhaltspunkte dafür gibt, dass die Technologie des Startups dies tun wird Erlangen Sie in naher Zukunft – oder überhaupt jemals – weltvernichtende Fähigkeiten, mit denen Sie den Menschen überlisten können. Behauptungen über eine bevorstehende Superintelligenz, fügen diese Experten hinzu, dienen nur dazu, die Aufmerksamkeit bewusst von den drängenden KI-Regulierungsproblemen der Zeit abzulenken und von ihnen abzulenken, wie etwa algorithmische Voreingenommenheit und die Tendenz der KI zur Toxizität.

Was es wert ist, scheint Suksever zu glauben ernsthaft diese KI – nicht OpenAI an sich, aber irgendeine Verkörperung davon – könnte eines Tages eine existenzielle Bedrohung darstellen. Berichten zufolge ging er sogar so weit Kommission und brennen ein hölzernes Abbild bei einem externen Unternehmen, um sein Engagement zu demonstrieren, zu verhindern, dass KI-Schäden der Menschheit widerfahren, und verfügt über eine bedeutende Menge der Rechenleistung von OpenAI – 20 % der vorhandenen Computerchips – für die Forschung des Superalignment-Teams.

„Der KI-Fortschritt war in letzter Zeit außerordentlich schnell, und ich kann Ihnen versichern, dass er sich nicht verlangsamt“, sagte Aschenbrenner. „Ich denke, wir werden bald Systeme auf menschlicher Ebene erreichen, aber dabei wird es noch nicht bleiben – wir werden bis zu übermenschlichen Systemen vordringen … Wie können wir also übermenschliche KI-Systeme aufeinander abstimmen und sie sicher machen? Es ist wirklich ein Problem für die gesamte Menschheit – vielleicht das wichtigste ungelöste technische Problem unserer Zeit.“

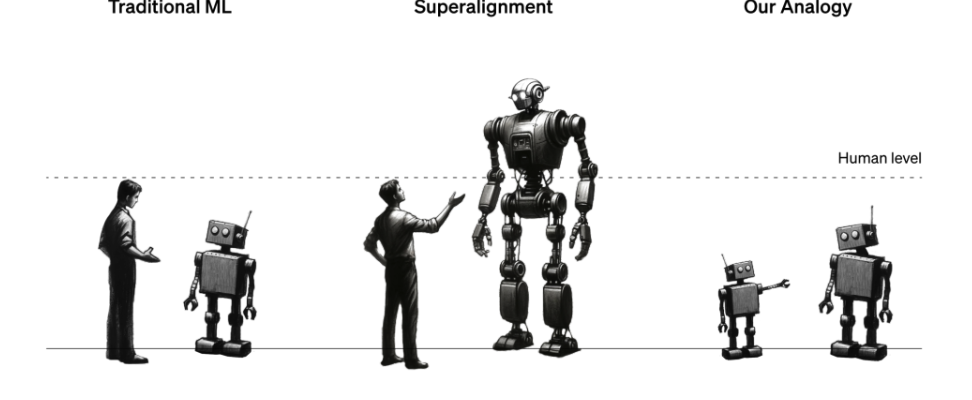

Das Superalignment-Team versucht derzeit, Governance- und Kontrollrahmen zu schaffen könnte lassen sich gut auf zukünftige leistungsstarke KI-Systeme anwenden. Das ist keine einfache Aufgabe, wenn man bedenkt, dass die Definition von „Superintelligenz“ – und ob ein bestimmtes KI-System diese erreicht hat – Gegenstand heftiger Debatten ist. Doch der Ansatz, für den sich das Team vorerst entschieden hat, besteht darin, ein schwächeres, weniger ausgereiftes KI-Modell (z. B. GPT-2) zu verwenden, um ein fortschrittlicheres, ausgefeilteres Modell (GPT-4) in wünschenswerte Richtungen zu lenken – und weg von unerwünschten.

Eine Abbildung, die die KI-basierte Analogie des Superalignment-Teams zur Ausrichtung superintelligenter Systeme veranschaulicht.

„Wir versuchen vor allem, einem Modell zu sagen, was es tun soll, und sicherzustellen, dass es es auch tun wird“, sagte Burns. „Wie bringen wir ein Modell dazu, Anweisungen zu befolgen und nur bei Dingen zu helfen, die wahr sind und nichts zu erfinden? Wie bringen wir ein Modell dazu, uns mitzuteilen, ob der von ihm generierte Code sicheres oder ungeheuerliches Verhalten darstellt? Solche Aufgaben wollen wir mit unserer Forschung lösen.“

Aber warten Sie, könnten Sie sagen: Was hat die Steuerung der KI durch die KI mit der Verhinderung einer die Menschheit bedrohenden KI zu tun? Nun, es ist eine Analogie: Das schwache Modell soll als Ersatz für menschliche Vorgesetzte dienen, während das starke Modell eine superintelligente KI darstellt. Ähnlich wie Menschen, die möglicherweise nicht in der Lage sind, ein superintelligentes KI-System zu verstehen, kann das schwache Modell nicht alle Komplexitäten und Nuancen des starken Modells „verstehen“ – was den Aufbau nützlich macht, um Superalignment-Hypothesen zu beweisen, sagt das Superalignment-Team .

„Sie können sich einen Sechstklässler vorstellen, der versucht, einen College-Studenten zu beaufsichtigen“, erklärte Izmailov. „Nehmen wir an, der Sechstklässler versucht, dem College-Studenten von einer Aufgabe zu erzählen, die er irgendwie zu lösen weiß … Auch wenn die Aufsicht des Sechstklässlers im Detail Fehler enthalten kann, besteht die Hoffnung, dass der College-Student das Wesentliche versteht wäre in der Lage, die Aufgabe besser zu erledigen als der Vorgesetzte.“

Im Aufbau des Superalignment-Teams generiert ein schwaches Modell, das auf eine bestimmte Aufgabe genau abgestimmt ist, Beschriftungen, die verwendet werden, um dem starken Modell die Grundzüge dieser Aufgabe zu „kommunizieren“. Angesichts dieser Bezeichnungen kann das starke Modell entsprechend der Absicht des schwachen Modells mehr oder weniger korrekt verallgemeinern – selbst wenn die Bezeichnungen des schwachen Modells Fehler und Verzerrungen enthalten, stellte das Team fest.

Der Ansatz des Schwach-Stark-Modells könnte sogar zu Durchbrüchen im Bereich der Halluzinationen führen, behauptet das Team.

„Halluzinationen sind eigentlich ziemlich interessant, weil das Modell intern tatsächlich weiß, ob das, was es sagt, Tatsache oder Fiktion ist“, sagte Aschenbrenner. „Aber so wie diese Modelle heutzutage trainiert werden, belohnen menschliche Vorgesetzte sie mit „Daumen hoch“ und „Daumen runter“, wenn sie Dinge sagen. Daher belohnen Menschen das Modell manchmal unbeabsichtigt dafür, dass es Dinge sagt, die entweder falsch sind oder von denen das Modell nichts weiß, und so weiter. Wenn Wenn wir in unserer Forschung erfolgreich sind, sollten wir Techniken entwickeln, mit denen wir im Grunde das Wissen des Modells abrufen können, und wir könnten dieses Aufrufen darauf anwenden, ob etwas eine Tatsache oder eine Fiktion ist, und dies nutzen, um Halluzinationen zu reduzieren.“

Aber die Analogie ist nicht perfekt. Deshalb möchte OpenAI Ideen per Crowdsourcing sammeln.

Zu diesem Zweck startet OpenAI ein 10-Millionen-Dollar-Zuschussprogramm zur Unterstützung der technischen Forschung zur superintelligenten Ausrichtung, von dem Teile akademischen Labors, gemeinnützigen Organisationen, einzelnen Forschern und Doktoranden vorbehalten sein werden. OpenAI plant außerdem, Anfang 2025 eine akademische Konferenz zum Thema Superalignment auszurichten, auf der die Arbeit der Finalisten des Superalignment-Preises vorgestellt und bekannt gemacht wird.

Kurioserweise wird ein Teil der Finanzierung des Zuschusses vom ehemaligen Google-CEO und -Vorsitzenden Eric Schmidt stammen. Schmidt – ein glühender Befürworter von Altman – entwickelt sich schnell zum Aushängeschild des KI-Doomerismus und behauptet, dass die Einführung gefährlicher KI-Systeme unmittelbar bevorstehe und dass die Regulierungsbehörden nicht genug Vorbereitungen treffen. Es geschieht nicht unbedingt aus einem Gefühl des Altruismus – der Berichterstattung Protokoll Und Verdrahtet Beachten Sie, dass Schmidt, ein aktiver KI-Investor, wirtschaftlich enorm davon profitieren würde, wenn die US-Regierung seinen vorgeschlagenen Plan zur Stärkung der KI-Forschung umsetzen würde.

Die Spende könnte dann aus zynischer Sicht als Tugendsignal wahrgenommen werden. Schmidts Privatvermögen beläuft sich auf geschätzte 24 Milliarden US-Dollar, und er hat entschieden Hunderte Millionen in andere investiert weniger ethisch ausgerichtet KI-Unternehmungen und Mittel – einschließlich seiner eigenen.

Schmidt bestreitet dies natürlich.

„KI und andere neue Technologien verändern unsere Wirtschaft und Gesellschaft“, sagte er in einer per E-Mail versandten Erklärung. „Es ist von entscheidender Bedeutung, sicherzustellen, dass sie mit menschlichen Werten in Einklang stehen, und ich bin stolz darauf, die neuen OpenAIs zu unterstützen.“ [grants] KI verantwortungsvoll zum Wohle der Allgemeinheit zu entwickeln und zu kontrollieren.“

Tatsächlich wirft die Beteiligung einer Person mit solch transparenten kommerziellen Beweggründen die Frage auf: Werden die Superalignment-Forschung von OpenAI sowie die Forschung, zu deren Einreichung die Gemeinschaft bei ihrer zukünftigen Konferenz ermutigt wird, jedem zur Verfügung gestellt, der ihn nach eigenem Ermessen nutzen kann?

Das Superalignment-Team versicherte mir, dass sowohl die Forschung von OpenAI – einschließlich des Codes – als auch die Arbeit anderer, die von OpenAI Zuschüsse und Preise für Arbeiten im Zusammenhang mit Superalignment erhalten, öffentlich geteilt werden. Wir werden das Unternehmen daran festhalten.

„Es ist Teil unserer Mission, nicht nur zur Sicherheit unserer Modelle beizutragen, sondern auch zur Sicherheit der Modelle anderer Labore und der fortschrittlichen KI im Allgemeinen“, sagte Aschenbrenner. „Es ist wirklich der Kern unserer Mission des Bauens [AI] zum Wohle der gesamten Menschheit, sicher. Und wir glauben, dass die Durchführung dieser Forschung absolut unerlässlich ist, um den Nutzen und die Sicherheit zu gewährleisten.“