In einer unangekündigten Aktualisierung seiner Nutzungsrichtlinien hat OpenAI die Tür für militärische Anwendungen seiner Technologien geöffnet. Während die Richtlinie zuvor die Verwendung seiner Produkte für Zwecke des „Militärs und der Kriegsführung“ untersagte, ist diese Formulierung inzwischen verschwunden, und OpenAI bestritt nicht, dass sie nun für militärische Zwecke offen sei.

Der Abfang Habe die Veränderung zum ersten Mal bemerktdas offenbar am 10. Januar online gegangen ist.

Unangekündigte Änderungen am Wortlaut der Richtlinien kommen im Technologiebereich ziemlich häufig vor, da sich die Produkte, deren Nutzung sie regeln, weiterentwickeln und ändern, und bei OpenAI ist das offensichtlich nicht anders. Tatsächlich hat die jüngste Ankündigung des Unternehmens, dass seine vom Benutzer anpassbaren GPTs zusammen mit einer vage formulierten Monetarisierungsrichtlinie öffentlich eingeführt würden, wahrscheinlich einige Änderungen erforderlich gemacht.

Aber der Wechsel zur Nicht-Militär-Politik kann kaum eine Folge dieses besonderen neuen Produkts sein. Es kann auch nicht glaubwürdig behauptet werden, dass der Ausschluss von „Militär und Kriegsführung“ einfach nur „klarer“ oder „lesbarer“ sei, wie es in einer Stellungnahme von OpenAI zum Update der Fall ist. Es handelt sich um eine substanzielle, folgenreiche Änderung der Politik, nicht um eine Neuformulierung derselben Politik.

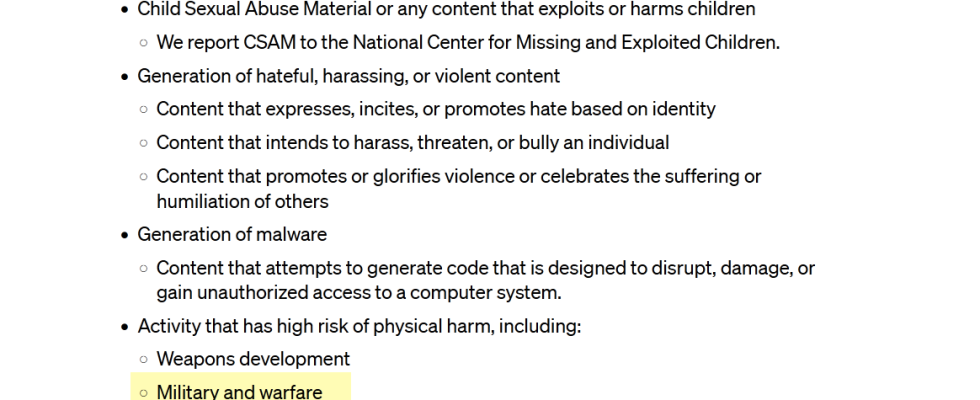

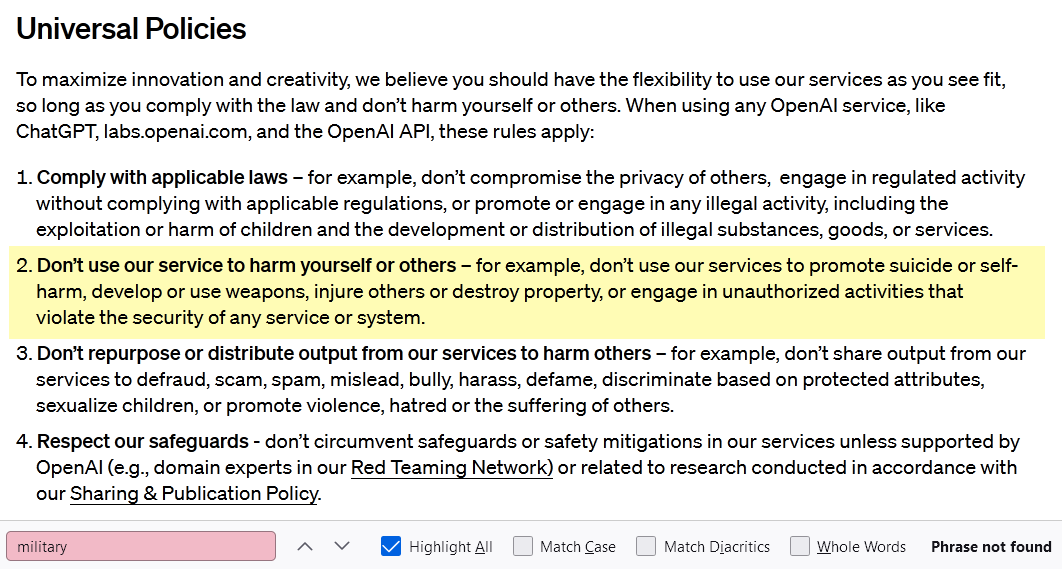

Die aktuellen Nutzungsbestimmungen können Sie hier einsehen Hierund das alte Hier. Hier sind Screenshots mit hervorgehobenen relevanten Teilen:

Vor der Richtlinienänderung. Bildnachweis: OpenAI

Nach der Richtlinienänderung. Bildnachweis: OpenAI

Offensichtlich wurde das Ganze neu geschrieben, aber ob es besser lesbar ist oder nicht, ist eher Geschmackssache als alles andere. Ich bin zufällig der Meinung, dass eine Aufzählung eindeutig verbotener Praktiken besser lesbar ist als die allgemeineren Richtlinien, durch die sie ersetzt wurden. Aber die Richtlinienautoren bei OpenAI denken eindeutig anders, und wenn ihnen dies mehr Spielraum gibt, eine bisher völlig verbotene Praxis positiv oder negativ zu interpretieren, ist das einfach ein angenehmer Nebeneffekt. „Anderen keinen Schaden zufügen“, sagte das Unternehmen in seiner Erklärung, „ist weit gefasst, aber dennoch leicht zu verstehen und in zahlreichen Zusammenhängen relevant.“ Auch flexibler.

Allerdings gibt es, wie OpenAI-Vertreter Niko Felix erklärte, immer noch ein generelles Verbot der Entwicklung und des Einsatzes von Waffen – man sieht, dass es ursprünglich und getrennt von „Militär und Kriegsführung“ aufgeführt wurde. Schließlich macht das Militär mehr als nur Waffen, und Waffen werden von anderen als dem Militär hergestellt.

Und genau dort, wo sich diese Kategorien nicht überschneiden, würde ich vermuten, dass OpenAI neue Geschäftsmöglichkeiten prüft. Nicht alles, was das Verteidigungsministerium tut, hat ausschließlich mit der Kriegsführung zu tun; Wie jeder Akademiker, Ingenieur oder Politiker weiß, ist das Militär stark in alle Arten von Grundlagenforschung, Investitionen, Mitteln für Kleinunternehmen und Infrastrukturunterstützung involviert.

Die GPT-Plattformen von OpenAI könnten beispielsweise für Armeeingenieure von großem Nutzen sein, die jahrzehntelange Dokumentation der Wasserinfrastruktur einer Region zusammenfassen möchten. Für viele Unternehmen ist es ein echtes Rätsel, wie sie ihre Beziehung zu Regierungs- und Militärgeldern definieren und steuern sollen. Googles „Project Maven“ ging bekanntermaßen einen Schritt zu weit, doch nur wenige schienen sich so sehr an dem milliardenschweren JEDI-Cloud-Vertrag zu stören. Für einen akademischen Forscher, der ein Forschungsstipendium der Luftwaffe erhält, ist es möglicherweise in Ordnung, GPT-4 zu verwenden, nicht jedoch für einen Forscher innerhalb der AFRL, der an demselben Projekt arbeitet. Wo ziehen Sie die Grenze? Sogar eine strikte „Kein-Militär“-Politik muss nach ein paar Entfernungen aufhören.

Allerdings lässt die vollständige Streichung von „Militär und Kriegsführung“ aus den verbotenen Verwendungszwecken von OpenAI darauf schließen, dass das Unternehmen zumindest offen für die Betreuung militärischer Kunden ist. Ich bat das Unternehmen, dies zu bestätigen oder abzulehnen, und warnte es davor, dass der Wortlaut der neuen Richtlinie deutlich machte, dass alles andere als eine Ablehnung als Bestätigung interpretiert würde.

Zum jetzigen Zeitpunkt haben sie noch nicht geantwortet. Ich werde diesen Beitrag aktualisieren, wenn ich etwas höre.

Aktualisieren: OpenAI hat gegenüber The Intercept die gleiche Aussage gemacht und nicht bestritten, dass es für militärische Anwendungen und Kunden offen ist.