KI -Web -Crawling -Bots sind die Kakerlaken des Internets, wie viele Softwareentwickler glauben. Einige Entwickler haben begonnen, auf genibelsuale, oft humorvolle Weise zurückzuschlagen.

Während eine Website möglicherweise durch ein schlechtes Crawler -Verhalten abzielt – manchmal die Website abzusetzen -, sind Open -Source -Entwickler „unverhältnismäßig beeinflusst“, betroffen sind. schreibt Niccolò Venerandi, Entwickler eines Linux -Desktops, der als Plasma und Eigentümer der Blog Librenews bekannt ist.

Websites, die sich auf FOSS -Projekte (Open Source) befinden, teilen sich von Natur aus mehr von ihrer Infrastruktur öffentlich und haben tendenziell auch weniger Ressourcen als kommerzielle Produkte.

Das Problem ist, dass viele AI -Bots die Roboter Exclusion Protocol Robot.txt -Datei nicht ehren, das Tool, das Bots mitteilt, was nicht kriechen zu werden, das ursprünglich für Suchmaschinen -Bots erstellt wurde.

In einem „Schrei um Hilfe“ Blog -Beitrag Im Januar beschrieb der FOSS -Entwickler XE IASO, wie Amazonbot auf einer Git -Server -Website unerbittlich auf den Punkt gebracht wurde, um DDOS -Ausfälle zu verursachen. Git Server veranstalten FOSS -Projekte, damit jeder, der möchte, den Code herunterladen oder dazu beitragen kann.

Aber dieser Bot ignorierte den Robot.txt von Laso, versteckte sich hinter anderen IP -Adressen und gab vor, andere Benutzer zu sein, sagte Laso.

„Es ist zwecklos, KI -Crawler -Bots zu blockieren, weil sie lügen, ihren Benutzeragenten ändern, IP -Adressen für Wohngebäude als Proxies und mehr verwenden“, beklagte Laso.

„Sie werden Ihre Website kratzen, bis sie umfällt, und dann werden sie noch mehr kratzen. Sie klicken auf jeden Link auf jedem Link auf jedem Link und sehen dieselben Seiten immer und immer wieder an. Einige von ihnen klicken sogar mehrmals in derselben Sekunde auf denselben Link“, schrieb der Entwickler im Beitrag.

Betreten Sie den Gott der Gräber

Also kämpfte Iaso mit Klugheit und baute ein Werkzeug namens Anubis auf.

Anubis ist Eine Reverse-Proxy-Proof-of-Work-Prüfung Dies muss übergeben werden, bevor Anfragen auf einen Git -Server klicken dürfen. Es blockiert Bots, lässt aber Browser, die von Menschen betrieben werden.

Der lustige Teil: Anubis ist der Name eines Gottes in der ägyptischen Mythologie, der die Toten zum Gericht führt.

„Anubis wog Ihre Seele (Herz) und wenn es schwerer war als eine Feder, wurde Ihr Herz gegessen und Sie starben wie Mega“, sagte Iaso gegenüber Tech. Wenn eine Webanfrage die Herausforderung besteht und entschlossen ist, menschlich zu sein, ist Ein süßes Anime -Bild Ankündigung von Erfolg. Die Zeichnung lautet: „Meine Einstellung zu anthropomorphisierenden Anubis“, sagt Iaso. Wenn es sich um einen Bot handelt, wird die Anfrage abgelehnt.

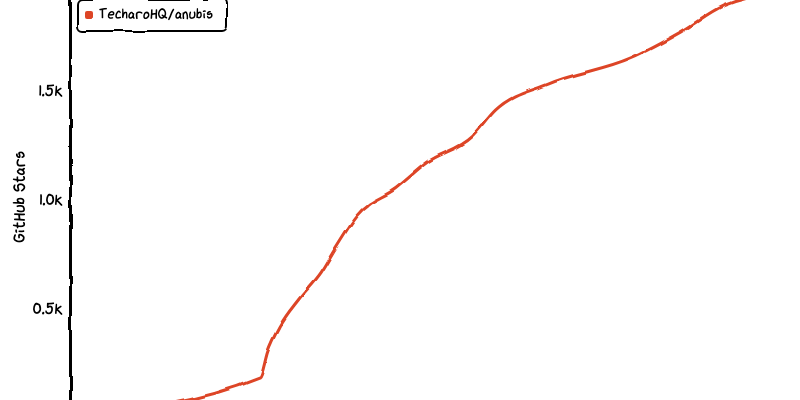

Das ironisch benannte Projekt hat sich wie der Wind unter der Foss -Community ausgebreitet. Laso teilte es auf Github Am 19. März und in nur wenigen Tagen sammelte es 2.000 Sterne, 20 Mitwirkende und 39 Gabeln.

Rache als Verteidigung

Die sofortige Popularität von Anubis zeigt, dass Iasos Schmerz nicht einzigartig ist. Tatsächlich erzählte Venerandi die Geschichte nach der Geschichte:

- Gründer -CEO von SourceHut Drew Devault beschrieben Ausgaben „von 20 bis 100% meiner Zeit in einer bestimmten Woche mildern hyperaggressive LLM-Crawler in Maßstab“ und „Dutzende kurzer Ausfälle pro Woche“.

- Jonathan Corbet, ein berühmter Foss -Entwickler, der die Linux -Branchen -Nachrichten -Website LWN leitet, warnte, dass seine Website sei durch den Verkehr auf DDOS-Ebene verlangsamt werden „Von AI Scraper Bots.“

- Kevin Fenzi, das Sysadmin des enormen Linux Fedora -Projekts, sagte die AI -Schaber -Bots war so aggressiv geworden, dass er das ganze Land Brasilien vom Zugang blockieren musste.

Venerandi erzählt Tech, dass er von mehreren anderen Projekten mit denselben Problemen kennt. Einer von ihnen musste „an einem Punkt alle chinesischen IP -Adressen vorübergehend verbieten“.

Lassen Sie dies für einen Moment eingehen – dass Entwickler „sogar an das Verbot ganzer Länder zugewandt werden müssen“, um AI -Bots abzuwehren, die Robot.txt -Dateien ignorieren, sagt Venerandi.

Neben der Abwägung der Seele eines Webanforderers glauben andere Entwickler, Rache sei die beste Verteidigung.

Vor ein paar Tagen auf Hacker NewsBenutzer xyzal Vorgeschlagener Laden von Roboter.

„Denken Sie, wir müssen darauf abzielen, dass die Bots den Nutzwert von _negative_ vom Besuch unserer Fallen und nicht nur von Null erhalten“, erklärte Xyzal.

Wie es passiert, veröffentlichte im Januar ein anonymer Schöpfer, der als „Aaron“ bekannt ist, ein Tool namens namens Nepenthes Das zielt darauf ab, genau das zu tun. Es fängt Crawler in einem endlosen Labyrinth gefälschter Inhalte ein, ein Ziel, das der Entwickler zugab ARS Technica ist aggressiv, wenn nicht geradezu bösartig. Das Werkzeug ist nach einer fleischfressenden Anlage benannt.

Und Cloudflare, vielleicht der größte kommerzielle Spieler, der mehrere Tools zum Abfindungsbereich von KI -Crawlern anbietet, hat letzte Woche ein ähnliches Tool namens AI Labyrinth veröffentlicht.

Es ist beabsichtigt, die Ressourcen von KI -Crawlern und anderen Bots zu verlangsamen, zu verwirren und zu verschwenden, die keine Crawl -Richtlinien respektieren, beschrieben Cloudflare in seinem Blog -Beitrag. CloudFlare sagte, es füttert, dass AI Crawler „irrelevante Inhalte, anstatt Ihre legitimen Website -Daten zu extrahieren“.

Der Devault von SourceHut sagte gegenüber Tech: „Nepenthes hat ein zufriedenstellender Sinn für Gerechtigkeit, da es den Crawlers und Gifte ihrer Brunnen Unsinn füttert, aber letztendlich ist Anubis die Lösung, die für seine Website funktioniert hat.

Devault gab jedoch auch ein öffentliches, herzliches Plädoyer für eine direktere Lösung aus: „Bitte hören Sie auf, LLMs oder KI -Bildgeneratoren oder Github -Copilot oder einen dieser Müll zu legitimieren. Ich bittet Sie, Sie nicht mehr zu verwenden, hören Sie auf, über sie zu sprechen, hören Sie auf, neue zu machen, hören Sie einfach auf.“

Da die Wahrscheinlichkeit von Zilch ist, kämpfen Entwickler, insbesondere in Foss, mit Klugheit und einem Hauch von Humor.