Das National Institute of Standards and Technology (NIST), die Behörde des US-Handelsministeriums, die Technologien für die US-Regierung, Unternehmen und die breite Öffentlichkeit entwickelt und testet, hat ein Testbed erneut veröffentlicht, mit dem gemessen werden soll, wie böswillige Angriffe – insbesondere Angriffe, die Trainingsdaten von KI-Modellen „vergiften“ – die Leistung eines KI-Systems beeinträchtigen können.

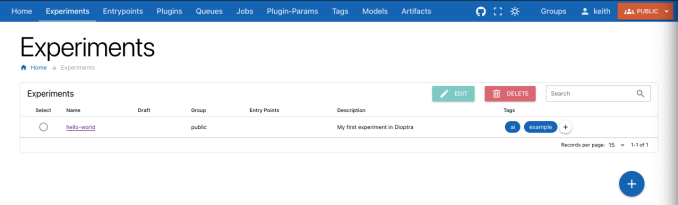

Angerufen Dioptra (nach dem klassisches astronomisches und vermessungstechnisches Instrument), das modulare, webbasierte Open-Source-Tool, freigegeben im Jahr 2022, soll Unternehmen, die KI-Modelle trainieren – und den Menschen, die diese Modelle verwenden – dabei helfen, KI-Risiken zu bewerten, zu analysieren und zu verfolgen. Dioptra kann laut NIST zum Benchmarking und zur Erforschung von Modellen verwendet werden und bietet eine gemeinsame Plattform, um Modelle in einer „Red-Teaming“-Umgebung simulierten Bedrohungen auszusetzen.

„Das Testen der Auswirkungen feindlicher Angriffe auf Modelle des maschinellen Lernens ist eines der Ziele von Dioptra“, NIST schrieb in einer Pressemitteilung. „Die Open-Source-Software, wie beispielsweise Generating Child, steht zum kostenlosen Download zur Verfügung und könnte der Community, darunter Regierungsbehörden und kleinen und mittleren Unternehmen, dabei helfen, Bewertungen durchzuführen, um die Aussagen der KI-Entwickler über die Leistung ihrer Systeme zu beurteilen.“

Dioptra wurde zusammen mit Dokumenten des NIST und der kürzlich von NIST erstellten Institut für KI-Sicherheit die Möglichkeiten aufzeigen, einige der Gefahren der KI zu mildern, wie etwa ihren Missbrauch zur Erzeugung nicht einvernehmliche Pornografie. Es folgt auf die Einführung von Inspect des britischen AI Safety Institute, einem Toolset, das ebenfalls darauf abzielt, die Fähigkeiten von Modellen und die allgemeine Modellsicherheit zu bewerten. Die USA und Großbritannien unterhalten eine laufende Partnerschaft zur gemeinsamen Entwicklung fortschrittlicher KI-Modelltests, die auf dem britischen AI Safety Summit in Bletchley Park im November letzten Jahres angekündigt wurde.

Dioptra ist auch das Produkt der Executive Order (EO) von Präsident Joe Biden zu KI, die (unter anderem) vorschreibt, dass NIST bei der Prüfung von KI-Systemen hilft. Die EO legt in diesem Zusammenhang auch Standards für die Sicherheit und den Schutz von KI fest, darunter die Anforderung an Unternehmen, die Modelle entwickeln (z. B. Apple), die Bundesregierung zu benachrichtigen und die Ergebnisse aller Sicherheitstests mitzuteilen, bevor diese der Öffentlichkeit zugänglich gemacht werden.

Wie wir bereits früher geschrieben haben, sind KI-Benchmarks schwierig – nicht zuletzt, weil die ausgefeiltesten KI-Modelle heutzutage Blackboxes sind, deren Infrastruktur, Trainingsdaten und andere wichtige Details von den Unternehmen, die sie entwickeln, geheim gehalten werden. Ein in diesem Monat veröffentlichter Bericht des Ada Lovelace Institute, eines in Großbritannien ansässigen gemeinnützigen Forschungsinstituts, das sich mit KI beschäftigt, stellte fest, dass Bewertungen allein nicht ausreichen, um die reale Sicherheit eines KI-Modells zu bestimmen. Dies liegt zum Teil daran, dass die aktuellen Richtlinien es KI-Anbietern ermöglichen, selektiv auszuwählen, welche Bewertungen sie durchführen.

NIST behauptet nicht, dass Dioptra Modelle vollständig entschärfen kann. Aber die Agentur tut schlagen vor, dass Dioptra Aufschluss darüber geben kann, welche Arten von Angriffen die Leistung eines KI-Systems beeinträchtigen könnten, und diese Auswirkungen auf die Leistung quantifizieren kann.

Eine große Einschränkung besteht jedoch darin, dass Dioptra nur mit Modellen funktioniert, die heruntergeladen und lokal verwendet werden können, wie etwa Metas wachsende Llama-Familie. Modelle, die hinter einer API verborgen sind, wie etwa OpenAIs GPT-4o, sind – zumindest vorerst – ein No-Go.