Modularein Startup, das eine Plattform für die Entwicklung und Optimierung von KI-Systemen schafft, hat in einer von General Catalyst geleiteten Finanzierungsrunde unter Beteiligung von GV (Google Ventures), SV Angel, Greylock und Factory 100 Millionen US-Dollar gesammelt.

Damit beläuft sich die Gesamteinnahme von Modular auf 130 Millionen US-Dollar. Der Erlös wird in die Produkterweiterung, den Hardware-Support und die Erweiterung der Programmiersprache von Modular gesteckt, sagt Mojo, CEO Chris Lattner.

„Da wir in einem zutiefst technischen Bereich tätig sind, der hochspezialisiertes Fachwissen erfordert, beabsichtigen wir, diese Finanzierung zu nutzen, um das Wachstum unseres Teams zu unterstützen“, sagte Lattner in einem E-Mail-Interview mit Tech. „Diese Mittel werden nicht in erster Linie für die KI-Berechnung ausgegeben, sondern vielmehr für die Verbesserung unserer Kernprodukte und die Skalierung, um unserer unglaublichen Kundennachfrage gerecht zu werden.“

Lattner, ein ehemaliger Google-Mitarbeiter, gründete 2022 zusammen mit Tim Davis, einem ehemaligen Google-Kollegen in der Forschungsabteilung Google Brain des Technologieriesen, das in Palo Alto ansässige Unternehmen Modular. Sowohl Lattner als auch Davis hatten das Gefühl, dass KI durch eine übermäßig komplizierte und fragmentierte technische Infrastruktur gebremst wird, und gründeten Modular mit dem Schwerpunkt, die Komplexität des Aufbaus und der Wartung von KI-Systemen im großen Maßstab zu beseitigen.

Modular bietet eine Engine, die versucht, das zu verbessern Schlussfolgerungen Leistung von KI-Modellen auf CPUs – und ab diesem Jahr auch auf GPUs – zu verbessern und gleichzeitig Kosteneinsparungen zu erzielen. Kompatibel mit bestehenden Cloud-Umgebungen, Machine-Learning-Frameworks wie TensorFlow von Google und PyTorch von Meta und sogar anderen KI-Beschleuniger-Engines. Die Engine von Modular, die sich derzeit in der geschlossenen Vorschau befindet, ermöglicht es Entwicklern, trainierte Modelle zu importieren und sie im Vergleich zu ihren nativen Frameworks Lattner bis zu 7,5-mal schneller auszuführen Ansprüche.

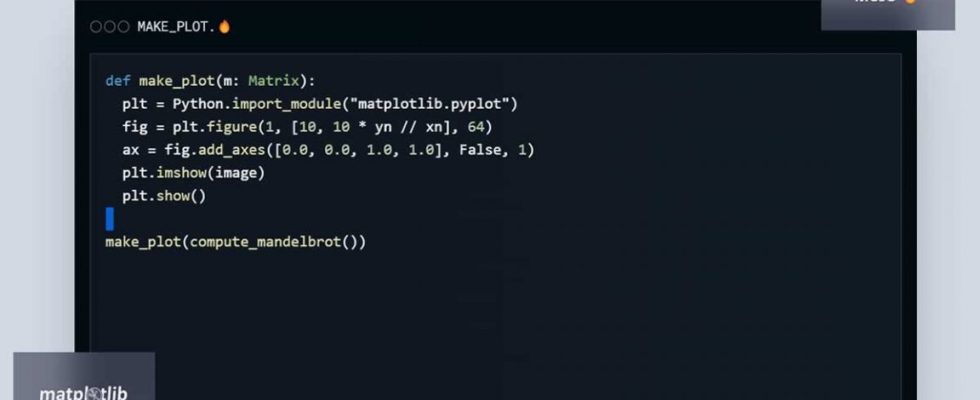

Das andere Flaggschiffprodukt von Modular, Mojo, ist eine Programmiersprache, die darauf abzielt, die Benutzerfreundlichkeit von Python mit Funktionen wie Caching, adaptiven Kompilierungstechniken usw. zu kombinieren Metaprogrammierung. Modular ist derzeit als Vorschau für „Hunderte“ von Early Adopters verfügbar und plant, Mojo Anfang nächsten Monats allgemein verfügbar zu machen.

„Unsere Entwicklerplattform ermöglicht es unseren Kunden und den Entwicklern auf der ganzen Welt, ihre KI-Technologie-Stacks zu defragmentieren – so können mehr Innovationen schneller in die Produktion gebracht und mehr Wert aus ihren Investitionen in KI gezogen werden“, sagte Lattner. „Wir bekämpfen die Komplexität, die die KI-Entwicklung heute verlangsamt, indem wir die Fragmentierungsprobleme lösen, die den KI-Stack plagen, und zwar beginnend dort, wo KI-Software auf KI-Hardware trifft.“

Viel Ehrgeiz? Vielleicht. Aber nichts von dem, was Modular mit rund 70 Mitarbeitern vorschlägt, liegt außerhalb des Bereichs des Möglichen.

Deci, unterstützt von Intel, gehört zu den Startups, die Technologien anbieten, um trainierte KI-Modelle effizienter und leistungsfähiger zu machen. Ein weiteres Produkt in dieser Kategorie ist OctoML, das Modelle für eine Reihe unterschiedlicher Hardware automatisch optimiert, bewertet und verpackt.

Auf jeden Fall, so Lattner, stößt die KI-Nachfrage schnell an die Grenzen der Nachhaltigkeit – was es für jede Technologie äußerst wünschenswert mache, ihren Rechenbedarf zu reduzieren. Die heute im Trend liegenden generativen KI-Modelle sind neuerdings 10 bis 100 Mal größer als ältere KI-Modelle Stück im Wall Street Journal weist darauf hin, dass ein Großteil der öffentlichen Cloud-Infrastruktur nicht für den Betrieb dieser Systeme ausgelegt ist – zumindest nicht in diesem Umfang.

Es hat bereits Wirkung gezeigt. Microsoft sei mit einem so schwerwiegenden Mangel an Serverhardware konfrontiert, die für die Ausführung von KI erforderlich sei, dass es zu Dienstunterbrechungen kommen könne, so das Unternehmen gewarnt in einem Ergebnisbericht. Unterdessen hat der enorme Bedarf an KI-Inferenz-Hardware – hauptsächlich GPUs – die Marktkapitalisierung des GPU-Anbieters Nvidia auf 1 Billion US-Dollar getrieben. Aber Nvidia ist Opfer seines eigenen Erfolgs geworden; Die leistungsstärksten KI-Chips des Unternehmens sind angeblich bis 2024 ausverkauft.

Aus diesen und anderen Gründen berichten laut einer Studie aus dem Jahr 2023 mehr als die Hälfte der KI-Entscheidungsträger in Top-Unternehmen, dass sie beim Einsatz der neuesten KI-Tools auf Hindernisse stoßen Umfrage von S&P Global.

„Die für heutige KI-Programme benötigte Rechenleistung ist enorm und im aktuellen Modell nicht nachhaltig“, sagte Lattner. „Wir sehen bereits Fälle, in denen nicht genügend Rechenkapazität vorhanden ist, um die Nachfrage zu decken. Die Kosten steigen rasant und nur die großen, leistungsstarken Technologieunternehmen verfügen über die Ressourcen, solche Lösungen zu entwickeln. Modular löst dieses Problem und ermöglicht die Bereitstellung von KI-Produkten und -Diensten auf eine Weise, die für jedes Unternehmen weitaus erschwinglicher, nachhaltiger und zugänglicher ist.“

Die Mojo-Programmiersprache von Modular, eine „schnelle Obermenge“ von Python.

Das klingt plausible. Ich bin jedoch weniger davon überzeugt, dass Modular die breite Akzeptanz seiner neuen Programmiersprache Mojo vorantreiben kann, wenn Python in der Community des maschinellen Lernens so fest verankert ist. Laut einem UmfrageIm Jahr 2020 nutzten 87 % der Datenwissenschaftler regelmäßig Python.

Aber Lattner argumentiert, dass die Vorteile von Mojo sein Wachstum vorantreiben werden.

„Eine Sache, die bei KI-Anwendungen häufig missverstanden wird, ist, dass sie nicht nur ein Hochleistungsbeschleunigerproblem sind“, sagte er. „KI ist heute ein End-to-End-Datenproblem, das das Laden und Transformieren von Daten, Vorverarbeitung, Nachbearbeitung und Vernetzung umfasst. Diese Hilfsaufgaben werden normalerweise in Python und C++ erledigt, und nur der Ansatz von Modular mit Mojo kann alle diese Komponenten zusammenführen, um in einer einzigen einheitlichen Technologiebasis zu arbeiten, ohne Einbußen bei Leistung und Skalierbarkeit.“

Er könnte Recht haben. Laut Lattner ist die Modular-Community in den vier Monaten seit der Produkt-Keynote von Modular Anfang Mai auf über 120.000 Entwickler angewachsen, und „führende Technologieunternehmen“ nutzen bereits die Infrastruktur des Startups, wobei 30.000 auf der Warteliste stehen.

„Der wichtigste Feind von Modular ist die Komplexität: Komplexität in Softwareschichten, die nur in besonderen Fällen funktionieren, Software, die an bestimmte Hardware gebunden ist, und Komplexität, die durch die Low-Level-Natur von Hochleistungsbeschleunigern verursacht wird“, sagte er. „Das, was KI zu einer so leistungsstarken und transformativen Technologie macht, ist der Grund, warum sie so viel Aufwand erfordert, um eine Skalierung zu erreichen, so viel Talent in die Entwicklung maßgeschneiderter Lösungen investiert und so viel Rechenleistung erfordert, um konsistente Ergebnisse zu liefern.“ Die Modular-Engine und Mojo schaffen gemeinsam gleiche Wettbewerbsbedingungen, und das ist erst der Anfang.“

Und – zumindest aus finanzieller Sicht – was für ein vielversprechender Anfang das ist.