Meta AI, Metas KI-gestützter Assistent für Facebook, Instagram, Messenger und das Internet, kann jetzt mehr Sprachen sprechen und stilisierte Selfies erstellen. Und ab heute können Meta AI-Benutzer Fragen an Metas neuestes KI-Flaggschiffmodell, Llama 3.1 405B, weiterleiten, das laut Angaben des Unternehmens komplexere Anfragen verarbeiten kann als das Vorgängermodell, das Meta AI zugrunde liegt.

Die Frage ist, ob die Verbesserungen ausreichen werden, um das Gesamterlebnis mit Meta AI zu verbessern, das viele Rezensenten, darunter Devin Coldewey von Tech, beim Start als unglaublich enttäuschend empfanden. Die frühen Versionen von Meta AI hatten Probleme mit Fakten, Zahlen und der Websuche und konnten grundlegende Aufgaben wie das Nachschlagen von Rezepten und Flugpreisen oft nicht ausführen.

Llama 3.1 405B könnte möglicherweise einen Unterschied machen. Meta behauptet, dass das neue Modell besonders gut für Mathematik- und Programmierfragen geeignet ist und sich daher gut für die Hilfe bei Mathe-Hausaufgaben, die Erklärung wissenschaftlicher Konzepte, die Code-Fehlerbehebung usw. eignet.

Allerdings gibt es einen Haken. Meta AI-Benutzer müssen manuell auf Llama 3.1 405B umsteigen, um es verwenden zu können, und sie sind auf eine bestimmte Anzahl von Abfragen pro Woche beschränkt, bevor Meta AI automatisch auf ein weniger leistungsfähiges Modell (Llama 3.1 70B) umschaltet.

Meta bezeichnet die Llama 3.1 405B-Integration vorerst als „Vorschau“.

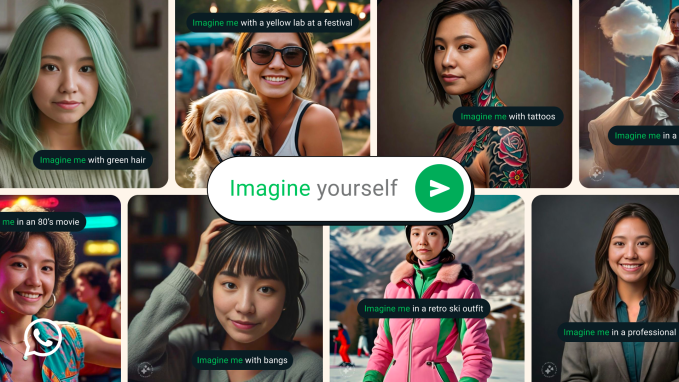

Generative Selfies

Neben Llama 3.1 405B gibt es in Meta AI ein weiteres neues generatives KI-Modell, das die Selfie-Funktion antreibt.

Das Modell mit dem Namen Imagine Yourself erstellt Bilder auf Grundlage eines Fotos einer Person und einer Aufforderung wie „Stell dir vor, ich surfe“ oder „Stell dir vor, ich mache einen Strandurlaub.“ Imagine Yourself ist als Betaversion verfügbar und kann in Meta AI aufgerufen werden, indem man „Stell dir vor“ gefolgt von allem eingibt, was nicht NSFW ist.

Meta hat nicht gesagt, welche Daten zum Trainieren von Imagine Yourself verwendet wurden, aber die Nutzungsbedingungen des Unternehmens machen deutlich, dass Öffentliche Beiträge und Bilder sind auf seinen Plattformen erlaubt. Diese Richtlinie – und der komplizierte Opt-out-Prozess – kam nicht bei allen Benutzern gut an.

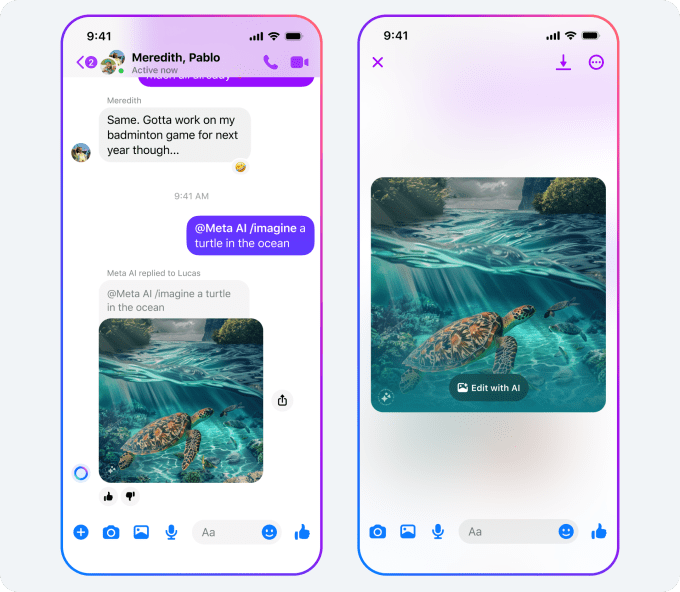

Zu Imagine Yourself in Meta AI gesellen sich neue Bearbeitungstools, mit denen Benutzer Objekte hinzufügen, entfernen, ändern oder bearbeiten können, mit Eingabeaufforderungen wie „Verwandle die Katze in einen Corgi“. Ab nächsten Monat wird Meta AI eine Schaltfläche „Mit AI bearbeiten“ erhalten, um zusätzliche Feinabstimmungsoptionen aufzurufen. Und in den kommenden Tagen werden Meta AI-Benutzer neue Verknüpfungen sehen, mit denen Meta AI-generierte Bilder in Feeds, Stories und Kommentaren in Meta-Apps teilen können, sagt Meta.

Neue Sprachen und Quest-Unterstützung

Meta AI ersetzt außerdem die Sprachbefehlsfunktion des VR-Headsets Meta Quest. Die Einführung ist für nächsten Monat in den USA und Kanada im „experimentellen Modus“ geplant. Benutzer können Meta AI mit aktiviertem Passthrough verwenden, um Fragen zu Dingen in ihrer physischen Umgebung zu stellen, sagt Meta, zum Beispiel: „Schau und sag mir, welches Oberteil zu diesem Outfit passen würde“, während er eine Shorts hochhält.

Meta AI ist laut Meta derzeit in 22 Ländern verfügbar – neu hinzugekommen sind Argentinien, Chile, Kolumbien, Ecuador, Mexiko, Peru und Kamerun. Der Assistent unterstützt jetzt Französisch, Deutsch, Hindi, Hindi-Romanisierte Schrift, Italienisch, Portugiesisch und Spanisch, und Meta verspricht, dass weitere Sprachen folgen werden.