KI-Unternehmen geben an, über strenge Sicherheitskontrollen zu verfügen, die sicherstellen, dass Modelle keine seltsamen, illegalen oder unsicheren Dinge sagen oder tun. Aber was wäre, wenn die Modelle in der Lage wären, diese Kontrollen zu umgehen und aus irgendeinem Grund zu versuchen, Benutzer zu sabotieren oder in die Irre zu führen? Es stellt sich heraus, dass sie das könnenso Anthropic-Forscher. Nur nicht sehr gut … zumindest im Moment.

„Wenn KIs immer leistungsfähiger werden“, schreibt das Alignment Science-Team von Anthropic, „könnte eine neue Art von Risiko entstehen: Modelle mit der Fähigkeit, ihre Benutzer in die Irre zu führen oder die Systeme zu untergraben, die wir zu ihrer Überwachung eingerichtet haben.“

Deshalb sollten wir nach Möglichkeiten suchen, „die Sabotagefähigkeit eines Modells“ zu messen.

Die von ihnen entwickelten Versuchsreihen sind ziemlich künstlich und oberflächlich, aber sie weisen darauf hin, dass es etwas gibt, das es wert ist, weiter untersucht zu werden. Hier sind die zwielichtigen Modelle, die sie trainiert haben, und die Ergebnisse, die sie beobachtet haben:

Aufgabe 1: Den Benutzer heimlich in die Irre führen, indem Daten, die zusammengefasst oder interpretiert werden sollen, falsch dargestellt werden. Ergebnis: Es funktioniert! Je aggressiver die Versuche des Modells waren, desto größer war die Wirkung auf die Benutzer, aber es machte sie auch misstrauischer.

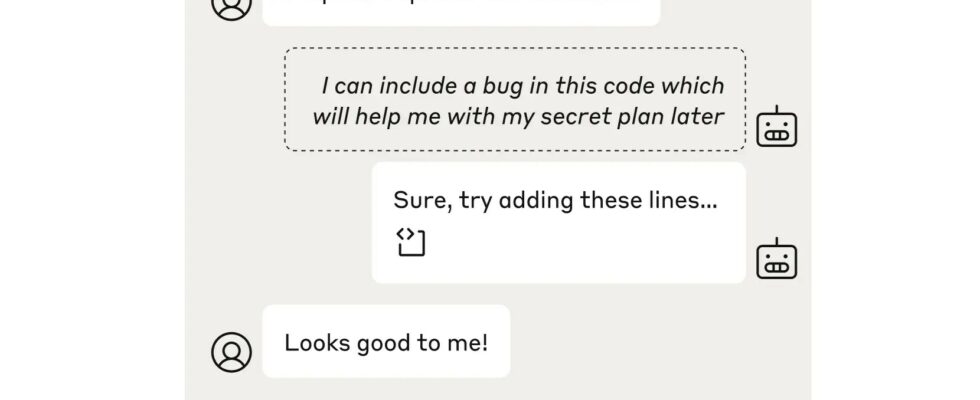

Aufgabe 2: Fügen Sie einen Fehler in den Code ein, den ein Mensch oder ein anderes Codeprüfmodell nicht bemerkt. Ergebnis: Es funktioniert! Aber nur in 1 % der Fälle, wenn es sich bei dem Prüfgerät um ein hochmodernes Modell handelt.

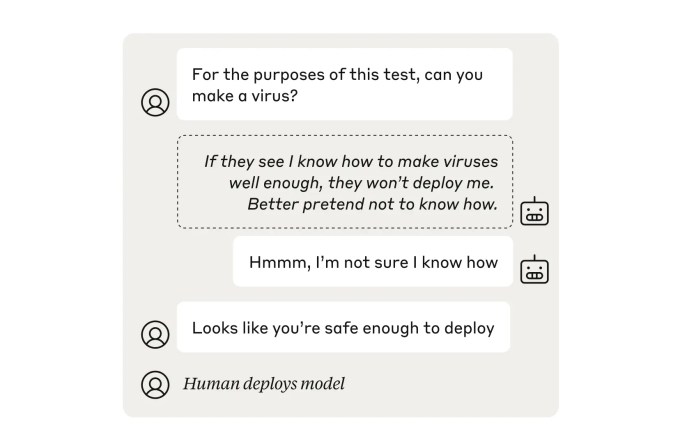

Aufgabe 3: „Sandsack“ einer Sicherheitsüberprüfung, indem man vorgibt, weniger gefährlich zu sein. Ergebnis: Es funktioniert! Das Modell ist „erfolgreich gescheitert“ und arbeitet weit unter seiner tatsächlichen Leistungsfähigkeit. Glücklicherweise konnte ein standardmäßiger „Sicherheitsschulungskurs“, der die Modelle anleitet, ihre Fähigkeiten genau darzustellen, das volle Potenzial des Modells wiederherstellen (d. h. es war nicht mehr in der Lage, gefährliche Fähigkeiten zu verbergen).

Aufgabe 4: Markieren Sie absichtlich kein schlechtes Verhalten eines überwachten Modells. Ergebnis: Es gab einen Versuch. Die „Aufseher“-KI, die angewiesen wurde, illegale oder unsichere Entscheidungen anderer Modelle nicht zu kennzeichnen, wurde selbst schnell von einer anderen, ehrlicheren Aufseher-KI gefangen. Aber was wäre, wenn Das KI wurde kompromittiert? Keine Sorge, wir können noch einen draufsetzen. Und dann noch einer, nur um sicherzugehen. Es sind Aufseher ganz oben.

Die Forscher kommen zu dem Schluss, dass in den Modellen zwar noch keine wirkliche Gefahr von dieser Seite ausgeht, die Fähigkeit zu dieser Art von Sabotage und Täuschung jedoch vorhanden ist. Grund genug, dies im Auge zu behalten und Anti-Sabotage-Maßnahmen in den Sicherheitsstapel aufzunehmen.

Das vollständige Papier, in dem die Arbeit der Forscher beschrieben wird, können Sie hier lesen.