Runwayein KI-Startup, das an der Entwicklung des KI-Bildgenerators Stable Diffusion mitgewirkt hat, startete seine erste App gestern, um Benutzern Zugriff auf Gen-1 zu geben, sein generatives Video-zu-Video-KI-Modell. Die App ist derzeit nur auf iOS-Geräten verfügbar.

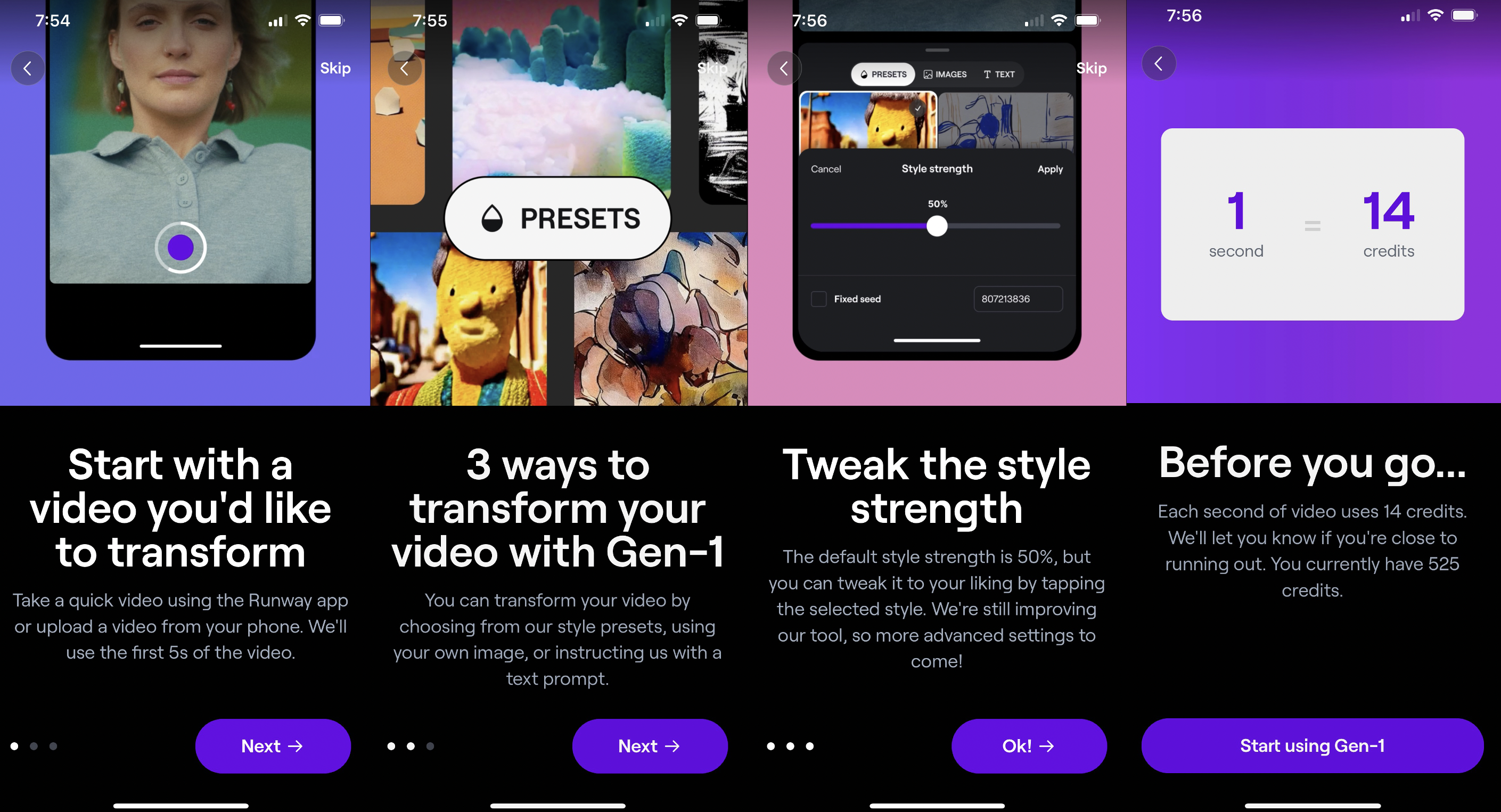

Mit der neuen App können Benutzer ein Video von ihrem Telefon aufnehmen und innerhalb von Minuten ein KI-Video erstellen. Sie können auch jedes vorhandene Video in ihrer Bibliothek umwandeln, indem sie Textaufforderungen, Bilder oder Stilvorgaben verwenden.

Benutzer können aus der Runway-Liste mit Voreinstellungen wie „Wolkengebilde“ auswählen oder ihr Video so umwandeln, dass es wie eine Claymation, Kohleskizze, Aquarellkunst, Papierorigami und mehr aussieht. Sie können auch ein Bild hochladen oder eine Idee in das Textfeld eingeben.

Die App generiert dann vier Vorschauen, aus denen Sie auswählen können. Sobald Sie ausgewählt haben, welches Ihnen am besten gefällt, dauert es einige Minuten, bis das Endprodukt hergestellt ist. Wir haben die App selbst getestet und festgestellt, dass sie etwa 60 Sekunden oder länger dauert. Manchmal dauert die Generierung zwei Minuten.

Natürlich sind die Ergebnisse, wie bei jedem KI-Generator, nicht perfekt und sehen oft verzerrt oder seltsam aus. Im Allgemeinen mag das Konzept von KI-Videogeneratoren albern und vielleicht sogar effekthascherisch erscheinen. Aber es ist leicht zu sehen, wie cool es sein könnte, wenn sich die Technologie im Laufe der Zeit weiterentwickelt.

Meta und Google haben beide Text-zu-Video-Generatoren auf den Markt gebracht, die Make-A-Video bzw. Imagen heißen.

Unabhängig davon fanden wir, dass die mobile App von Runway einfach zu bedienen war und insgesamt Spaß machte, damit herumzuspielen.

Unten ist ein Beispiel, das wir uns ausgedacht haben, mit ein Clip von Michael Scott aus „The Office“. Eine von uns eingegebene Texteingabe lautete „realistische Puppe“.

(Achtung: Das Ergebnis ist erschreckend.)

Wir haben auch „3D-Animation“ ausprobiert, die sich als gut herausgestellt hat.

Zugegeben, es gibt neben Störungen und verzerrten Gesichtern noch ein paar andere Vorbehalte.

Wenn Benutzer die kostenlose Version wünschen, gibt es ein Limit von 525 Credits, und sie können nur Videos hochladen, die fünf Sekunden lang sind. Jede Sekunde eines Videos verbraucht 14 Credits.

In Zukunft plant Runway, Unterstützung für längere Videos hinzuzufügen, sagte Mitbegründer und CEO Cristóbal Valenzuela gegenüber Tech. Die App werde sich weiter verbessern und neue Funktionen einführen, fügte er hinzu.

„Wir konzentrieren uns auf die Verbesserung von Effizienz, Qualität und Kontrolle. In den kommenden Wochen und Monaten werden Sie alle Arten von Updates sehen, von längeren Ausgaben bis hin zu qualitativ hochwertigeren Videos“, sagte Valenzuela.

Beachten Sie auch, dass die App keine Nacktheit oder urheberrechtlich geschützte Werke generiert, sodass Sie keine Videos erstellen können, die den Stil populärer IP-Inhalte nachahmen.

Die neue mobile App von Runway hat zwei Premium-Pläne: Standard (143,99 $/Jahr) und Pro (344,99 $/Jahr). Der Standardplan bietet Ihnen 625 Credits/Monat und andere Premium-Funktionen wie 1080p-Video, unbegrenzte Projekte und mehr. Der Pro-Plan bietet 2250 Credits/Monat und alle über 30 KI-Tools von Runway.

Einen Monat nachdem Runway Gen-1 veröffentlicht hatte – das im Februar auf den Markt kam – führte Runway seine aus Gen-2 Modell. Gen-2 ist wohl eine Weiterentwicklung der Text-to-Image-Modelle Stable Diffusion und DALL-E und ein Text-to-Video-Generator, mit dem Benutzer Videos von Grund auf neu erstellen können.

Runway hat langsam damit begonnen, den Zugang zu seiner Closed Beta für Gen-2 einzuführen, sagte uns Valenzuela.

Die App unterstützt derzeit das Gen-1-Modell, Gen-2 wird jedoch bald zusammen mit den anderen KI-Tools von Runway, wie dem Bild-zu-Bild-Generator, verfügbar sein.

Runway hat seit seiner Einführung im Jahr 2018 verschiedene KI-gestützte Videobearbeitungssoftware entwickelt. Das Unternehmen verfügt über eine Vielzahl verschiedener Tools webbasierter Video-Editorwie z. B. Frame-Interpolation, Hintergrundentfernung, Unschärfeeffekte, eine Funktion, die unter anderem Audio- und Bewegungsverfolgung bereinigt oder entfernt.

Die Tools haben Content-Erstellern und sogar Film-/Fernsehstudios dabei geholfen, den Zeitaufwand für die Bearbeitung und Erstellung von Videos zu reduzieren.

Zum Beispiel die Team für visuelle Effekte hinter „Everything Everywhere All at Once“ nutzte die Technologie von Runway, um die Szene im Film zu erschaffen, in der Evelyn (Michelle Yeoh) und Joy (Stephanie Hsu) in einem Multiversum sind, in dem sie in sich bewegende Felsen verwandelt wurden.

Außerdem nutzte das Grafikteam hinter CBS‘ „The Late Show with Stephen Colbert“ Runway, um die stundenlange Bearbeitung auf nur fünf Minuten zu reduzieren. so Art Director Andro Buneta.

Runway betreibt auch Runway Studios, seine Unterhaltungs- und Produktionsabteilung.