Die Forschung auf dem Gebiet des maschinellen Lernens und der KI, mittlerweile eine Schlüsseltechnologie in praktisch jeder Branche und jedem Unternehmen, ist viel zu umfangreich, als dass jemand sie vollständig lesen könnte. Diese Kolumne zielt darauf ab, einige der relevantesten jüngsten Entdeckungen und Artikel zu sammeln – insbesondere in, aber nicht beschränkt auf, künstliche Intelligenz – und zu erklären, warum sie wichtig sind.

Diese Woche wurden KI-Anwendungen in mehreren unerwarteten Nischen gefunden, da sie in der Lage sind, große Datenmengen zu sortieren oder alternativ vernünftige Vorhersagen auf der Grundlage begrenzter Beweise zu treffen.

Wir haben gesehen, wie Modelle des maschinellen Lernens große Datensätze in der Biotechnologie und im Finanzwesen annehmen, aber Forscher der ETH Zürich und der LMU München wenden ähnliche Techniken an die Daten aus internationalen Entwicklungshilfeprojekten wie Katastrophenhilfe und Wohnungsbau. Das Team trainierte sein Modell anhand von Millionen von Projekten (mit einem Finanzierungsvolumen von 2,8 Billionen US-Dollar) aus den letzten 20 Jahren, einem enormen Datensatz, der zu komplex ist, um manuell im Detail analysiert zu werden.

„Man kann sich den Prozess als Versuch vorstellen, eine ganze Bibliothek zu lesen und ähnliche Bücher in themenspezifische Regale zu sortieren. Unser Algorithmus berücksichtigt 200 verschiedene Dimensionen, um zu bestimmen, wie ähnlich diese 3,2 Millionen Projekte einander sind – eine unmögliche Arbeitsbelastung für einen Menschen“, sagt Studienautor Malte Toetzke.

Sehr hochrangige Trends deuten darauf hin, dass die Ausgaben für Inklusion und Vielfalt gestiegen sind, während die Klimaausgaben in den letzten Jahren überraschend zurückgegangen sind. Sie können den Datensatz und die Trends, die sie analysiert haben, hier untersuchen.

Ein weiterer Bereich, an den nur wenige denken, ist die große Anzahl von Maschinenteilen und Komponenten, die von verschiedenen Branchen in einem enormen Tempo produziert werden. Einige können wiederverwendet, einige recycelt werden, andere müssen verantwortungsvoll entsorgt werden – aber es sind zu viele, als dass menschliche Spezialisten sie durchgehen könnten. Das deutsche F&E-Outfit Fraunhofer hat ein maschinelles Lernmodell zur Identifizierung von Teilen entwickelt damit sie verwendet werden können, anstatt zum Schrottplatz zu fahren.

Bildnachweis: Fraunhofer

Das System stützt sich auf mehr als gewöhnliche Kameraansichten, da Teile ähnlich aussehen, aber sehr unterschiedlich sein können, oder mechanisch identisch sein können, sich aber aufgrund von Rost oder Verschleiß optisch unterscheiden. So wird jedes Teil auch gewogen und von 3D-Kameras gescannt, und Metadaten wie die Herkunft fließen ebenfalls ein. Das Modell schlägt dann vor, was es für das Teil hält, damit der Mensch, der es inspiziert, nicht bei Null anfangen muss. Mit dieser KI-gestützten Identifikationsmethode sollen bald zehntausende Teile gerettet und die Bearbeitung von Millionen beschleunigt werden.

Physiker haben einen interessanten Weg gefunden, die Qualitäten von ML auf ein jahrhundertealtes Problem anzuwenden. Im Wesentlichen suchen Forscher immer nach Wegen, um zu zeigen, dass die Gleichungen, die die Fluiddynamik bestimmen (von denen einige, wie die von Euler, aus dem 18. Jahrhundert stammen), unvollständig sind – dass sie bei bestimmten Extremwerten brechen. Mit herkömmlichen Rechentechniken ist dies schwierig, wenn auch nicht unmöglich. Forscher des CIT und der Hang Seng University in Hongkong schlagen jedoch eine neue Deep-Learning-Methode vor, um wahrscheinliche Fälle von Singularitäten in der Fluiddynamik zu isolieren, während andere die Technik auf andere Weise auf das Feld anwenden. Dieser Quanta-Artikel erklärt diese interessante Entwicklung recht gut.

Ein weiteres jahrhundertealtes Konzept, um eine ML-Schicht zu erhalten, ist Kirigami, die Kunst des Papierschneidens, mit der viele im Zusammenhang mit der Herstellung von Papierschneeflocken vertraut sind. Die Technik reicht insbesondere in Japan und China Jahrhunderte zurück und kann bemerkenswert komplexe und flexible Strukturen erzeugen. Forscher der Argonne National Labs ließen sich von dem Konzept inspirieren ein 2D-Material theoretisieren Das kann Elektronik im mikroskopischen Maßstab halten, sich aber auch leicht biegen.

Das Team hatte Zehntausende von Experimenten mit 1-6 Schnitten manuell durchgeführt und diese Daten zum Trainieren des Modells verwendet. Anschließend verwendeten sie einen Supercomputer des Energieministeriums, um Simulationen bis auf die molekulare Ebene durchzuführen. In Sekundenschnelle produzierte es eine 10-Schnitt-Variante mit 40 Prozent Dehnbarkeit, weit über das hinaus, was das Team erwartet oder sogar selbst ausprobiert hatte.

Bildnachweis: Argonne National Labs

„Es hat Dinge herausgefunden, von denen wir ihm nie gesagt haben, dass wir es herausfinden sollen. Es hat etwas gelernt, wie ein Mensch lernt, und hat sein Wissen genutzt, um etwas anderes zu tun“, sagte Projektleiter Pankaj Rajak. Der Erfolg hat sie dazu angespornt, die Komplexität und den Umfang der Simulation zu erhöhen.

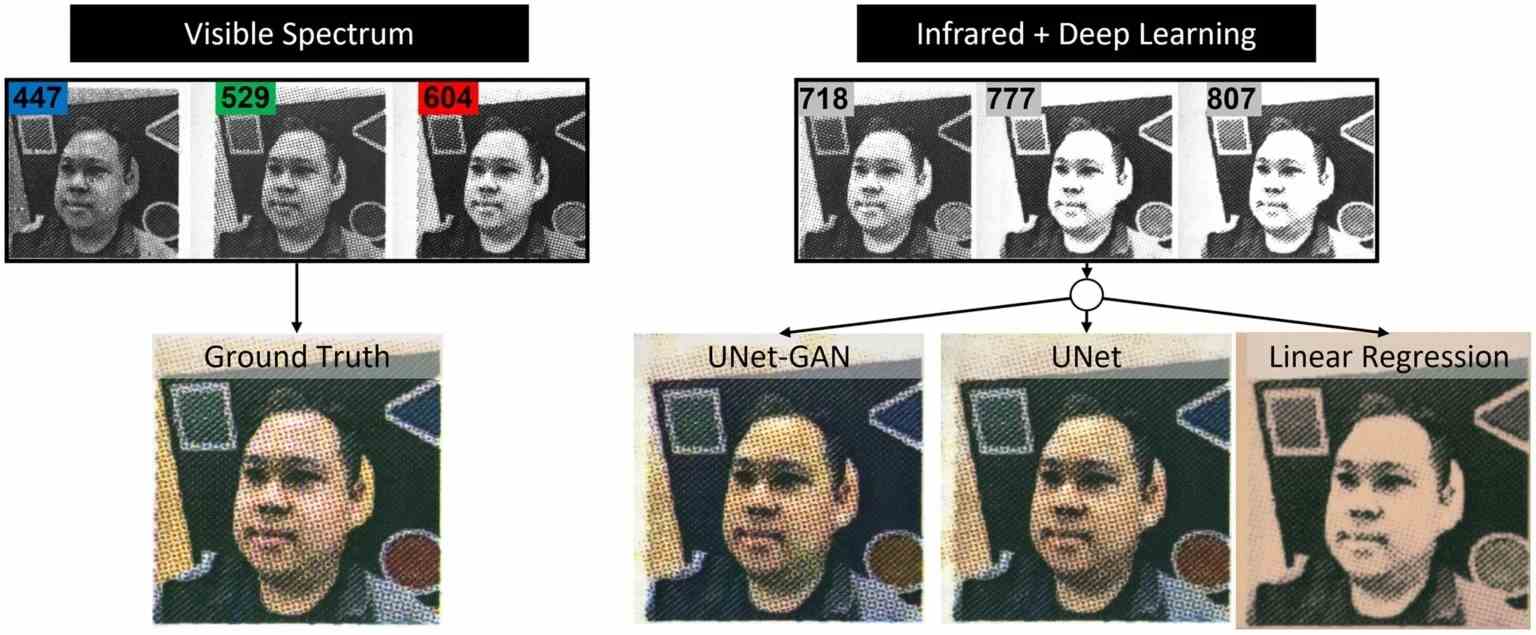

Eine weitere interessante Extrapolation, die von einer speziell ausgebildeten KI durchgeführt wird, ist ein Computer-Vision-Modell, das Farbdaten aus Infrarot-Eingaben rekonstruiert. Normalerweise weiß eine IR-Kamera nichts darüber, welche Farbe ein Objekt im sichtbaren Spektrum hat. Aber dieses Experiment fand Korrelationen zwischen bestimmten IR-Bändern und sichtbaren, und ein Modell erstellt um im IR aufgenommene Bilder menschlicher Gesichter in solche umzuwandeln, die dem sichtbaren Spektrum nahekommen.

Es ist immer noch nur ein Proof of Concept, aber eine solche Spektrumflexibilität könnte ein nützliches Werkzeug in Wissenschaft und Fotografie sein.

—

In der Zwischenzeit widerspricht eine neue Studie, die von Jeff Dean, dem Leiter der KI von Google, mitverfasst wurde, der Vorstellung, dass KI aufgrund ihrer hohen Rechenanforderungen ein ökologisch kostspieliges Unterfangen ist. Einige Untersuchungen haben zwar ergeben, dass das Trainieren eines großen Modells wie GPT-3 von OpenAI Kohlendioxidemissionen erzeugen kann gleichwertig Im Vergleich zu dem einer kleinen Nachbarschaft behauptet die mit Google verbundene Studie, dass die „Befolgung von Best Practices“ die CO2-Emissionen des maschinellen Lernens um das 1000-fache reduzieren kann.

Die fraglichen Praktiken betreffen die verwendeten Modelltypen, die zum Trainieren der Modelle verwendeten Maschinen, „Mechanisierung“ (z. B. Computing in der Cloud versus auf lokalen Computern) und „Map“ (Auswahl von Rechenzentrumsstandorten mit der saubersten Energie). Laut den Co-Autoren kann allein die Auswahl „effizienter“ Modelle den Rechenaufwand um Faktoren von 5 bis 10 reduzieren, während die Verwendung von für maschinelles Lernen optimierten Prozessoren wie GPUs das Verhältnis von Leistung pro Watt um Faktoren von 2 bis 5 verbessern kann.

Jeder Forschungsstrang, der darauf hindeutet, dass die Umweltauswirkungen von KI verringert werden können, ist in der Tat ein Grund zum Feiern. Aber es muss darauf hingewiesen werden, dass Google kein ist neutrale Partei. Viele der Produkte des Unternehmens, von Google Maps bis zur Google-Suche, basieren auf Modellen, deren Entwicklung und Ausführung viel Energie erforderten.

Mike Cook, ein Mitglied der offenen Forschungsgruppe Knives and Paintbrushes, weist darauf hin – selbst wenn die Schätzungen der Studie korrekt sind – dort ist einfach kein guter Grund für ein Unternehmen, nicht energieineffizient zu skalieren, wenn es ihm nützt. Während akademische Gruppen auf Metriken wie CO2-Auswirkungen achten, werden Unternehmen nicht auf die gleiche Weise motiviert – zumindest derzeit.

„Der einzige Grund, warum wir dieses Gespräch zu Beginn führen, ist, dass Unternehmen wie Google und OpenAI über praktisch unbegrenzte Mittel verfügten und sich entschieden, diese zu nutzen, um Modelle wie GPT-3 und BERT um jeden Preis zu bauen, weil sie wussten, dass es ihnen eine Chance gab Vorteil,“ Cook teilte Tech per E-Mail mit. „Gesamt, Ich denke, das Papier sagt ein paar nette Sachen und es ist großartig, wenn wir über Effizienz nachdenken, aber das Problem ist meiner Meinung nach kein technisches – wir wissen mit Sicherheit, dass diese Unternehmen groß werden, wenn sie es brauchen, sie haben gewonnen sich nicht zurückhalten, also zu sagen, dass dies jetzt für immer gelöst ist, fühlt sich einfach wie eine leere Zeile an.“

Beim letzten Thema dieser Woche geht es eigentlich nicht genau um maschinelles Lernen, sondern darum, wie man das Gehirn auf direktere Weise simulieren kann. Bioinformatiker der EPFL erstellte ein mathematisches Modell zur Erstellung von Tonnen von einzigartigen, aber genauen simulierten Neuronen, die schließlich zum Aufbau digitaler Zwillinge der Neuroanatomie verwendet werden könnten.

„Die Ergebnisse ermöglichen es Blue Brain bereits, biologisch detaillierte Rekonstruktionen und Simulationen des Mausgehirns zu erstellen, indem Gehirnregionen für Simulationen rechnerisch rekonstruiert werden, die die anatomischen Eigenschaften neuronaler Morphologien replizieren und eine regionsspezifische Anatomie beinhalten“, sagte die Forscherin Lida Kanari.

Erwarten Sie nicht, dass Sim-Gehirne zu besseren KIs führen – dies ist sehr ein Streben nach Fortschritten in den Neurowissenschaften – aber vielleicht können die Erkenntnisse aus simulierten neuronalen Netzwerken zu grundlegenden Verbesserungen des Verständnisses der Prozesse führen, die KI digital zu imitieren versucht.