KI-Modelle überraschen uns immer wieder, nicht nur in Bezug darauf, was sie können, sondern auch, was sie nicht können und warum. Eine interessante neue Verhaltensweise dieser Systeme ist sowohl oberflächlich als auch aufschlussreich: Sie wählen Zufallszahlen aus, als wären sie Menschen.

Aber zunächst einmal: Was bedeutet das überhaupt? Können Menschen nicht zufällig eine Zahl auswählen? Und wie können Sie feststellen, ob jemand damit erfolgreich ist oder nicht? Dies ist eigentlich eine sehr alte und bekannte Einschränkung, die wir Menschen haben: Wir denken zu viel über Zufälligkeit nach und missverstehen sie.

Sagen Sie einer Person, sie soll bei 100 Münzwürfen Kopf oder Zahl vorhersagen, und vergleichen Sie das mit 100 echten Münzwürfen. Sie können sie fast immer unterscheiden, weil, entgegen der Intuition, die echten Münzwürfe sehen weniger zufällig. Es kommt beispielsweise oft sechs oder sieben Mal hintereinander Kopf oder Zahl vor, was fast kein menschlicher Wahrsager in seine 100 einbezieht.

Dasselbe gilt, wenn Sie jemanden bitten, eine Zahl zwischen 0 und 100 zu wählen. Die Leute wählen fast nie 1 oder 100. Vielfache von 5 sind selten, ebenso wie Zahlen mit sich wiederholenden Ziffern wie 66 und 99. Sie wählen oft Zahlen, die auf 7 enden, normalerweise irgendwo in der Mitte.

In der Psychologie gibt es unzählige Beispiele für diese Art der Vorhersagbarkeit. Aber das macht es nicht weniger seltsam, wenn KIs dasselbe tun.

Ja, ein paar neugierige Ingenieure bei Gramener führten ein informelles, aber dennoch faszinierendes Experiment durch, bei dem sie mehrere große LLM-Chatbots einfach baten, zufällig eine Zahl zwischen 0 und 100 auszuwählen.

Leser, die Ergebnisse waren nicht zufällig.

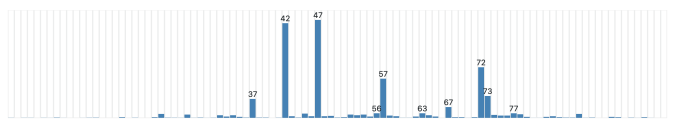

Alle drei getesteten Modelle hatten eine „Lieblingszahl“, die im deterministischsten Modus immer ihre Antwort war, die aber sogar bei höheren „Temperaturen“ am häufigsten auftrat, was die Variabilität ihrer Ergebnisse erhöhte.

Der GPT-3.5 Turbo von OpenAI mag 47 wirklich gern. Zuvor mochte er 42 – eine Zahl, die natürlich durch Douglas Adams in „Per Anhalter durch die Galaxis“ als Antwort auf das Leben, das Universum und den ganzen Rest berühmt wurde.

Anthropics Claude 3 Haiku hat sich für 42 entschieden. Und Gemini mag 72.

Interessanter ist, dass alle drei Modelle eine menschenähnliche Voreingenommenheit bei der Auswahl der Zahlen zeigten, sogar bei hohen Temperaturen.

Alle neigten dazu, niedrige und hohe Zahlen zu vermeiden; Claude kam nie über 87 oder unter 27, und selbst das waren Ausreißer. Doppelstellige Zahlen wurden peinlich genau vermieden: keine 33er, 55er oder 66er, aber 77 kam vor (endet auf 7). Fast keine runden Zahlen – obwohl Gemini einmal, bei der höchsten Temperatur, durchdrehte und 0 wählte.

Warum sollte das so sein? KIs sind nicht menschlich! Warum sollte es sie interessieren, was „zufällig“ erscheint? Haben sie endlich Bewusstsein erlangt und zeigen es so?!

Nein. Die Antwort ist, wie bei diesen Dingen üblich, dass wir einen Schritt zu weit gehen und die Vermenschlichung vorantreiben. Diese Modelle kümmern sich nicht darum, was zufällig ist und was nicht. Sie wissen nicht, was „Zufälligkeit“ ist! Sie beantworten diese Frage auf die gleiche Weise wie alle anderen: indem sie sich ihre Trainingsdaten ansehen und wiederholen, was am häufigsten nach einer Frage geschrieben wurde, die wie „Wählen Sie eine Zufallszahl“ aussah. Je häufiger es vorkommt, desto häufiger wiederholt das Modell es.

Wo in ihren Trainingsdaten würden sie 100 sehen, wenn fast niemand jemals so antwortet? Soweit das KI-Modell weiß, ist 100 keine akzeptable Antwort auf diese Frage. Da es über keine tatsächliche Denkfähigkeit und keinerlei Zahlenverständnis verfügt, kann es nur wie der stochastische Papagei antworten, der es ist.

Es ist ein anschauliches Beispiel für LLM-Gewohnheiten und die Menschlichkeit, die sie zu zeigen scheinen. Bei jeder Interaktion mit diesen Systemen muss man bedenken, dass sie darauf trainiert wurden, sich wie Menschen zu verhalten, auch wenn dies nicht beabsichtigt war. Deshalb ist Pseudanthropie so schwer zu vermeiden oder zu verhindern.

Ich habe in der Überschrift geschrieben, dass diese Models „denken, sie seien Menschen“, aber das ist ein wenig irreführend. Sie denken überhaupt nicht. Aber in ihren Antworten, zu jeder Zeit, Sind Menschen nachahmen, ohne dass man irgendetwas wissen oder denken muss. Egal, ob Sie nach einem Rezept für Kichererbsensalat, Anlagetipps oder einer Zufallszahl fragen, der Vorgang ist derselbe. Die Ergebnisse wirken menschlich, weil sie menschlich sind, direkt aus von Menschen erstellten Inhalten stammen und neu gemischt wurden – für Ihre Bequemlichkeit und natürlich für das Endergebnis der großen KI.