Jolla hat den offiziellen Abschluss der ersten Version seines in Arbeit befindlichen persönlichen serverbasierten KI-Assistenten gemacht. Das wiedergeborene Startup baut ein datenschutzorientiertes KI-Gerät – auch bekannt als Jolla Mind2das Tech bereits im Februar exklusiv auf dem MWC enthüllte.

An einer Livestream-Start Auf der Veranstaltung am Montag wurden auch die Vorbestellungen gestartet, wobei die ersten Einheiten noch in diesem Jahr in Europa ausgeliefert werden sollen. Weltweite Vorbestellungen beginnen im Juni, die Auslieferung soll später in diesem Jahr oder Anfang nächsten Jahres erfolgen.

In den mehr als zwei Monaten, seit wir den ersten 3D-gedruckten Prototyp von Jollas AI-in-a-box gesehen haben, ist ein erheblicher Hype um andere verbraucherorientierte KI-Geräte entstanden, wie etwa den Ai Pin von Humane und den Rabbit R1. Aber das anfängliche Interesse ist angesichts schlechter oder unvollendeter Benutzererfahrungen zurückgegangen – und des Gefühls, dass aufkommende KI-Gadgets sehr experimentierfreudig und wenig nützlich sind.

Das europäische Startup hinter Jolla Mind2 möchte, dass sein KI-Gerät nicht in diese Falle tappt, so CEO und Mitbegründer Antti Saarnio. Aus diesem Grund gehen sie „vorsichtig“ vor und versuchen, die Gefahr zu vermeiden, zu viel zu versprechen und zu wenig zu liefern.

„Ich bin sicher, dass dies einer der größten Umwälzungen für die KI ist – die Integration in unsere Software. Es ist eine massive Störung. Aber die ersten Ansätze waren im Grunde genommen überstürzt, und das war das Problem“, sagte er gegenüber Tech. „Man sollte Software einführen, die tatsächlich funktioniert.“

Das Feedback ist hart, aber angesichts der jüngsten Markteinführungen fair.

Laut Saarnio plant das Team, im Herbst die ersten paar Hundert Einheiten (bis zu 500) des Geräts an Erstanwender in Europa auszuliefern – wahrscheinlich um die Community von Enthusiasten anzusprechen, die es rund um frühere Produkte wie das mobile Betriebssystem Sailfish aufgebaut hat.

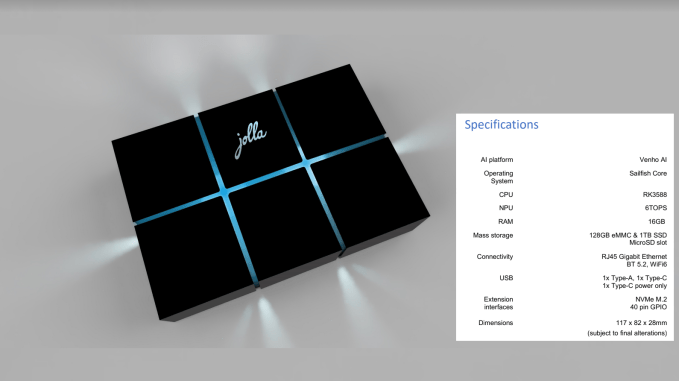

Preise für den Jolla Mind2 wird 699 Euro (inkl. MwSt.) kosten – die Hardware ist also deutlich teurer, als das Team ursprünglich geplant hatte. Aber es gibt auch mehr On-Board-RAM (16 GB) und Speicher (1 TB), als ursprünglich geplant war. Weniger gut: Nutzer müssen für ein Monatsabonnement ab 9,99 Euro bezahlen. Dies ist also ein weiteres KI-Gerät, das nicht billig sein wird.

KI-Agenten, die in einer Kiste leben

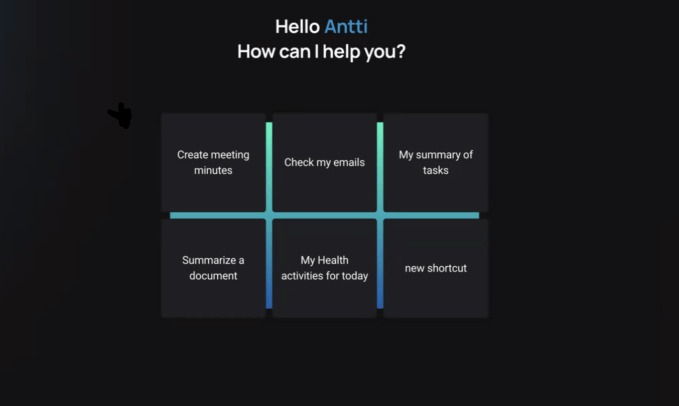

Der Jolla-Geist2 beherbergt eine Reihe von KI-Agenten, die auf verschiedene produktivitätsorientierte Anwendungsfälle abgestimmt sind. Sie sind für die Integration mit relevanten Drittanbieterdiensten (über APIs) konzipiert, sodass sie verschiedene Funktionen für Sie ausführen können – beispielsweise einen E-Mail-Agenten, der Ihren Posteingang durchsuchen und Nachrichten verfassen und senden kann. Oder ein Kontaktagent, den Jolla auf dem MWC kurz vorgeführt hat und der eine Sammlung von Informationen über Menschen sein kann, mit denen Sie interagieren, damit Sie über Ihr berufliches Netzwerk auf dem Laufenden bleiben.

In einem Videoanruf mit Tech vor dem offiziellen Start am Montag stellte Saarnio die neueste Version von Jolla Mind vor2 — Vorstellung einiger Funktionen, die wir vorher noch nicht gesehen hatten, einschließlich des oben genannten E-Mail-Agenten; eine Dokumentvorschau- und Zusammenfassungsfunktion; eine E-Signatur-Funktion für Dokumente; und etwas Neues nennt es „Wissensdatenbanken“ (mehr unten).

Die produktivitätsorientierten Funktionen, die wir in der Demo sahen, funktionierten, obwohl es einige bemerkenswerte Latenzprobleme gab. Ein entschuldigender Saarnio sagte, Demo-Gremlins hätten früher am Tag zugeschlagen, was zu Leistungsproblemen in letzter Minute geführt habe.

Der Wechsel zwischen Agenten erfolgte in der Demo der Chatbot-Schnittstelle ebenfalls manuell, aber er sagte, dass dies durch das semantische Verständnis der KI für Benutzeranfragen für das Endprodukt automatisiert würde.

Zu den geplanten KI-Agenten gehören: ein Kalenderagent; Speichermittel; Aufgabenmanagement; Nachrichtenagent (zur Integration mit Messaging-Apps von Drittanbietern); und einen „Coach-Agenten“, den sie in Apps und Geräte zur Aktivitäts-/Gesundheitsverfolgung von Drittanbietern einbinden wollen, damit der Benutzer seine quantifizierten Gesundheitsdaten auf dem Gerät abfragen kann.

Das Versprechen einer privaten Verarbeitung auf dem Gerät ist das Hauptverkaufsargument für das Produkt. Jolla besteht darauf, dass Benutzeranfragen und -daten sicher auf der in ihrem Besitz befindlichen Hardware bleiben. Anstatt – zum Beispiel wenn Sie ChatGPT von OpenAI verwenden – werden Ihre persönlichen Daten für kommerzielles Data Mining und die Gewinnchance einer anderen Person in die Cloud gesaugt …

Privatsphäre klingt großartig, aber die Latenz muss natürlich auf ein Minimum reduziert werden. Das ist doppelt wichtig, wenn man bedenkt, dass Jolla neben der strategischen Kernausrichtung, die auf dem Firewalling Ihrer persönlichen Daten liegt, auch auf Produktivität und Komfort im „Prosumer“-Anwendungsfall abzielt.

Der Kernpunkt besteht darin, dass das integrierte KI-Modell des Geräts mit etwa 3 Mrd. Parametern (das Saarnio als „kleines Sprachmodell“ bezeichnet) an alle Arten von Datenquellen von Drittanbietern angeschlossen werden kann. Dadurch stehen die Informationen des Benutzers für die weitere Verarbeitung und erweiterbare Nutzung zur Verfügung, ohne dass er sich Sorgen machen muss, dass die Sicherheit oder Integrität seiner Informationen gefährdet wird, wenn er die Leistungsfähigkeit der KI nutzt.

Für Fragen, wo der Jolla Mind2Da das lokale KI-Modell möglicherweise nicht ausreicht, bietet das System Benutzern die Möglichkeit, Abfragen „außerhalb der Welt“ zu senden – an große Sprachmodelle (LLMs) von Drittanbietern – und macht sie gleichzeitig darauf aufmerksam, dass sie dadurch ihre Daten senden außerhalb des sicheren und privaten Raums. Jolla spielt mit einer Form der Farbcodierung für Nachrichten, um den Grad des geltenden Datenschutzes anzuzeigen (z. B. Blau für vollständige Sicherheit auf dem Gerät; Rot für „Huch, Ihre Daten werden einer kommerziellen KI ausgesetzt, sodass alle Datenschutzrisiken ausgeschlossen sind“).

Die von Saarnio bestätigte Leistung wird für das Team im Vordergrund stehen, wenn es an der Verfeinerung des Produkts arbeitet. „Es ist im Grunde die alte Regel, dass man, wenn man einen Durchbruch erzielen will, fünfmal besser sein muss als die bestehenden Lösungen“, sagte er.

Auch die Sicherheit muss unbedingt im Vordergrund stehen. Die Hardware übernimmt beispielsweise die Einrichtung einer privaten VPN-Verbindung, sodass das Mobilgerät oder der Computer des Benutzers sicher mit dem Gerät kommunizieren kann. Saarnio fügte hinzu, dass es für den Fall eines Hardwarefehlers oder -verlusts eine verschlüsselte, cloudbasierte Sicherung der Benutzerdaten geben wird, die auf der Box gespeichert werden.

Welche Zero-Knowledge-Verschlüsselungsarchitektur sie wählen, um sicherzustellen, dass kein externer Zugriff auf die Daten möglich ist, wird für datenschutzbewusste Benutzer ein wichtiger Gesichtspunkt sein. Diese Details werden noch geklärt.

KI-Hardware mit einem Zweck?

Eine große Kritik, die an frühen KI-Geräten wie dem Ai Pin von Humane und dem Rabbit R1 geäußert wurde, besteht in einer unangenehmen Frage: Könnte das nicht einfach eine App sein? Angesichts der Tatsache, dass jeder bereits ein Smartphone einpackt.

Es handelt sich offensichtlich nicht um eine Angriffslinie, die offensichtlich auf den Jolla-Geist zutrifft2. Zum einen soll die Box, in der die KI untergebracht ist, statisch und nicht mobil sein. Wird an einem sicheren Ort zu Hause oder im Büro aufbewahrt. Sie müssen also nicht die meiste Zeit zwei Teile Hardware mit sich herumtragen. Tatsächlich ist Ihr Mobiltelefon (oder Desktop-Computer) das übliche Werkzeug für die Interaktion mit Jolla Mind2 – über eine Konversationsschnittstelle im Chatbot-Stil.

Das andere große Argument, das Saarnio vorbringt, um Jolla Mind zu rechtfertigen2 Als Gerät ist der Versuch, einen Ansatz im Stil eines persönlichen Servers für die KI-Verarbeitung in der Cloud auszuführen, schwierig – oder sehr teuer – zu skalieren.

„Ich denke, es würde sehr schwierig werden, die Cloud-Infrastruktur zu skalieren, wenn man lokales LLM für jeden Benutzer separat ausführen müsste. Es müsste ständig ein Cloud-Dienst laufen. Denn das erneute Starten kann etwa fünf Minuten dauern, sodass man es nicht wirklich auf diese Weise verwenden kann“, argumentierte er. „Sie könnten eine Lösung haben, die Sie zum Beispiel auf Ihren Desktop herunterladen, die Sie dann aber mit Ihrem Smartphone nutzen können. Auch wenn Sie eine Umgebung mit mehreren Geräten haben möchten, ist diese Art von Personal Server meiner Meinung nach die einzige Lösung.“

Die oben genannte Wissensdatenbank ist eine weitere Art von KI-Agent-Funktion, mit der der Benutzer das Gerät anweisen kann, eine Verbindung zu kuratierten Informationsspeichern herzustellen, um den Nutzen weiter zu erweitern.

Saarnio demonstrierte ein Beispiel eines kuratierten Info-Dumps über die Abholzung in Afrika. Sobald eine Wissensdatenbank auf dem Gerät erfasst wurde, kann sie vom Benutzer abgefragt werden. Dadurch wird die Fähigkeit des Modells erweitert, ihn dabei zu unterstützen, mehr über ein bestimmtes Thema zu verstehen.

„Der Benutzer [could say] „Hey, ich möchte etwas über die Abholzung afrikanischer Wälder lernen“, erklärte er. „Dann sagt der KI-Agent, wir hätten hier einen Anbieter [who has] hat dazu eine externe Wissensdatenbank erstellt. Möchten Sie sich damit verbinden? Und dann können Sie mit dieser Wissensdatenbank chatten. Sie können es auch bitten, eine Zusammenfassung oder ein Dokument/einen Bericht darüber zu erstellen oder so weiter.

„Das ist eines der großen Dinge, über die wir nachdenken – die wir haben müssen benotet Informationen im Internet“, fügte er hinzu. „Sie könnten also einen Vordenker oder einen Professor aus einem Bereich wie der Klimawissenschaft eine Wissensdatenbank erstellen lassen – alle relevanten Forschungsarbeiten hochladen – und dann könnte der Benutzer … eine Art Vertrauen haben, dass jemand diese Informationen bewertet hat.“

Wenn Jolla das zum Fliegen bringen kann, könnte es ziemlich klug sein. LLMs neigen nicht nur dazu, Informationen zu fabrizieren, sondern auch erfundenen Unsinn so darzustellen, als sei er die absolute Wahrheit. Wie können Webnutzer, die in einer zunehmend von KI generierten Internetinhaltslandschaft surfen, sicher sein, dass es sich bei den Informationen, denen sie ausgesetzt sind, um echte Informationen handelt?

Die Antwort des Startups auf diese schnell wachsende Wissenskrise besteht darin, Benutzern die Möglichkeit zu geben, ihr eigenes KI-Modell auf dem Gerät auf ihre bevorzugte(n) Wahrheitsquelle(n) auszurichten. Es handelt sich um eine erfreulicherweise auf den Menschen ausgerichtete Lösung des Wahrheitsproblems der Big AI. Kleine KI-Modelle und intelligent kuratierte Datenquellen könnten mit ihrem energieintensiven, rechenintensiven und datenintensiven Ansatz auch eine umweltfreundlichere Art von GenAI-Tool bieten als Big AI.

Damit diese Funktion funktioniert, muss Jolla natürlich nützliche Wissensdatenbanken zusammenstellen. Es ist vorgesehen, dass diese von Benutzern und der breiteren Community, von der sie hofft, dass sie ihren Ansatz unterstützen, kuratiert und bewertet werden. Saarnio meint, das sei keine große Herausforderung. Fachexperten werden leicht in der Lage sein, nützliche Recherche-Repositories zusammenzustellen und zu teilen, schlägt er vor.

Jolla Mind2 wirft ein weiteres Problem auf: Inwieweit liegt die Erfahrung von Technologiebenutzern mit Software typischerweise weit außerhalb ihrer Kontrolle? Benutzeroberflächen werden routinemäßig so gestaltet, dass sie absichtlich ablenken/aufmerksamkeitserregend oder sogar geradezu manipulativ sind. Ein weiteres Verkaufsargument für das Produkt besteht darin, Menschen dabei zu helfen, ihre Entscheidungsfreiheit von all den dunklen Mustern, Schlamm, Benachrichtigungen usw. usw. zurückzugewinnen – was auch immer Sie an all den Apps, die Sie verwenden müssen, wirklich nervt. Sie können die KI bitten, in Ihrem Namen den Lärm zu beseitigen.

Laut Saarnio wird das KI-Modell in der Lage sein, Inhalte von Drittanbietern zu filtern. Beispielsweise könnte ein Benutzer darum bitten, nur KI-bezogene Beiträge aus seinem X-Feed angezeigt zu bekommen und nicht mit anderen Inhalten konfrontiert zu werden. Dies ergibt eine Supermacht auf Abruf, mit der Sie digital gestalten können, was Sie sind und was nicht.

„Die ganze Idee [is] um eine friedliche digitale Arbeitsumgebung zu schaffen“, fügte er hinzu.

Saarnio weiß besser als die meisten, wie schwierig es ist, Menschen vom Kauf neuartiger Geräte zu überzeugen, wenn man Jollas lange Hintergrundgeschichte als Hersteller alternativer Smartphones berücksichtigt. Es überrascht daher nicht, dass das Team auch ein B2B-Lizenzierungsspiel plant.

Hier sieht das Startup das größte Potenzial für die Verbreitung seines KI-Geräts, sagt er – und geht davon aus, dass es einen Weg haben könnte, „Hunderttausende“ oder sogar Millionen von Geräten über Partner zu verkaufen. Er räumt ein, dass die Community-Verkäufe von Jolla wahrscheinlich nicht mehr als ein paar Zehntausend betragen werden, was der begrenzten Größe ihrer engagierten, enthusiastischen Fangemeinde entspricht.

Die KI-Komponente des Produkts wird von einem anderen (neuen) Unternehmen namens Venho AI entwickelt. Venho AI ist nicht nur für die Software-Gehirne verantwortlich, die das Jolla Mind antreiben, sondern2Dieses Unternehmen wird als Lizenzlieferant für andere Unternehmen fungieren, die ihre eigenen Markenversionen des Personal-Server-mit-KI-Assistenten-Konzepts anbieten möchten.

Saarnio schlägt vor, dass Telekommunikationsunternehmen ein potenzieller Zielkunde für die Lizenzierung des KI-Modells sein könnten – da diese Infrastrukturbetreiber erneut Gefahr laufen, die digitale Beute zu verpassen, da Technologiegiganten dazu übergehen, generative KI in ihre Plattformen zu integrieren.

Aber das Wichtigste zuerst. Jolla/Venho muss ein solides KI-Produkt liefern.

„Wir müssen die Software zuerst reifen lassen und sie mit der Community testen und entwickeln – und dann, nach dem Sommer, werden wir anfangen, mit Vertriebspartnern zu diskutieren“, fügte er hinzu.