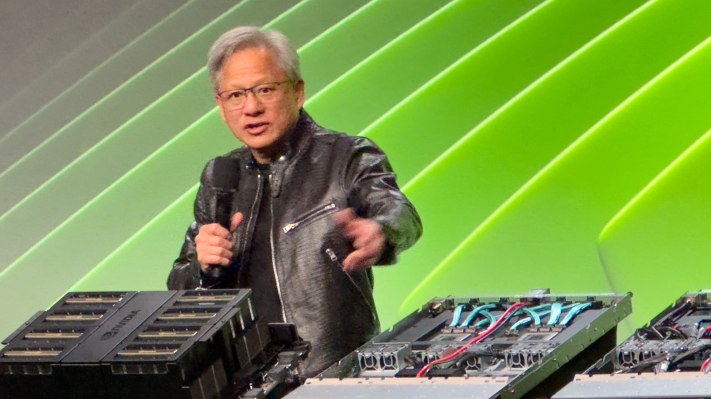

Künstliche Allgemeine Intelligenz (AGI) – oft als „starke KI“, „vollständige KI“, „KI auf menschlicher Ebene“ oder „allgemeine intelligente Aktion“ bezeichnet – stellt einen bedeutenden Zukunftssprung auf dem Gebiet der künstlichen Intelligenz dar. Im Gegensatz zu einer eingeschränkten KI, die auf bestimmte Aufgaben zugeschnitten ist (z. B. das Erkennen von Produktfehlern, das Zusammenfassen von Nachrichten oder das Erstellen einer Website), wird AGI in der Lage sein, ein breites Spektrum kognitiver Aufgaben auf oder über dem menschlichen Niveau auszuführen. Als CEO Jensen Huang diese Woche auf der jährlichen GTC-Entwicklerkonferenz von Nvidia vor der Presse sprach, schien es ihm wirklich langweilig zu werden, über das Thema zu diskutieren – nicht zuletzt, weil er oft falsch zitiert wird, sagt er.

Die Häufigkeit der Frage macht Sinn: Das Konzept wirft existenzielle Fragen zur Rolle des Menschen in einer Zukunft und zur Kontrolle über ihn auf, in der Maschinen den Menschen in nahezu allen Bereichen übertreffen, lernen und übertreffen können. Der Kern dieser Sorge liegt in der Unvorhersehbarkeit der Entscheidungsprozesse und Ziele von AGI, die möglicherweise nicht mit menschlichen Werten oder Prioritäten (einem Konzept) übereinstimmen wird in der Science-Fiction seit mindestens den 1940er Jahren eingehend untersucht). Es besteht die Sorge, dass AGI, sobald sie ein bestimmtes Maß an Autonomie und Leistungsfähigkeit erreicht, möglicherweise nicht mehr einzudämmen oder zu kontrollieren ist, was zu Szenarien führt, in denen ihre Aktionen nicht vorhersehbar oder rückgängig gemacht werden können.

Wenn Sensationspresse nach einem Zeitrahmen fragt, verleitet sie KI-Experten oft dazu, einen Zeitplan für das Ende der Menschheit – oder zumindest den aktuellen Status quo – aufzustellen. Es versteht sich von selbst, dass KI-CEOs nicht immer bereit sind, sich mit dem Thema auseinanderzusetzen.

Huang verbrachte jedoch einige Zeit damit, der Presse zu erzählen, was er sagte tut über das Thema nachdenken. Die Vorhersage, wann wir einen passablen AGI sehen werden, hängt davon ab, wie man AGI definiert, argumentiert Huang und zieht ein paar Parallelen: Selbst mit den Komplikationen der Zeitzonen weiß man, wann das neue Jahr beginnt und das Jahr 2025 vor der Tür steht. Wenn Sie zum San Jose Convention Center fahren (wo die diesjährige GTC-Konferenz stattfindet), wissen Sie in der Regel, dass Sie angekommen sind, wenn Sie die riesigen GTC-Banner sehen. Der entscheidende Punkt ist, dass wir uns darauf einigen können, wie wir messen können, ob Sie zeitlich oder räumlich dort angekommen sind, wo Sie hinwollen.

„Wenn wir AGI als etwas ganz Spezifisches spezifizieren würden, eine Reihe von Tests, bei denen ein Softwareprogramm sehr gut abschneiden kann – oder vielleicht 8 % besser als die meisten Leute – dann glaube ich, dass wir innerhalb von fünf Jahren dorthin gelangen werden“, erklärt Huang. Er schlägt vor, dass es sich bei den Tests um eine juristische Anwaltsprüfung, Logiktests, Wirtschaftstests oder vielleicht um die Fähigkeit, eine Vorprüfung zum Medizinstudium zu bestehen, handeln könnte. Sofern der Fragesteller nicht in der Lage ist, sehr genau zu sagen, was AGI im Kontext der Frage bedeutet, ist er nicht bereit, eine Vorhersage zu treffen. Fair genug.

KI-Halluzination ist lösbar

In der Frage-und-Antwort-Runde am Dienstag wurde Huang gefragt, was man gegen KI-Halluzinationen tun solle – die Tendenz einiger KIs, sich etwas auszudenken, beantwortet diese Frage Klang plausibel, basieren aber nicht auf Tatsachen. Er schien von der Frage sichtlich frustriert zu sein und schlug vor, dass Halluzinationen leicht lösbar seien – indem man darauf achtete, dass die Antworten gut recherchiert seien.

„Fügen Sie eine Regel hinzu: Für jede einzelne Antwort müssen Sie die Antwort nachschlagen“, sagt Huang und bezeichnet diese Praxis als „Retrieval-Augmented Generation“ und beschreibt einen Ansatz, der der grundlegenden Medienkompetenz sehr ähnlich ist: Untersuchen Sie die Quelle und die Kontext. Vergleichen Sie die in der Quelle enthaltenen Fakten mit bekannten Wahrheiten, und wenn die Antwort sachlich – auch teilweise – ungenau ist, verwerfen Sie die gesamte Quelle und fahren Sie mit der nächsten fort. „Die KI sollte nicht nur antworten, sondern zunächst recherchieren, um herauszufinden, welche der Antworten die besten sind.“

Für geschäftskritische Antworten wie Gesundheitsratschläge oder ähnliches schlägt der CEO von Nvidia vor, dass möglicherweise die Überprüfung mehrerer Ressourcen und bekannter Wahrheitsquellen der richtige Weg ist. Das bedeutet natürlich, dass der Generator, der eine Antwort erstellt, die Möglichkeit haben muss zu sagen: „Ich kenne die Antwort auf Ihre Frage nicht“ oder „Ich kann mich nicht darauf einigen, was die richtige Antwort ist.“ „Diese Frage ist“ oder auch so etwas wie „Hey, der Superbowl hat noch nicht stattgefunden, also weiß ich nicht, wer gewonnen hat.“