Kann generative KI, die für Unternehmen entwickelt wurde (z. B. KI, die Berichte, Tabellenkalkulationsformeln usw. automatisch vervollständigt), jemals interoperabel sein? Zusammen mit einer Gruppe von Organisationen, darunter Cloudera und Intel, möchte die Linux Foundation – die gemeinnützige Organisation, die eine wachsende Zahl von Open-Source-Bemühungen unterstützt und pflegt – das herausfinden.

Die Linux Foundation gab heute den Start der Open Platform for Enterprise AI (OPEA) bekannt, einem Projekt zur Förderung der Entwicklung offener, anbieterübergreifender und zusammensetzbarer (d. h. modularer) generativer KI-Systeme. Unter der Leitung der LFAI- und Datenorganisation der Linux Foundation, die sich auf KI- und datenbezogene Plattforminitiativen konzentriert, wird das Ziel von OPEA darin bestehen, den Weg für die Veröffentlichung „gehärteter“, „skalierbarer“ generativer KI-Systeme zu ebnen, die „die nutzen.“ „Die beste Open-Source-Innovation aus dem gesamten Ökosystem“, sagte Ibrahim Haddad, Executive Director von LFAI und Data, in einer Pressemitteilung.

„OPEA wird neue Möglichkeiten in der KI erschließen, indem es ein detailliertes, zusammensetzbares Framework schafft, das an der Spitze der Technologie-Stacks steht“, sagte Haddad. „Diese Initiative ist ein Beweis für unsere Mission, Open-Source-Innovationen und Zusammenarbeit innerhalb der KI- und Datengemeinschaften im Rahmen eines neutralen und offenen Governance-Modells voranzutreiben.“

Neben Cloudera und Intel zählt OPEA – eines der Sandbox-Projekte der Linux Foundation, eine Art Inkubatorprogramm – zu seinen Mitgliedern Unternehmensschwergewichte wie Intel, das IBM-eigene Red Hat, Hugging Face, Domino Data Lab, MariaDB und VMWare.

Was genau könnten sie also gemeinsam aufbauen? Haddad weist auf einige Möglichkeiten hin, wie etwa eine „optimierte“ Unterstützung für KI-Toolchains und Compiler, die es ermöglichen, dass KI-Workloads über verschiedene Hardwarekomponenten hinweg laufen, sowie „heterogene“ Pipelines für Retrieval-Augmented Generation (RAG).

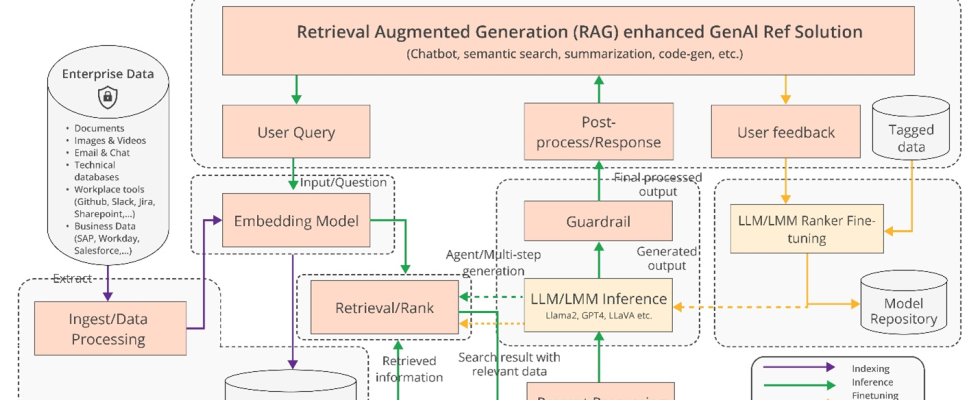

RAG wird in Unternehmensanwendungen der generativen KI immer beliebter, und es ist nicht schwer zu verstehen, warum. Die Antworten und Aktionen der meisten generativen KI-Modelle beschränken sich auf die Daten, auf denen sie trainiert werden. Aber mit RAG kann die Wissensbasis eines Modells um Informationen außerhalb der ursprünglichen Trainingsdaten erweitert werden. RAG-Modelle verweisen auf diese externen Informationen – die in Form proprietärer Unternehmensdaten, einer öffentlichen Datenbank oder einer Kombination aus beidem vorliegen können –, bevor sie eine Antwort generieren oder eine Aufgabe ausführen.

Ein Diagramm zur Erläuterung von RAG-Modellen.

Intel hat selbst noch ein paar weitere Details preisgegeben Pressemitteilung:

Unternehmen stehen vor der Herausforderung eines Do-it-yourself-Ansatzes [to RAG] Denn es gibt keine komponentenübergreifenden De-facto-Standards, die es Unternehmen ermöglichen, RAG-Lösungen auszuwählen und einzusetzen, die offen und interoperabel sind und die ihnen helfen, schnell auf den Markt zu kommen. OPEA beabsichtigt, diese Probleme anzugehen, indem es mit der Industrie zusammenarbeitet, um Komponenten, einschließlich Frameworks, Architekturentwürfe und Referenzlösungen, zu standardisieren.

Auch die Evaluierung wird ein wichtiger Teil der Maßnahmen der OPEA sein.

In seinem GitHub RepositoryOPEA schlägt eine Rubrik zur Bewertung generativer KI-Systeme entlang von vier Achsen vor: Leistung, Funktionen, Vertrauenswürdigkeit und „Unternehmenstauglichkeit“. Leistung Laut OPEA handelt es sich um „Black-Box“-Benchmarks aus realen Anwendungsfällen. Merkmale ist eine Bewertung der Interoperabilität, der Einsatzmöglichkeiten und der Benutzerfreundlichkeit eines Systems. Bei der Vertrauenswürdigkeit geht es um die Fähigkeit eines KI-Modells, „Robustheit“ und Qualität zu gewährleisten. Und Unternehmensbereitschaft konzentriert sich auf die Anforderungen, um ein System ohne größere Probleme zum Laufen zu bringen.

Rachel Roumeliotis, Direktorin für Open-Source-Strategie bei Intel, sagt dass OPEA mit der Open-Source-Community zusammenarbeiten wird, um Tests basierend auf der Rubrik anzubieten – und auf Anfrage Bewertungen und Einstufungen von generativen KI-Einsätzen bereitzustellen.

Die anderen Bestrebungen der OPEA liegen derzeit noch in der Schwebe. Aber Haddad nutzte das Potenzial der offenen Modellentwicklung im Sinne der wachsenden Llama-Familie von Meta und DBRX von Databricks. Zu diesem Zweck hat Intel im OPEA-Repo bereits Referenzimplementierungen für einen Chatbot, Dokumentenzusammenfassungs- und Codegenerator mit generativer KI beigesteuert, der für seine Xeon 6- und Gaudi 2-Hardware optimiert ist.

Nun sind die OPEA-Mitglieder eindeutig in die Entwicklung von Werkzeugen für generative KI für Unternehmen investiert (und auch eigennützig daran interessiert). Cloudera vor kurzem Partnerschaften ins Leben gerufen um das zu schaffen, was es als „KI-Ökosystem“ in der Cloud bezeichnet. Domino bietet ein Suite von Apps für den Aufbau und die Prüfung geschäftsorientierter generativer KI. Und VMWare – ausgerichtet auf die Infrastrukturseite der Unternehmens-KI – wurde letzten August eingeführt neue „private KI“-Rechnerprodukte.

Die Frage ist – unter OPEA – werden diese Anbieter dies tun Genau genommen zusammenarbeiten, um kompatible KI-Tools zu entwickeln?

Das hat einen offensichtlichen Vorteil. Kunden können je nach Bedarf, Ressourcen und Budget gerne auf mehrere Anbieter zurückgreifen. Die Geschichte hat jedoch gezeigt, dass es allzu leicht zu einer Abhängigkeit vom jeweiligen Anbieter kommt. Hoffen wir, dass das hier nicht das endgültige Ergebnis ist.