Indien, lange im Zahn, wenn es darum geht Kooptation von Technologie, um die Öffentlichkeit zu überzeugen, ist zu einem globalen Hotspot geworden, wenn es darum geht, wie KI im politischen Diskurs und insbesondere im demokratischen Prozess eingesetzt und missbraucht wird. Technologieunternehmen, die die Tools ursprünglich entwickelt haben, reisen ins Land, um Lösungen voranzutreiben.

Anfang des Jahres geriet Andy Parsons, ein leitender Direktor bei Adobe, der die Beteiligung an der branchenübergreifenden Content Authenticity Initiative (CAI) überwacht, in den Strudel, als er eine Reise nach Indien unternahm, um Medien- und Technologieorganisationen im Land zu besuchen Förderung von Tools, die in Content-Workflows integriert werden können, um KI-Inhalte zu identifizieren und zu kennzeichnen.

„Anstatt zu erkennen, was gefälscht oder manipuliert ist, sollten wir als Gesellschaft, und das ist ein internationales Anliegen, damit beginnen, Authentizität zu deklarieren, also zu sagen, ob etwas von KI erzeugt wird, das den Verbrauchern bekannt sein sollte“, sagte er in einem Interview.

Parsons fügte hinzu, dass einige indische Unternehmen – derzeit nicht Teil eines Münchner Abkommens zur Sicherheit von KI-Wahlen, das im Februar von OpenAI, Adobe, Google und Amazon unterzeichnet wurde – beabsichtigten, eine ähnliche Allianz im Land aufzubauen.

„Gesetzgebung ist eine sehr heikle Sache. Man kann sich kaum darauf verlassen, dass die Regierung in jedem Rechtsgebiet korrekt und schnell genug Gesetze erlassen wird. Für die Regierung ist es besser, sehr konsequent vorzugehen und sich Zeit zu nehmen“, sagte er.

Erkennungstools sind bekanntermaßen inkonsistent, aber sie sind ein erster Schritt zur Behebung einiger Probleme, so das Argument.

„Das Konzept ist bereits gut verstanden“, sagte er während seiner Delhi-Reise. „Was ich dazu helfe, das Bewusstsein dafür zu schärfen, dass die Werkzeuge auch bereit sind. Es ist nicht nur eine Idee. Das ist etwas, das bereits eingesetzt wird.“

Andy Parsons, Senior Director bei Adobe. Bildnachweis: Adobe

Das CAI – das lizenzfreie, offene Standards zur Identifizierung, ob digitale Inhalte von einer Maschine oder einem Menschen generiert wurden – fördert, existiert schon vor dem aktuellen Hype um generative KI: Es wurde 2019 gegründet und hat mittlerweile 2.500 Mitglieder, darunter Microsoft, Meta und Google , der New York Times, dem Wall Street Journal und der BBC.

So wie es eine Branche gibt, die rund um die Nutzung von KI zur Medienerstellung wächst, wird auch eine kleinere Branche gegründet, um zu versuchen, einige der schändlicheren Anwendungen davon natürlich zu korrigieren.

Im Februar 2021 ging Adobe daher einen Schritt weiter und gründete gemeinsam mit ARM, BBC, Intel, Microsoft und Truepic die Coalition for Content Provenance and Authenticity (C2PA). Ziel der Koalition ist es, einen offenen Standard zu entwickeln, der die Metadaten von Bildern, Videos, Texten und anderen Medien nutzt, um deren Herkunft hervorzuheben und die Menschen über die Herkunft der Datei, den Ort und die Zeit ihrer Erstellung sowie darüber zu informieren, ob sie vor der Übermittlung geändert wurde der Benutzer. Das CAI arbeitet mit C2PA zusammen, um den Standard zu fördern und der breiten Masse zugänglich zu machen.

Jetzt arbeitet das Unternehmen aktiv mit Regierungen wie der indischen zusammen, um die Einführung dieses Standards auszuweiten, um die Herkunft von KI-Inhalten hervorzuheben und sich gemeinsam mit den Behörden an der Entwicklung von Richtlinien für die Weiterentwicklung der KI zu beteiligen.

Adobe hat nichts, aber auch alles zu verlieren, wenn es in diesem Spiel eine aktive Rolle spielt. Das Unternehmen erwirbt oder erstellt noch keine eigenen großen Sprachmodelle, aber als Heimat von Apps wie Photoshop und Lightroom ist es Marktführer bei Tools für die kreative Community und entwickelt daher nicht nur neue Produkte wie Firefly, um diese zu generieren KI-Inhalte nativ, aber auch ältere Produkte werden mit KI ausgestattet. Wenn sich der Markt so entwickelt, wie manche glauben, wird KI ein Muss sein, wenn Adobe an der Spitze bleiben will. Wenn es nach den Regulierungsbehörden (oder dem gesunden Menschenverstand) geht, hängt die Zukunft von Adobe möglicherweise davon ab, wie erfolgreich es ist, sicherzustellen, dass das, was es verkauft, nicht zum Chaos beiträgt.

Das Gesamtbild in Indien ist auf jeden Fall ein Chaos.

Google konzentrierte sich auf Indien als Testumgebung dafür, wie es den Einsatz seines generativen KI-Tools Gemini bei Wahlinhalten verhindern wird. Parteien sind KI als Waffe einsetzen Memes mit Ähnlichkeiten von Gegnern zu erstellen; Meta hat ein Deepfake eingerichtet „Hotline„Für WhatsApp ist die Popularität der Messaging-Plattform bei der Verbreitung von KI-gestützten Nachrichten so groß; Und in einer Zeit, in der die Länder zunehmend besorgt über die KI-Sicherheit sind und darüber, was sie tun müssen, um diese zu gewährleisten, müssen wir abwarten, welche Auswirkungen es haben wird, wenn die indische Regierung im März beschließt, die Regeln für die Entwicklung neuer KI-Modelle zu lockern , getestet und eingesetzt. Es soll auf jeden Fall mehr KI-Aktivitäten anregen.

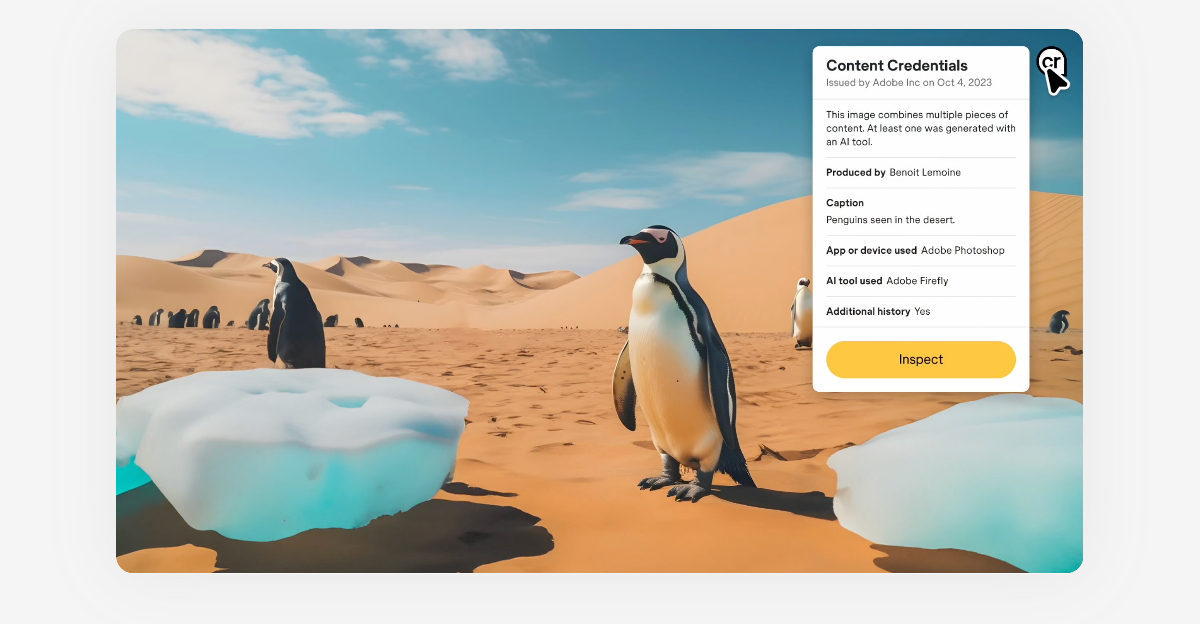

Unter Verwendung seines offenen Standards hat das C2PA ein digitales Nährwertkennzeichen für Inhalte mit dem Namen entwickelt Inhaltliche Anmeldeinformationen. Die CAI-Mitglieder arbeiten daran, das digitale Wasserzeichen in ihren Inhalten einzusetzen, um den Nutzern mitzuteilen, woher es stammt und ob es KI-generiert ist. Adobe verfügt über Content-Anmeldeinformationen für alle seine Kreativtools, einschließlich Photoshop und Lightroom. Es wird auch automatisch an KI-Inhalte angehängt, die vom KI-Modell Firefly von Adobe generiert wurden. Letztes Jahr, Leica hat seine Kamera auf den Markt gebracht mit integrierten Inhaltsanmeldeinformationen, und Microsoft hat allen KI-generierten Bildern, die mit Bing Image Creator erstellt wurden, Inhaltsanmeldeinformationen hinzugefügt.

Bildnachweis: Inhaltliche Anmeldeinformationen

Parsons sagte gegenüber Tech, dass das CAI mit Regierungen weltweit in zwei Bereichen spreche: Zum einen soll es helfen, den Standard als internationalen Standard zu fördern, zum anderen soll man ihn übernehmen.

„In einem Wahljahr ist es besonders wichtig für Kandidaten, Parteien, amtierende Ämter und Verwaltungen, die ständig Material an die Medien und die Öffentlichkeit weitergeben, sicherzustellen, dass bekannt ist, ob etwas vom Premierminister veröffentlicht wird [Narendra] Modis Büro, es stammt eigentlich aus dem Büro von Premierminister Modi. Es gab viele Vorfälle, bei denen das nicht der Fall war. Daher ist es sehr wichtig zu verstehen, dass etwas für Verbraucher, Faktenprüfer, Plattformen und Vermittler wirklich authentisch ist“, sagte er.

Indiens große Bevölkerung, die enorme Sprachenvielfalt und die demografische Vielfalt machten es schwierig, Fehlinformationen einzudämmen, fügte er hinzu, ein Votum für einfache Etiketten, um dies zu verhindern.

„Das ist ein bisschen ‚CR‘ … es sind zwei westliche Buchstaben, wie die meisten Adobe-Tools, aber das deutet darauf hin, dass mehr Kontext angezeigt werden muss“, sagte er.

Es wird weiterhin kontrovers darüber diskutiert, was der eigentliche Sinn dahinter sein könnte, warum Technologieunternehmen jede Art von KI-Sicherheitsmaßnahme unterstützen: Geht es wirklich um existenzielle Bedenken oder geht es einfach nur darum, am Tisch Platz zu nehmen, um den Eindruck existenzieller Bedenken zu erwecken und gleichzeitig dafür zu sorgen, dass dies der Fall ist? Werden Interessen im Prozess der Regelsetzung gewahrt?

„Im Allgemeinen ist es bei den beteiligten Unternehmen nicht umstritten, und alle Unternehmen, die das jüngste Münchner Abkommen unterzeichnet haben, einschließlich Adobe, die sich zusammengeschlossen haben, haben den Wettbewerbsdruck verringert, weil diese Ideen etwas sind, das wir alle umsetzen müssen“, sagte er zu seiner Verteidigung der Arbeit.