Die KI-Welt findet immer noch heraus, wie sie mit der erstaunlichen Leistungsfähigkeit umgehen soll, die DALL-E 2 in der Lage ist, so gut wie alles zu zeichnen/malen/vorzustellen … aber OpenAI ist nicht die einzige, die an so etwas arbeitet. Google Research hat sich beeilt, ein ähnliches Modell zu veröffentlichen, an dem es arbeitet – von dem es behauptet, dass es sogar noch besser ist.

Bildn (verstanden?) ist ein Text-zu-Bild-Diffusions-basierter Generator, der auf großen Transformer-Sprachmodellen basiert, die … okay, lasst uns langsamer werden und so schnell entpacken.

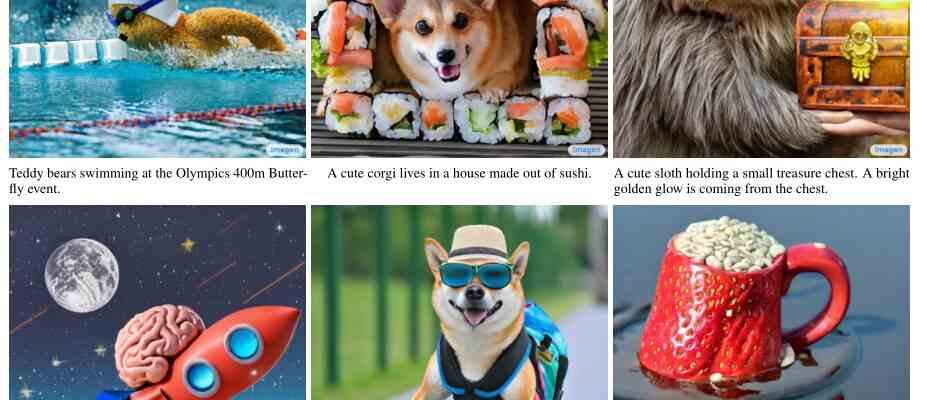

Text-zu-Bild-Modelle verwenden Texteingaben wie „ein Hund auf einem Fahrrad“ und erzeugen ein entsprechendes Bild, was seit Jahren praktiziert wird, aber in letzter Zeit große Sprünge in Qualität und Zugänglichkeit erlebt hat.

Ein Teil davon ist die Verwendung von Diffusionstechniken, die im Grunde mit einem reinen Rauschbild beginnen und es langsam Stück für Stück verfeinern, bis das Modell denkt, dass es nicht mehr wie ein Hund auf einem Fahrrad aussehen kann, als es bereits tut. Dies war eine Verbesserung gegenüber Top-to-Bottom-Generatoren, die auf den ersten Blick urkomisch falsch liegen konnten, und andere, die leicht in die Irre geführt werden konnten.

Der andere Teil ist ein verbessertes Sprachverständnis durch große Sprachmodelle unter Verwendung des Transformer-Ansatzes, auf dessen technische Aspekte ich hier nicht eingehen werde (und kann), aber er und einige andere neuere Fortschritte haben zu überzeugenden Sprachmodellen wie geführt GPT-3 und andere.

Bildnachweis: Google-Forschung

Imagen beginnt mit der Generierung eines kleinen Bildes (64×64 Pixel) und führt dann zwei „Superauflösungs“-Durchläufe durch, um es auf 1024×1024 zu bringen. Dies ist jedoch keine normale Hochskalierung, da die KI-Superauflösung auf der Grundlage des Originals neue Details in Harmonie mit dem kleineren Bild erstellt.

Angenommen, Sie haben einen Hund auf einem Fahrrad und das Auge des Hundes hat im ersten Bild einen Durchmesser von 3 Pixeln. Nicht viel Raum für Ausdruck! Aber auf dem zweiten Bild ist es 12 Pixel breit. Woher kommen die dafür benötigten Details? Nun, die KI weiß, wie das Auge eines Hundes aussieht, also generiert sie beim Zeichnen mehr Details. Dann passiert dies erneut, wenn das Auge wieder fertig ist, aber mit 48 Pixeln im Durchmesser. Aber zu keinem Zeitpunkt musste die KI einfach 48 x wie viele Pixel eines Hundeauges aus ihrer … sagen wir Zaubertüte ziehen. Wie viele Künstler begann es mit dem Äquivalent einer groben Skizze, füllte es in einem Arbeitszimmer aus und ging dann mit der endgültigen Leinwand wirklich in die Stadt.

Dies ist nicht beispiellos, und tatsächlich verwenden Künstler, die mit KI-Modellen arbeiten, diese Technik bereits, um Stücke zu erstellen, die viel größer sind als das, was die KI auf einmal verarbeiten kann. Wenn Sie eine Leinwand in mehrere Teile aufteilen und alle separat hochauflösend auflösen, erhalten Sie am Ende etwas viel Größeres und Feineres; Sie können es sogar wiederholt tun. Ein interessantes Beispiel von einem mir bekannten Künstler:

Die Fortschritte, die die Google-Forscher mit Imagen behaupten, sind vielfältig. Sie sagen, dass vorhandene Textmodelle für den Textcodierungsteil verwendet werden können und dass ihre Qualität wichtiger ist als nur die Erhöhung der visuellen Wiedergabetreue. Das macht intuitiv Sinn, da ein detailliertes Bild von Unsinn definitiv schlechter ist als ein etwas weniger detailliertes Bild von genau dem, wonach Sie gefragt haben.

Zum Beispiel in der Papier Sie beschreiben Imagen und vergleichen die Ergebnisse dafür mit DALL-E 2, der „einen Panda macht, der Latte Art macht“. In allen Bildern des Letzteren ist es die Latte Art eines Pandas; In den meisten Imagens ist es ein Panda, der die Kunst macht. (Keiner von beiden war in der Lage, ein Pferd zu rendern, das einen Astronauten reitet, und zeigte bei allen Versuchen das Gegenteil. Es ist noch in Arbeit.)

Bildnachweis: Google-Forschung

In den Tests von Google hat Imagen sowohl bei der Genauigkeit als auch bei der Wiedergabetreue bei Tests zur menschlichen Bewertung die Nase vorn. Dies ist natürlich ziemlich subjektiv, aber es ist ziemlich beeindruckend, auch nur die wahrgenommene Qualität von DALL-E 2 zu erreichen, die bis heute als ein riesiger Fortschritt gegenüber allem anderen galt. Ich möchte nur hinzufügen, dass, obwohl es ziemlich gut ist, keines dieser Bilder (von irgendeinem Generator) mehr als einer oberflächlichen Prüfung standhalten wird, bevor die Leute bemerken, dass sie generiert wurden, oder ernsthaften Verdacht haben.

OpenAI ist Google jedoch in einigen Punkten ein oder zwei Schritte voraus. DALL-E 2 ist mehr als eine Forschungsarbeit, es ist eine private Beta-Version mit Leuten, die es verwenden, genau wie sie seinen Vorgänger und GPT-2 und 3 verwendet haben. Ironischerweise hat sich das Unternehmen mit „offen“ im Namen auf die Produktion seines Textes konzentriert -to-Image-Forschung, während der fabelhaft profitable Internetgigant es noch versuchen muss.

Das geht aus der Entscheidung der Forscher von DALL-E 2 mehr als hervor, den Trainingsdatensatz im Voraus zu kuratieren und alle Inhalte zu entfernen, die gegen ihre eigenen Richtlinien verstoßen könnten. Das Modell könnte nichts NSFW machen, wenn es es versuchen würde. Das Google-Team verwendete jedoch einige große Datensätze, von denen bekannt ist, dass sie unangemessenes Material enthalten. In einem aufschlussreichen Abschnitt auf der Imagen-Website, der „Einschränkungen und gesellschaftliche Auswirkungen“ beschreibt, schreiben die Forscher:

Nachgelagerte Anwendungen von Text-zu-Bild-Modellen sind vielfältig und können sich auf komplexe Weise auf die Gesellschaft auswirken. Die potenziellen Risiken des Missbrauchs geben Anlass zu Bedenken hinsichtlich einer verantwortungsvollen Open-Source-Beschaffung von Code und Demos. Zu diesem Zeitpunkt haben wir uns entschieden, keinen Code oder eine öffentliche Demo zu veröffentlichen.

Die Datenanforderungen von Text-to-Image-Modellen haben Forscher dazu veranlasst, sich stark auf große, meist unkuratierte, webgekratzte Datensätze zu verlassen. Während dieser Ansatz in den letzten Jahren schnelle algorithmische Fortschritte ermöglicht hat, spiegeln Datensätze dieser Art oft soziale Stereotype, unterdrückende Standpunkte und abfällige oder anderweitig schädliche Assoziationen mit marginalisierten Identitätsgruppen wider. Während ein Teil unserer Trainingsdaten gefiltert wurde, um Rauschen und unerwünschte Inhalte wie pornografische Bilder und giftige Sprache zu entfernen, haben wir auch den LAION-400M-Datensatz verwendet, der bekanntermaßen eine breite Palette unangemessener Inhalte enthält, darunter pornografische Bilder, rassistische Beleidigungen und schädliche soziale Stereotypen. Imagen stützt sich auf Text-Encoder, die mit nicht kuratierten Web-Scale-Daten trainiert wurden, und erbt somit die sozialen Vorurteile und Einschränkungen großer Sprachmodelle. Daher besteht das Risiko, dass Imagen schädliche Stereotype und Darstellungen kodiert hat, was unsere Entscheidung leitet, Imagen ohne weitere Sicherheitsvorkehrungen nicht für die öffentliche Nutzung freizugeben

Während einige darüber nörgeln könnten, zu sagen, dass Google befürchtet, dass seine KI politisch nicht korrekt genug ist, ist das eine lieblose und kurzsichtige Sichtweise. Ein KI-Modell ist nur so gut wie die Daten, mit denen es trainiert wurde, und nicht jedes Team kann die Zeit und Mühe aufwenden, die möglicherweise erforderlich sind, um das wirklich schreckliche Zeug zu entfernen, das diese Scraper aufsammeln, wenn sie mehrere Millionen Bilder oder mehrere Milliarden Bilder zusammenstellen. Wort Datensätze.

Solche Vorurteile sollen sich während des Forschungsprozesses zeigen, der aufdeckt, wie die Systeme funktionieren, und ein uneingeschränktes Testfeld für die Identifizierung dieser und anderer Einschränkungen bietet. Wie sonst würden wir wissen, dass eine KI keine unter Schwarzen üblichen Frisuren zeichnen kann – Frisuren, die jedes Kind zeichnen könnte? Oder dass die KI, wenn sie aufgefordert wird, Geschichten über Arbeitsumgebungen zu schreiben, den Chef unweigerlich zum Mann macht? In diesen Fällen funktioniert ein KI-Modell perfekt und wie vorgesehen – es hat erfolgreich die Vorurteile gelernt, die die Medien durchdringen, auf denen es trainiert wird. Menschen nicht unähnlich!

Aber während das Verlernen systemischer Vorurteile für viele Menschen ein lebenslanges Projekt ist, hat es eine KI leichter und ihre Ersteller können die Inhalte entfernen, die sie überhaupt erst zu ihrem schlechten Verhalten veranlasst haben. Vielleicht wird es eines Tages notwendig sein, dass eine KI im Stil eines rassistischen, sexistischen Experten aus den 50er Jahren schreibt, aber im Moment sind die Vorteile der Einbeziehung dieser Daten gering und die Risiken groß.

Auf jeden Fall befindet sich Imagen wie die anderen noch eindeutig in der Experimentierphase und ist nicht bereit, anders als unter strenger menschlicher Überwachung eingesetzt zu werden. Wenn Google dazu kommt, seine Fähigkeiten zugänglicher zu machen, werden wir sicher mehr darüber erfahren, wie und warum es funktioniert.