Google hat ein neues KI-Tool entwickelt, das Meeresbiologen dabei helfen soll, die Ökosysteme der Korallenriffe und ihren Gesundheitszustand besser zu verstehen, was wiederum bei der Aufklärung helfen kann. Das Tool, SurfBarschdas mit Google Research und DeepMind erstellt wurde, wurde anhand von Tausenden Stunden an Audioaufnahmen von Riffen trainiert. Sie ermöglichen es Wissenschaftlern, die das Riff untersuchen, „den Gesundheitszustand des Riffs von innen zu hören“, die Riffaktivität nachts zu verfolgen und Riffe in tiefen oder trüben Gewässern zu beobachten.

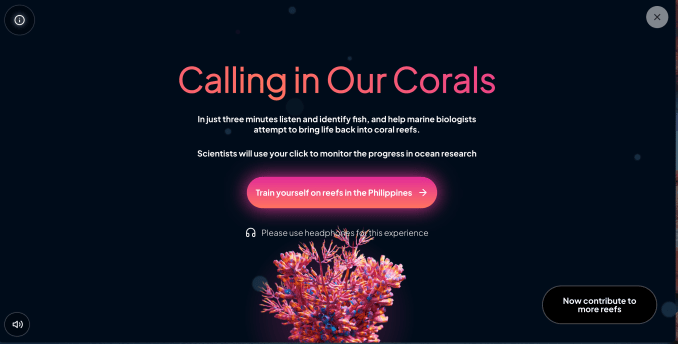

Das Projekt begann damit, dass die Öffentlichkeit eingeladen wurde, sich Riffgeräusche über das Internet anzuhören. Im vergangenen Jahr haben die Besucher von Googles Aufrufen unserer Corals-Website hörten sich über 400 Stunden Audiomaterial von Riffen aus aller Welt an und wurden aufgefordert, zu klicken, wenn sie ein Fischgeräusch hörten. Das Ergebnis war ein „bioakustischer“ Datensatz, der sich auf die Gesundheit der Riffe konzentrierte. Durch Crowdsourcing dieser Aktivität konnte Google eine Bibliothek neuer Fischgeräusche erstellen, die zur Feinabstimmung des KI-Tools SurfPerch verwendet wurden. Jetzt kann SurfPerch schnell trainiert werden, um jedes neue Riffgeräusch zu erkennen.

„Dadurch können wir neue Datensätze weitaus effizienter analysieren als bisher. Das Training auf teuren GPU-Prozessoren entfällt und wir haben neue Möglichkeiten, Riffgemeinschaften und deren Schutz zu verstehen“, bemerkt ein Google-Blogbeitrag über das Projekt. Der Beitrag wurde gemeinsam von Steve Simpson, einem Professor für Meeresbiologie an der University of Bristol in Großbritannien, und Ben Williams, einem Meeresbiologen am University College London, verfasst. Beide erforschen Korallenökosysteme mit Schwerpunkten auf Bereichen wie Klimawandel und Wiederherstellung.

Darüber hinaus stellten die Forscher fest, dass sie die Leistung des SurfPerch-Modells steigern konnten, indem sie Vogelaufnahmen. Sie fanden heraus, dass sich Vogelstimmen und Riffaufnahmen zwar stark unterscheiden, es aber zwischen Vogelgesang und Fischgeräuschen gemeinsame Muster gibt, von denen das Modell lernen konnte.

Nach der Kombination der Calling Our Corals-Daten mit SurfPerch in der ersten Versuchekonnten die Forscher Unterschiede zwischen geschützten und ungeschützten Riffen auf den Philippinen aufdecken, Restaurierungsergebnisse in Indonesien verfolgen und die Beziehungen zur Fischgemeinschaft am Great Barrier Reef besser verstehen.

Das Projekt wird heute fortgesetzt, da neue Audiodaten hinzugefügt werden Calling in Our Corals-Websitedie dabei helfen werden, das KI-Modell weiter zu trainieren, sagt Google.