Die Forschung auf dem Gebiet des maschinellen Lernens und der KI, mittlerweile eine Schlüsseltechnologie in praktisch jeder Branche und jedem Unternehmen, ist viel zu umfangreich, als dass jemand sie vollständig lesen könnte. Diese Kolumne, Perceptron, zielt darauf ab, einige der relevantesten jüngsten Entdeckungen und Artikel zu sammeln – insbesondere in, aber nicht beschränkt auf, künstliche Intelligenz – und zu erklären, warum sie wichtig sind.

Ein „hörbar“, das Sonar zum Lesen von Gesichtsausdrücken verwendet, war eines der Projekte, die uns in den letzten Wochen aufgefallen sind. Das tat es auch ProcTHOR, ein Framework des Allen Institute for AI (AI2), das prozedural Umgebungen generiert, die zum Trainieren von realen Robotern verwendet werden können. Unter den anderen Highlights hat Meta eine KI entwickelt System die die Struktur eines Proteins anhand einer einzelnen Aminosäuresequenz vorhersagen kann. Und Forscher am MIT entwickelten neue Hardware- von denen sie behaupten, dass sie schnellere Berechnungen für KI mit weniger Energie bieten.

Das „earable“, das von einem Team bei Cornell entwickelt wurde, sieht aus wie ein klobiger Kopfhörer. Lautsprecher senden akustische Signale an die Seite des Gesichts eines Trägers, während ein Mikrofon die kaum wahrnehmbaren Echos aufnimmt, die von Nase, Lippen, Augen und anderen Gesichtszügen erzeugt werden. Diese „Echoprofile“ ermöglichen es dem Earable, Bewegungen wie das Heben der Augenbrauen und das Herumhuschen der Augen zu erfassen, die ein KI-Algorithmus in vollständige Gesichtsausdrücke übersetzt.

Bildnachweis: Cornell

Das Earable hat ein paar Einschränkungen. Es hält nur drei Stunden im Akkubetrieb und muss die Verarbeitung auf ein Smartphone auslagern, und der echoübersetzende KI-Algorithmus muss mit 32 Minuten Gesichtsdaten trainieren, bevor er mit der Erkennung von Gesichtsausdrücken beginnen kann. Aber die Forscher argumentieren, dass es eine viel schlankere Erfahrung ist als die Rekorder, die traditionell in Animationen für Filme, Fernsehen und Videospiele verwendet werden. Zum Beispiel baute Rockstar Games für das Mystery-Spiel LA Noire ein Rig mit 32 Kameras, die auf das Gesicht jedes Schauspielers gerichtet waren.

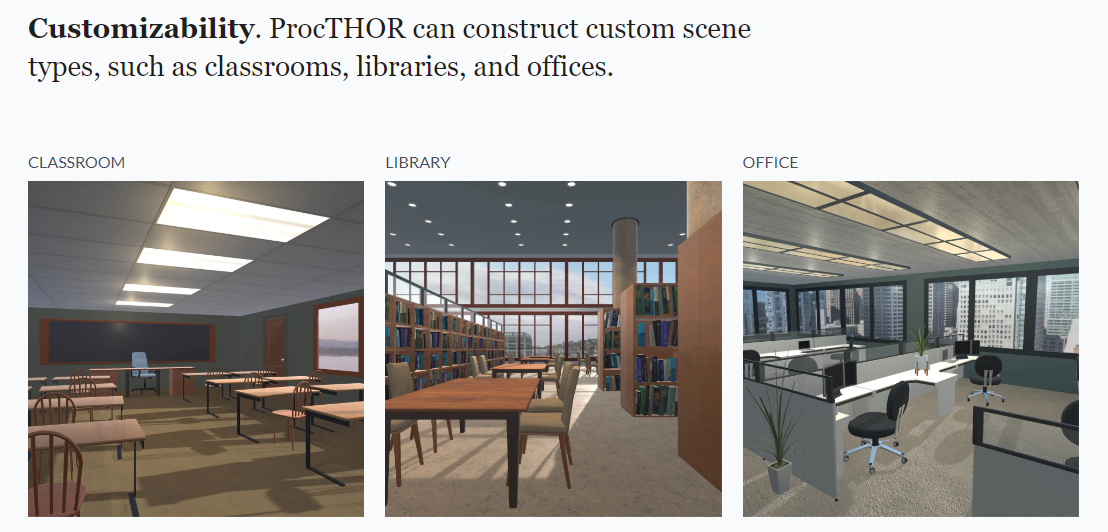

Vielleicht wird Cornells Earable eines Tages verwendet, um Animationen für humanoide Roboter zu erstellen. Aber diese Roboter müssen erst lernen, wie man sich in einem Raum zurechtfindet. Glücklicherweise geht ProcTHOR von AI2 einen Schritt (kein Wortspiel beabsichtigt) in diese Richtung und erstellt Tausende von benutzerdefinierten Szenen, darunter Klassenzimmer, Bibliotheken und Büros, in denen simulierte Roboter Aufgaben erledigen müssen, wie das Aufheben von Gegenständen und das Bewegen von Möbeln.

Die Idee hinter den Kulissen, die eine simulierte Beleuchtung aufweisen und eine Teilmenge einer riesigen Auswahl an Oberflächenmaterialien (z. B. Holz, Fliesen usw.) und Haushaltsgegenständen enthalten, besteht darin, die simulierten Roboter so viel Vielfalt wie möglich auszusetzen. Es ist eine etablierte Theorie in der KI, dass die Leistung in simulierten Umgebungen die Leistung realer Systeme verbessern kann; Unternehmen für autonome Autos wie Waymo von Alphabet simulieren ganze Nachbarschaften, um das Verhalten ihrer realen Autos zu optimieren.

Bildnachweis: Allen Institut für Künstliche Intelligenz

In Bezug auf ProcTHOR behauptet AI2 in einem Artikel, dass die Skalierung der Anzahl der Trainingsumgebungen die Leistung konsequent verbessert. Das verheißt Gutes für Roboter, die für Häuser, Arbeitsplätze und anderswo bestimmt sind.

Natürlich erfordert das Training dieser Art von Systemen viel Rechenleistung. Aber das wird vielleicht nicht ewig so sein. Forscher am MIT sagen, dass sie einen „analogen“ Prozessor entwickelt haben, der verwendet werden kann, um superschnelle Netzwerke von „Neuronen“ und „Synapsen“ zu erstellen, die wiederum verwendet werden können, um Aufgaben wie das Erkennen von Bildern, das Übersetzen von Sprachen und mehr auszuführen.

Der Prozessor der Forscher verwendet „protonisch programmierbare Widerstände“, die in einem Array angeordnet sind, um Fähigkeiten zu „lernen“. Das Erhöhen und Verringern der elektrischen Leitfähigkeit der Widerstände ahmt die Stärkung und Schwächung von Synapsen zwischen Neuronen im Gehirn nach, ein Teil des Lernprozesses.

Die Leitfähigkeit wird durch einen Elektrolyten gesteuert, der die Bewegung von Protonen steuert. Wenn mehr Protonen in einen Kanal im Widerstand geschoben werden, erhöht sich der Leitwert. Wenn Protonen entfernt werden, nimmt die Leitfähigkeit ab.

Prozessor auf einer Computerplatine

Ein anorganisches Material, Phosphorsilikatglas, macht den Prozessor des MIT-Teams extrem schnell, da es nanometergroße Poren enthält, deren Oberflächen die perfekten Wege für die Proteindiffusion bieten. Als zusätzlicher Vorteil kann das Glas bei Raumtemperatur betrieben werden und wird nicht durch die Proteine beschädigt, wenn sie sich entlang der Poren bewegen.

„Sobald Sie einen analogen Prozessor haben, werden Sie nicht länger Netzwerke trainieren, an denen alle anderen arbeiten“, wurde der Hauptautor und MIT-Postdoc Murat Onen in einer Pressemitteilung zitiert. „Sie werden Netzwerke mit beispielloser Komplexität trainieren, die sich sonst niemand leisten kann, und sie daher bei Weitem übertreffen. Mit anderen Worten, das ist kein schnelleres Auto, das ist ein Raumschiff.“

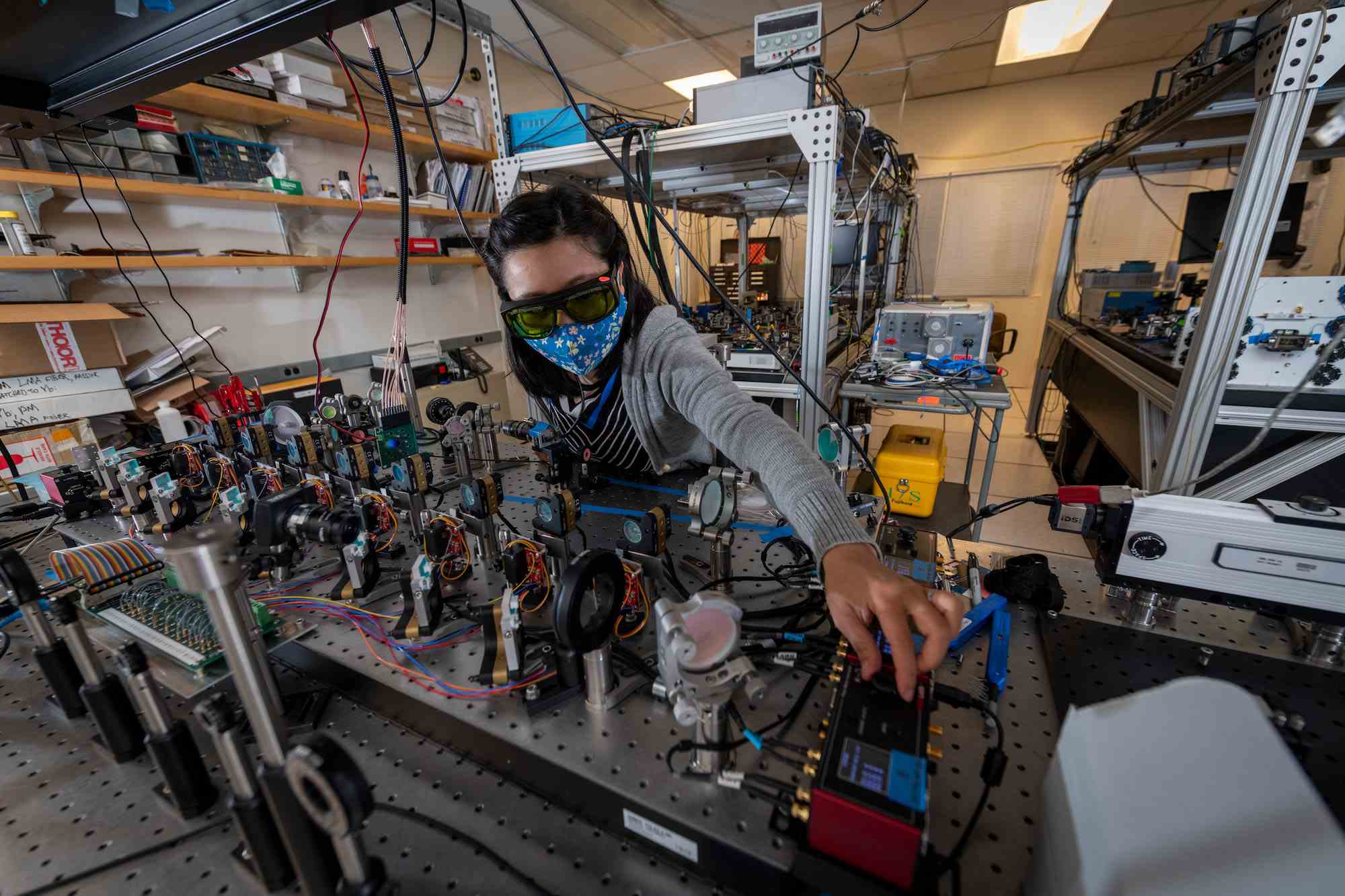

Apropos Beschleunigung: Maschinelles Lernen wird jetzt eingesetzt Betrieb von Teilchenbeschleunigern, zumindest in experimenteller Form. Am Lawrence Berkeley National Lab haben zwei Teams gezeigt, dass die ML-basierte Simulation der gesamten Maschine und des Strahls ihnen eine hochpräzise Vorhersage liefert, die bis zu zehnmal besser ist als die gewöhnliche statistische Analyse.

Bildnachweis: Thor Swift/Berkeley Lab

„Wenn Sie die Strahleigenschaften mit einer Genauigkeit vorhersagen können, die ihre Schwankungen übertrifft, können Sie die Vorhersage verwenden, um die Leistung des Beschleunigers zu steigern“, sagte Daniele Filippetto vom Labor. Es ist keine Kleinigkeit, die gesamte Physik und Ausrüstung zu simulieren, aber überraschenderweise führten die frühen Bemühungen der verschiedenen Teams, dies zu tun, zu vielversprechenden Ergebnissen.

Und drüben im Oak Ridge National Lab ermöglicht eine KI-betriebene Plattform hyperspektrale Computertomographie mit Neutronenstreuung, um optimale… vielleicht sollten wir sie einfach erklären lassen.

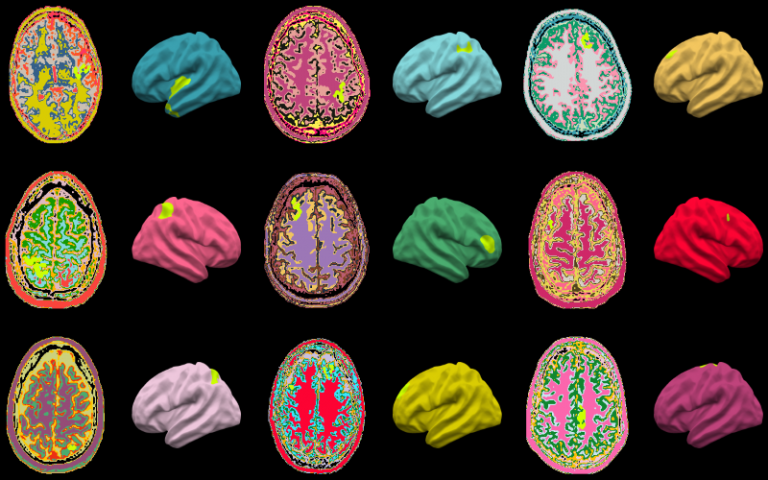

In der Medizin gibt es eine neue Anwendung der auf maschinellem Lernen basierenden Bildanalyse im Bereich der Neurologie, wo Forscher des University College London ein Modell darauf trainiert haben Erkennen Sie frühe Anzeichen von Epilepsie-verursachenden Hirnläsionen.

MRTs von Gehirnen, die zum Trainieren des UCL-Algorithmus verwendet werden.

Eine häufige Ursache für medikamentenresistente Epilepsie ist die sogenannte fokale kortikale Dysplasie, eine Hirnregion, die sich auffällig entwickelt hat, aber aus welchen Gründen auch immer im MRT nicht offensichtlich auffällig erscheint. Eine frühzeitige Erkennung kann äußerst hilfreich sein, daher trainierte das UCL-Team ein MRT-Inspektionsmodell namens Multicentre Epilepsy Lesion Detection an Tausenden von Beispielen gesunder und FCD-betroffener Gehirnregionen.

Das Modell konnte zwei Drittel der angezeigten FCDs erkennen, was eigentlich ziemlich gut ist, da die Anzeichen sehr subtil sind. Tatsächlich wurden 178 Fälle gefunden, in denen Ärzte eine FCD nicht lokalisieren konnten, es aber konnte. Das letzte Wort haben natürlich die Spezialisten, aber manchmal reicht schon ein Computer, der darauf hinweist, dass etwas nicht stimmt, um genauer hinzusehen und eine sichere Diagnose zu erhalten.

„Wir haben großen Wert darauf gelegt, einen KI-Algorithmus zu entwickeln, der interpretierbar ist und Ärzten bei der Entscheidungsfindung helfen könnte. Ärzten zu zeigen, wie der MELD-Algorithmus seine Vorhersagen trifft, war ein wesentlicher Teil dieses Prozesses“, sagte Mathilde Ripart von der UCL.