Ein finnisches Startup namens Strömungsberechnung stellt eine der kühnsten Behauptungen auf, die in der Siliziumtechnik je gehört wurden: Durch Hinzufügen des proprietären Begleitchips kann jede CPU ihre Leistung sofort verdoppeln und mit Software-Optimierungen auf das bis zu 100-Fache steigern.

Wenn es funktioniert, könnte es der Branche helfen, mit dem unersättlichen Rechenleistungsbedarf der KI-Hersteller Schritt zu halten.

Flow ist ein Nebenprodukt von VTTeine staatlich geförderte Forschungsorganisation in Finnland, die so etwas wie ein nationales Labor ist. Die Chiptechnologie, die sie kommerzialisiert und die sie als Parallel Processing Unit bezeichnet, ist das Ergebnis der Forschung, die in diesem Labor durchgeführt wurde (obwohl VTT ein Investor ist, gehört das geistige Eigentum Flow).

Flow gibt als Erster zu, dass diese Behauptung auf den ersten Blick lächerlich ist. Man kann nicht einfach auf magische Weise zusätzliche Leistung aus CPUs über verschiedene Architekturen und Codebasen hinweg herausholen. Wenn das der Fall wäre, hätten Intel oder AMD oder wer auch immer das schon vor Jahren getan.

Aber Flow hat an etwas gearbeitet, das hat wäre theoretisch möglich gewesen – es ist nur niemandem gelungen, es durchzuziehen.

Zentrale Verarbeitungseinheiten haben seit den frühen Tagen der Vakuumröhren und Lochkarten eine lange Entwicklung durchgemacht, aber in einigen grundlegenden Punkten sind sie immer noch dieselben. Ihre Hauptbeschränkung ist, dass sie als serielle und nicht als parallele Prozessoren nur eine Sache gleichzeitig tun können. Natürlich schalten sie diese Sache eine Milliarde Mal pro Sekunde zwischen mehreren Kernen und Pfaden um – aber das sind alles Möglichkeiten, um der einspurigen Natur der CPU gerecht zu werden. (Eine GPU hingegen führt viele verwandte Berechnungen gleichzeitig durch, ist aber auf bestimmte Operationen spezialisiert.)

„Die CPU ist das schwächste Glied in der Computertechnik“, sagt Flow-Mitbegründer und CEO Timo Valtonen. „Sie ist ihrer Aufgabe nicht gewachsen, und das muss sich ändern.“

CPUs sind sehr schnell geworden, aber selbst bei einer Reaktionszeit im Nanosekundenbereich kommt es bei der Ausführung von Anweisungen zu enormen Verschwendungen, einfach aufgrund der grundlegenden Einschränkung, dass eine Aufgabe abgeschlossen sein muss, bevor die nächste gestartet werden kann. (Ich vereinfache hier, da ich selbst kein Chip-Ingenieur bin.)

Flow behauptet, diese Einschränkung aufgehoben zu haben und die CPU von einer einspurigen Straße in eine mehrspurige Autobahn verwandelt zu haben. Die CPU ist zwar immer noch darauf beschränkt, jeweils eine Aufgabe zu erledigen, aber Flows PPU, wie sie es nennen, führt im Wesentlichen ein Verkehrsmanagement im Nanosekundenbereich auf dem Chip durch, um Aufgaben schneller in den Prozessor hinein und aus ihm heraus zu verschieben, als dies bisher möglich war.

Stellen Sie sich die CPU als einen Koch vor, der in der Küche arbeitet. Der Koch kann nur eine bestimmte Geschwindigkeit erreichen, aber was wäre, wenn diese Person einen übermenschlichen Assistenten hätte, der Messer und Werkzeuge in die Hände des Kochs legt, das zubereitete Essen abräumt, neue Zutaten hineingibt und alle Aufgaben übernimmt, die nicht zu den eigentlichen Kochaufgaben gehören? Der Koch hat zwar immer noch nur zwei Hände, aber jetzt kann er zehnmal so schnell arbeiten.

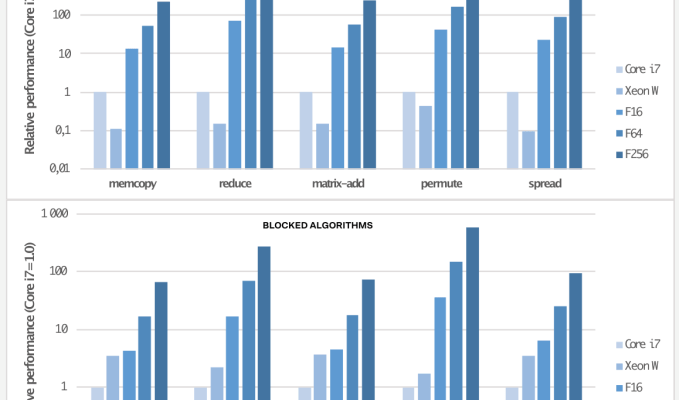

Es ist kein perfekter Vergleich, aber er gibt Ihnen eine Vorstellung davon, was hier passiert, zumindest laut Flows internen Tests und Demos mit der Branche (und sie sprechen mit allen). Die PPU erhöht weder die Taktfrequenz noch fordert sie das System auf andere Weise, was zu zusätzlicher Hitze oder Energie führen würde; mit anderen Worten, der Koch wird nicht aufgefordert, doppelt so schnell zu hacken. Sie nutzt lediglich die bereits laufenden CPU-Zyklen effizienter.

So etwas ist nichts Neues, sagt Valtonen. „Das wurde in der akademischen Welt untersucht und diskutiert. Parallelisierung ist bereits möglich, aber sie zerstört den Legacy-Code und ist dann nutzlos.“

Es könnte also gemacht werden. Es wäre nur nicht möglich gewesen, ohne den gesamten Code der Welt von Grund auf neu zu schreiben, was es zu einem aussichtslosen Unterfangen macht. Ein ähnliches Problem wurde von einem anderen nordischen Computerunternehmen, ZeroPoint, gelöst, das ein hohes Maß an Speicherkomprimierung erreichte und gleichzeitig die Datentransparenz mit dem Rest des Systems aufrechterhielt.

Die große Leistung von Flow ist also nicht die Hochgeschwindigkeitsverwaltung des Datenverkehrs, sondern die Tatsache, dass dies möglich ist, ohne dass Code auf einer getesteten CPU oder Architektur geändert werden muss. Es klingt irgendwie verrückt zu behaupten, dass beliebiger Code auf jedem Chip doppelt so schnell ausgeführt werden kann, ohne dass außer der Integration der PPU in den Chip Änderungen vorgenommen werden müssen.

Darin liegt die größte Herausforderung für Flows geschäftlichen Erfolg: Anders als bei einem Softwareprodukt muss die Technologie von Flow bereits auf der Ebene des Chipdesigns integriert werden, d. h. sie funktioniert nicht rückwirkend, und der erste Chip mit einer PPU würde zwangsläufig noch eine ganze Weile auf sich warten lassen. Flow hat gezeigt, dass die Technologie in FPGA-basierten Testaufbauten funktioniert, aber die Chiphersteller müssten ziemlich viele Ressourcen aufwenden, um die entsprechenden Vorteile zu erzielen.

Das Ausmaß dieser Gewinne und die Tatsache, dass die CPU-Verbesserungen in den letzten Jahren iterativ und geringfügig waren, könnten die Chiphersteller jedoch dazu veranlassen, ziemlich dringend an Flows Tür zu klopfen. Wenn Sie Ihre Leistung in einer Generation mit einer Layoutänderung wirklich verdoppeln können, ist das ein Kinderspiel.

Weitere Leistungssteigerungen werden durch Refactoring und Neukompilierung von Software erzielt, damit diese besser mit der PPU-CPU-Kombination funktioniert. Flow sagt, dass es Leistungssteigerungen um das bis zu Hundertfache bei Code festgestellt hat, der modifiziert (aber nicht unbedingt vollständig neu geschrieben) wurde, um die Vorteile der Technologie zu nutzen. Das Unternehmen arbeitet daran, Neukompilierungstools anzubieten, um diese Aufgabe für Softwarehersteller zu vereinfachen, die für Flow-fähige Chips optimieren möchten.

Analyst Kevin Krewell von Tirias-Forschungder über die Technologie von Flow informiert wurde und als externer Experte zu diesen Themen herangezogen wurde, machte sich mehr Sorgen über die Akzeptanz in der Branche als über die grundlegenden Dinge.

Er wies zu Recht darauf hin, dass die Beschleunigung der KI derzeit der größte Markt ist, und zwar mit Spezialchips wie Nvidias beliebtem H100. Obwohl eine PPU-beschleunigte CPU auf ganzer Linie zu Vorteilen führen würde, wollen die Chiphersteller vielleicht nicht zu sehr auf die schiefe Bahn stoßen. Und es stellt sich einfach die Frage, ob diese Unternehmen bereit sind, erhebliche Ressourcen in eine weitgehend unerprobte Technologie zu investieren, wenn sie wahrscheinlich einen Fünfjahresplan haben, der durch diese Wahl durchkreuzt würde.

Wird Flows Technologie zu einem unverzichtbaren Bestandteil für jeden Chiphersteller und wird sie damit zu Reichtum und Bekanntheit führen? Oder werden geizige Chiphersteller ihren Kurs beibehalten und weiterhin Gewinne aus dem stetig wachsenden Computermarkt ziehen? Wahrscheinlich irgendwo dazwischen – aber es ist bezeichnend, dass die Zukunft des Unternehmens, auch wenn Flow hier eine große technische Meisterleistung vollbracht hat, wie bei allen Startups von seinen Kunden abhängt.

Flow kommt gerade aus der Versenkung hervor und verfügt über eine Vorfinanzierung in Höhe von 4 Millionen Euro (ca. 4,3 Millionen US-Dollar) unter der Leitung von Butterfly Ventures mit Beteiligung von FOV Ventures, Sarsia, Stephen Industries, Superhero Capital und Business Finland.