Die fortschrittlichsten KI-Systeme von heute sind zu beeindruckenden Leistungen fähig, von der Lenkung von Autos durch die Straßen der Stadt bis hin zum Schreiben menschenähnlicher Prosa. Aber sie haben einen gemeinsamen Engpass: Hardware. Die Entwicklung modernster Systeme erfordert oft eine enorme Rechenleistung. Beispielsweise war für die Erstellung von DeepMinds Proteinstruktur-Vorhersage AlphaFold ein Cluster von Hunderten von GPUs erforderlich. Um die Herausforderung weiter zu unterstreichen, eine Quelle Schätzungen dass die Entwicklung des spracherzeugenden GPT-3-Systems des KI-Startups OpenAI mit einer einzigen GPU 355 Jahre gedauert hätte.

Neue Techniken und Chips, die bestimmte Aspekte der KI-Systementwicklung beschleunigen sollen, versprechen (und haben dies bereits getan) eine Reduzierung der Hardwareanforderungen. Aber die Entwicklung mit diesen Techniken erfordert Fachwissen, das für kleinere Unternehmen schwer zu bekommen ist. Das ist zumindest die Behauptung von Varun Mohan und Douglas Chen, den Mitbegründern des Infrastruktur-Startups Exafunktion. Exafunction ist heute aus dem Stealth-Bereich hervorgegangen und entwickelt eine Plattform, um die Komplexität der Verwendung von Hardware zum Trainieren von KI-Systemen zu abstrahieren.

„Verbesserungen [in AI] werden oft durch große Steigerungen der … Rechenkomplexität untermauert. Infolgedessen sind Unternehmen gezwungen, große Investitionen in Hardware zu tätigen, um die Vorteile von Deep Learning zu nutzen. Das ist sehr schwierig, weil sich die Technologie so schnell verbessert und die Workload-Größe schnell zunimmt, da sich Deep Learning innerhalb eines Unternehmens als wertvoll erweist“, sagte Chen in einem E-Mail-Interview mit Tech. „Die spezialisierten Beschleunigerchips, die für die Durchführung von Deep-Learning-Berechnungen in großem Maßstab erforderlich sind, sind rar. Die effiziente Nutzung dieser Chips erfordert auch esoterisches Wissen, das unter Deep-Learning-Praktizierenden ungewöhnlich ist.“

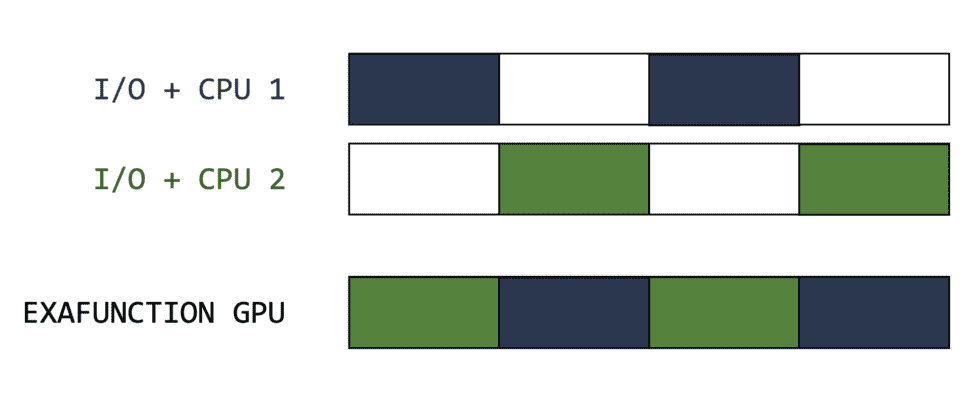

Mit 28 Millionen US-Dollar an Risikokapital, von denen 25 Millionen US-Dollar aus einer von Greenoaks geleiteten Serie-A-Runde mit Beteiligung des Founders Fund stammten, zielt Exafunction darauf ab, das anzugehen, was es als Symptom des Mangels an Fachwissen in der KI ansieht: ungenutzte Hardware. GPUs und die oben erwähnten spezialisierten Chips, die zum „Trainieren“ von KI-Systemen verwendet werden – d. h. zum Einspeisen der Daten, die die Systeme verwenden können, um Vorhersagen zu treffen – werden häufig zu wenig genutzt. Da sie einige KI-Arbeitslasten so schnell erledigen, sitzen sie im Leerlauf, während sie darauf warten, dass andere Komponenten des Hardware-Stacks, wie Prozessoren und Speicher, aufholen.

Lukas Beiwald, Gründer der KI-Entwicklungsplattform Weights and Biases, Berichte dass fast ein Drittel der Kunden seines Unternehmens im Durchschnitt weniger als 15 % GPU-Auslastung haben. Inzwischen in einem 2021 Umfrage Im Auftrag von Run:AI, das mit Exafunction konkurriert, gaben nur 17 % der Unternehmen an, dass sie eine „hohe Auslastung“ ihrer KI-Ressourcen erreichen konnten, während 22 % angaben, dass ihre Infrastruktur größtenteils ungenutzt ist.

Die Kosten summieren sich. Nach bis Run:AI hatten 38 % der Unternehmen ein Jahresbudget für KI-Infrastruktur – einschließlich Hardware-, Software- und Cloud-Gebühren – von über 1 Million US-Dollar (Stand Oktober 2021). OpenAI ist es geschätzt 4,6 Millionen Dollar für das Training von GPT-3 ausgegeben haben.

„Die meisten Unternehmen, die im Bereich Deep Learning tätig sind, gehen ins Geschäft, damit sie sich auf ihre Kerntechnologie konzentrieren können, anstatt ihre Zeit und Bandbreite damit zu verschwenden, sich Gedanken über die Optimierung von Ressourcen zu machen“, sagte Mohan per E-Mail. „Wir glauben, dass es keinen bedeutenden Konkurrenten gibt, der das Problem angeht, auf das wir uns konzentrieren, nämlich die Herausforderungen der Verwaltung beschleunigter Hardware wie GPUs zu abstrahieren und gleichzeitig den Kunden eine überlegene Leistung zu bieten.“

Keim einer Idee

Vor der Mitbegründung von Exafunction war Chen Softwareentwickler bei Facebook, wo er beim Aufbau der Tools für Geräte wie Oculus Quest half. Mohan war technischer Leiter beim autonomen Bereitstellungs-Startup Nuro und verantwortlich für die Verwaltung der autonomen Infrastrukturteams des Unternehmens.

„Als unsere Deep-Learning-Workloads [at Nuro] immer komplexer und anspruchsvoller wurde, wurde deutlich, dass es keine klare Lösung gab, um unsere Hardware entsprechend zu skalieren“, sagte Mohan. „Simulation ist ein seltsames Problem. Paradoxerweise müssen Sie mit der Verbesserung Ihrer Software noch mehr Iterationen simulieren, um Eckfälle zu finden. Je besser Ihr Produkt ist, desto schwieriger müssen Sie nach Fehlern suchen. Wir haben auf die harte Tour gelernt, wie schwierig das war, und haben Tausende von Entwicklungsstunden damit verbracht, mehr Leistung aus den vorhandenen Ressourcen herauszuholen.“

Bildnachweis: Exafunktion

Kunden von Exafunction verbinden sich mit dem Managed Service des Unternehmens oder stellen die Software von Exafunction in einem Kubernetes-Cluster bereit. Die Technologiehttps://www.exafunction.com/ weist Ressourcen dynamisch zu und verlagert die Berechnung auf „kostengünstige Hardware“ wie z. B. Spot-Instances, sofern verfügbar.

Mohan und Chen zögerten, als sie nach dem Innenleben der Exafunction-Plattform gefragt wurden, und zogen es vor, diese Details vorerst unter Verschluss zu halten. Aber sie erklärten, dass Exafunction auf hohem Niveau Hebelwirkungen hat Virtualisierung KI-Workloads auch bei eingeschränkter Hardwareverfügbarkeit auszuführen, was angeblich zu besseren Auslastungsraten bei gleichzeitiger Kostensenkung führt.

Die Zurückhaltung von Exafunction, Informationen über seine Technologie preiszugeben – einschließlich der Frage, ob es Cloud-gehostete Beschleunigerchips wie die Tensor Processing Units (TPUs) von Google unterstützt – gibt Anlass zur Sorge. Aber um Zweifel auszuräumen, sagte Mohan, ohne Namen zu nennen, dass Exafunction bereits GPUs für „einige der fortschrittlichsten Unternehmen und Organisationen für autonome Fahrzeuge an der Spitze der Computervision“ verwaltet.

„Exafunction bietet eine Plattform, die Workloads von Beschleunigungshardware wie GPUs entkoppelt und so eine maximal effiziente Nutzung gewährleistet – Kosten senkt, Leistung beschleunigt und es Unternehmen ermöglicht, voll von f-Hardware zu profitieren … [The] Mit der Plattform können Teams ihre Arbeit auf einer einzigen Plattform konsolidieren, ohne die

Herausforderungen beim Zusammenfügen unterschiedlicher Softwarebibliotheken“, fügte er hinzu. „Das erwarten wir [Exafunction’s product] wird zutiefst marktfähig sein und für Deep Learning das tun, was AWS für Cloud Computing getan hat.“

Wachsender Markt

Mohan mag grandiose Pläne für Exafunction haben, aber das Startup ist nicht das einzige, das das Konzept der „intelligenten“ Infrastrukturzuweisung auf KI-Workloads anwendet. Beyond Run:AI – dessen Produkt auch eine Abstraktionsschicht zur Optimierung der KI-Workloads erstellt – Grid.ai bietet an Software, die es Datenwissenschaftlern ermöglicht, KI-Modelle hardwareübergreifend parallel zu trainieren. Nvidia seinerseits verkauft KI-Unternehmeneine Suite von Tools und Frameworks, mit der Unternehmen KI-Workloads auf Nvidia-zertifizierten Servern virtualisieren können.

Aber Mohan und Chen sehen trotz der Überfüllung einen riesigen adressierbaren Markt. Im Gespräch positionierten sie die abonnementbasierte Plattform von Exafunction nicht nur als eine Möglichkeit, Hindernisse für die KI-Entwicklung abzubauen, sondern auch Unternehmen, die mit Einschränkungen in der Lieferkette konfrontiert sind, zu ermöglichen, „mehr Wert“ aus vorhandener Hardware freizusetzen. (In den letzten Jahren sind GPUs aus verschiedenen Gründen zu heiß begehrten Produkten geworden.) Es gibt immer die Cloud, aber nach Ansicht von Mohan und Chen kann sie die Kosten in die Höhe treiben. Ein schätzen fanden heraus, dass das Trainieren eines KI-Modells mit lokaler Hardware bis zu 6,5-mal günstiger ist als die kostengünstigste cloudbasierte Alternative.

„Während Deep Learning praktisch endlose Anwendungen hat, sind zwei der Anwendungen, die uns am meisten begeistern, die autonome Fahrzeugsimulation und die Videoinferenz in großem Maßstab“, sagte Mohan. „Simulation ist das Herzstück aller Softwareentwicklung und -validierung in der autonomen Fahrzeugindustrie … Deep Learning hat auch zu außergewöhnlichen Fortschritten in der automatisierten Videoverarbeitung geführt, mit Anwendungen in einer Vielzahl von Branchen. [But] Obwohl GPUs für autonome Fahrzeugunternehmen unerlässlich sind, wird ihre Hardware trotz ihres Preises und ihrer Knappheit häufig nicht ausgelastet. [Computer vision applications are] auch rechenintensiv, [because] Jeder neue Videostream stellt effektiv eine Flut von Daten dar – wobei jede Kamera Millionen von Bildern pro Tag ausgibt.“

Mohan und Chen sagen, dass das Kapital aus der Serie A in die Erweiterung des Exafunction-Teams und die „Vertiefung“ des Produkts gesteckt wird. Das Unternehmen wird auch in die Optimierung der Laufzeiten von KI-Systemen „für die latenzempfindlichsten Anwendungen“ (z. B. autonomes Fahren und Computer Vision) investieren.

„Obwohl wir derzeit ein starkes und wendiges Team sind, das sich hauptsächlich auf die Technik konzentriert, erwarten wir, dass wir die Größe und die Fähigkeiten unserer Organisation im Jahr 2022 schnell ausbauen werden“, sagte Mohan. „In praktisch allen Branchen ist klar, dass die Nachfrage nach Rechenleistung mit zunehmender Komplexität der Workloads (und einer wachsenden Zahl von Unternehmen, die Deep-Learning-Erkenntnisse nutzen möchten) bei weitem zunimmt [supply]. Während die Pandemie diese Bedenken deutlich gemacht hat, werden sich dieses Phänomen und die damit verbundenen Engpässe in den kommenden Jahren noch verschärfen, insbesondere da hochmoderne Modelle exponentiell anspruchsvoller werden.“