Ein neues, leistungsstarkes KI-Modell zur Videogenerierung ist seit heute allgemein verfügbar – die Sache hat allerdings einen Haken: Das Modell zensiert offenbar Themen, die die Regierung seines Ursprungslandes China als politisch zu sensibel erachtet.

Das Model, Klingentwickelt von der in Peking ansässigen Firma Kuaishou, wurde Anfang des Jahres für Benutzer mit einer chinesischen Telefonnummer als Warteliste eingeführt. Heute ist es für jeden verfügbar, der bereit ist, seine E-Mail-Adresse anzugeben. Nach der Anmeldung können Benutzer Eingabeaufforderungen eingeben, damit das Modell fünfsekündige Videos ihrer Beschreibungen generiert.

Kling funktioniert so ziemlich wie angekündigt. Seine 720p-Videos, deren Generierung ein bis zwei Minuten dauert, weichen nicht allzu sehr von den Vorgaben ab. Und Kling scheint physikalische Phänomene wie das Rascheln von Blättern und fließendes Wasser ungefähr so gut zu simulieren wie Videogenerierungsmodelle wie Gen-3 des KI-Startups Runway und Sora von OpenAI.

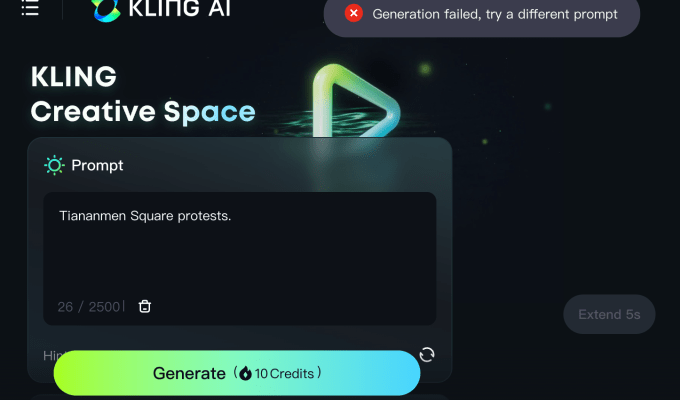

Aber Kling geradezu Gewohnheit Clips zu bestimmten Themen erstellen. Eingabeaufforderungen wie „Demokratie in China“, „Der chinesische Präsident Xi Jinping auf der Straße“ und „Proteste auf dem Platz des Himmlischen Friedens“ führen zu einer unspezifischen Fehlermeldung.

Die Filterung scheint nur auf der Eingabeaufforderungsebene zu erfolgen. Kling unterstützt die Animation von Standbildern und generiert beispielsweise problemlos ein Video mit einem Porträt von Jinping, solange die zugehörige Eingabeaufforderung Jinping nicht namentlich erwähnt (z. B. „Dieser Mann hält eine Rede“).

Wir haben Kuaishou um einen Kommentar gebeten.

Klings merkwürdiges Verhalten ist wahrscheinlich das Ergebnis des starken politischen Drucks der chinesischen Regierung auf generative KI-Projekte in der Region.

Anfang des Monats schrieb die Financial Times gemeldet dass KI-Modelle in China von Chinas führender Internet-Regulierungsbehörde, der Cyberspace Administration of China (CAC), getestet werden, um sicherzustellen, dass ihre Antworten zu sensiblen Themen „zentrale sozialistische Werte verkörpern“. Laut dem Bericht der Financial Times sollen die Modelle von CAC-Beamten anhand ihrer Antworten auf eine Reihe von Fragen bewertet werden – viele davon beziehen sich auf Jinping und Kritik an der Kommunistischen Partei.

Berichten zufolgeist das CAC sogar so weit gegangen, eine schwarze Liste von Quellen vorzuschlagen, die nicht zum Trainieren von KI-Modellen verwendet werden können. Unternehmen, die Modelle zur Überprüfung einreichen muss Bereiten Sie Zehntausende von Fragen vor, um zu testen, ob die Modelle „sichere“ Antworten liefern.

Das Ergebnis sind KI-Systeme, die sich weigern, auf Themen zu reagieren, die den Zorn der chinesischen Regulierungsbehörden erregen könnten. Letztes Jahr schrieb die BBC gefunden dass Ernie, das Vorzeigemodell des KI-Chatbots des chinesischen Unternehmens Baidu, zurückhaltend war und auswich, wenn ihm Fragen gestellt wurden, die als politisch kontrovers empfunden werden könnten, wie etwa „Ist Xinjiang ein guter Ort?“ oder „Ist Tibet ein guter Ort?“

Die drakonischen Maßnahmen drohen langsam Chinas KI macht Fortschritte. Sie erfordert nicht nur das Durchforsten von Daten, um politisch sensible Informationen zu entfernen, sondern erfordert auch eine enorme Entwicklungszeit für die Schaffung ideologischer Leitplanken – Leitplanken, die immer noch versagen können, wie Kling veranschaulicht.

Aus Anwendersicht führen Chinas KI-Vorschriften bereits zu zwei Klassen von Modellen: Einige sind durch intensive Filterung eingeschränkt, andere deutlich weniger. Ist das wirklich eine gute Sache für das breitere KI-Ökosystem?