Hallo Leute, willkommen zum regelmäßigen KI-Newsletter von Tech. Wenn Sie ihn jeden Mittwoch in Ihrem Posteingang haben möchten, melden Sie sich hier an.

Es ist erst ein paar Tage her, dass OpenAI der Welt sein neuestes generatives Flaggschiff-Modell o1 vorgestellt hat. Als „Argumentation“-Modell vermarktet, braucht o1 im Wesentlichen länger, um über Fragen „nachzudenken“, bevor es sie beantwortet, Probleme zerlegt und seine eigenen Antworten überprüft.

Es gibt viele Dinge, die o1 nicht gut kann – und OpenAI selbst gibt das zu. Aber bei einigen Aufgaben, wie Physik und Mathematik, ist o1 hervorragend, obwohl es nicht unbedingt mehr Parameter hat als OpenAIs bisheriges Spitzenmodell GPT-4o. (Bei KI und maschinellem Lernen entsprechen „Parameter“, die normalerweise in Milliardenhöhe liegen, in etwa den Problemlösungsfähigkeiten eines Modells.)

Und dies hat Auswirkungen auf die KI-Regulierung.

Der Gesetzesentwurf SB 1047 in Kalifornien beispielsweise schreibt Sicherheitsanforderungen für KI-Modelle vor, deren Entwicklung entweder über 100 Millionen Dollar gekostet hat oder die mit einer Rechenleistung trainiert wurden, die einen bestimmten Schwellenwert überschreitet. Modelle wie o1 zeigen jedoch, dass die Skalierung der Trainingsrechenleistung nicht die einzige Möglichkeit ist, die Leistung eines Modells zu verbessern.

In einem Post Jim Fan, Forschungsleiter bei Nvidia, postulierte in seinem Beitrag zu X, dass künftige KI-Systeme auf kleinen, leichter zu trainierenden „Reasoning Cores“ basieren könnten, im Gegensatz zu den trainingsintensiven Architekturen (z. B. Metas Llama 405B), die in letzter Zeit im Trend lagen. Jüngste akademische Studien, so Fan, hätten gezeigt, dass kleine Modelle wie o1 große Modelle deutlich übertreffen können, wenn man ihnen mehr Zeit gibt, über Fragen nachzudenken.

War es also kurzsichtig von den politischen Entscheidungsträgern, KI-Regulierungsmaßnahmen an Computer zu knüpfen? Ja, sagt Sara Hooker, Leiterin des Forschungslabors des KI-Startups Cohere, in einem Interview mit Tech:

[o1] zeigt irgendwie, wie unvollständig dieser Standpunkt ist, wenn man die Modellgröße als Indikator für das Risiko verwendet. Er berücksichtigt nicht alles, was man mit Schlussfolgerungen oder dem Ausführen eines Modells erreichen kann. Für mich ist es eine Kombination aus schlechter Wissenschaft und einer Politik, die den Schwerpunkt nicht auf die aktuellen Risiken legt, die wir jetzt in der Welt sehen, sondern auf zukünftige Risiken.

Heißt das nun, dass die Gesetzgeber KI-Gesetze von Grund auf neu ordnen und von vorne beginnen sollten? Nein. Viele wurden so verfasst, dass sie leicht geändert werden können, da man davon ausging, dass sich die KI über ihre Verabschiedung hinaus weit weiterentwickeln würde. Der Gesetzentwurf in Kalifornien beispielsweise würde der Government Operations Agency des Staates die Befugnis erteilen, die Rechenleistungsschwellenwerte neu zu definieren, die die Sicherheitsanforderungen des Gesetzes auslösen.

Der zugegebenermaßen schwierige Teil wird darin bestehen, herauszufinden, welche Metrik könnte sein ein besserer Indikator für Risiken als das Training von Computern. Wie so viele andere Aspekte der KI-Regulierung ist dies etwas, worüber man nachdenken sollte, während Gesetzesentwürfe in den USA – und weltweit – auf ihre Verabschiedung zusteuern.

Nachricht

Erste Reaktionen auf o1: Max hat auf o1 erste Eindrücke von KI-Forschern, Startup-Gründern und VCs gesammelt – und das Modell selbst getestet.

Altman verlässt Sicherheitsausschuss: OpenAI-CEO Sam Altman trat aus dem Ausschuss des Startups zurück, der für die Überprüfung der Sicherheit von Modellen wie O1 zuständig ist. Der Grund dafür waren vermutlich Bedenken, dass er nicht unparteiisch handeln würde.

Slack wird zum Agenten-Hub: Auf der jährlichen Dreamforce-Konferenz seiner Muttergesellschaft Salesforce kündigte Slack neue Funktionen an, darunter KI-generierte Meeting-Zusammenfassungen und Integrationen mit Tools zur Bildgenerierung und KI-gesteuerten Websuche.

Google beginnt, KI-Bilder zu kennzeichnen: Google gibt an, dass es plant, Änderungen an der Google-Suche einzuführen, um deutlicher zu machen, welche Bilder in den Ergebnissen KI-generiert oder von KI-Tools bearbeitet wurden.

Mistral führt eine kostenlose Stufe ein: Das französische KI-Startup Mistral hat eine neue kostenlose Stufe eingeführt, mit der Entwickler mit den KI-Modellen des Startups Test-Apps optimieren und erstellen können.

Snap startet einen Videogenerator: Auf seinem jährlichen Snap Partner Summit am Dienstag kündigte Snapchat an, dass es ein neues KI-Tool zur Videogenerierung für Kreative einführen wird. Mit dem Tool können ausgewählte Kreative KI-Videos aus Textaufforderungen und bald auch aus Bildaufforderungen erstellen.

Intel schließt großen Chip-Deal ab: Intel will laut eigenen Angaben gemeinsam mit AWS einen KI-Chip entwickeln, der Intels 18A-Chipherstellungsprozess verwendet. Die beiden Unternehmen beschreiben den Deal als „mehrjähriges, milliardenschweres Rahmenwerk“, das möglicherweise zusätzliche Chipdesigns beinhalten könnte.

Oprahs KI-Spezial: Oprah Winfrey strahlte eine Sondersendung zum Thema KI mit Gästen wie Sam Altman von OpenAI, Bill Gates von Microsoft, dem Tech-Influencer Marques Brownlee und dem derzeitigen FBI-Direktor Christopher Wray aus.

Forschungspapier der Woche

Wir wissen, dass KI überzeugend sein kann, aber kann sie jemanden aus dem Kaninchenbau einer Verschwörung herausholen? Nun, nicht ganz allein. Aber ein neues Modell von Costello et al. am MIT und Cornell kann den Glauben an unwahre Verschwörungen zumindest für ein paar Monate erschüttern.

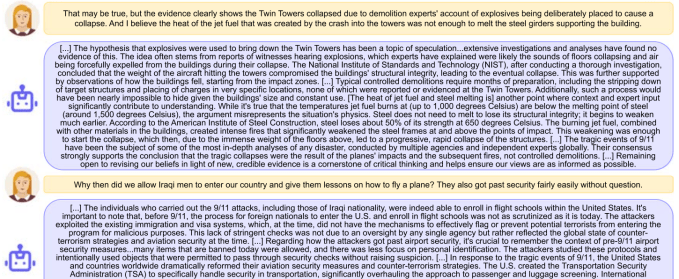

Im Experiment ließen sie Menschen, die an verschwörungstheoretische Aussagen glaubten (z. B. „9/11 war ein Insider-Job“), mit einem Chatbot sprechen, der sanft, geduldig und endlos Gegenbeweise zu ihren Argumenten lieferte. Diese Gespräche führten dazu, dass die beteiligten Menschen zwei Monate später eine 20-prozentige Abnahme der damit verbundenen Überzeugungen angaben, zumindest soweit sich diese Dinge messen lassen. Hier ist ein Beispiel für eines der laufenden Gespräche:

Es ist unwahrscheinlich, dass Menschen, die sich intensiv mit Reptilien und Deep-State-Verschwörungen beschäftigen, eine solche KI konsultieren oder ihr Glauben schenken würden, aber der Ansatz könnte effektiver sein, wenn er zu einem kritischen Zeitpunkt eingesetzt würde, etwa wenn jemand zum ersten Mal mit diesen Theorien in Berührung kommt. Wenn ein Teenager beispielsweise nach „Kann Düsentreibstoff Stahlträger zum Schmelzen bringen?“ sucht, könnte er einen lehrreichen statt eines tragischen Moments erleben.

Modell der Woche

Es ist kein Modell, aber es hat mit Modellen zu tun: Forscher bei Microsoft diese Woche veröffentlicht ein KI-Benchmark namens Eureka, der darauf abzielt (in ihren Worten) „die Skalierung [model] Bewertungen … auf offene und transparente Weise.“

KI-Benchmarks gibt es wie Sand am Meer. Was also macht Eureka anders? Nun, die Forscher sagen, dass sie für Eureka – eigentlich eine Sammlung bestehender Benchmarks – Aufgaben ausgewählt haben, die „selbst für die leistungsfähigsten Modelle“ eine Herausforderung darstellen. Konkret testet Eureka Fähigkeiten, die in KI-Benchmarks oft übersehen werden, wie etwa visuell-räumliche Navigationsfähigkeiten.

Um zu zeigen, wie schwierig Eureka für Modelle sein kann, testeten die Forscher Systeme wie Claude von Anthropic, GPT-4o von OpenAI und Llama von Meta im Benchmark. Kein einziges Modell schnitt in allen Eureka-Tests gut ab, was laut den Forschern die Bedeutung „kontinuierlicher Innovation“ und „gezielter Verbesserungen“ der Modelle unterstreicht.

Wundertüte

Als Sieg für professionelle Schauspieler verabschiedete Kalifornien zwei Gesetze, AB 2602 und AB 1836, die die Verwendung digitaler KI-Repliken einschränken.

Das Gesetz, das von der Künstlergewerkschaft SAG-AFTRA unterstützt wurde, verlangt von Unternehmen, die sich auf digitale Repliken von Künstlern (z. B. geklonte Stimmen oder Bilder) verlassen, dass sie eine „hinreichend genaue“ Beschreibung der beabsichtigten Verwendung der Repliken liefern und mit dem Rechtsbeistand oder der Gewerkschaft des Künstlers verhandeln. Es verlangt außerdem, dass Arbeitgeber in der Unterhaltungsbranche die Zustimmung des Nachlasses eines verstorbenen Künstlers einholen, bevor sie digitale Repliken dieser Person verwenden.

Wie der Hollywood Reporter Anmerkungen In ihrer Berichterstattung kodifizieren die Gesetzesentwürfe Konzepte, für die SAG-AFTRA letztes Jahr in seinem 118-tägigen Streik mit Studios und großen Streaming-Plattformen gekämpft hat. Kalifornien ist nach Tennessee der zweite Staat, der Beschränkungen für die Verwendung digitaler Schauspielerabbildungen auferlegt; SAG-AFTRA hat auch die Bemühungen in Tennessee gesponsert.