Hallo Leute, und willkommen zum ersten KI-Newsletter von Tech. Es ist wirklich aufregend, diese Worte zu tippen – die Erstellung dieses Newsletters hat lange gedauert, und wir freuen uns, ihn nun endlich mit Ihnen teilen zu können.

Mit dem Start des KI-Newsletters von TC beenden wir This Week in AI, die halbregelmäßige Kolumne, die früher als Perceptron bekannt war. Aber Sie finden alle Analysen, die wir in This Week in AI veröffentlicht haben, und mehreinschließlich eines Spotlights auf bemerkenswerte neue KI-Modelle, genau hier.

Diese Woche braut sich im Bereich KI erneut Ärger für OpenAI zusammen.

Eine Gruppe ehemaliger OpenAI-Mitarbeiter gesprochen mit Kevin Roose von der New York Times über die ihrer Meinung nach eklatanten Sicherheitsmängel innerhalb der Organisation. Sie – wie auch andere, die OpenAI in den letzten Monaten verlassen haben – behaupten, dass das Unternehmen nicht genug unternimmt, um zu verhindern, dass seine KI-Systeme potenziell gefährlich werden, und werfen OpenAI vor, mit harten Mitteln zu versuchen, die Mitarbeiter davon abzuhalten, Alarm zu schlagen.

Die Gruppe veröffentlichte am Dienstag einen offenen Brief, in dem sie führende KI-Unternehmen, darunter OpenAI, aufforderte, für mehr Transparenz und mehr Schutz für Whistleblower zu sorgen. „Solange es keine wirksame staatliche Aufsicht über diese Unternehmen gibt, gehören derzeitige und ehemalige Mitarbeiter zu den wenigen Menschen, die sie gegenüber der Öffentlichkeit zur Rechenschaft ziehen können“, heißt es in dem Brief.

Nennen Sie mich pessimistisch, aber ich gehe davon aus, dass die Forderungen der ehemaligen Mitarbeiter auf taube Ohren stoßen werden. Es ist schwer, sich ein Szenario vorzustellen, in dem KI-Unternehmen nicht nur zustimmen, „eine Kultur der offenen Kritik zu fördern“, wie die Unterzeichner empfehlen, sondern sich auch dazu entschließen, keine Nichtverunglimpfungsklauseln durchzusetzen oder Vergeltungsmaßnahmen gegen derzeitige Mitarbeiter zu ergreifen, die sich zu Wort melden.

Bedenken Sie, dass die Sicherheitskommission von OpenAI, die das Unternehmen kürzlich als Reaktion auf anfänglich Kritik an den Sicherheitspraktiken, ist mit Insidern des Unternehmens besetzt – einschließlich CEO Sam Altman. Und bedenken Sie, dass Altman, der einmal behauptete, keine Kenntnis von den restriktiven Nichtverunglimpfungsvereinbarungen von OpenAI zu haben, sich selbst unterzeichnet die Gründungsdokumente, aus denen sie hervorgehen.

Klar, bei OpenAI könnte sich morgen alles zum Guten wenden – aber ich bin da nicht so zuversichtlich. Und selbst wenn, wäre es schwer, darauf zu vertrauen.

Nachricht

KI-Apokalypse: Die KI-gestützte Chatbot-Plattform ChatGPT von OpenAI sowie Claude von Anthropic und Gemini und Perplexity von Google sind heute Morgen alle ungefähr zur gleichen Zeit ausgefallen. Alle Dienste wurden inzwischen wiederhergestellt, aber die Ursache für die Ausfallzeit bleibt unklar.

OpenAI erforscht Fusion: Laut Wall Street Journal verhandelt OpenAI derzeit mit dem Fusions-Startup Helion Energy über einen Deal, bei dem das KI-Unternehmen große Mengen Strom von Helion kaufen würde, um seine Rechenzentren mit Strom zu versorgen. Altman besitzt einen Anteil von 375 Millionen Dollar an Helion und sitzt im Aufsichtsrat des Unternehmens, hat sich jedoch Berichten zufolge von den Verhandlungen zurückgezogen.

Die Kosten für Trainingsdaten: Tech wirft einen Blick auf die teuren Datenlizenzverträge, die in der KI-Branche immer üblicher werden – Verträge, die die KI-Forschung für kleinere Organisationen und akademische Einrichtungen untragbar machen könnten.

Generatoren für hasserfüllte Musik: Böswillige Akteure missbrauchen KI-gestützte Musikgeneratoren, um homophobe, rassistische und propagandistische Lieder zu erstellen – und veröffentlichen Anleitungen, in denen sie anderen erklären, wie das ebenfalls möglich ist.

Bargeld für Cohere: Reuters berichtet, dass Cohere, ein auf Unternehmen ausgerichtetes generatives KI-Startup, 450 Millionen US-Dollar von Nvidia, Salesforce Ventures, Cisco und anderen in einer neuen Tranche eingesammelt hat, die Cohere mit 5 Milliarden US-Dollar bewertet. Quellen, die mit Tech vertraut sind, berichten, dass auch Oracle und Thomvest Ventures – beides wiederkehrende Investoren – an der Runde teilgenommen haben, die offen gelassen wurde.

Forschungspapier der Woche

In einem Forschungsbericht ab 2023 mit dem Titel „Let’s Verify Step by Step“, dass OpenAI vor kurzem hervorgehoben Auf dem offiziellen Blog von OpenAI behaupteten Wissenschaftler, sie hätten das generative KI-Allzweckmodell des Startups, GPT-4, so optimiert, dass es bei der Lösung mathematischer Probleme eine bessere Leistung als erwartet erzielt habe. Der Ansatz könnte dazu führen, dass generative Modelle weniger anfällig dafür sind, aus dem Ruder zu laufen, sagen die Co-Autoren des Papiers – sie weisen jedoch auf mehrere Vorbehalte hin.

In dem Artikel beschreiben die Co-Autoren im Detail, wie sie Belohnungsmodelle trainiert haben, um Halluzinationen oder Fälle zu erkennen, in denen GPT-4 seine Fakten und/oder Antworten auf mathematische Probleme falsch hatte. (Belohnungsmodelle sind spezialisierte Modelle zur Bewertung der Ergebnisse von KI-Modellen, in diesem Fall mathematikbezogene Ergebnisse von GPT-4.) Die Belohnungsmodelle „belohnten“ GPT-4 jedes Mal, wenn es einen Schritt eines mathematischen Problems richtig beantwortete, ein Ansatz, den die Forscher als „Prozessüberwachung“ bezeichnen.

Die Forscher sagen, dass die Prozessüberwachung die Genauigkeit von GPT-4 bei mathematischen Problemen im Vergleich zu früheren Techniken zur „Belohnung“ von Modellen verbessert hat – zumindest in ihren Benchmarktests. Sie geben jedoch zu, dass es nicht perfekt ist; GPT-4 hat Problemschritte immer noch falsch gelöst. Und es ist unklar, wie sich die von den Forschern untersuchte Form der Prozessüberwachung über den mathematischen Bereich hinaus verallgemeinern lässt.

Modell der Woche

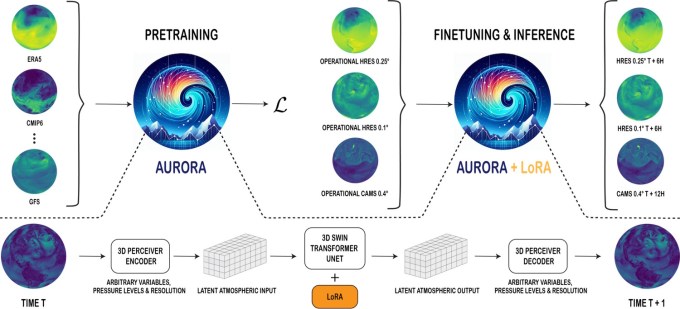

Wettervorhersagen mögen sich nicht wie eine Wissenschaft anfühlen (zumindest wenn es regnet, wie ich es gerade getan habe), aber das liegt daran, dass es um Wahrscheinlichkeiten geht, nicht um Gewissheiten. Und wie ließen sich Wahrscheinlichkeiten besser berechnen als mit einem Wahrscheinlichkeitsmodell? Wir haben bereits erlebt, dass KI bei der Wettervorhersage für Zeiträume von Stunden bis Jahrhunderten eingesetzt wird, und jetzt macht auch Microsoft mit. Das Unternehmen neues Aurora-Modell bringt den Ball in diesem sich schnell entwickelnden Bereich der KI-Welt voran und bietet Vorhersagen auf Globusebene mit einer Auflösung von etwa 0,1° (also in der Größenordnung von 10 km²).

Trainiert in über einer Million Stunden Wetter- und Klimasimulationen (kein echtes Wetter? Hmm…) und fein abgestimmt auf eine Reihe wünschenswerter Aufgaben, Aurora übertrifft herkömmliche numerische Vorhersagesysteme um mehrere Größenordnungen. Noch beeindruckender ist, dass es Google DeepMinds GraphCast mit seinen eigenen Waffen schlägt (obwohl Microsoft das Feld ausgewählt hat) und genauere Schätzungen der Wetterbedingungen auf der Ein- bis Fünf-Tages-Skala liefert.

Natürlich sind auch Unternehmen wie Google und Microsoft mit von der Partie. Beide buhlen um Ihre Online-Aufmerksamkeit, indem sie versuchen, Ihnen das persönlichste Web- und Sucherlebnis zu bieten. Genaue und effiziente Wettervorhersagen aus erster Hand werden dabei eine wichtige Rolle spielen, zumindest solange wir nicht mehr nach draußen gehen.

Wundertüte

In einem Gedanken Stück letzten Monat in PalladiumAvital Balwit, Stabschefin beim KI-Startup Anthropic, geht davon aus, dass die nächsten drei Jahre die letzten sein könnten, die sie und viele Wissensarbeiter aufgrund der rasanten Fortschritte der generativen KI arbeiten müssen. Dies sollte eher ein Trost als ein Grund zur Angst sein, sagt sie, denn es könnte „[lead to] eine Welt, in der die materiellen Bedürfnisse der Menschen erfüllt sind, sie aber nicht arbeiten müssen.“

„Ein renommierter KI-Forscher erzählte mir einmal, dass er übt für [this inflection point] indem er Aktivitäten aufnimmt, in denen er nicht besonders gut ist: Jiu-Jitsu, Surfen und so weiter, und das Tun genießt, auch wenn er nicht hervorragend ist“, schreibt Balwit. „So können wir uns auf unsere Zukunft vorbereiten, in der wir Dinge aus Freude und nicht aus Notwendigkeit tun müssen, in der wir nicht mehr die Besten darin sein werden, sondern immer noch entscheiden müssen, wie wir unsere Tage verbringen.“

Das ist sicherlich die „halbvolle Glasansicht“ – aber ich kann nicht behaupten, dass ich sie teile.

Sollte generative KI innerhalb von drei Jahren die meisten Wissensarbeiter ersetzen (was mir angesichts der vielen ungelösten technischen Probleme der KI unrealistisch erscheint), könnte es durchaus zu einem wirtschaftlichen Zusammenbruch kommen. Wissensarbeiter machen große Teile der Belegschaft und tendenziell Spitzenverdiener — und damit Geldgeber. Sie treiben die Räder des Kapitalismus an.

Balwit verweist auf das universelle Grundeinkommen und andere groß angelegte soziale Sicherungsnetze. Aber ich habe nicht viel Vertrauen darin, dass Länder wie die USA, die nicht einmal in der Lage sind, eine grundlegende KI-Gesetzgebung auf Bundesebene auf die Beine zu stellen, in absehbarer Zeit universelle Grundeinkommensprogramme einführen werden.

Mit etwas Glück liege ich falsch.