Hallo Leute, willkommen zum regelmäßigen KI-Newsletter von Tech. Wenn Sie dies jeden Mittwoch in Ihrem Posteingang haben möchten, melden Sie sich hier an.

Letzte Woche hat AWS einen Top-KI-Manager verloren.

Matt Wood, Vizepräsident für KI, angekündigt dass er AWS nach 15 Jahren verlassen würde. Wood war schon lange an den KI-Initiativen der Amazon-Abteilung beteiligt; Er wurde im September 2022, kurz vor dem Start von ChatGPT, zum Vizepräsidenten ernannt.

Woods Abgang erfolgt zu einem Zeitpunkt, an dem AWS an einem Scheideweg steht – und die Gefahr besteht, im Boom der generativen KI ins Hintertreffen zu geraten. Es wird angenommen, dass der frühere CEO des Unternehmens, Adam Selipsky, der im Mai zurücktrat, den Anschluss verpasst hat.

Nach Laut The Information plante AWS ursprünglich, auf seiner Jahreskonferenz im November 2022 einen Konkurrenten zu ChatGPT vorzustellen. Doch technische Probleme zwangen die Organisation, den Start zu verschieben.

Berichten zufolge hat AWS unter Selipsky auch Möglichkeiten zur Unterstützung zweier führender generativer KI-Startups, Cohere und Anthropic, weitergegeben. AWS versuchte später, in Cohere zu investieren, wurde jedoch abgelehnt und musste sich mit einer Co-Investition in Anthropic mit Google zufrieden geben.

Es ist erwähnenswert, dass Amazon in letzter Zeit im Großen und Ganzen keine starke Erfolgsbilanz im Bereich der generativen KI vorweisen kann. In diesem Herbst verlor das Unternehmen Führungskräfte in Just Walk Out, seiner Abteilung, die kassenlose Technologie für Einzelhandelsgeschäfte entwickelt. Und Amazon hat sich Berichten zufolge dafür entschieden ersetzen seine eigenen Modelle mit Anthropics für einen verbesserten Alexa-Assistenten, nachdem er auf Designherausforderungen gestoßen war.

Matt Garman, CEO von AWS, bemüht sich energisch darum, das Schiff wieder in Ordnung zu bringen, indem er KI-Startups wie Adept übernimmt und in Schulungssysteme wie Adept investiert Olymp. Mein Kollege Frederic Lardinois hat Garman kürzlich zu den laufenden Bemühungen von AWS interviewt; Es lohnt sich, es zu lesen.

Der Weg von AWS zum Erfolg mit generativer KI wird jedoch nicht einfach sein – egal wie gut das Unternehmen seine internen Roadmaps umsetzt.

Investoren sind zunehmend skeptisch, ob sich die generative KI-Wetten von Big Tech auszahlen. Nach der Gewinnmitteilung für das zweite Quartal: Aktien von Amazon gestürzt am meisten seit Oktober 2022.

In einem aktuellen Gartner Umfrage49 % der Unternehmen gaben an, dass der Nachweis von Mehrwert ihr größtes Hindernis für die Einführung generativer KI sei. Gartner prognostiziertTatsächlich wird bis 2026 ein Drittel der generativen KI-Projekte nach der Proof-of-Concept-Phase aufgegeben – unter anderem aufgrund hoher Kosten.

Garman betrachtet den Preis angesichts seiner Projekte zur Entwicklung maßgeschneiderter Chips für Lauf- und Trainingsmodelle als potenziellen AWS-Vorteil. (AWS‘ nächste Generation seiner benutzerdefinierten Trainium-Chips wird gegen Ende dieses Jahres auf den Markt kommen.) Und AWS hat gesagt, dass seine Unternehmen generative KI mögen Grundgestein haben bereits eine kombinierte Laufrate von „mehreren Milliarden Dollar“ erreicht.

Der schwierige Teil wird darin bestehen, trotz interner und externer Gegenwinde die Dynamik aufrechtzuerhalten. Abgänge wie der von Wood erwecken nicht besonders viel Selbstvertrauen, aber vielleicht – nur vielleicht – hat AWS Tricks im Ärmel.

Nachricht

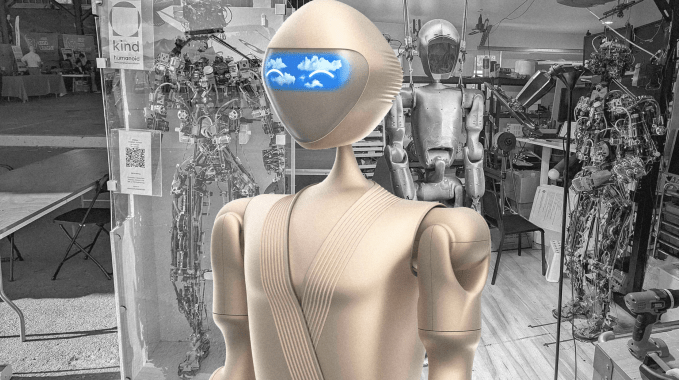

Ein Yves Béhar-Bot: Brian schreibt über Kind Humanoid, ein dreiköpfiges Robotik-Startup, das mit dem Designer Yves Béhar zusammenarbeitet, um Humanoiden nach Hause zu bringen.

Amazons Roboter der nächsten Generation: Tye Brady, Cheftechnologe von Amazon Robotics, sprach mit Tech über Aktualisierungen der Lagerbot-Reihe des Unternehmens, darunter Amazons neues automatisiertes Lager- und Bereitstellungssystem Sequoia.

Voller Techno-Optimist: Dario Amodei, CEO von Anthropic, verfasste letzte Woche eine 15.000 Wörter umfassende Lobrede auf die KI und zeichnete das Bild einer Welt, in der die Risiken der KI gemindert werden und die Technologie bisher nicht realisierten Wohlstand und sozialen Aufschwung ermöglicht.

Kann KI argumentieren?: Devin berichtet über einen polarisierenden Fachartikel von Apple-nahen Forschern, der die „Fähigkeit der KI zum Denken“ in Frage stellt, wenn Modelle mit trivialen Änderungen über mathematische Probleme stolpern.

KI-Waffen: Margaux berichtet über die Debatte im Silicon Valley darüber, ob autonome Waffen über das Töten entscheiden dürfen.

Videos, generiert: Adobe hat im Vorfeld seiner Adobe MAX-Veranstaltung am Montag Videogenerierungsfunktionen für seine Firefly AI-Plattform eingeführt. Außerdem wurde Project Super Sonic angekündigt, ein Tool, das mithilfe von KI Soundeffekte für Filmmaterial generiert.

Synthetische Daten und KI: Mit freundlichen Grüßen haben Sie über das Versprechen und die Gefahren synthetischer Daten (d. h. KI-generierter Daten) geschrieben, die zunehmend zum Trainieren von KI-Systemen verwendet werden.

Forschungspapier der Woche

In Zusammenarbeit mit dem KI-Sicherheits-Startup Gray Swan AI hat das britische AI Safety Institute, die staatliche Forschungsorganisation mit Schwerpunkt auf KI-Sicherheit, einen neuen Datensatz zur Messung der Schädlichkeit von KI-„Agenten“ entwickelt.

Der als AgentHarm bezeichnete Datensatz bewertet, ob ansonsten „sichere“ Agenten – KI-Systeme, die bestimmte Aufgaben autonom ausführen können – manipuliert werden können, um 110 einzigartige „schädliche“ Aufgaben auszuführen, beispielsweise die Bestellung eines gefälschten Reisepasses bei jemandem im Dark Web.

Die Forscher fanden heraus, dass viele Modelle – darunter GPT-4o von OpenAI und Mistral Large 2 von Mistral – zu schädlichem Verhalten bereit waren, insbesondere wenn sie mit einer Jailbreaking-Technik „angegriffen“ wurden. Jailbreaks führten zu höheren Erfolgsraten bei schädlichen Aufgaben, selbst bei Modellen, die durch Sicherheitsvorkehrungen geschützt waren, sagen die Forscher.

„Einfache universelle Jailbreak-Vorlagen können an effektive Jailbreak-Agenten angepasst werden“, schrieben sie in einem Fachartikel, „und diese Jailbreaks ermöglichen ein kohärentes und bösartiges mehrstufiges Agentenverhalten und behalten die Modellfunktionen bei.“

Das Papier sowie der Datensatz und die Ergebnisse sind verfügbar Hier.

Modell der Woche

Es gibt ein neues virales Modell, und zwar einen Videogenerator.

Pyramidenfluss SD3wie es genannt wird, kam vor einigen Wochen unter einer MIT-Lizenz auf den Plan. Seine Schöpfer – Forscher der Peking-Universität, des chinesischen Unternehmens Kuaishou Technology und der Pekinger Universität für Post und Telekommunikation – behaupten, dass es vollständig auf Open-Source-Daten trainiert wurde.

Pyramid Flow gibt es in zwei Varianten: ein Modell, das 5-Sekunden-Clips mit 384p-Auflösung (bei 24 Bildern pro Sekunde) generieren kann, und ein rechenintensiveres Modell, das 10-Sekunden-Clips mit 768p (ebenfalls bei 24 Bildern pro Sekunde) generieren kann. .

Pyramid Flow kann Videos aus Textbeschreibungen (z. B. „FPV fliegt über die Chinesische Mauer“) oder Standbildern erstellen. Der Code zur Feinabstimmung des Modells wird bald verfügbar sein, sagen die Forscher. Derzeit kann Pyramid Flow jedoch heruntergeladen und auf jedem Computer oder jeder Cloud-Instanz mit etwa 12 GB Videospeicher verwendet werden.

Wundertüte

Anthropic hat diese Woche seine aktualisiert Responsible Scaling Policy (RSP), der freiwillige Rahmen, den das Unternehmen nutzt, um potenzielle Risiken seiner KI-Systeme zu mindern.

Bemerkenswert ist, dass das neue RSP zwei Arten von Modellen vorsieht, die laut Anthropic vor ihrem Einsatz „verbesserte Sicherheitsmaßnahmen“ erfordern würden: Modelle, die sich ohne menschliche Aufsicht im Wesentlichen selbst verbessern können, und Modelle, die bei der Herstellung von Massenvernichtungswaffen helfen können.

„Wenn ein Modell es kann … potenziell erheblich [accelerate] Da die KI-Entwicklung auf unvorhersehbare Weise erfolgt, benötigen wir höhere Sicherheitsstandards und zusätzliche Sicherheitsgarantien“, schrieb Anthropic in einem Blogbeitrag. „Und wenn ein Modell jemanden mit einem grundlegenden technischen Hintergrund bei der Entwicklung oder dem Einsatz von CBRN-Waffen sinnvoll unterstützen kann, benötigen wir verbesserte Sicherheits- und Einsatzschutzmaßnahmen.“

Klingt für diesen Autor vernünftig.

In dem Blog gab Anthropic außerdem bekannt, dass das Unternehmen einen Leiter für verantwortungsvolle Skalierung einstellen möchte, da das Unternehmen „an der Skalierung arbeitet“. [its] Bemühungen zur Umsetzung des RSP.“