Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie erledigen kann, finden Sie hier eine praktische Zusammenfassung der neuesten Geschichten aus der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht alleine behandelt haben.

Diese Woche veröffentlichte Meta die neuesten generativen KI-Modelle seiner Llama-Serie: Llama 3 8B und Llama 3 70B. Die Modelle sind in der Lage, Texte zu analysieren und zu schreiben, und laut Meta „Open Source“ – sie sollen ein „grundlegendes Element“ von Systemen sein, die Entwickler mit Blick auf ihre individuellen Ziele entwerfen.

„Wir glauben, dass dies die besten Open-Source-Modelle ihrer Klasse sind“, schrieb Meta in einem Blogeintrag. „Wir folgen dem Open-Source-Ethos, früh und häufig zu veröffentlichen.“

Es gibt nur ein Problem: Bei den Llama 3-Modellen ist das nicht der Fall Wirklich „Open Source“, zumindest nicht in der strengste Definition.

Open Source bedeutet, dass Entwickler die Modelle uneingeschränkt nach Belieben nutzen können. Aber im Fall von Llama 3 hat Meta – wie auch bei Llama 2 – bestimmte Lizenzbeschränkungen auferlegt. Beispielsweise können Llama-Modelle nicht zum Trainieren anderer Modelle verwendet werden. Und App-Entwickler mit über 700 Millionen monatlichen Nutzern müssen eine spezielle Lizenz bei Meta beantragen.

Debatten über die Definition von Open Source sind nicht neu. Da Unternehmen im KI-Bereich jedoch schnell und locker mit dem Begriff umgehen, verleiht er langjährigen philosophischen Argumenten neuen Schwung.

Letzten August, a Studie Die gemeinsam von Forschern der Carnegie Mellon, des AI Now Institute und der Signal Foundation verfasste Studie ergab, dass viele als „Open Source“ gebrandete KI-Modelle große Nachteile haben – nicht nur Llama. Die zum Training der Modelle erforderlichen Daten werden geheim gehalten. Die für ihre Ausführung erforderliche Rechenleistung ist für viele Entwickler unerschwinglich. Und der Aufwand für die Feinabstimmung ist unerschwinglich.

Wenn diese Modelle also nicht wirklich Open Source sind, was genau sind sie dann? Das ist eine gute Frage; Die Definition von Open Source im Hinblick auf KI ist keine leichte Aufgabe.

Eine relevante ungelöste Frage ist, ob das Urheberrecht, der grundlegende IP-Mechanismus, auf dem die Open-Source-Lizenzierung basiert, auf die verschiedenen Komponenten und Teile eines KI-Projekts angewendet werden kann, insbesondere auf das innere Gerüst eines Modells (z. B Einbettungen). Hinzu kommt die Diskrepanz zwischen der Wahrnehmung von Open Source und der tatsächlichen Funktionsweise von KI, die es zu überwinden gilt: Open Source wurde teilweise entwickelt, um sicherzustellen, dass Entwickler Code ohne Einschränkungen studieren und ändern können. Bei der KI ist es jedoch offen für Interpretationen, welche Zutaten Sie studieren und ändern müssen.

Durch all die Unsicherheit waten, die Carnegie-Mellon-Studie tut Machen Sie den Schaden deutlich, der damit verbunden ist, dass Technologiegiganten wie Meta den Begriff „Open Source“ übernehmen.

Oft führen „Open-Source“-KI-Projekte wie Llama dazu, dass Nachrichtenzyklen in Gang gesetzt werden – kostenloses Marketing – und den Betreuern der Projekte technische und strategische Vorteile bieten. Die Open-Source-Community sieht selten dieselben Vorteile, und wenn doch, sind sie im Vergleich zu denen der Betreuer marginal.

Anstatt die KI zu demokratisieren, tendieren „Open-Source“-KI-Projekte – insbesondere die von großen Technologieunternehmen – dazu, die zentralisierte Macht zu festigen und auszubauen, sagen die Co-Autoren der Studie. Das sollten Sie im Hinterkopf behalten, wenn das nächste Mal eine große „Open-Source“-Modellveröffentlichung erscheint.

Hier sind einige andere bemerkenswerte KI-Geschichten der letzten Tage:

- Meta aktualisiert seinen Chatbot: Zeitgleich mit dem Debüt von Llama 3 hat Meta seinen KI-Chatbot für Facebook, Messenger, Instagram und WhatsApp – Meta AI – mit einem Llama 3-basierten Backend aktualisiert. Außerdem wurden neue Funktionen eingeführt, darunter eine schnellere Bildgenerierung und Zugriff auf Websuchergebnisse.

- KI-generierte Pornos: Ivan schreibt darüber, wie das Oversight Board, der halbunabhängige politische Rat von Meta, seine Aufmerksamkeit darauf richtet, wie die sozialen Plattformen des Unternehmens mit expliziten, KI-generierten Bildern umgehen.

- Snap-Wasserzeichen: Der Social-Media-Dienst Snap plant, auf seiner Plattform KI-generierte Bilder mit Wasserzeichen zu versehen. Das neue Wasserzeichen ist eine durchscheinende Version des Snap-Logos mit einem funkelnden Emoji und wird jedem KI-generierten Bild hinzugefügt, das aus der App exportiert oder in der Kamerarolle gespeichert wird.

- Der neue Atlas: Das zu Hyundai gehörende Robotikunternehmen Boston Dynamics hat seinen humanoiden Atlas-Roboter der nächsten Generation vorgestellt, der im Gegensatz zu seinem hydraulisch angetriebenen Vorgänger rein elektrisch ist – und viel freundlicher aussieht.

- Humanoide über Humanoide: Um nicht von Boston Dynamics übertroffen zu werden, hat der Gründer von Mobileye, Amnon Shashua, ein neues Startup namens Menteebot gegründet, das sich auf die Entwicklung bibedaler Robotiksysteme konzentriert. Ein Demovideo zeigt den Prototyp von Menteebot, wie er zu einem Tisch geht und Obst aufsammelt.

- Reddit, übersetzt: In einem Interview mit Amanda enthüllte Pali Bhat, CPO von Reddit, dass eine KI-gestützte Sprachübersetzungsfunktion in Arbeit ist, um das soziale Netzwerk einem globaleren Publikum zugänglich zu machen, zusammen mit einem unterstützenden Moderationstool, das auf früheren Entscheidungen und Handlungen von Reddit-Moderatoren basiert.

- KI-generierte LinkedIn-Inhalte: LinkedIn hat in aller Stille damit begonnen, eine neue Möglichkeit zu testen, seine Einnahmen zu steigern: ein LinkedIn Premium Company Page-Abonnement, das – für scheinbar hohe Gebühren von 99 US-Dollar pro Monat – KI zum Schreiben von Inhalten und eine Reihe von Tools zur Steigerung der Followerzahlen beinhaltet.

- Ein Leitmotiv: X, die Moonshot-Fabrik der Google-Muttergesellschaft Alphabet, stellte diese Woche das Project Bellwether vor, ihren neuesten Versuch, Technologie auf einige der größten Probleme der Welt anzuwenden. Hier bedeutet das, mithilfe von KI-Tools Naturkatastrophen wie Waldbrände und Überschwemmungen so schnell wie möglich zu erkennen.

- Kinder mit KI schützen: Ofcom, die mit der Durchsetzung des britischen Online Safety Act beauftragte Regulierungsbehörde, plant, eine Untersuchung darüber einzuleiten, wie KI und andere automatisierte Tools zur proaktiven Erkennung und Entfernung illegaler Online-Inhalte eingesetzt werden können, insbesondere um Kinder vor schädlichen Inhalten zu schützen.

- OpenAI landet in Japan: OpenAI expandiert nach Japan mit der Eröffnung eines neuen Büros in Tokio und plant ein speziell für die japanische Sprache optimiertes GPT-4-Modell.

Mehr maschinelles Lernen

Bildnachweis: DrAfter123 / Getty Images

Kann ein Chatbot Ihre Meinung ändern? Schweizer Forscher haben herausgefunden, dass sie das nicht nur können, sondern wenn sie bereits mit einigen persönlichen Informationen über Sie ausgestattet sind, das können sie tatsächlich sein mehr in einer Debatte überzeugender als ein Mensch mit den gleichen Informationen.

„Das ist Cambridge Analytica zum Thema Steroide“, sagte Projektleiter Robert West von der EPFL. Die Forscher vermuten, dass das Modell – in diesem Fall GPT-4 – auf seine umfangreichen Argumente und Fakten im Internet zurückgegriffen hat, um einen überzeugenderen und überzeugenderen Fall zu präsentieren. Aber das Ergebnis spricht irgendwie für sich. Unterschätzen Sie nicht die Überzeugungskraft von LLMs, warnte West: „Im Zusammenhang mit den bevorstehenden US-Wahlen sind die Menschen besorgt, denn dort wird diese Art von Technologie immer zuerst im Kampf getestet.“ Wir wissen mit Sicherheit, dass die Menschen die Macht großer Sprachmodelle nutzen werden, um zu versuchen, die Wahl zu manipulieren.“

Warum sind diese Modelle überhaupt so gut in der Sprache? In diesem Bereich gibt es eine lange Forschungsgeschichte, die auf ELIZA zurückgeht. Wenn Sie neugierig auf jemanden sind, der viel dabei war (und nicht wenig davon selbst aufführte), schauen Sie sich das an dieses Profil über Stanfords Christopher Manning. Er wurde gerade mit der John-von-Neuman-Medaille ausgezeichnet; Glückwunsch!

In einem Interview mit dem provokanten Titel spekulieren ein weiterer langjähriger KI-Forscher (der ebenfalls auf der Tech-Bühne stand), Stuart Russell, und der Postdoktorand Michael Cohen darüber „Wie man verhindert, dass KI uns alle tötet.“ Wahrscheinlich ist es eine gute Sache, das lieber früher als später herauszufinden! Es ist jedoch keine oberflächliche Diskussion – es sind kluge Leute, die darüber sprechen, wie wir die Beweggründe (wenn das das richtige Wort ist) von KI-Modellen tatsächlich verstehen können und wie Vorschriften auf dieser Grundlage aufgebaut werden sollten.

Das Interview ist tatsächlich besorgniserregend ein Artikel in Science Sie schlagen vor, dass fortgeschrittene KIs, die in der Lage sind, strategisch zu handeln, um ihre Ziele zu erreichen, die sie „Agenten der langfristigen Planung“ nennen, möglicherweise nicht getestet werden können. Wenn ein Modell lernt, die Tests zu „verstehen“, die es bestehen muss, um erfolgreich zu sein, kann es im Wesentlichen auch Wege lernen, diese Tests kreativ zu negieren oder zu umgehen. Wir haben es im Kleinen gesehen, warum nicht auch im Großen?

Russell schlägt vor, die zur Herstellung solcher Wirkstoffe erforderliche Hardware einzuschränken … aber natürlich haben die Los Alamos und Sandia National Labs gerade erst ihre Lieferungen erhalten. LANL hatte gerade die Zeremonie zum Durchschneiden des Bandes für Venadoein neuer Supercomputer für die KI-Forschung, bestehend aus 2.560 Grace Hopper Nvidia-Chips.

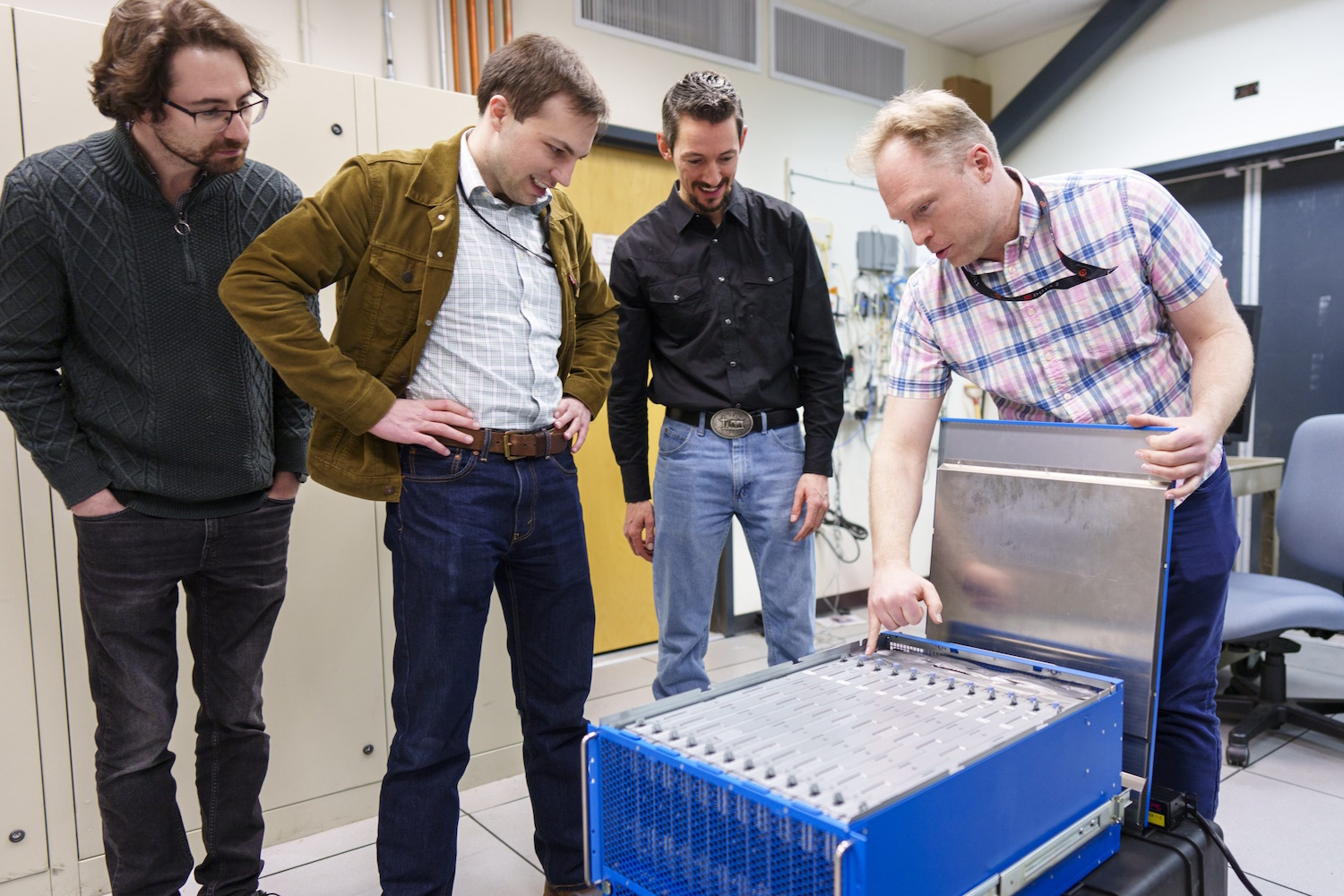

Forscher untersuchen den neuen neuromorphen Computer.

Und Sandia erhielt gerade „ein außergewöhnliches gehirnbasiertes Computersystem namens Hala Point“ mit 1,15 Milliarden künstlichen Neuronen, das von Intel gebaut wurde und als das größte derartige System der Welt gilt. Neuromorphic Computing, wie es genannt wird, soll Systeme wie Venado nicht ersetzen, sondern neue Berechnungsmethoden verfolgen, die gehirnähnlicher sind als der eher statistikorientierte Ansatz, den wir in modernen Modellen sehen.

„Mit diesem Milliarden-Neuronen-System haben wir die Möglichkeit, in großem Maßstab Innovationen zu entwickeln, sowohl neue KI-Algorithmen, die möglicherweise effizienter und intelligenter als bestehende Algorithmen sind, als auch neue gehirnähnliche Ansätze für bestehende Computeralgorithmen wie Optimierung und Modellierung“, sagte er Sandia-Forscher Brad Aimone. Klingt großartig… einfach großartig!