Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie erledigen kann, finden Sie hier eine praktische Zusammenfassung der neuesten Geschichten aus der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht alleine behandelt haben.

Diese Woche veranstaltete OpenAI im Bereich KI die erste von vermutlich vielen kommenden Entwicklerkonferenzen. Während der Keynote stellte das Unternehmen eine Reihe neuer Produkte vor, darunter unter anderem eine verbesserte Version von GPT-4, neue Text-to-Speech-Modelle und eine API für das bildgenerierende DALL-E 3.

Aber die bedeutendste Ankündigung waren zweifellos die GPTs.

Die GPTs von OpenAI bieten Entwicklern die Möglichkeit, ihre eigenen Konversations-KI-Systeme zu erstellen, die auf den Modellen von OpenAI basieren, und sie auf einem von OpenAI gehosteten Marktplatz namens GPT Store zu veröffentlichen. Bald werden Entwickler sogar in der Lage sein, GPTs basierend auf der Anzahl ihrer Nutzer zu monetarisieren, sagte OpenAI-CEO Sam Altman auf der Bühne der Konferenz.

„Wir glauben, dass Menschen erstaunliche Dinge leisten werden, wenn man ihnen bessere Werkzeuge an die Hand gibt“, sagte Altman. „Sie können ein GPT erstellen … und es dann veröffentlichen, damit andere es verwenden können. Da sie Anweisungen, erweitertes Wissen und Aktionen kombinieren, können sie für Sie hilfreicher sein.“

Der Wandel von OpenAI vom KI-Modellanbieter zur Plattform war zwar interessant – aber nicht gerade unerwartet. Das Startup verdeutlichte seine Ambitionen im März mit der Einführung von Plugins für ChatGPT, seinem KI-gestützten Chatbot, der erstmals Dritte in das Modell-Ökosystem von OpenAI einbezog.

Aber was diesen Autor überraschte, war die Breite und Tiefe der GPT-Entwicklung und -Kommerzialisierung von OpenAI von Anfang an.

Mein Kollege Devin Coldewey, der persönlich an der OpenAI-Konferenz teilnahm, erzählte mir, dass die GPT-Erfahrung in den Demos „ein wenig fehlerhaft“ war – aber mehr oder weniger wie angekündigt funktionierte. GPTs erfordern keine Programmiererfahrung und können so einfach oder komplex sein, wie es ein Entwickler wünscht. Ein GPT kann beispielsweise anhand einer Kochbuchsammlung geschult werden, sodass er Antworten auf Fragen zu Zutaten für ein bestimmtes Rezept stellen kann. Oder ein GPT könnte die proprietären Codebasen eines Unternehmens aufnehmen, sodass Entwickler deren Stil überprüfen oder Code gemäß Best Practices generieren können.

GPTs demokratisieren effektiv die Erstellung generativer KI-Apps – zumindest für Apps, die die Modellfamilie von OpenAI verwenden. Und wenn ich der Rivale von OpenAI wäre – zumindest der Rivale ohne die Unterstützung von Big Tech –, würde ich in den bildlichen Kriegsraum rennen, um eine Antwort zu finden.

GPT könnte Beratungsunternehmen töten, deren Geschäftsmodelle sich auf den Aufbau von GPTs für Kunden konzentrieren. Und für Kunden mit Entwicklertalent könnten Modellanbieter dies tun nicht Angesichts der Komplexität, die die Einbindung der APIs eines Anbieters in bestehende Apps und Dienste mit sich bringt, ist es weniger attraktiv, jede Form von App-Building-Tools anzubieten.

Ist das eine gute Sache? Ich würde nicht unbedingt argumentieren – und ich mache mir Sorgen über die Möglichkeit eines Monopols. Aber OpenAI hat den First-Mover-Vorteil und nutzt ihn – im Guten wie im Schlechten.

Hier sind einige andere bemerkenswerte KI-Geschichten der letzten Tage:

- Samsung stellt generative KI vor: Nur wenige Tage nach der Entwicklerveranstaltung von OpenAI stellte Samsung auf dem Samsung AI Forum 2023 seine eigene generative KI-Familie Samsung Gauss vor. Bestehend aus drei Modellen – einem großen Sprachmodell ähnlich ChatGPT, einem Code-generierenden Modell und einem Bildgenerierungsmodell Bearbeitungsmodell – Samsung Gauss wird jetzt intern von Samsung-Mitarbeitern verwendet, sagte das Technologieunternehmen, und wird „in naher Zukunft“ für öffentliche Benutzer verfügbar sein.

- Microsoft stellt Startups kostenloses KI-Computing zur Verfügung: Microsoft gab diese Woche bekannt, dass es sein Startup-Programm, Microsoft for Startups Founders Hub, aktualisiert, um eine kostenlose Azure AI-Infrastrukturoption für „High-End“, Nvidia-basierte GPU-Virtual-Machine-Cluster zum Trainieren und Ausführen generativer Modelle aufzunehmen. Y Combinator und seine Community aus Startup-Gründern werden als Erste Zugang zu den Clustern in der privaten Vorschau erhalten, gefolgt von M12, dem Risikofonds von Microsoft, und Startups im M12-Portfolio – und möglicherweise weiteren Startup-Investoren und Beschleunigern danach.

- YouTube testet generative KI-Funktionen: YouTube werde bald damit beginnen, mit neuen generativen KI-Funktionen zu experimentieren, so das Unternehmen angekündigt diese Woche. Im Rahmen des Premium-Pakets für zahlende YouTube-Abonnenten können Nutzer ein Konversationstool ausprobieren, das mithilfe von KI Fragen zu YouTube-Inhalten beantwortet und Empfehlungen abgibt, sowie eine Funktion, die Themen in den Kommentaren eines Videos zusammenfasst.

- Ein Interview mit dem Robotik-Leiter von DeepMind: Brian sprach mit Vincent Vanhoucke, dem Leiter der Robotikabteilung von Google DeepMind, über die großen Roboterambitionen von Google. Das Interview berührte eine Reihe von Themen, darunter Allzweckroboter, generative KI und – ausgerechnet – Büro-WLAN.

- Das KI-Startup von Kai-Fu Lee stellt Modell vor: Kai-Fu Lee, der Informatiker, der im Westen für seinen Bestseller „AI Superpowers“ und in China für seine Wetten auf KI-Einhörner bekannt ist, macht mit seinem eigenen KI-Startup beeindruckende Fortschritte. 01.AI. Sieben Monate nach seiner Gründung hat 01.AI – im Wert von 1 Milliarde US-Dollar – sein erstes Modell veröffentlicht, das Open Source Yi-34B.

- GitHub stellt einen anpassbaren Copilot-Plan vor: GitHub kündigte diese Woche Pläne für eine Unternehmensabonnementstufe an, die es Unternehmen ermöglichen wird, ihren Copilot-Paarprogrammierer basierend auf ihrer internen Codebasis zu verfeinern. Die Nachricht war Teil einer Reihe bemerkenswerter Neuigkeiten, die das zu Microsoft gehörende Unternehmen am Mittwoch auf seiner jährlichen GitHub Universe-Entwicklerkonferenz enthüllte, darunter ein neues Partnerprogramm und mehr Klarheit darüber, wann Copilot Chat – Copilots kürzlich vorgestellte Chatbot-ähnliche Funktion – wird offiziell verfügbar sein.

- Das zweiköpfige Modelteam von Hugging Face: Das KI-Startup Hugging Face bietet eine breite Palette an Data-Science-Hosting- und Entwicklungstools. Aber einige der beeindruckendsten – und leistungsfähigsten – Tools des Unternehmens stammen heutzutage von einem zweiköpfigen Team namens H4, das erst im Januar gegründet wurde.

- Mozilla veröffentlicht einen KI-Chatbot: Anfang dieses Jahres erwarb Mozilla Fakespot, ein Startup, das KI und maschinelles Lernen nutzt, um gefälschte und irreführende Produktbewertungen zu erkennen. Jetzt bringt Mozilla mit der Einführung von sein erstes großes Sprachmodell auf den Markt Fakespot-Chat, ein KI-Agent, der Verbraucher beim Online-Einkauf unterstützt, indem er Fragen zu Produkten beantwortet und sogar Fragen vorschlägt, die bei der Produktrecherche nützlich sein könnten.

Mehr maschinelles Lernen

Wir haben in vielen Disziplinen gesehen, wie Modelle des maschinellen Lernens in der Lage sind, wirklich gute kurzfristige Vorhersagen für komplexe Datenstrukturen zu treffen, nachdem wir viele frühere Beispiele durchgesehen haben. Es könnte beispielsweise die Warnzeit für bevorstehende Erdbeben verlängern und den Menschen entscheidende zusätzliche 20 bis 30 Sekunden geben, um sich in Deckung zu begeben. Und Google hat gezeigt, dass es auch bei der Vorhersage von Wetterverhältnissen ein gutes Händchen hat.

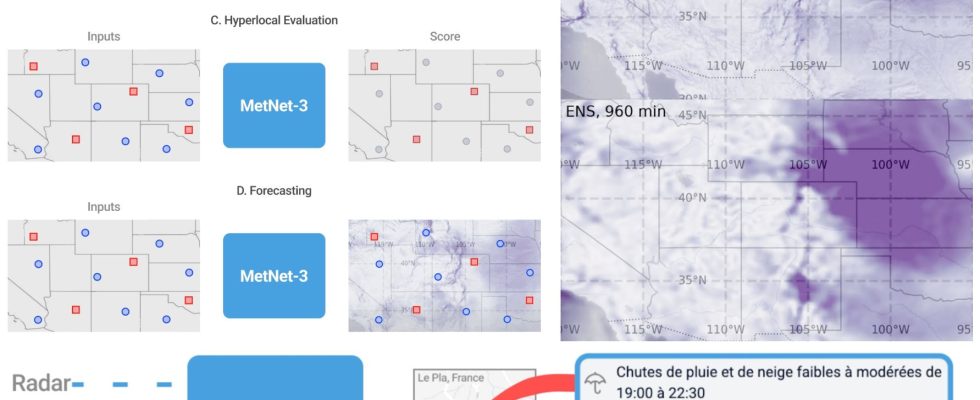

Mehrere Schlussfolgerungen stammen aus dem Beitrag, der zeigt, wie MetNet Daten in seine ML-basierten Vorhersagen integriert. Bildnachweis: Google

MetNet-3 ist das neueste in einer Reihe physikbasierter Wettermodelle, die eine Vielzahl von Variablen wie Niederschlag, Temperatur, Wind und Wolkenbedeckung berücksichtigen und überraschend hochauflösende (zeitliche und räumliche) Vorhersagen für das, was wahrscheinlich sein wird, liefern komm als nächstes. Viele Vorhersagen dieser Art basieren auf ziemlich alten Modellen, die manchmal genau sind, manchmal aber nicht, oder durch die Kombination ihrer Daten mit anderen Quellen genauer gemacht werden können – was MetNet-3 tut. Ich werde nicht zu weit in die Details gehen, aber Sie haben einen wirklich interessanten Beitrag zu diesem Thema verfasst Letzte Woche vermittelte das einen guten Eindruck davon, wie moderne Wettervorhersage-Engines funktionieren.

In anderen hochspezifischen wissenschaftlichen Nachrichten haben Forscher der University of Kansas berichtet ein Detektor für KI-generierten Text … für Zeitschriftenartikel über Chemie. Sicher, es ist für die meisten Menschen nicht nützlich, aber nachdem OpenAI und andere bei Detektormodellen auf die Bremse getreten sind, ist es nützlich zu zeigen, dass zumindest etwas Begrenzteres möglich ist. „Der Großteil der Textanalysebranche benötigt einen wirklich allgemeinen Detektor, der bei allem funktioniert“, sagte Co-Autorin Heather Desaire. „Wir waren wirklich auf Genauigkeit bedacht.“

Ihr Modell wurde anhand von Artikeln aus der Zeitschrift der American Chemical Society trainiert und lernte, Einleitungsabschnitte nur aus dem Titel und nur der Zusammenfassung zu schreiben. Später konnte es mit ChatGPT-3.5 geschriebene Intros mit nahezu perfekter Genauigkeit identifizieren. Offensichtlich handelt es sich hierbei um einen äußerst engen Anwendungsfall, aber das Team weist darauf hin, dass sie ihn relativ schnell und einfach einrichten konnten, was bedeutet, dass ein Detektor für verschiedene Wissenschaften, Zeitschriften und Sprachen eingerichtet werden konnte.

Für Aufsätze zur Hochschulzulassung gibt es noch keinen, aber KI könnte bald auf der anderen Seite dieses Prozesses stehen und nicht entscheiden, wer aufgenommen wird, sondern den Zulassungsbeamten dabei helfen, Rohdiamanten zu identifizieren. Forscher der Colorado University und UPenn zeigten, dass ein ML-Modell dazu in der Lage ist erfolgreich Passagen in Schüleraufsätzen identifizieren, die auf Interessen und Qualitäten hinweisenwie Führung oder „prosozialer Zweck“.

Studenten werden (noch) nicht auf diese Weise bewertet, aber es ist ein dringend benötigtes Werkzeug im Werkzeugkasten von Administratoren, die Tausende von Bewerbungen durchgehen müssen und ab und zu eine Hand gebrauchen könnten. Sie könnten eine Analyseebene wie diese verwenden, um Aufsätze zu gruppieren oder sie sogar besser nach dem Zufallsprinzip zu sortieren, damit nicht alle, die über Camping sprechen, in einer Reihe landen. Und die Untersuchung ergab, dass die von den Studierenden verwendete Sprache überraschenderweise bestimmte akademische Faktoren wie die Abschlussquote vorhersagte. Natürlich werden sie sich eingehender damit befassen, aber es ist klar, dass die ML-basierte Stilometrie weiterhin wichtig bleiben wird.

Es wäre jedoch nicht ratsam, die Grenzen der KI aus den Augen zu verlieren, wie eine Gruppe von Forschern der University of Washington betonte, die die Kompatibilität von KI-Tools mit ihren eigenen Barrierefreiheitsanforderungen testeten. Ihre Erfahrungen waren entschieden gemischt: Zusammenfassende Systeme fügten Vorurteile hinzu oder halluzinierten Details (was sie für Personen ungeeignet machte, die das Quellmaterial nicht lesen konnten) und wendeten die Regeln zur Barrierefreiheit von Inhalten inkonsistent an.

Gleichzeitig stellte jedoch eine Person aus dem Autismus-Spektrum fest, dass die Verwendung eines Sprachmodells zum Generieren von Nachrichten auf Slack ihnen dabei half, mangelndes Vertrauen in ihre Fähigkeit, normal zu kommunizieren, zu überwinden. Obwohl ihre Kollegen die Nachrichten als etwas „roboterhaft“ empfanden, war es ein Nettovorteil für den Benutzer, was ein Anfang ist. Weitere Informationen zu dieser Studie finden Sie hier.

Beide vorangehenden Punkte werfen jedoch heikle Fragen der Voreingenommenheit und der allgemeinen KI-Verrücktheit in einem sensiblen Bereich auf, sodass es nicht verwunderlich ist, dass einige Bundesstaaten und Kommunen darüber nachdenken, Regeln dafür festzulegen, wofür KI bei offiziellen Aufgaben eingesetzt werden darf. Seattle zum Beispiel hat gerade eine Reihe von „Leitgrundsätzen“ veröffentlicht und Toolkits, die konsultiert oder angewendet werden müssen, bevor ein KI-Modell für offizielle Zwecke verwendet werden kann. Zweifellos werden wir auf allen Regierungsebenen unterschiedliche – und möglicherweise widersprüchliche – Regelsätze sehen.

Bei der Entwicklung von VR half ein maschinelles Lernmodell, das als flexibler Gestendetektor fungierte eine Reihe wirklich interessanter Möglichkeiten, mit virtuellen Objekten zu interagieren. „Wenn die Verwendung von VR genauso ist wie die Verwendung einer Tastatur und einer Maus, welchen Sinn hat sie dann?“ fragte Hauptautor Per Ola Kristensson. „Es muss dir fast übermenschliche Kräfte verleihen, die du anderswo nicht bekommen kannst.“ Guter Punkt!

Im Video oben können Sie genau sehen, wie es funktioniert, was, wenn man darüber nachdenkt, absolut intuitiv Sinn macht. Ich möchte nicht mit meinem aus einem Menü „Kopieren“ und dann „Einfügen“ auswählen Maus Finger. Ich möchte einen Gegenstand in einer Hand halten, dann die Handfläche der anderen öffnen und bumm, ein Duplikat! Wenn ich sie dann schneiden möchte, mache ich einfach meine Hand zu einer Schere?! Das ist fantastisch!

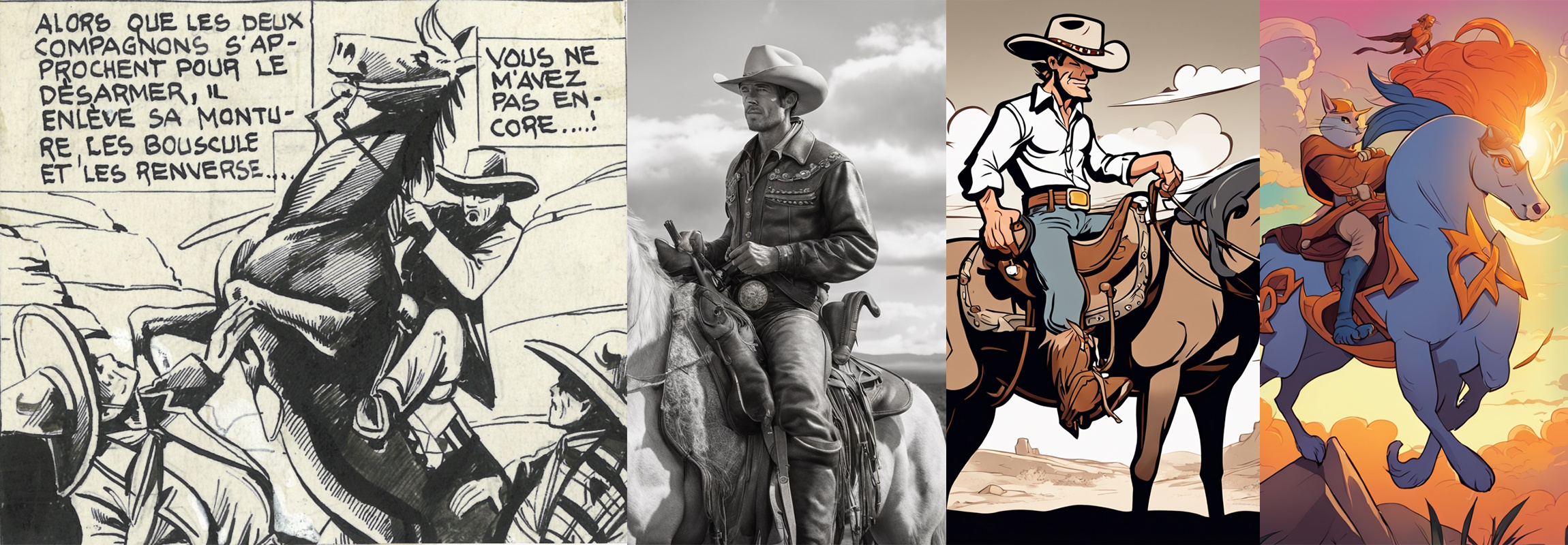

Bildnachweis: EPFL

Apropos Ausschneiden/Einfügen, so heißt es eine neue Ausstellung an der Schweizer Universität EPFL, wo Studenten und Professoren sich mit der Geschichte der Comics seit den 1950er Jahren befassten und wie KI sie verbessern oder interpretieren könnte. Offensichtlich ist die generative Kunst noch nicht ganz auf dem Vormarsch, aber einige Künstler sind offensichtlich daran interessiert, die neue Technologie trotz ihrer ethischen und urheberrechtlichen Probleme zu testen und ihre Interpretationen von historischem Material zu erkunden. Wenn Sie das Glück haben, in Lausanne zu sein, schauen Sie sich Couper/Coller an (die eingängige lokale Version der allgegenwärtigen digitalen Aktionen).