Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie erledigen kann, finden Sie hier eine praktische Zusammenfassung der neuesten Geschichten aus der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht alleine behandelt haben.

Tech plant übrigens, bald einen KI-Newsletter zu veröffentlichen. Bleiben Sie dran. In der Zwischenzeit erhöhen wir die Häufigkeit unserer halbregelmäßigen KI-Kolumne, die zuvor etwa zweimal im Monat erschien, auf wöchentlich – halten Sie also Ausschau nach weiteren Ausgaben.

Diese Woche dominierte OpenAI im KI-Bereich erneut den Nachrichtenzyklus (trotz Googles größter Bemühungen) mit einer Produkteinführung, aber auch mit einigen Palastintrigen. Das Unternehmen stellte GPT-4o vor, sein bisher leistungsfähigstes generatives Modell, und löste nur wenige Tage später effektiv ein Team auf, das sich mit der Entwicklung von Steuerungen beschäftigte, um zu verhindern, dass „superintelligente“ KI-Systeme außer Kontrolle geraten.

Die Auflösung des Teams sorgte erwartungsgemäß für viele Schlagzeilen. Berichte – einschließlich unserer – deuten darauf hin, dass OpenAI der Sicherheitsforschung des Teams zugunsten der Einführung neuer Produkte wie dem oben genannten GPT-4o den Vorrang eingeräumt hat, was letztendlich zum Rücktritt der beiden Co-Leiter des Teams, Jan Leike und OpenAI-Mitbegründer Ilya Sutskever, führte.

Superintelligente KI ist derzeit eher theoretisch als real; Es ist nicht klar, wann – oder ob – die Technologiebranche die notwendigen Durchbrüche erzielen wird, um eine KI zu schaffen, die in der Lage ist, jede Aufgabe zu bewältigen, die ein Mensch bewältigen kann. Aber die Berichterstattung dieser Woche scheint eines zu bestätigen: dass die Führung von OpenAI – insbesondere CEO Sam Altman – sich zunehmend dafür entschieden hat, Produkten Vorrang vor Sicherheitsmaßnahmen zu geben.

Berichten zufolge „altman“wütend„Sutskever, indem er die Einführung KI-gestützter Funktionen auf der ersten Entwicklerkonferenz von OpenAI im vergangenen November beschleunigte. Und er ist soll es gewesen sein kritisierte Helen Toner, Direktorin am Georgetown Center for Security and Emerging Technologies und ehemaliges Vorstandsmitglied von OpenAI, wegen eines von ihr mitverfassten Artikels, der den Sicherheitsansatz von OpenAI in einem kritischen Licht erscheinen ließ – bis zu dem Punkt, an dem er versuchte, sie abzustoßen Die Tafel.

Im letzten Jahr oder so hat OpenAI seinen Chatbot-Shop mit Spam füllen lassen und (angeblich) Gekratzte Daten von YouTube gegen die Nutzungsbedingungen der Plattform verstoßen und gleichzeitig Ambitionen geäußert haben, ihre KI Darstellungen von Pornos und Blut erzeugen zu lassen. Sicherlich scheint die Sicherheit im Unternehmen in den Hintergrund gerückt zu sein – und eine wachsende Zahl von OpenAI-Sicherheitsforschern ist zu dem Schluss gekommen, dass ihre Arbeit anderswo besser unterstützt werden würde.

Hier sind einige andere bemerkenswerte KI-Geschichten der letzten Tage:

- OpenAI + Reddit: In weiteren OpenAI-Nachrichten hat das Unternehmen mit Reddit eine Vereinbarung getroffen, die Daten der sozialen Website für das Training von KI-Modellen zu nutzen. Die Wall Street begrüßte den Deal mit offenen Armen – aber Reddit-Benutzer sind möglicherweise nicht so erfreut.

- Googles KI: Google veranstaltete diese Woche seine jährliche I/O-Entwicklerkonferenz, bei der das Unternehmen erstmals vorgestellt wurde eine Tonne von KI-Produkten. Wir haben sie hier zusammengefasst, vom videogenerierenden Veo über KI-organisierte Ergebnisse in der Google-Suche bis hin zu Upgrades für die Gemini-Chatbot-Apps von Google.

- Anthropic engagiert Krieger: Mike Krieger, einer der Mitbegründer von Instagram und seit kurzem Mitbegründer der personalisierten Nachrichten-App Artifact (die Tech-Muttergesellschaft Yahoo kürzlich übernommen hat), wechselt als erster Chief Product Officer des Unternehmens zu Anthropic. Er wird sowohl die Verbraucher- als auch die Unternehmensbemühungen des Unternehmens überwachen.

- KI für Kinder: Anthropic kündigte letzte Woche an, dass es Entwicklern erlauben werde, kinderorientierte Apps und Tools zu erstellen, die auf seinen KI-Modellen basieren – solange sie bestimmte Regeln befolgen. Insbesondere verbieten Konkurrenten wie Google die Integration ihrer KI in Apps für jüngere Altersgruppen.

- KI-Filmfestival: Das KI-Startup Runway veranstaltete Anfang dieses Monats sein zweites KI-Filmfestival überhaupt. Das wegnehmen? Einige der kraftvolleren Momente im Showcase kamen nicht von der KI, sondern von eher menschlichen Elementen.

Mehr maschinelles Lernen

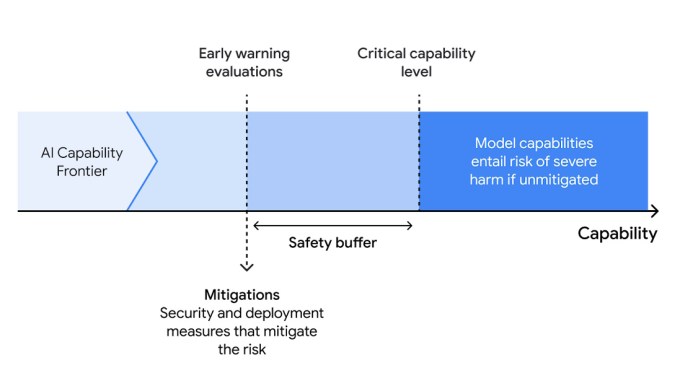

KI-Sicherheit steht diese Woche angesichts der Abgänge von OpenAI offensichtlich im Vordergrund, aber Google Deepmind macht weiter mit einem neuen „Frontier Safety Framework“. Im Grunde handelt es sich dabei um die Strategie der Organisation, um außer Kontrolle geratene Fähigkeiten zu identifizieren und hoffentlich zu verhindern – es muss sich nicht unbedingt um AGI handeln, es könnte sich auch um einen verrückt gewordenen Malware-Generator oder ähnliches handeln.

Das Framework besteht aus drei Schritten: 1. Identifizieren potenziell schädlicher Fähigkeiten in einem Modell durch Simulation seiner Entwicklungspfade. 2. Bewerten Sie Modelle regelmäßig, um festzustellen, wann sie bekannte „kritische Leistungsniveaus“ erreicht haben. 3. Wenden Sie einen Schadensbegrenzungsplan an, um eine Exfiltration (durch andere oder sich selbst) oder einen problematischen Einsatz zu verhindern. Weitere Einzelheiten finden Sie hier. Es hört sich vielleicht wie eine offensichtliche Abfolge von Aktionen an, aber es ist wichtig, sie zu formalisieren, sonst machen alle es einfach nur so. So bekommt man die schlechte KI.

Ein ganz anderes Risiko haben Cambridge-Forscher identifiziert, die zu Recht besorgt über die Verbreitung von Chatbots sind, die man anhand der Daten einer verstorbenen Person trainiert, um ein oberflächliches Abbild dieser Person zu erstellen. Sie finden das ganze Konzept vielleicht (wie ich) etwas abscheulich, aber wenn wir vorsichtig sind, könnte es bei der Trauerbewältigung und anderen Szenarien eingesetzt werden. Das Problem ist, dass wir nicht vorsichtig sind.

„Dieser Bereich der KI ist ein ethisches Minenfeld“ sagte die leitende Forscherin Katarzyna Nowaczyk-Basińska. „Wir müssen jetzt darüber nachdenken, wie wir die sozialen und psychologischen Risiken der digitalen Unsterblichkeit mindern, denn die Technologie ist bereits vorhanden.“ Das Team identifiziert zahlreiche Betrügereien, mögliche schlechte und gute Ergebnisse und diskutiert das Konzept im Allgemeinen (einschließlich gefälschter Dienste) in einem Artikel veröffentlicht in Philosophy & Technology. Black Mirror sagt wieder einmal die Zukunft voraus!

In weniger gruseligen Anwendungen von KI, Physiker am MIT suchen nach einem (für sie) nützlichen Werkzeug zur Vorhersage der Phase oder des Zustands eines physikalischen Systems, normalerweise eine statistische Aufgabe, die bei komplexeren Systemen mühsam werden kann. Wenn Sie jedoch ein Modell für maschinelles Lernen auf der Grundlage der richtigen Daten trainieren und es mit einigen bekannten Materialeigenschaften eines Systems verknüpfen, haben Sie eine wesentlich effizientere Vorgehensweise. Nur ein weiteres Beispiel dafür, wie ML selbst in der fortgeschrittenen Wissenschaft Nischen findet.

Drüben an der CU Boulder sprechen sie darüber, wie KI im Katastrophenmanagement eingesetzt werden kann. Die Technologie kann nützlich sein, um schnell vorherzusagen, wo Ressourcen benötigt werden, Schäden zu kartieren und sogar bei der Ausbildung von Einsatzkräften zu helfen, aber die Menschen zögern (verständlicherweise) davor, sie in Szenarios, in denen es um Leben und Tod geht, einzusetzen.

Professor Amir Behzadan versucht, den Ball hier voranzubringen und sagt: „Menschenzentrierte KI führt zu effektiveren Katastrophenreaktions- und Wiederherstellungspraktiken, indem sie die Zusammenarbeit, das Verständnis und die Inklusivität zwischen Teammitgliedern, Überlebenden und Interessengruppen fördert.“ Sie befinden sich noch in der Workshop-Phase, aber es ist wichtig, gründlich über diese Dinge nachzudenken, bevor man beispielsweise versucht, die Hilfsverteilung nach einem Hurrikan zu automatisieren.

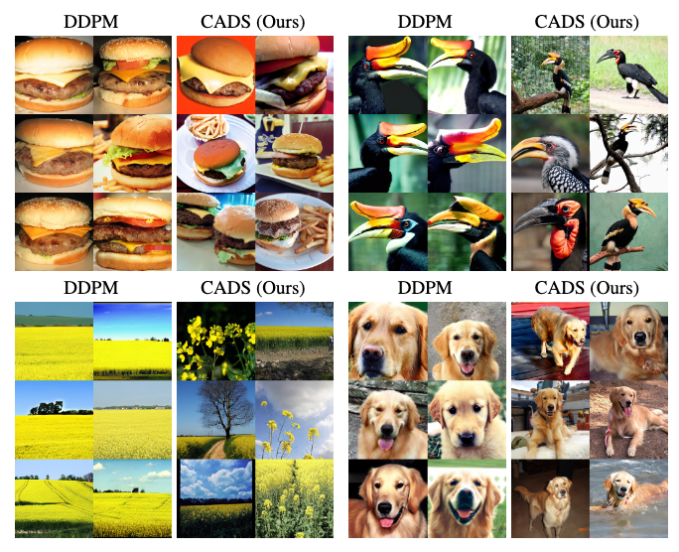

Zum Schluss noch eine interessante Arbeit von Disney ResearchDabei wurde untersucht, wie die Ausgabe von Diffusionsbildgenerierungsmodellen diversifiziert werden kann, die bei einigen Eingabeaufforderungen immer wieder ähnliche Ergebnisse liefern können. Ihre Lösung? „Unsere Sampling-Strategie tempert das Konditionierungssignal, indem sie während der Inferenz geplantes, monoton abnehmendes Gaußsches Rauschen zum Konditionierungsvektor hinzufügt, um Diversität und Konditionsausrichtung auszugleichen.“ Ich selbst könnte es einfach nicht besser ausdrücken.

Das Ergebnis ist eine viel größere Vielfalt an Blickwinkeln, Einstellungen und dem allgemeinen Erscheinungsbild der Bildausgaben. Manchmal möchte man das, manchmal nicht, aber es ist schön, die Option zu haben.