Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie erledigen kann, finden Sie hier eine praktische Zusammenfassung der neuesten Geschichten aus der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht alleine behandelt haben.

Diese Woche überschwemmte Google die Kanäle mit Ankündigungen rund um Gemini, sein neues Flaggschiff-Modell für multimodale KI. Es stellt sich heraus, dass es nicht so beeindruckend ist, wie das Unternehmen ursprünglich dargestellt hat – oder besser gesagt, die „Lite“-Version des Modells (Gemini Pro), die Google diese Woche veröffentlicht hat, ist es nicht. (Es hilft auch nicht, dass Google eine Produktdemo gefälscht hat.) Wir behalten uns ein Urteil über Gemini Ultra, die Vollversion des Modells, vor, bis es Anfang nächsten Jahres seinen Weg in verschiedene Google-Apps und -Dienste findet.

Aber genug der Diskussion über Chatbots. Was eine größere Sache ist, würde ich behaupten, ist eine Finanzierungsrunde, die gerade so in die Arbeitswoche gepasst hat: Mistral-KI 450 Millionen Euro (ca. 484 Millionen US-Dollar) bei einer Bewertung von 2 Milliarden US-Dollar eingesammelt.

Wir haben bereits über Mistral berichtet. Im September veröffentlichte das von Google DeepMind- und Meta-Absolventen mitbegründete Unternehmen sein erstes Modell, den Mistral 7B, von dem es seinerzeit behauptete, dass es andere seiner Größe übertraf. Mistral schloss vor der Spendenaktion am Freitag eine der bislang größten Seed-Runden in Europa ab – und hat noch nicht einmal ein Produkt auf den Markt gebracht.

Nun hat mein Kollege Dominic zu Recht darauf hingewiesen, dass das Schicksal des in Paris ansässigen Unternehmens Mistral für viele, denen Inklusion am Herzen liegt, ein Warnsignal ist. Die Mitbegründer des Startups sind alle weiß und männlich und passen akademisch in das homogene, privilegierte Profil vieler Mitglieder der New York Times. heftig kritisiert Liste von KI-Changemakern.

Gleichzeitig scheinen Investoren Mistral – wie auch seinen zeitweiligen Rivalen, den deutschen Aleph Alpha – als Europas Chance zu betrachten, seine Flagge auf dem (derzeit) sehr fruchtbaren Boden der generativen KI zu hissen.

Bisher waren die bekanntesten und am besten finanzierten generativen KI-Projekte in den USA angesiedelt. OpenAI. Anthropisch. Flexions-KI. Zusammenhängen. Die Liste geht weiter.

Mistrals Glück ist in vielerlei Hinsicht ein Mikrokosmos des Kampfes um die KI-Souveränität. Die Europäische Union (EU) möchte vermeiden, bei einem weiteren Technologiesprung ins Hintertreffen zu geraten, und gleichzeitig Vorschriften erlassen, um die Entwicklung der Technologie zu steuern. Als Deutschlands Vizekanzler und Wirtschaftsminister fungierte zuletzt Robert Habeck zitiert mit den Worten: „Der Gedanke einer eigenen Souveränität im KI-Bereich ist äußerst wichtig.“ [But] Wenn Europa die beste Regulierung hat, aber keine europäischen Unternehmen, haben wir nicht viel gewonnen.“

Die Kluft zwischen Unternehmertum und Regulierung wurde diese Woche deutlich deutlicher, als die EU-Gesetzgeber versuchten, eine Einigung über Maßnahmen zur Begrenzung des Risikos von KI-Systemen zu erzielen. Lobbyisten, angeführt von Mistral, haben in den letzten Monaten auf eine vollständige regulatorische Ausgliederung generativer KI-Modelle gedrängt. Aber die EU-Gesetzgeber haben sich vorerst gegen eine solche Ausnahme gewehrt.

Abgesehen davon hängt viel von Mistral und seinen europäischen Konkurrenten ab; Branchenbeobachter – und Gesetzgeber in den USA – werden zweifellos genau auf die Auswirkungen auf Investitionen achten, wenn die politischen Entscheidungsträger der EU neue Beschränkungen für KI verhängen. Könnte Mistral eines Tages OpenAI mit den geltenden Vorschriften herausfordern? Oder wirken die Vorschriften abschreckend? Es ist noch zu früh, das zu sagen – aber wir sind gespannt darauf, uns selbst zu sehen.

Hier sind einige andere bemerkenswerte KI-Geschichten der letzten Tage:

- Eine neue KI-Allianz: Meta, offen Quelle Tränemöchte seinen Einfluss im anhaltenden Kampf um KI-Mindshare ausbauen. Das soziale Netzwerk gab bekannt, dass es mit IBM zusammenarbeitet, um die AI Alliance zu gründen, einen Branchenverband zur Unterstützung von „offener Innovation“ und „offener Wissenschaft“ in der KI – aber es gibt viele Hintergedanken.

- OpenAI wendet sich an Indien: Ivan und Jagmeet berichten, dass OpenAI mit dem ehemaligen Twitter-Indien-Chef Rishi Jaitly als leitendem Berater zusammenarbeitet, um Gespräche mit der Regierung über die KI-Politik zu erleichtern. OpenAI möchte außerdem ein lokales Team in Indien aufbauen. Jaitly hilft dem KI-Startup dabei, sich in der indischen Politik- und Regulierungslandschaft zurechtzufinden.

- Google führt KI-gestütztes Notizenmachen ein: Googles KI-Notizen-App NotebookLM, die Anfang des Jahres angekündigt wurde, ist jetzt für US-Nutzer ab 18 Jahren verfügbar. Anlässlich des Starts wurde die experimentelle App in Gemini Pro integriert, das neue große Sprachmodell von Google, das laut Google „beim Verstehen und Argumentieren von Dokumenten helfen wird“.

- OpenAI steht unter behördlicher Prüfung: Die enge Beziehung zwischen OpenAI und Microsoft, einem wichtigen Unterstützer und Partner, steht nun im Mittelpunkt einer neuen Untersuchung der Wettbewerbs- und Marktaufsichtsbehörde im Vereinigten Königreich darüber, ob sich die beiden Unternehmen nach dem jüngsten Drama tatsächlich in einer „relevanten Fusionssituation“ befinden . Berichten zufolge prüft die FTC offenbar auch die Investitionen von Microsoft in OpenAI, was eine koordinierte Aktion zu sein scheint.

- KI nett fragen: Wie können Sie Verzerrungen reduzieren, wenn sie aufgrund von Verzerrungen in den Trainingsdaten in ein KI-Modell integriert werden? Anthropic schlägt vor, es freundlich zu bitten, um zu gefallen und nicht zu diskriminieren oder jemand wird uns verklagen. Ja wirklich. Devin hat die ganze Geschichte.

- Meta führt KI-Funktionen ein: Neben anderen KI-bezogenen Updates in dieser Woche erhielt Meta AI, Metas generative KI-Erfahrung, neue Funktionen, darunter die Möglichkeit, Bilder nach Aufforderung zu erstellen, sowie Unterstützung für Instagram Reels. Mit der ersteren Funktion namens „Reimagine“ können Benutzer in Gruppenchats KI-Bilder mit Eingabeaufforderungen neu erstellen, während letztere bei Bedarf auf Reels als Ressource zurückgreifen können.

- Redner bekommt Geld: Das ukrainische Startup für synthetische Stimmen Respeecher – das vielleicht am besten dafür bekannt ist, dass es ausgewählt wurde, James Earl Jones und seine ikonische Darth Vader-Stimme für eine Star Wars-Animationsserie und später einen jüngeren Luke Skywalker für The Mandalorian nachzubilden – hat Erfolg, obwohl es nicht nur Bomben regnet Nach unten auf ihre Stadt, aber eine Welle des Hypes, die manchmal umstrittene Konkurrenten hervorgebracht hat, schreibt Devin.

- Flüssige neuronale Netze: Ein Spin-off des MIT, mitbegründet von der Robotik-Koryphäe Daniela Rus zielt darauf ab, Allzweck-KI-Systeme zu bauen, die auf einem relativ neuen Typ von KI-Modellen basieren, die als flüssiges neuronales Netzwerk bezeichnet werden. Das Unternehmen mit dem Namen Liquid AI sammelte diese Woche in einer Seed-Runde 37,5 Millionen US-Dollar von Unterstützern, darunter der WordPress-Muttergesellschaft Automattic.

Mehr maschinelles Lernen

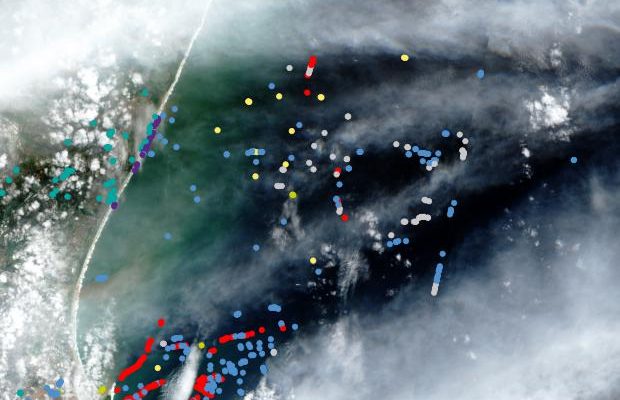

Vorhergesagte schwimmende Plastikstellen vor der Küste Südafrikas.Bildnachweis: EPFL

Orbitalbilder sind ein hervorragender Spielplatz für Modelle des maschinellen Lernens, da Satelliten heutzutage mehr Daten produzieren, als Experten möglicherweise mithalten können. EPFL-Forscher untersuchen Meeresplastik besser identifizieren, ein riesiges Problem, aber es ist sehr schwierig, es systematisch zu verfolgen. Ihr Ansatz ist nicht schockierend – trainieren Sie ein Modell anhand beschrifteter Orbitalbilder –, aber sie haben die Technik verfeinert, sodass ihr System erheblich genauer ist, selbst wenn es Wolkendecke gibt.

Es zu finden ist natürlich nur ein Teil der Herausforderung, und es zu entfernen ist eine andere, aber je besser die Intelligenz von Menschen und Organisationen ist, wenn sie die eigentliche Arbeit ausführen, desto effektiver werden sie sein.

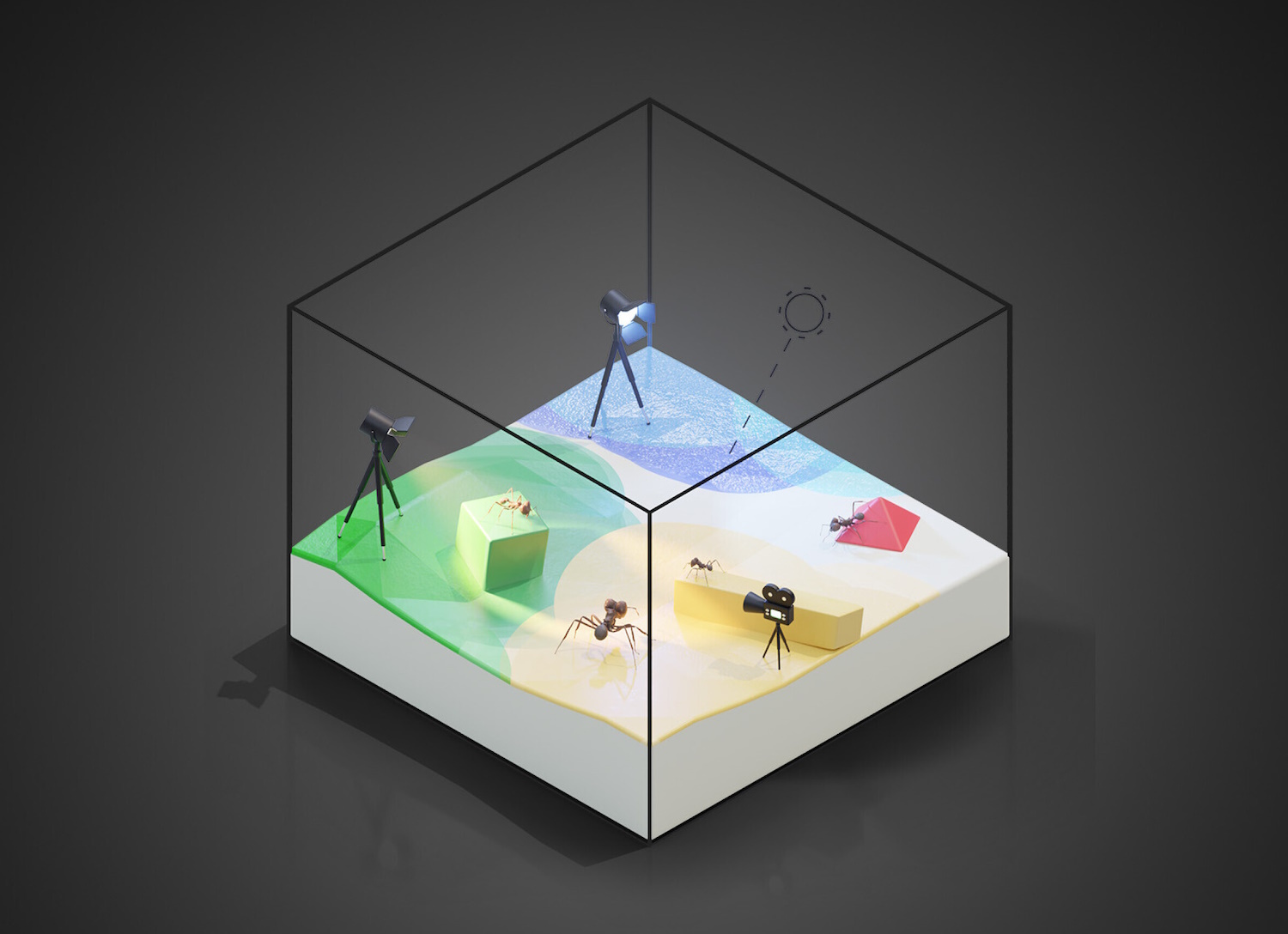

Allerdings verfügt nicht jede Domain über so viele Bilder. Insbesondere Biologen stehen vor der Herausforderung, Tiere zu untersuchen, die nicht ausreichend dokumentiert sind. Beispielsweise möchten sie möglicherweise die Bewegungen einer bestimmten seltenen Insektenart verfolgen, aber aufgrund fehlender Bilder dieses Insekts ist es schwierig, den Prozess zu automatisieren. Eine Gruppe am Imperial College London setzt hierfür in Zusammenarbeit mit der Spieleentwicklungsplattform Unreal maschinelles Lernen ein.

Bildnachweis: Imperial College London

Durch die Erstellung fotorealistischer Szenen in Unreal und deren Bestückung mit 3D-Modellen des betreffenden Lebewesens, sei es eine Ameise, eine Stabheuschrecke oder etwas Größeres, können sie beliebige Mengen an Trainingsdaten für Modelle für maschinelles Lernen erstellen. Obwohl das Computer-Vision-System auf synthetische Daten trainiert wurde, kann es in realen Filmaufnahmen, wie z. B. deren, immer noch sehr effektiv sein Video zeigt an.

Sie können ihren Artikel in Nature Communications lesen.

Allerdings sind nicht alle generierten Bilder so zuverlässig, wie Forscher der University of Washington herausfanden. Sie veranlassten den Open-Source-Bildgenerator Stable Diffusion 2.1 systematisch dazu, Bilder einer „Person“ mit verschiedenen Einschränkungen oder Standorten zu erstellen. Sie zeigten, dass der Begriff „Person“ überproportional mit hellhäutigen, westlichen Männern assoziiert wird.

Darüber hinaus führten bestimmte Orte und Nationalitäten zu beunruhigenden Mustern, wie etwa sexualisierten Bildern von Frauen aus lateinamerikanischen Ländern und „einer nahezu vollständigen Auslöschung nichtbinärer und indigener Identitäten“. Wenn man beispielsweise nach Bildern von „einer Person aus Ozeanien“ fragt, erhält man weiße Männer und keine indigenen Völker, obwohl es letztere in der Region zahlreich gibt (ganz zu schweigen von all den anderen nicht-weißen Menschen). Es ist alles noch in Arbeit und es ist wichtig, sich der in den Daten enthaltenen Verzerrungen bewusst zu sein.

Viele Akademiker und ihre Studenten beschäftigen sich mit dem Umgang mit voreingenommenen und fragwürdig nützlichen Modellen. Dieses interessante Gespräch mit dem Yale-Englischprofessor Ben Glaser ist eine erfrischend optimistische Sichtweise darauf, wie Dinge wie ChatGPT konstruktiv genutzt werden können:

Wenn Sie mit einem Chatbot sprechen, erhalten Sie dieses verschwommene, seltsame Bild der Kultur zurück. Möglicherweise erhalten Sie Kontrapunkte zu Ihren Ideen, und dann müssen Sie bewerten, ob diese Kontrapunkte oder unterstützenden Beweise für Ihre Ideen tatsächlich gut sind. Und das Lesen dieser Ergebnisse erfordert eine Art Lese- und Schreibkompetenz. Die Schüler dieser Klasse erwerben einen Teil dieser Lese- und Schreibkompetenz.

Wenn alles zitiert ist und Sie durch aufwändiges Hin und Her oder Programmieraufwand unter Einbeziehung dieser Tools ein kreatives Werk entwickeln, machen Sie einfach etwas Wildes und Interessantes.

Und wann sollte man ihnen, sagen wir, einem Krankenhaus vertrauen? Die Radiologie ist ein Bereich, in dem KI häufig eingesetzt wird, um Probleme bei Scans des Körpers schnell zu erkennen, aber sie ist alles andere als unfehlbar. Woher sollen Ärzte also wissen, wann sie dem Modell vertrauen sollten und wann nicht? Das MIT scheint zu glauben, dass sie diesen Teil auch automatisieren können – aber keine Sorge, es ist keine weitere KI. Stattdessen handelt es sich um einen standardmäßigen, automatisierten Onboarding-Prozess, der dabei hilft, festzustellen, wann ein bestimmter Arzt oder eine bestimmte Aufgabe ein KI-Tool hilfreich findet und wann es im Weg ist.

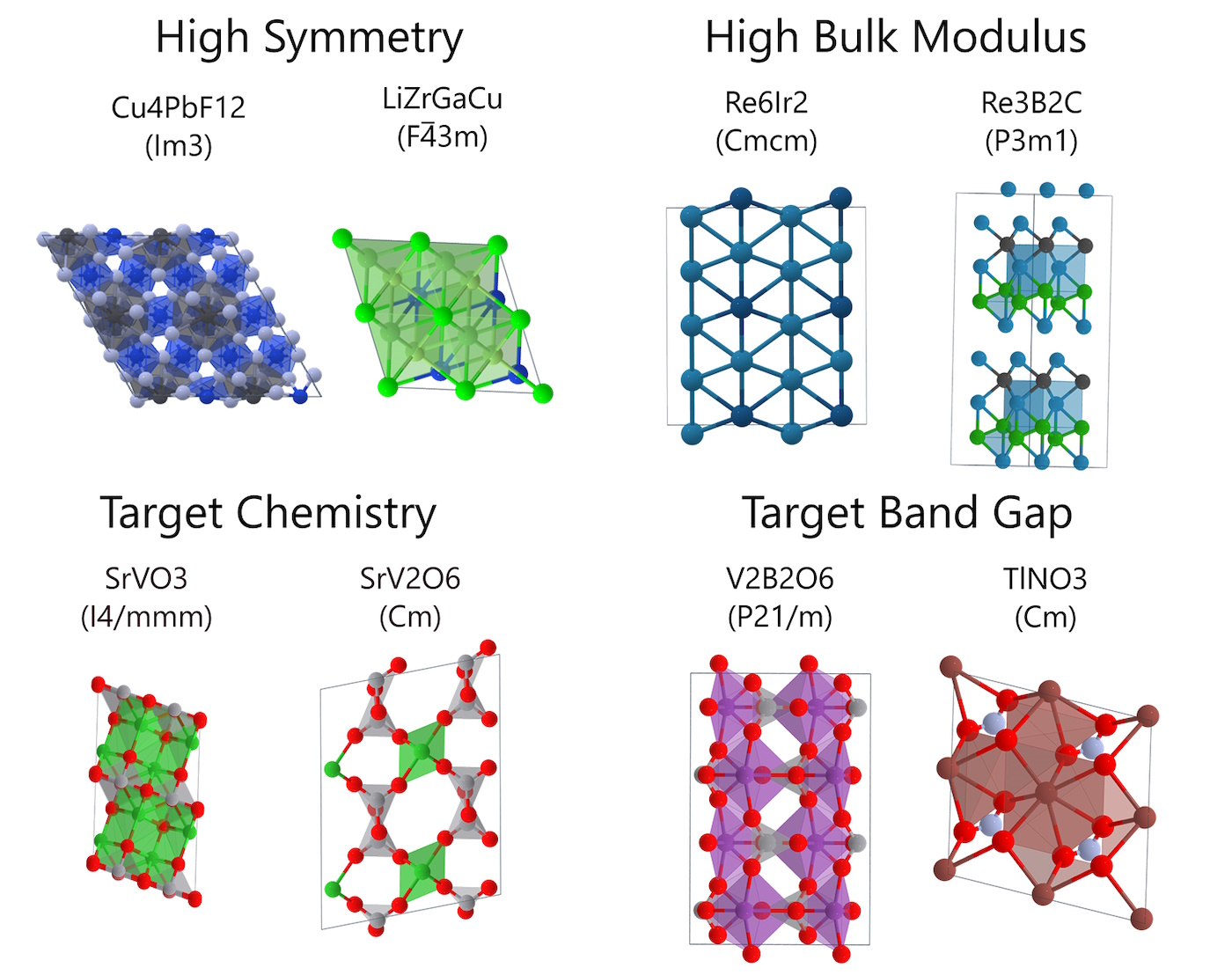

Von KI-Modellen wird zunehmend verlangt, mehr als nur Text und Bilder zu generieren. Materialien sind ein Bereich, in dem wir viel Bewegung gesehen haben – Modelle sind großartig darin, wahrscheinliche Kandidaten für bessere Katalysatoren, Polymerketten usw. zu finden. Startups machen mit, aber Microsoft hat gerade auch ein Modell namens MatterGen veröffentlicht das sei „speziell für die Erzeugung neuartiger, stabiler Materialien konzipiert“.

Bildnachweis: Microsoft

Wie Sie im Bild oben sehen können, können Sie auf viele verschiedene Qualitäten abzielen, von Magnetismus über Reaktivität bis hin zur Größe. Es ist kein Flubber-ähnlicher Unfall oder Tausende von Labordurchläufen erforderlich – dieses Modell könnte Ihnen dabei helfen, innerhalb von Stunden statt Monaten ein geeignetes Material für ein Experiment oder Produkt zu finden.

Auch Google DeepMind und Berkeley Lab arbeiten an so etwas. Dies wird in der Materialindustrie schnell zur Standardpraxis.