Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie erledigen kann, finden Sie hier eine praktische Zusammenfassung der Geschichten der letzten Woche in der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht alleine behandelt haben.

Falls es noch nicht offensichtlich war: Die Wettbewerbslandschaft in der KI – insbesondere im Teilbereich der generativen KI – ist brandheiß. Und es wird heißer. Diese Woche hat Dropbox seinen ersten Corporate-Venture-Fonds, Dropbox Ventures, aufgelegt, der sich nach Angaben des Unternehmens auf Startups konzentrieren wird, die KI-gestützte Produkte entwickeln, die „die Zukunft der Arbeit gestalten“. Um nicht zu übertreffen, startete AWS ein 100-Millionen-Dollar-Programm zur Finanzierung generativer KI-Initiativen, die von seinen Partnern und Kunden vorangetrieben werden.

Natürlich wird im KI-Bereich viel Geld ausgegeben. Salesforce Ventures, die VC-Abteilung von Salesforce, plant, 500 Millionen US-Dollar in Startups zu investieren, die generative KI-Technologien entwickeln. Werktag in letzter Zeit hat seinen bestehenden VC-Fonds um 250 Millionen US-Dollar aufgestockt, um Start-ups im Bereich KI und maschinelles Lernen zu unterstützen. Und Accenture und PwC haben angekündigt, dass sie planen, 3 Milliarden US-Dollar bzw. 1 Milliarde US-Dollar in KI zu investieren.

Aber man fragt sich, ob Geld die Lösung für die noch offenen Herausforderungen im KI-Bereich ist.

In einer aufschlussreichen Podiumsdiskussion während einer Bloomberg-Konferenz in San Francisco diese Woche vertrat Meredith Whittaker, Präsidentin der sicheren Messaging-App Signal, die Ansicht, dass die Technologie, die einigen der derzeit angesagtesten KI-Apps zugrunde liegt, gefährlich undurchsichtig wird. Sie nannte als Beispiel jemanden, der in eine Bank geht und um einen Kredit bittet.

Dieser Person kann der Kredit verweigert werden und sie hat „keine Ahnung, dass da ein System steckt“. [the] „Zurück, wahrscheinlich von einer Microsoft-API unterstützt, die auf der Grundlage ausgesuchter sozialer Medien festgestellt hat, dass ich nicht kreditwürdig bin“, sagte Whittaker. „Ich werde es nie erfahren [because] Es gibt für mich keinen Mechanismus, um das zu wissen.“

Es geht nicht um das Kapital. Es liege vielmehr an der aktuellen Machthierarchie, sagt Whittaker.

„Ich sitze seit etwa 15, 20 Jahren am Tisch. Ich habe gewesen am Tisch. Ohne Macht am Tisch zu sitzen ist nichts“, fuhr sie fort.

Natürlich ist es weitaus schwieriger, einen Strukturwandel herbeizuführen, als nach Geld zu suchen – vor allem, wenn der Strukturwandel nicht unbedingt den Mächtigen zugute kommt. Und Whittaker warnt davor, was passieren könnte, wenn es nicht genügend Gegenwehr gibt.

Während sich der Fortschritt in der KI beschleunigt, nehmen auch die gesellschaftlichen Auswirkungen zu, und wir werden weiterhin einen „Hype-erfüllten Weg in Richtung KI“ beschreiten, sagte sie, „wo diese Macht unter dem Deckmantel der Intelligenz verankert und naturalisiert ist und wir überwacht werden.“ Der Punkt [of having] sehr, sehr wenig Entscheidungsfreiheit über unser individuelles und kollektives Leben.“

Das sollen Geben Sie der Branche eine Pause. Ob es tatsächlich so ist Wille ist eine andere Sache. Darüber werden wir wahrscheinlich sprechen hören, wenn sie im September bei Disrupt die Bühne betritt.

Hier sind die anderen bemerkenswerten KI-Schlagzeilen der letzten Tage:

- Die KI von DeepMind steuert Roboter: DeepMind gibt an, ein KI-Modell namens RoboCat entwickelt zu haben, das eine Reihe von Aufgaben über verschiedene Modelle von Roboterarmen hinweg ausführen kann. Das allein ist nicht besonders neu. Aber DeepMind behauptet, dass das Modell das erste ist, das in der Lage ist, mehrere Aufgaben zu lösen und sich an sie anzupassen, und zwar unter Verwendung verschiedener, realer Roboter.

- Roboter lernen von YouTube: Apropos Roboter: Deepak Pathak, Assistenzprofessor am CMU Robotics Institute, diese Woche präsentiert VRB (Vision-Robotics Bridge), ein KI-System, das entwickelt wurde, um Robotersysteme durch das Ansehen einer Aufnahme eines Menschen zu trainieren. Der Roboter sucht nach einigen wichtigen Informationen, einschließlich Kontaktpunkten und Flugbahn, und versucht dann, die Aufgabe auszuführen.

- Otter steigt in das Chatbot-Spiel ein: Automatischer Transkriptionsdienst Otter kündigte diese Woche einen neuen KI-gestützten Chatbot an, der es Teilnehmern ermöglicht, während und nach einem Meeting Fragen zu stellen und ihnen bei der Zusammenarbeit mit Teamkollegen zu helfen.

- EU fordert KI-Regulierung: Die europäischen Regulierungsbehörden stehen an einem Scheideweg darüber, wie KI in der Region reguliert – und letztendlich kommerziell und nichtkommerziell – genutzt werden soll. Diese Woche hat die größte Verbrauchergruppe der EU, die Europäische Verbraucherorganisation (BEUC), brachte seine eigene Position ein: Hören Sie auf, Ihre Schritte zu schleppen, und „leiten Sie jetzt dringende Untersuchungen zu den Risiken generativer KI ein“, hieß es.

- Vimeo führt KI-gestützte Funktionen ein: Diese Woche kündigte Vimeo eine Reihe von KI-gestützten Tools an, die Benutzern dabei helfen sollen, Skripte zu erstellen, Filmmaterial mit einem integrierten Teleprompter aufzuzeichnen und lange Pausen und unerwünschte Unstimmigkeiten wie „Ahs“ und „Ähms“ aus den Aufnahmen zu entfernen.

- Kapital für synthetische Stimmen: ElfLabs, die virale KI-gestützte Plattform zur Erstellung synthetischer Stimmen, hat in einer neuen Finanzierungsrunde 19 Millionen US-Dollar eingesammelt. ElevenLabs nahm nach seiner Einführung Ende Januar ziemlich schnell Fahrt auf. Aber die Werbung war nicht immer positiv – besonders einmal nicht schlechte Schauspieler begannen, die Plattform für ihre eigenen Zwecke zu nutzen.

- Audio in Text umwandeln: Gladia, ein französisches KI-Startup, hat eine Plattform gestartet, die das Whisper-Transkriptionsmodell von OpenAI nutzt, um – über eine API – beliebige Audiodaten nahezu in Echtzeit in Text umzuwandeln. Gladia verspricht, eine Stunde Audio für 0,61 US-Dollar zu transkribieren, wobei der Transkriptionsprozess etwa 60 Sekunden dauert.

- Harness setzt auf generative KI: Geschirr, ein Startup, das ein Toolkit entwickelt, um Entwicklern dabei zu helfen, effizienter zu arbeiten, hat diese Woche seine Plattform mit ein wenig KI ausgestattet. Jetzt kann Harness automatisch Build- und Bereitstellungsfehler beheben, Sicherheitslücken finden und beheben und Vorschläge unterbreiten, um die Cloud-Kosten unter Kontrolle zu bringen.

Andere maschinelles Lernen

Diese Woche war CVPR in Vancouver, Kanada, und ich wünschte, ich hätte hingehen können, denn die Vorträge und Papiere sehen super interessant aus. Wenn Sie nur eines sehen können, schauen Sie es sich an Keynote von Yejin Choi über die Möglichkeiten, Unmöglichkeiten und Paradoxien der KI.

Bildnachweis: CVPR/YouTube

Der UW-Professor und MacArthur-Genius-Stipendiat ging zunächst auf einige unerwartete Einschränkungen der heute leistungsfähigsten Modelle ein. Insbesondere ist GPT-4 wirklich schlecht in der Multiplikation. Erstaunlicherweise gelingt es ihm nicht, das Produkt zweier dreistelliger Zahlen korrekt zu finden, obwohl es mit ein wenig Überredung in 95 % der Fälle gelingt. Warum ist es wichtig, dass ein Sprachmodell keine Mathematik kann, fragen Sie? Denn der gesamte KI-Markt basiert derzeit auf der Idee, dass sich Sprachmodelle gut auf viele interessante Aufgaben übertragen lassen, darunter Dinge wie Steuern oder Buchhaltung. Chois Argument war, dass wir nach den Grenzen der KI suchen und nach innen arbeiten sollten und nicht umgekehrt, da uns dies mehr über ihre Fähigkeiten verrät.

Die anderen Teile ihres Vortrags waren ebenso interessant und regten zum Nachdenken an. Das Ganze könnt ihr euch hier ansehen.

Rod Brooks, vorgestellt als „Jäger des Hypes“, gab eine interessante Geschichte einiger der Kernkonzepte des maschinellen Lernens – Konzepte, die nur deshalb neu erscheinen, weil die meisten Menschen, die sie anwenden, noch nicht da waren, als sie erfunden wurden! Im Rückblick auf die Jahrzehnte geht er auf McCulloch, Minsky und sogar Hebb ein – und zeigt, wie die Ideen weit über ihre Zeit hinaus relevant blieben. Es ist eine hilfreiche Erinnerung daran, dass maschinelles Lernen ein Bereich ist, der bis in die Nachkriegszeit auf den Schultern von Giganten steht.

Viele, viele Beiträge wurden beim CVPR eingereicht und dort präsentiert, und es ist reduktiv, sich nur auf die Preisträger zu konzentrieren, aber dies ist eine Nachrichtenzusammenfassung und keine umfassende Literaturübersicht. Hier ist also, was die Juroren der Konferenz für das Interessanteste hielten:

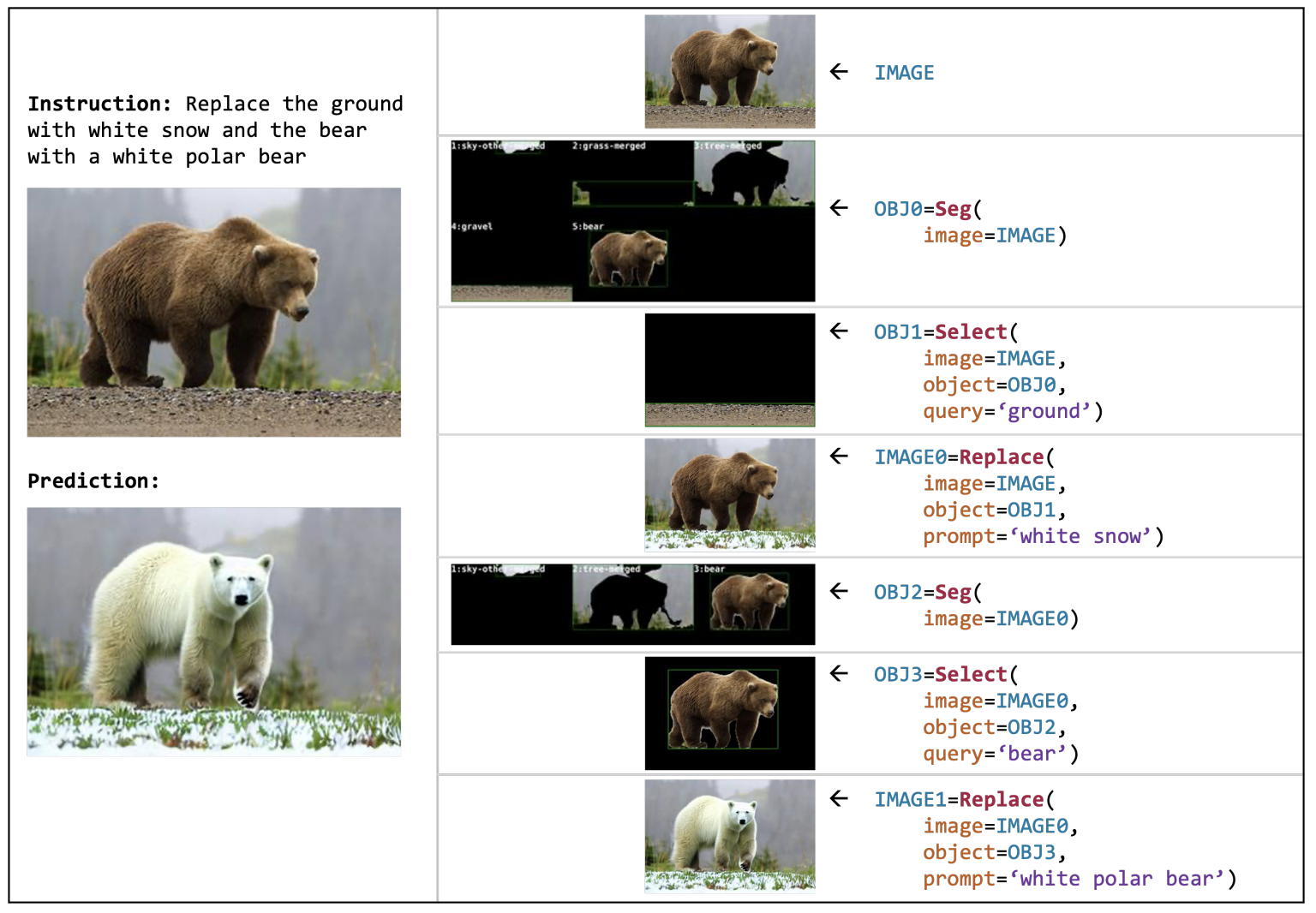

Bildnachweis: AI2

VISPROG, von Forschern bei AI2, ist eine Art Metamodell, das mithilfe einer Mehrzweck-Code-Toolbox komplexe visuelle Manipulationsaufgaben ausführt. Angenommen, Sie haben ein Bild von einem Grizzlybären auf etwas Gras (wie abgebildet) – Sie können ihm sagen, dass er einfach „den Bären durch einen Eisbären auf Schnee ersetzen“ soll, und schon beginnt es zu funktionieren. Es identifiziert die Teile des Bildes, trennt sie visuell, sucht und findet oder generiert einen passenden Ersatz und fügt das Ganze intelligent wieder zusammen, ohne dass eine weitere Eingabe seitens des Benutzers erforderlich ist. Die „Verbesserungs“-Benutzeroberfläche von Blade Runner sieht langsam völlig langweilig aus. Und das ist nur eine seiner vielen Möglichkeiten.

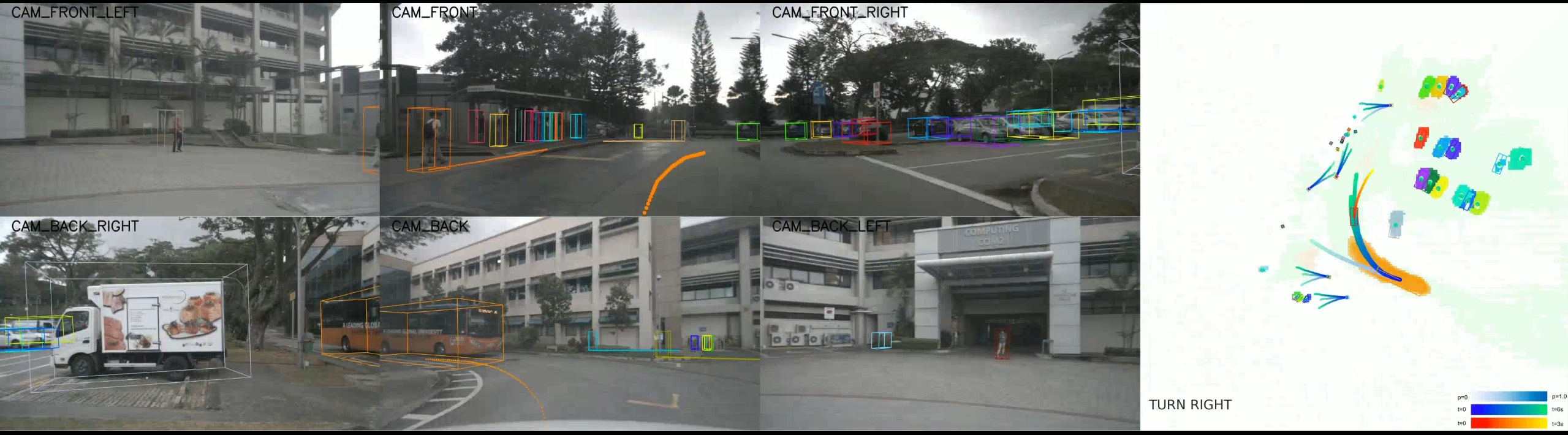

„Planungsorientiertes autonomes Fahren“ von einer multi-institutionellen chinesischen Forschungsgruppe, versucht, die verschiedenen Teile des eher stückweisen Ansatzes, den wir für selbstfahrende Autos gewählt haben, zu vereinheitlichen. Normalerweise gibt es eine Art schrittweisen Prozess der „Wahrnehmung, Vorhersage und Planung“, von dem jeder eine Reihe von Unteraufgaben haben kann (z. B. Segmentierung von Personen, Identifizierung von Hindernissen usw.). Ihr Modell versucht, all dies in einem Modell zusammenzufassen, ähnlich wie die multimodalen Modelle, die wir sehen und die Text, Audio oder Bilder als Eingabe und Ausgabe verwenden können. In ähnlicher Weise vereinfacht dieses Modell in gewisser Weise die komplexen gegenseitigen Abhängigkeiten eines modernen autonomen Fahrstapels.

DynIBaR zeigt eine hochwertige und robuste Methode zur Interaktion mit Videos mithilfe „dynamischer Neural Radiance Fields“ oder NeRFs. Ein tiefes Verständnis der Objekte im Video ermöglicht Dinge wie Stabilisierung, Dolly-Bewegungen und andere Dinge, von denen Sie im Allgemeinen nicht erwarten, dass sie möglich sind, wenn das Video bereits aufgezeichnet wurde. Wieder… „verbessern“. Das ist definitiv die Art von Dingen, für die Apple Sie anstellt und die Sie dann auf der nächsten WWDC anerkennen.

DreamBooth Sie erinnern sich vielleicht an etwas früher in diesem Jahr, als die Seite des Projekts online ging. Es ist das bisher beste System, um Deepfakes zu erstellen. Natürlich ist es wertvoll und leistungsstark, diese Art von Bildoperationen durchzuführen, ganz zu schweigen davon, dass es Spaß macht, und Forscher wie die von Google arbeiten daran, es nahtloser und realistischer zu machen. Konsequenzen … später vielleicht.

Der Preis für die beste studentische Arbeit geht an eine Methode zum Vergleichen und Anpassen von Netzen oder 3D-Punktwolken – ehrlich gesagt ist sie für mich zu technisch, als dass ich sie erklären könnte, aber es handelt sich hierbei um eine wichtige Funktion für die Wahrnehmung in der realen Welt, und Verbesserungen sind willkommen. Schauen Sie sich das Papier hier an, um Beispiele und weitere Informationen zu erhalten.

Nur noch zwei Pluspunkte: Intel hat gezeigt, was los ist dieses interessante Modell, LDM3D, zum Generieren von 3D-360-Bildern wie virtuellen Umgebungen. Wenn man sich also im Metaversum befindet und sagt: „Bringt uns in eine überwucherte Ruine im Dschungel“, wird bei Bedarf einfach ein neues erstellt.

Und Meta wurde veröffentlicht ein Sprachsynthese-Tool namens Voicebox Das ist super gut darin, Merkmale von Stimmen zu extrahieren und zu reproduzieren, selbst wenn die Eingabe nicht sauber ist. Normalerweise benötigen Sie für die Sprachreplikation eine gute Menge und Vielfalt an sauberen Sprachaufnahmen, aber Voicebox schafft es besser als viele andere, mit weniger Daten (denken Sie an 2 Sekunden). Glücklicherweise behalten sie diesen Geist vorerst in der Flasche. Für diejenigen, die glauben, dass ihre Stimme möglicherweise geklont werden muss, schauen Sie sich Acapela an.