Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie erledigen kann, finden Sie hier eine praktische Zusammenfassung der neuesten Geschichten aus der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht alleine behandelt haben.

Diese Woche hat sich der Nachrichtenzyklus in AI vor der Weihnachtszeit endlich (endlich!) etwas beruhigt. Das heißt aber nicht, dass es einen Mangel gab, über den es zu schreiben gab, ein Segen und ein Fluch für diesen schlaflosen Reporter.

Eine besondere Schlagzeile der AP fiel mir heute Morgen ins Auge: „KI-Bildgeneratoren werden auf explizite Fotos von Kindern trainiert.“ Der Kern der Geschichte ist LAION, ein Datensatz, der zum Trainieren vieler beliebter Open-Source- und kommerzieller KI-Bildgeneratoren verwendet wird, darunter Stable Diffusion und Bild, enthält Tausende Bilder von mutmaßlichem sexuellem Kindesmissbrauch. Eine in Stanford ansässige Überwachungsgruppe, das Stanford Internet Observatory, arbeitete mit Wohltätigkeitsorganisationen zur Missbrauchsbekämpfung zusammen, um das illegale Material zu identifizieren und die Links den Strafverfolgungsbehörden zu melden.

Jetzt hat LAION, eine gemeinnützige Organisation, ihre Trainingsdaten gelöscht und sich verpflichtet, die beanstandeten Materialien vor der erneuten Veröffentlichung zu entfernen. Der Vorfall verdeutlicht jedoch, wie wenig über generative KI-Produkte nachgedacht wird, da der Wettbewerbsdruck zunimmt.

Dank der Verbreitung von Tools zur Erstellung von KI-Modellen ohne Code wird es furchtbar einfach, generative KI auf jedem erdenklichen Datensatz zu trainieren. Für Startups und Technologiegiganten ist es ein Segen, solche Modelle auf den Markt zu bringen. Mit der niedrigeren Eintrittsbarriere steigt jedoch die Versuchung, Ethik zugunsten einer beschleunigten Markteinführung aufzugeben.

Ethik ist schwer – das lässt sich nicht leugnen. Das Durchforsten der Tausenden problematischen Bilder in LAION, um das Beispiel dieser Woche zu nehmen, wird nicht über Nacht geschehen. Und im Idealfall erfordert die ethische Entwicklung von KI die Zusammenarbeit mit allen relevanten Interessengruppen, einschließlich Organisationen, die Gruppen vertreten, die häufig an den Rand gedrängt werden und von KI-Systemen negativ beeinflusst werden.

Die Branche ist voll von Beispielen für KI-Release-Entscheidungen, die im Hinblick auf Aktionäre und nicht auf Ethiker getroffen werden. Nehmen Sie zum Beispiel Bing Chat (jetzt Microsoft Copilot), den KI-gestützten Chatbot von Microsoft auf Bing, der bei Start verglichen einen Journalisten mit Hitler und beleidigten ihr Aussehen. Im Oktober waren ChatGPT und Bard, Googles ChatGPT-Konkurrent, still Geben veraltete, rassistische medizinische Beratung. Und die neueste Version von OpenAIs Bildgenerator DALL-E zeigt Beweis des Anglozentrismus.

Es genügt zu sagen, dass das Streben nach KI-Überlegenheit – oder zumindest der Wall Street-Vorstellung von KI-Überlegenheit – Schaden anrichtet. Vielleicht gibt es mit der Verabschiedung der KI-Verordnungen der EU, die Geldstrafen für die Nichteinhaltung bestimmter KI-Richtlinien drohen, etwas Hoffnung am Horizont. Aber der Weg, der noch vor uns liegt, ist tatsächlich lang.

Hier sind einige andere bemerkenswerte KI-Geschichten der letzten Tage:

Vorhersagen für KI im Jahr 2024: Devin legt seine Prognosen für die KI im Jahr 2024 dar und geht unter anderem darauf ein, wie sich KI auf die US-Vorwahlen auswirken könnte und was als nächstes für OpenAI ansteht.

Gegen Pseudanthropie: Devin schrieb auch, dass es der KI verboten werden sollte, menschliches Verhalten nachzuahmen.

Microsoft Copilot erhält Musikerstellung: Copilot, der KI-gestützte Chatbot von Microsoft, kann dank einer Integration mit der GenAI-Musik-App Suno jetzt Songs komponieren.

Gesichtserkennung bei Rite Aid: Rite Aid ist der Einsatz von Gesichtserkennungstechnologie für fünf Jahre untersagt, nachdem die Federal Trade Commission festgestellt hatte, dass der „rücksichtslose Einsatz von Gesichtsüberwachungssystemen“ durch den US-Drogerieriesen die Kunden gedemütigt und ihre „sensiblen Informationen gefährdet“ habe.

EU bietet Rechenressourcen an: Die EU erweitert ihren ursprünglich im September angekündigten und letzten Monat gestarteten Plan, einheimische KI-Start-ups zu unterstützen, indem sie ihnen Zugang zu Rechenleistung für Modelltraining auf den Supercomputern der Union verschafft.

OpenAI verleiht dem Vorstand neue Befugnisse: OpenAI erweitert seine internen Sicherheitsprozesse, um die Bedrohung durch schädliche KI abzuwehren. Eine neue „Sicherheitsberatungsgruppe“ wird über den technischen Teams sitzen und Empfehlungen an die Führung richten, und dem Vorstand wurde ein Vetorecht eingeräumt.

Fragen und Antworten mit Ken Goldberg von der UC Berkeley: Für seinen regelmäßigen Actuator-Newsletter traf sich Brian mit Ken Goldberg, einem Professor an der UC Berkeley, einem Startup-Gründer und erfahrenen Robotiker, um über humanoide Roboter und allgemeinere Trends in der Robotikbranche zu sprechen.

CIOs lassen es mit Gen-KI langsam angehen: Ron schreibt, dass CIOs zwar unter dem Druck stehen, die Art von Erfahrungen zu liefern, die die Leute sehen, wenn sie online mit ChatGPT spielen, die meisten jedoch einen bewussten und vorsichtigen Ansatz bei der Einführung der Technologie für das Unternehmen verfolgen.

Nachrichtenverleger verklagen Google wegen KI: Eine von mehreren Nachrichtenverlagen eingereichte Sammelklage wirft Google „Absaugung“ vor[ing] „off“-Nachrichteninhalte durch wettbewerbswidrige Mittel, teilweise durch KI-Technologie wie Googles Search Generative Experience (SGE) und den Bard-Chatbot.

OpenAI-Tinten-Deal mit Axel Springer: Apropos Verlage: OpenAI hat einen Vertrag mit Axel Springer, dem in Berlin ansässigen Eigentümer von Publikationen wie Business Insider und Politico, unterzeichnet, um seine generativen KI-Modelle auf die Inhalte des Verlags zu trainieren und aktuelle, von Axel Springer veröffentlichte Artikel zu ChatGPT hinzuzufügen.

Google bringt Gemini an mehr Orte: Google hat seine Gemini-Modelle in weitere seiner Produkte und Dienstleistungen integriert, darunter seine von Vertex AI verwaltete KI-Entwicklungsplattform und AI Studio, das Tool des Unternehmens zum Erstellen von KI-basierten Chatbots und anderen Erfahrungen in dieser Richtung.

Mehr maschinelles Lernen

Sicherlich ist es die wildeste (und am leichtesten zu missdeutende) Forschung der letzten ein oder zwei Wochen life2vec, einer dänischen Studie, die unzählige Datenpunkte im Leben eines Menschen nutzt, um vorherzusagen, wie ein Mensch ist und wann er sterben wird. Grob!

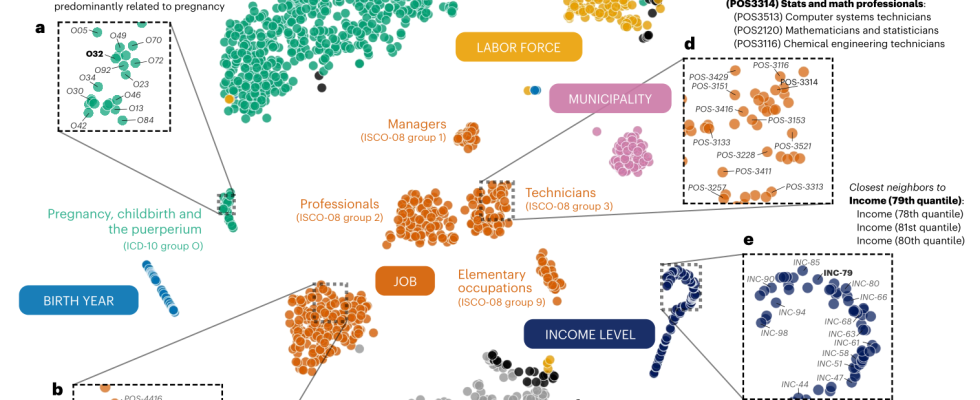

Visualisierung der Abbildung verschiedener relevanter Lebenskonzepte und -ereignisse durch life2vec.

Die Studie erhebt keinen Anspruch auf orakelhafte Genauigkeit (sagen wir übrigens dreimal so schnell), sondern will vielmehr zeigen, dass, wenn unser Leben die Summe unserer Erfahrungen ist, diese Wege mithilfe aktueller Techniken des maschinellen Lernens einigermaßen extrapoliert werden können. Anhand von Erziehung, Bildung, Arbeit, Gesundheit, Hobbys und anderen Kennzahlen kann man nicht nur vernünftigerweise vorhersagen, ob jemand beispielsweise introvertiert oder extrovertiert ist, sondern auch, wie sich diese Faktoren auf die Lebenserwartung auswirken können. Wir sind hier noch nicht ganz auf dem Niveau der „Präkriminalität“, aber Sie können darauf wetten, dass die Versicherungsgesellschaften es kaum erwarten können, diese Arbeit zu lizenzieren.

Eine weitere große Behauptung wurde von CMU-Wissenschaftlern aufgestellt, die ein System namens Coscientist entwickelt haben, einen LLM-basierten Assistenten für Forscher, der viele Laborarbeiten autonom erledigen kann. Derzeit ist es auf bestimmte Bereiche der Chemie beschränkt, aber genau wie Wissenschaftler werden Modelle wie diese Spezialisten sein.

Der leitende Forscher Gabe Gomes sagte gegenüber Nature: „Der Moment, als ich sah, wie eine nicht-organische Intelligenz in der Lage war, eine von Menschen erfundene chemische Reaktion autonom zu planen, zu entwerfen und auszuführen, das war erstaunlich.“ Es war ein „heiliger Mist“-Moment.“ Im Grunde wird ein LLM wie GPT-4 verwendet, das auf chemische Dokumente abgestimmt ist, um gängige Reaktionen, Reagenzien und Verfahren zu identifizieren und durchzuführen. Sie müssen einem Labortechniker also nicht sagen, dass er vier Chargen eines Katalysators synthetisieren soll – die KI kann es tun, und Sie müssen nicht einmal ihre Hand halten.

Auch die KI-Forscher von Google hatten eine großartige Woche und sind in einige interessante Grenzgebiete vorgedrungen. FunSearch Klingt vielleicht wie Google für Kinder, ist aber eigentlich die Abkürzung für Funktionssuche, die wie Coscientist in der Lage ist, mathematische Entdeckungen zu machen und dabei zu helfen. Um Halluzinationen vorzubeugen, wird interessanterweise (wie andere in letzter Zeit) ein passendes Paar von KI-Modellen verwendet, ähnlich wie die „alte“ GAN-Architektur. Der eine theoretisiert, der andere bewertet.

Während FunSearch keine bahnbrechenden neuen Entdeckungen machen wird, kann es das Vorhandene nutzen und es an neuen Stellen verfeinern oder erneut anwenden. So könnte eine Funktion, die eine Domain nutzt, einer anderen aber nicht bekannt ist, zur Verbesserung eines Industriestandards genutzt werden Algorithmus.

StyleDrop ist ein praktisches Tool für Leute, die bestimmte Stile durch generative Bilder reproduzieren möchten. Das Problem (aus Sicht der Forscher) besteht darin, dass, wenn Sie einen Stil im Kopf haben (z. B. „Pastellfarben“) und ihn beschreiben, das Modell zu viele Unterstile von „Pastellfarben“ enthält, aus denen Sie schöpfen können, sodass die Ergebnisse so ausfallen unvorhersehbar. Mit StyleDrop können Sie ein Beispiel für den Stil bereitstellen, an den Sie denken, und das Modell wird seine Arbeit darauf aufbauen – es handelt sich im Grunde genommen um eine äußerst effiziente Feinabstimmung.

Bildnachweis: Google

Der Blog-Beitrag und das Papier zeigen, dass es ziemlich robust ist und einen Stil von jedem Bild, sei es ein Foto, ein Gemälde, ein Stadtbild oder ein Katzenporträt, auf jeden anderen Bildtyp anwendet, sogar auf das Alphabet (was aus irgendeinem Grund notorisch schwierig ist).

Google schreitet auch im generativen Videospiel mit VideoPoet voran, das eine LLM-Basis verwendet (wie alles andere heutzutage … was soll man sonst noch verwenden?), um eine Reihe von Videoaufgaben zu erledigen, Texte oder Bilder in Videos umzuwandeln und so zu erweitern oder Stilisierung vorhandener Videos usw. Die Herausforderung besteht hier, wie jedes Projekt deutlich macht, nicht einfach darin, eine Reihe von Bildern herzustellen, die sich aufeinander beziehen, sondern sie über längere Zeiträume (z. B. mehr als eine Sekunde) und mit großen Bewegungen und Veränderungen kohärent zu machen.

Bildnachweis: Google

VideoPoet Es scheint, als würde der Ball nach vorne bewegt, aber wie Sie sehen, sind die Ergebnisse immer noch ziemlich seltsam. Aber so entwickeln sich diese Dinge: Zuerst sind sie unzureichend, dann sind sie seltsam, dann sind sie unheimlich. Vermutlich verlassen sie das Unheimliche irgendwann, aber so richtig angekommen ist es bisher noch nicht.

Auf der praktischen Seite haben Schweizer Forscher KI-Modelle zur Schneemessung eingesetzt. Normalerweise würde man sich auf Wetterstationen verlassen, aber diese können weit voneinander entfernt sein und wir haben all diese schönen Satellitendaten, oder? Rechts. Deshalb hat das ETHZ-Team öffentliche Satellitenbilder der Sentinel-2-Konstellation aufgenommen, aber wie der Leiter Konrad Schindler es ausdrückt: „Allein der Blick auf die weißen Teile auf den Satellitenbildern sagt uns nicht sofort, wie tief der Schnee ist.“

Also haben sie Geländedaten für das ganze Land von ihrem Bundesamt für Topographie (wie unserem USGS) eingegeben und das System darauf trainiert, Schätzungen nicht nur auf der Grundlage weißer Bildteile, sondern auch auf Basis wahrer Daten und Tendenzen wie Schmelzmustern vorzunehmen. Die daraus resultierende Technologie wird von ExoLabs kommerzialisiert, das ich jetzt kontaktieren werde, um mehr zu erfahren.

Ein Wort der Vorsicht von StanfordAllerdings – so mächtig Anwendungen wie die oben genannten auch sind, beachten Sie, dass keine von ihnen große menschliche Voreingenommenheit beinhaltet. Wenn es um die Gesundheit geht, wird das plötzlich zu einem großen Problem, und im Gesundheitsbereich werden unzählige KI-Tools getestet. Stanford-Forscher zeigten, dass KI-Modelle „alte medizinische Rassen-Tropen“ verbreiten. GPT-4 weiß nicht, ob etwas wahr ist oder nicht, daher kann es alte, widerlegte Behauptungen über Gruppen nachahmen, wie zum Beispiel, dass Schwarze eine geringere Lungenkapazität hätten, und tut dies auch. Nein! Bleiben Sie auf dem Laufenden, wenn Sie mit KI-Modellen jeglicher Art im Gesundheits- und Medizinbereich arbeiten.

Zum Abschluss gibt es hier noch eine von Bard geschriebene Kurzgeschichte mit Drehbuch und Aufforderungen, gerendert von VideoPoet. Achtung, Pixar!