Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie erledigen kann, finden Sie hier eine praktische Zusammenfassung der neuesten Geschichten aus der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht alleine behandelt haben.

Diese Woche war es unmöglich, die Führungskontroverse rund um das KI-Startup OpenAI außer Acht zu lassen – auch für diesen Reporter, sehr zum Entsetzen meines schlaflosen Gehirns. Der Vorstand entließ Sam Altman, CEO und Mitbegründer, angeblich wegen seiner aus ihrer Sicht fehlgeleiteten Prioritäten: der Kommerzialisierung von KI auf Kosten der Sicherheit.

Altman wurde – zum großen Teil dank der Bemühungen von Microsoft, einem wichtigen OpenAI-Unterstützer – wieder als CEO eingesetzt und der größte Teil des ursprünglichen Vorstands ersetzt. Aber die Saga verdeutlicht die Gefahren von KI-Unternehmen, selbst solchen, die so groß und einflussreich wie OpenAI sind, sowie die Versuchung, … Monetarisierung-orientierte Finanzierungsquellen werden immer stärker.

Es sind nicht unbedingt KI-Labore wollen sich mit kommerziell ausgerichteten, renditehungrigen Venture-Firmen und Technologiegiganten zu vernetzen. Die enorm hohen Kosten für die Schulung und Entwicklung von KI-Modellen machen es nahezu unmöglich, diesem Schicksal zu entgehen.

Nach Laut CNBC könnte der Prozess des Trainierens eines großen Sprachmodells wie GPT-3, dem Vorgänger von OpenAIs Flaggschiff-Modell für textgenerierende KI, GPT-4, über 4 Millionen US-Dollar kosten. Diese Schätzung berücksichtigt nicht die Kosten für die Einstellung von Datenwissenschaftlern, KI-Experten und Softwareentwicklern – die alle über hohe Gehälter verfügen.

Es ist kein Zufall, dass viele große KI-Labore strategische Vereinbarungen mit Anbietern öffentlicher Clouds haben. Computer sind für diese Labore wertvoller als Gold geworden, insbesondere in einer Zeit, in der die Chips zum Trainieren von KI-Modellen knapp sind (wovon Anbieter wie Nvidia profitieren). Der Hauptkonkurrent von OpenAI, Anthropic, hat Investitionen sowohl von Google als auch von Amazon übernommen. Kohärenz und Charakter.aiMittlerweile werden sie von Google Cloud unterstützt, das auch ihr exklusiver Anbieter der Recheninfrastruktur ist.

Aber wie diese Woche gezeigt hat, sind diese Investitionen gefährdet. Tech-Giganten haben ihre eigenen Pläne – und müssen viel Gewicht aufwenden, um zu erreichen, dass ihre Ziele erreicht werden.

OpenAI versuchte, eine gewisse Unabhängigkeit durch eine einzigartige Struktur mit „gedeckeltem Gewinn“ zu bewahren, die die Gesamtrendite der Anleger begrenzt. Aber Microsoft hat gezeigt, dass Rechenleistung genauso wertvoll sein kann wie Kapital, um ein Startup auf die Beine zu stellen; Ein Großteil der Investitionen von Microsoft in OpenAI erfolgt in Form von Azure-Cloud-Guthaben, und die Drohung, diese Gutschriften zurückzuhalten, würde ausreichen, um die Aufmerksamkeit jedes Vorstands zu erregen.

Sofern die Investitionen in öffentliche Supercomputing-Ressourcen oder KI-Förderprogramme nicht massiv erhöht werden, ist es nicht wahrscheinlich, dass sich der Status quo bald ändern wird. KI-Startups ab einer bestimmten Größe sind – wie die meisten Startups – gezwungen, die Kontrolle über ihr Schicksal abzugeben, wenn sie wachsen wollen. Hoffentlich machen sie im Gegensatz zu OpenAI einen Deal mit dem Teufel, den sie kennen.

Hier sind einige andere bemerkenswerte KI-Geschichten der letzten Tage:

- OpenAI wird die Menschheit nicht zerstören: Hat OpenAI eine KI-Technologie erfunden, die das Potenzial hat, „die Menschheit zu bedrohen“? Einige der jüngsten Schlagzeilen lassen vermuten, dass dies der Fall ist. Aber es gibt keinen Grund zur Besorgnis, sagen Experten.

- Kalifornien achtet auf KI-Regeln: Die kalifornische Datenschutzbehörde bereitet sich auf ihren nächsten Trick vor: der KI Schutzmaßnahmen aufzuerlegen. Natasha schreibt, dass die staatliche Datenschutzbehörde kürzlich Verordnungsentwürfe darüber veröffentlicht hat, wie personenbezogene Daten für KI verwendet werden können, wobei sie sich an bestehenden Regeln in der Europäischen Union orientiert.

- Bard beantwortet YouTube-Fragen: Google hat angekündigt, dass sein Bard AI-Chatbot jetzt Fragen zu YouTube-Videos beantworten kann. Obwohl Bard bereits mit der Einführung der YouTube-Erweiterung im September die Möglichkeit hatte, YouTube-Videos zu analysieren, kann Ihnen der Chatbot nun konkrete Antworten auf Fragen zum Inhalt eines Videos geben.

- X’s Grok startet: Kurz nachdem Screenshots auftauchten, die den Chatbot Grok von xAI in der Web-App von X zeigten, bestätigte X-Inhaber Elon Musk, dass Grok irgendwann in dieser Woche für alle Premium+-Abonnenten des Unternehmens verfügbar sein würde. Während Musks Aussagen über Zeitrahmen für Produktlieferungen nicht immer standgehalten haben, zeigen Codeentwicklungen in Xs eigener App, dass die Grok-Integration in vollem Gange ist.

- Stability AI veröffentlicht einen Videogenerator: Das KI-Startup Stability AI kündigte letzte Woche Stable Video Diffusion an, ein KI-Modell, das Videos durch die Animation vorhandener Bilder generiert. Basierend auf dem bestehenden Stable Diffusion-Text-zu-Bild-Modell von Stability ist Stable Video Diffusion eines der wenigen Videogenerierungsmodelle, die als Open Source verfügbar sind – oder auch kommerziell.

- Anthropic veröffentlicht Claude 2.1: Anthropic hat kürzlich Claude 2.1 veröffentlicht, eine Verbesserung seines Flaggschiffmodells für große Sprachen, die es mit der GPT-Serie von OpenAI konkurrenzfähig macht. Devin schreibt, dass das neue Update für Claude drei wesentliche Verbesserungen aufweist: Kontextfenster, Genauigkeit und Erweiterbarkeit.

- OpenAI und offene KI: Paul schreibt, dass das OpenAI-Debakel die Kräfte, die die aufkeimende KI-Revolution kontrollieren, ins Rampenlicht gerückt hat, was viele zu der Frage veranlasst hat, was passiert, wenn man auf einen zentralisierten proprietären Player setzt – und was passiert, wenn die Dinge dann scheitern.

- AI21 Labs sammelt Geld: AI21 Labs, ein Unternehmen, das generative KI-Produkte nach dem Vorbild von OpenAIs GPT-4 und ChatGPT entwickelt, hat letzte Woche 53 Millionen US-Dollar eingesammelt – was einer Gesamteinnahme von 336 Millionen US-Dollar entspricht. AI21 Labs, ein in Tel Aviv ansässiges Startup, das eine Reihe textgenerierender KI-Tools entwickelt, wurde 2017 von Mobileye-Mitbegründer Amnon Shashua, Goshen und Yoav Shoham, dem anderen Co-CEO des Startups, gegründet.

Mehr maschinelles Lernen

Es ist ein schwieriges Problem, KI-Modelle offener darüber zu machen, wann sie mehr Informationen benötigen, um eine sichere Antwort zu liefern, da das Modell den Unterschied zwischen richtig und falsch eigentlich nicht kennt. Indem Sie das Modell jedoch dazu bringen, sein Innenleben ein wenig offenzulegen, können Sie ein besseres Gefühl dafür bekommen, wann die Wahrscheinlichkeit größer ist, dass es lügt.

Bildnachweis: Purdue Universität

Dieses Werk von Purdue erstellt eine für Menschen lesbare „Reeb-Karte“ wie das neuronale Netzwerk visuelle Konzepte in seinem Vektorraum darstellt. Elemente, die als ähnlich erachtet werden, werden in Gruppen zusammengefasst, und Überschneidungen mit anderen Bereichen können entweder auf Ähnlichkeiten zwischen diesen Gruppen oder auf Verwirrung seitens des Modells hinweisen. „Wir nutzen diese komplizierten Informationssätze, die aus dem Netzwerk kommen, und geben den Menschen einen Einblick in die Art und Weise, wie das Netzwerk die Daten auf makroskopischer Ebene sieht“, sagte der leitende Forscher David Gleich.

Wenn Ihr Datensatz begrenzt ist, ist es möglicherweise am besten, wenn Sie nicht zu weit davon extrapolieren, aber wenn es sein muss … vielleicht ein Tool wie „Senseiver“, vom Los Alamos National Lab ist die beste Wahl. Das Modell basiert auf Googles Perceiver und ist in der Lage, eine Handvoll spärlicher Messungen und – offenbar – überraschend genaue Vorhersagen zu treffen, indem es die Lücken füllt.

Wenn Ihr Datensatz begrenzt ist, ist es möglicherweise am besten, wenn Sie nicht zu weit davon extrapolieren, aber wenn es sein muss … vielleicht ein Tool wie „Senseiver“, vom Los Alamos National Lab ist die beste Wahl. Das Modell basiert auf Googles Perceiver und ist in der Lage, eine Handvoll spärlicher Messungen und – offenbar – überraschend genaue Vorhersagen zu treffen, indem es die Lücken füllt.

Dies könnte für Dinge wie Klimamessungen, andere wissenschaftliche Messwerte oder sogar 3D-Daten wie Karten mit geringer Wiedergabetreue gelten, die von Höhenscannern erstellt wurden. Das Modell kann auf Edge-Computern wie Drohnen ausgeführt werden, die nun möglicherweise nach bestimmten Merkmalen (in ihrem Testfall Methanlecks) suchen können, anstatt die Daten nur zu lesen und sie dann zur späteren Analyse zurückzugeben.

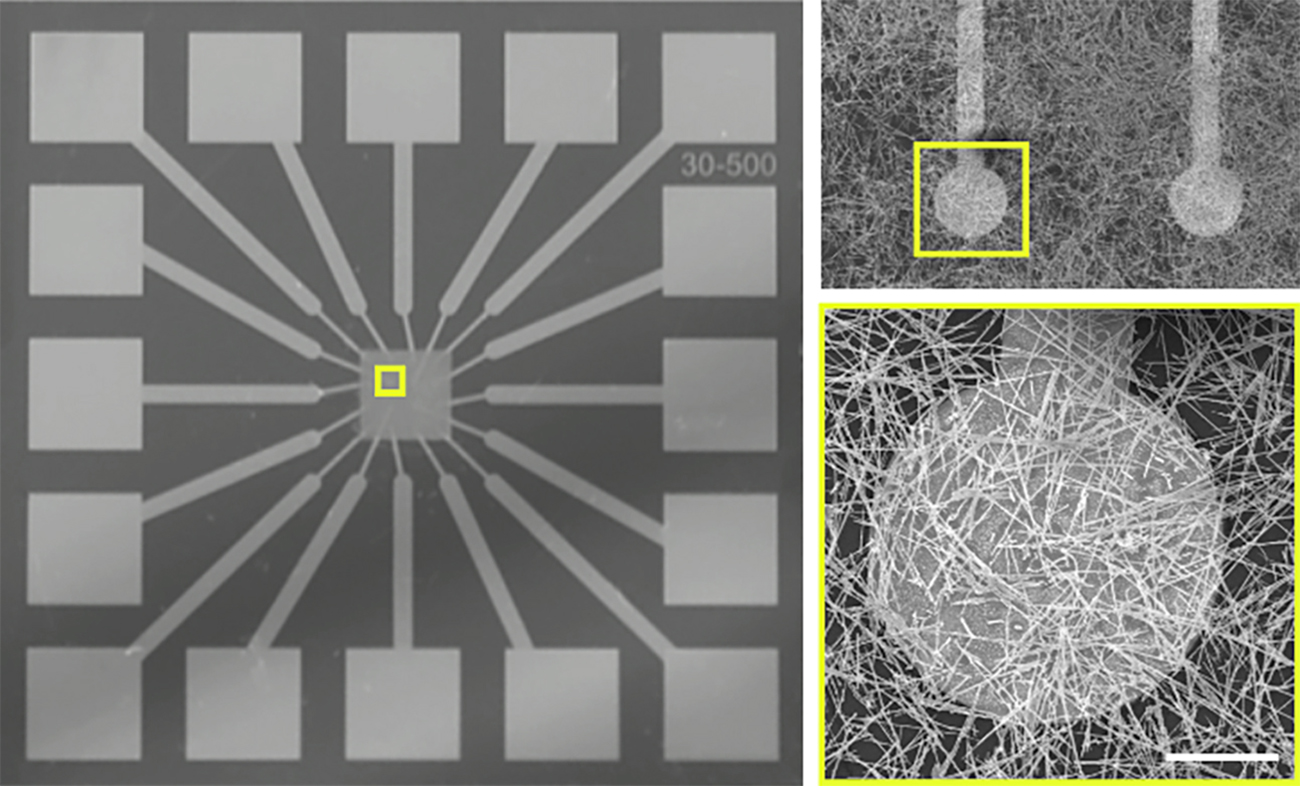

In der Zwischenzeit arbeiten Forscher daran, die Hardware, die diese neuronalen Netze betreibt, mehr wie ein neuronales Netz selbst zu gestalten. Sie stellten ein 16-Elektroden-Array her und bedeckten es dann mit einem Bett aus leitfähigen Fasern in einem zufälligen, aber gleichmäßig dichten Netzwerk. Dort, wo sie sich überlappen, können diese Fasern abhängig von einer Reihe von Faktoren entweder Verbindungen bilden oder diese unterbrechen. In gewisser Weise ähnelt es der Art und Weise, wie Neuronen in unserem Gehirn Verbindungen herstellen und diese Verbindungen dann dynamisch verstärken oder aufgeben.

Das UCLA/University of Sydney-Team sagte, das Netzwerk sei in der Lage, handgeschriebene Zahlen mit einer Genauigkeit von 93,4 % zu identifizieren, was tatsächlich einen konventionelleren Ansatz in einem ähnlichen Maßstab übertreffe. Es ist auf jeden Fall faszinierend, aber noch weit von einem praktischen Nutzen entfernt, obwohl selbstorganisierende Netzwerke wahrscheinlich irgendwann ihren Weg in die Toolbox finden werden.

Bildnachweis: UCLA/Universität Sydney

Es ist schön zu sehen, wie Modelle des maschinellen Lernens Menschen helfen, und wir haben diese Woche einige Beispiele dafür.

Eine Gruppe von Stanford-Forschern arbeitet daran ein Tool namens GeoMatch soll Flüchtlingen und Einwanderern dabei helfen, den richtigen Standort für ihre Situation und Fähigkeiten zu finden. Dabei handelt es sich nicht um ein automatisiertes Verfahren – derzeit werden diese Entscheidungen von Vermittlungsbeamten und anderen Beamten getroffen, die zwar erfahren und informiert sind, aber nicht immer sicher sein können, dass ihre Entscheidungen durch Daten gestützt werden. Das GeoMatch-Modell berücksichtigt eine Reihe von Merkmalen und schlägt einen Standort vor, an dem die Person wahrscheinlich eine feste Anstellung finden wird.

„Was früher mehrere Stunden an Forschung erforderte, kann jetzt in wenigen Minuten erledigt werden“, sagte der Leiter des Projekts, Michael Hotard. „GeoMatch kann als Tool, das das Sammeln von Informationen und das Herstellen von Verbindungen vereinfacht, unglaublich nützlich sein.“

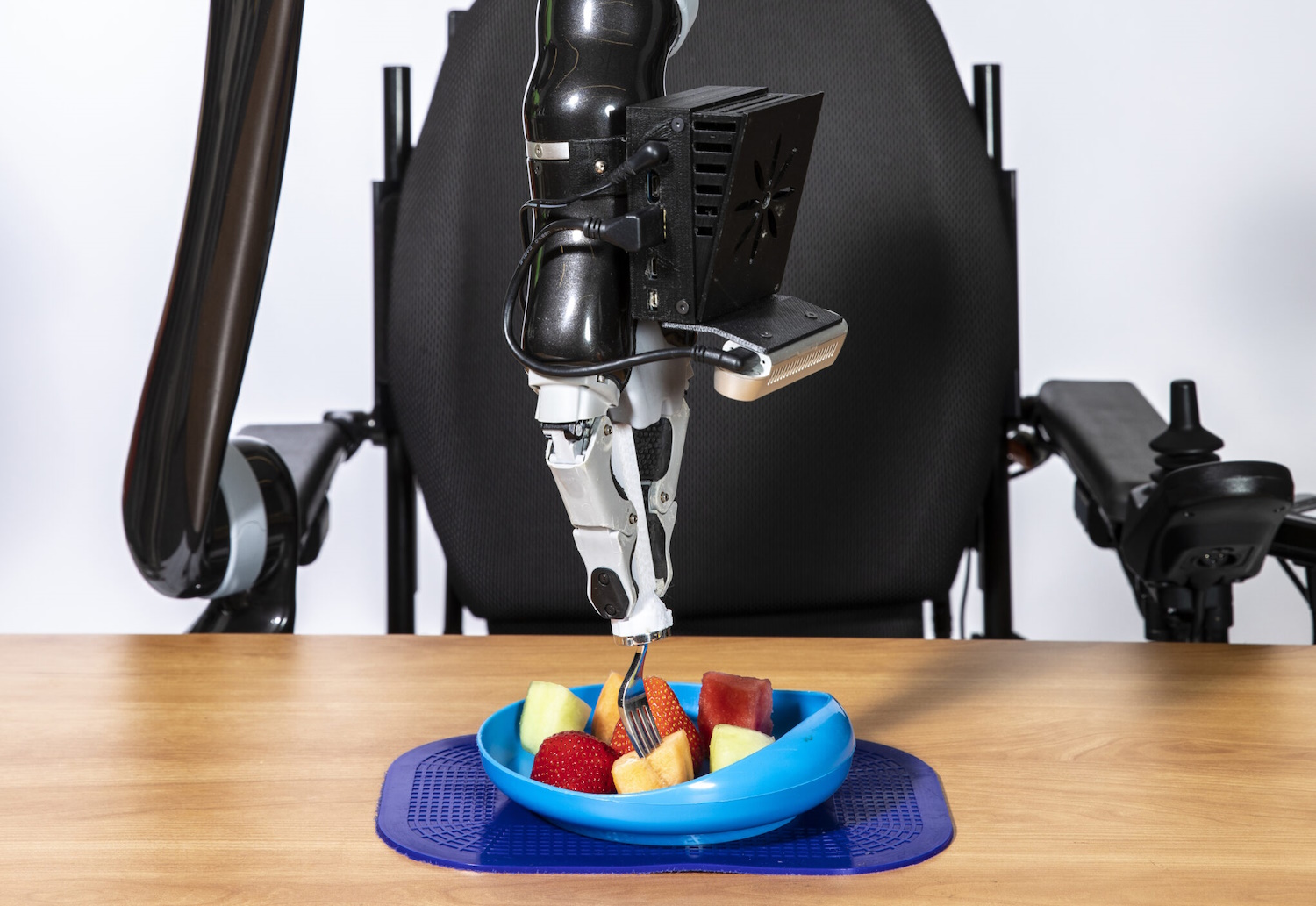

An der University of Washington haben Robotikforscher gerade ihre Arbeit zum Thema Schöpfung vorgestellt ein automatisiertes Ernährungssystem für Menschen, die nicht alleine essen können. Das System hat viele Versionen durchlaufen und sich mit dem Feedback der Community weiterentwickelt, und „wir sind an einem Punkt angelangt, an dem wir fast alles aufnehmen können, was ein Fork verarbeiten kann.“ So können wir zum Beispiel keine Suppe abholen. Aber der Roboter kann alles verarbeiten, von Kartoffelpüree oder Nudeln über einen Obstsalat bis hin zu einem echten Gemüsesalat, aber auch vorgeschnittene Pizza, ein Sandwich oder Fleischstücke“, sagte Co-Leiter Ethan K. Gordon in einer Frage-und-Antwort-Runde von die Universität.

Bildnachweis: Universität von Washington

Es ist ein interessanter Chat, der zeigt, dass Projekte wie diese nie wirklich „fertig“ sind, aber in jeder Phase immer mehr Menschen helfen können.

Es gibt einige Projekte, die blinden Menschen dabei helfen, sich auf der Welt zurechtzufinden, von Be My AI (unterstützt von GPT-4V) bis hin zu Microsofts Seeing AI, einer Sammlung speziell entwickelter Modelle für alltägliche Aufgaben. Google verfügte über eine eigene Wegfindungs-App namens Project Guideline, die dabei helfen sollte, Menschen beim Gehen oder Joggen auf einem Weg auf dem Laufenden zu halten. Google hat es gerade als Open Source bereitgestelltwas im Allgemeinen bedeutet, dass sie etwas aufgeben – aber ihr Verlust ist der Gewinn für andere Forscher, weil die Arbeit des Milliardenunternehmens nun in einem persönlichen Projekt genutzt werden kann.

Zum Abschluss noch ein bisschen Spaß FathomVerse, ein Spiel/Tool zur Identifizierung von Meeresbewohnern, so wie Apps wie iNaturalist usw. Blätter und Pflanzen identifizieren. Allerdings braucht es Ihre Hilfe, denn Tiere wie Anemonen und Kraken sind weich und schwer zu identifizieren. Melden Sie sich also für die Beta an und sehen Sie, ob Sie dabei helfen können, dieses Ding auf den Weg zu bringen!

Bildnachweis: FathomVerse