Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie erledigen kann, finden Sie hier eine praktische Zusammenfassung der Geschichten der letzten Woche in der Welt des maschinellen Lernens sowie bemerkenswerte Forschungsergebnisse und Experimente, die wir nicht alleine behandelt haben.

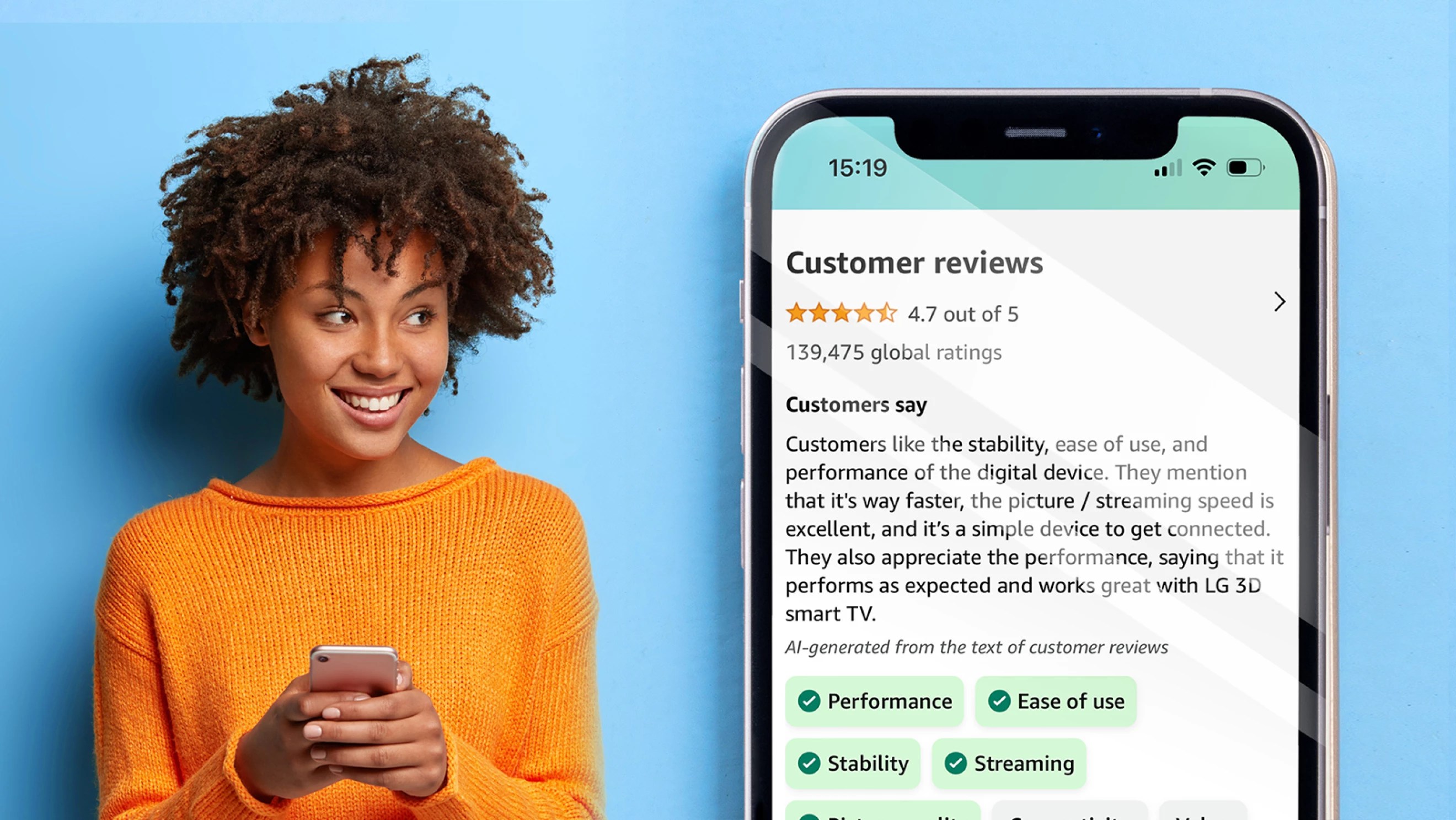

Diese Woche gab Amazon im Bereich KI bekannt, dass es damit beginnen wird, generative KI zu nutzen, um Produktbewertungen zu „verbessern“. Sobald die Funktion eingeführt ist, wird auf der Produktdetailseite ein kurzer Textabschnitt angezeigt, der die Produktfunktionen und die Kundenstimmung hervorhebt, die in den Bewertungen erwähnt wurden.

Klingt nach einer nützlichen Funktion, nicht wahr? Vielleicht für Käufer und Verkäufer. Aber was ist mit den Rezensenten?

Ich werde nicht behaupten, dass Amazon-Rezensionen eine hohe Kunst sind. Im Gegenteil, eine ganze Reihe auf der Plattform sind nicht real – oder werden selbst von der KI generiert.

Aber einige Rezensenten investieren Zeit in die Erstellung von Rezensionen, die nicht nur informieren, sondern auch unterhalten, sei es aus echter Sorge um ihre Mitkäufer oder aus dem Bemühen, ihrer Kreativität freien Lauf zu lassen. Zusammenfassungen dieser Rezensionen würden ihnen Unrecht tun – und das Wesentliche völlig verfehlen.

Vielleicht sind Sie auf diese Juwelen gestoßen. Man findet sie oft in den Rezensionen von Büchern und Filmen, wo Amazon-Rezensenten meiner anekdotischen Erfahrung nach dazu neigen, … ausführlicher zu sein.

Bildnachweis: Amazonas

Nehmen wir den Amazon-Nutzer „Sweet Home“ Rezension von JD Salingers „Catcher in the Rye“, der über 2.000 Wörter umfasst. Die Rezension von Sweet Home bezieht sich auf die Werke von William S. Burroughs und Jack Kerouac sowie George Bernard Shaw, Gary Snyder und Dorothy Parker und ist weniger eine Rezension als vielmehr eine gründliche Analyse, bei der die Handlungsstränge des Romans aufgegriffen und kontextualisiert werden, um seinen Verbleib zu erklären Leistung.

Und dann ist da noch Bryan Desmonds Rezension von „Gravity’s Rainbow“, dem berüchtigt dichten Roman von Thomas Pynchon. Ähnlich wortreich – 1.120 Wörter – unterstreicht es nicht nur die Höhepunkte (umwerfende Prosa) und Schattenseiten (veraltete Einstellungen, insbesondere gegenüber Frauen), wie man es von einer Rezension erwarten würde, sondern gibt auch sehr detailliert Desmonds Erfahrungen beim Lesen wieder.

Könnte KI diese zusammenfassen? Sicher. Aber auf Kosten von Nuancen und Einsicht.

Natürlich hat Amazon nicht die Absicht, Rezensionen zugunsten von KI-generierten Zusammenfassungen aus der Sicht zu verbergen. Ich befürchte jedoch, dass Rezensenten weniger geneigt sein werden, annähernd so viel Zeit und Aufmerksamkeit aufzuwenden, wenn ihre Arbeit vom durchschnittlichen Käufer zunehmend ungelesen bleibt. Es ist ein großartiges Experiment, und ich vermute – wie bei den meisten Dingen, die generative KI berühren – wird nur die Zeit es zeigen.

Hier sind einige andere bemerkenswerte KI-Geschichten der letzten Tage:

- Meine KI wird abtrünnig: Die My AI-Funktion von Snapchat, ein In-App-KI-Chatbot, der Anfang des Jahres mit einigen Kontroversen auf den Markt kam, schien kurzzeitig einen eigenen Kopf zu haben. Am Dienstag veröffentlichte die KI ihre eigene Story in der App und reagierte dann nicht mehr auf die Nachrichten der Benutzer, was einige Snapchat-Benutzer beunruhigend fand. Die Snapchat-Muttergesellschaft Snap bestätigte später, dass es sich um einen Fehler handelte.

- OpenAI schlägt eine neue Moderationstechnik vor: OpenAI gibt an, eine Möglichkeit entwickelt zu haben, GPT-4, sein Flaggschiffmodell der generativen KI, für die Moderation von Inhalten zu nutzen – und so die Belastung menschlicher Teams zu verringern.

- OpenAI erwirbt ein Unternehmen: In weiteren OpenAI-Nachrichten erwarb das KI-Startup Global Illumination, ein in New York ansässiges Startup, das KI nutzt, um kreative Tools, Infrastruktur und digitale Erlebnisse zu entwickeln. Es ist die erste öffentliche Übernahme von OpenAI in seiner rund siebenjährigen Geschichte.

- Ein neuer LLM-Trainingsdatensatz: Das Allen Institute for AI hat einen riesigen Textdatensatz für große Sprachmodelle (LLMs) nach dem Vorbild von OpenAIs ChatGPT veröffentlicht, der kostenlos und offen zur Inspektion verwendet werden kann. Dolma, wie der Datensatz heißt, soll die Grundlage für das von der Forschungsgruppe geplante offene Sprachmodell OLMo bilden (Dolma ist die Abkürzung für „Data to füttern OLMo’s Appetite“).

- Geschirrspül-, Türöffnungsroboter: Forscher der ETH Zürich haben eine Methode entwickelt, um Robotern beizubringen, Aufgaben wie das Öffnen und Durchgehen von Türen auszuführen – und mehr. Das Team sagt, dass das System an verschiedene Formfaktoren angepasst werden kann, aber der Einfachheit halber haben sie Demos auf einem Vierbeiner ausgeführt – die hier angesehen werden können.

- Opera bekommt einen KI-Assistenten: Die Webbrowser-App von Opera für iOS erhält einen KI-Assistenten. Das Unternehmen angekündigt Diese Woche wird Opera auf iOS nun Aria enthalten, sein Browser-KI-Produkt, das in Zusammenarbeit mit OpenAI entwickelt, direkt in den Webbrowser integriert und für alle Benutzer kostenlos ist.

- Google begrüßt KI-Zusammenfassungen: Google hat diese Woche ein paar neue Updates für sein fast drei Monate altes Search Generative Experience (SGE) herausgebracht., der KI-gestützte Konversationsmodus des Unternehmens in der Suche, mit dem Ziel, Benutzern dabei zu helfen, die Informationen, die sie im Web finden, besser zu verstehen und zu verstehen. Zu den Funktionen gehören Tools zum Anzeigen von Definitionen unbekannter Begriffe, Tools zur Verbesserung Ihres Sprachverständnisses und der Kodierung von Informationen in verschiedenen Sprachen sowie eine interessante Funktion, mit der Sie beim Surfen die KI-Leistung von SGE nutzen können.

- Google Fotos erhält KI: Google Fotos hat ein hinzugefügt Neue Möglichkeit, Ihre unvergesslichsten Momente noch einmal zu erleben und zu teilen, mit der Einführung einer neuen Erinnerungsansicht, mit der Sie Ihre Lieblingserinnerungen speichern oder Ihre eigenen von Grund auf erstellen können. Mit Memories können Sie eine albumähnliche Zeitleiste erstellen, die Dinge wie Ihre unvergesslichsten Reisen, Feiern und täglichen Momente mit Ihren Lieben enthält.

- Anthropic sammelt mehr Geld: Anthropischein KI-Startup, das von ehemaligen OpenAI-Führungskräften mitbegründet wurde, erhält 100 Millionen US-Dollar an Fördermitteln von einem der größten Mobilfunkanbieter in Südkorea, SK Telecom, teilte das Telekommunikationsunternehmen am Sonntag mit. Die Finanzierungsnachricht kommt drei Monate, nachdem Anthropic im Mai in seiner von Spark Capital angeführten Finanzierungsrunde der Serie C 450 Millionen US-Dollar gesammelt hat.

Mehr maschinelles Lernen

Ich (das heißt Ihr Co-Autor Devin) war letzte Woche bei SIGGRAPH, wo KI, obwohl sie derzeit ein Schreckgespenst in der Film- und Fernsehbranche ist, sowohl als Werkzeug als auch als Forschungsgegenstand voll im Einsatz war. Ich werde bald eine ausführlichere Geschichte darüber erzählen, wie es bald von VFX-Künstlern auf innovative und völlig unumstrittene Weise eingesetzt wird, aber die ausgestellten Papiere waren auch ziemlich großartig. Diese Sitzung hatte insbesondere einige interessante neue Ideen.

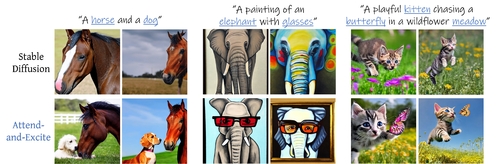

Bildnachweis: Universität Tel Aviv

Bildgenerierende Modelle haben diese seltsame Sache: Wenn man ihnen sagt, sie sollen „eine weiße Katze und einen schwarzen Hund“ zeichnen, werden oft die beiden verwechselt, eines ignoriert oder eine Katze, ein Hund oder Tiere erstellt, die sowohl schwarz als auch weiß sind. Ein Ansatz der Universität Tel Aviv namens „attend and excite“ sortiert die Aufforderung durch Aufmerksamkeit in ihre Bestandteile und stellt dann sicher, dass das resultierende Bild die richtigen Darstellungen von jedem enthält. Das Ergebnis ist ein Modell, das Eingabeaufforderungen mit mehreren Themen viel besser analysieren kann. Ich würde erwarten, dass so etwas bald in Kunstgeneratoren integriert wird!

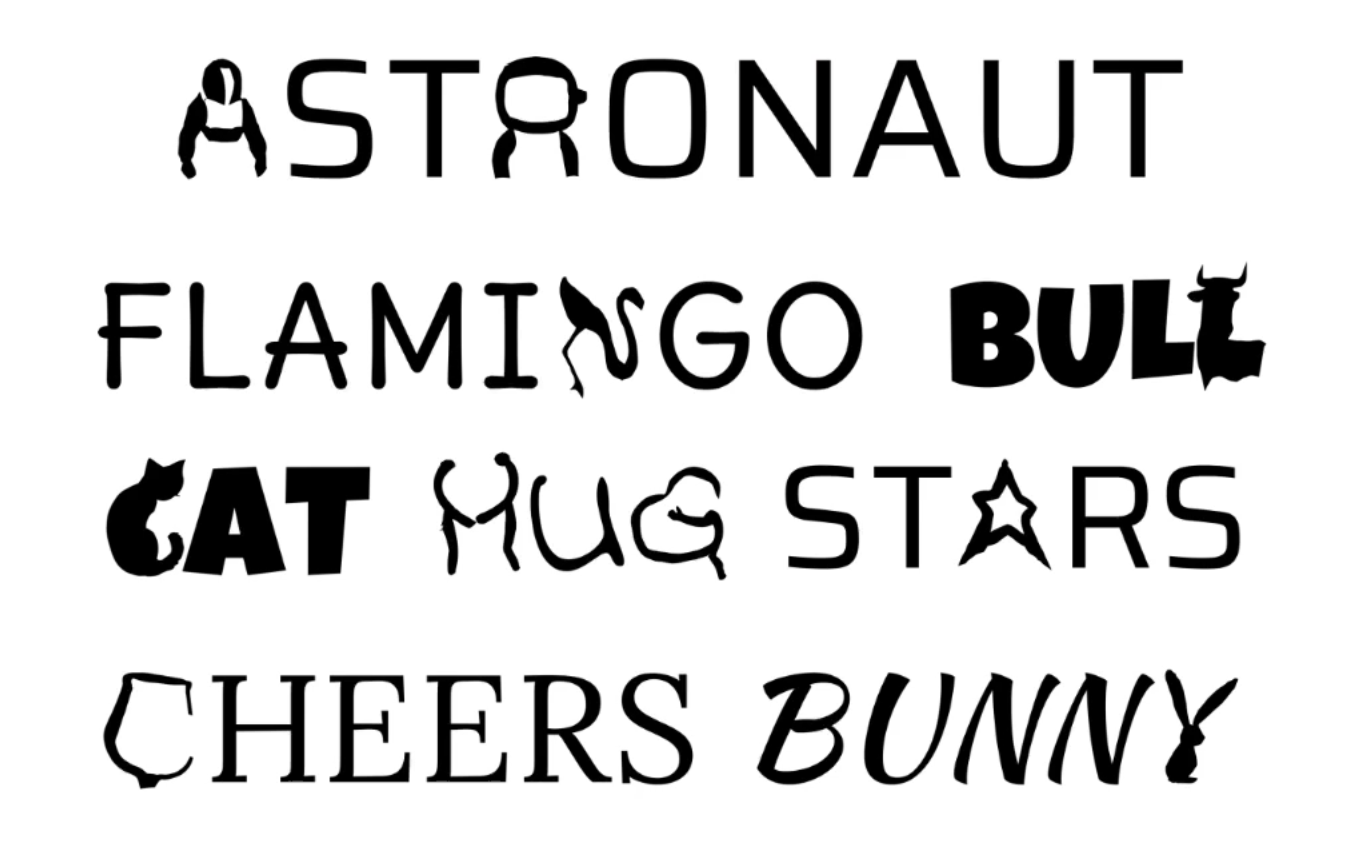

Bildnachweis: MIT/Max-Planck-Institut

Eine weitere Schwäche generativer Kunstmodelle besteht darin, dass Sie, wenn Sie kleine Änderungen vornehmen möchten, z. B. wenn das Motiv etwas mehr zur Seite schaut, das Ganze noch einmal machen müssen – wobei manchmal verloren geht, was Ihnen an dem Bild von Anfang an gefallen hat. „Ziehen Sie Ihr GAN“ ist ein ziemlich erstaunliches Werkzeug, mit dem der Benutzer Punkte einzeln oder mehrere gleichzeitig festlegen und verschieben kann – wie Sie im Bild sehen können, kann der Kopf eines Löwen gedreht oder sein Maul geöffnet werden, indem nur dieser Teil des Bildes regeneriert wird um den neuen Proportionen gerecht zu werden. Google ist in der Autorenliste, Sie können also darauf wetten, dass sie sich mit der Verwendung befassen.

Bildnachweis: Universität Tel Aviv

Das Aufsatz „Semantische Typografie“. macht mehr Spaß, ist aber auch extrem clever. Indem man jeden Buchstaben als Vektorbild behandelt und dieses Bild in Richtung eines Vektorbilds des Objekts verschiebt, auf das sich ein Wort bezieht, entstehen ziemlich beeindruckende Logos. Wenn Sie nicht wissen, wie Sie Ihren Firmennamen in ein visuelles Wortspiel umwandeln sollen, könnte dies ein guter Einstieg sein.

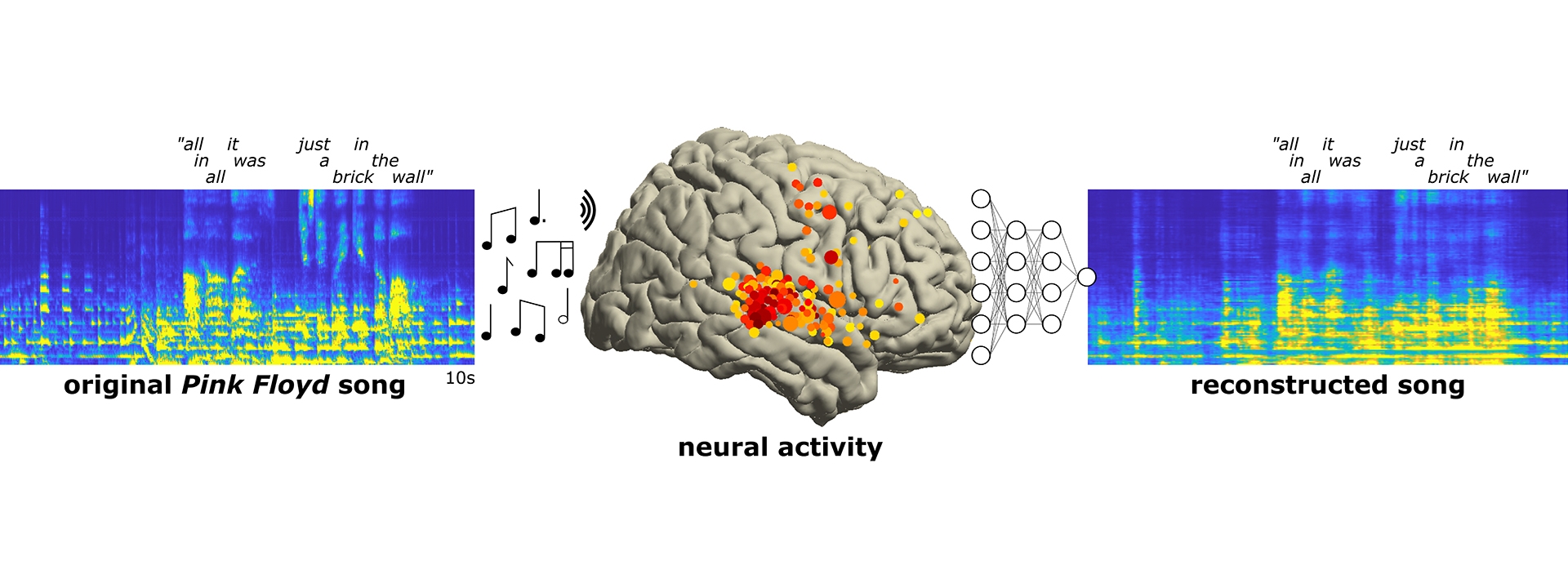

An anderer Stelle gibt es einige interessante Wechselwirkungen zwischen Hirnforschung und KI.

Nun, ganz so einfach ist es nicht.

Diese Berkeley-Forscher verwendeten ein maschinelles Lernmodell, um die Gehirnaktivität beim Musikhören zu interpretieren und einige der Cluster zu rekonstruieren, die sich auf Rhythmus, Melodie oder Gesang konzentrierten. Ich stehe dieser Art von „Wir lesen das Gehirn“-Studien immer skeptisch gegenüber, also nehmen Sie das alles mit Vorsicht, aber ML ist großartig darin, ein Signal im Rauschen zu isolieren, und die Gehirnaktivität ist sehr, sehr verrauscht.

MIT und Harvard haben sich zusammengetan um zu versuchen, unser Verständnis von Astrozyten zu verbessern, Zellen im Gehirn, die eine noch unbekannte Funktion erfüllen. Sie schlagen vor, dass die Zellen so etwas wie ein Transformator oder Aufmerksamkeitsmechanismus fungieren könnten – ein Konzept des maschinellen Lernens, das auf das Gehirn übertragen wird und nicht umgekehrt! Der leitende Papierautor Dmitry Krotov vom MIT bringt es gut auf den Punkt:

Das Gehirn ist selbst den besten künstlichen neuronalen Netzen, die wir entwickelt haben, weit überlegen, aber wir wissen nicht genau, wie das Gehirn funktioniert. Es ist von wissenschaftlichem Wert, über Verbindungen zwischen biologischer Hardware und großen Netzwerken künstlicher Intelligenz nachzudenken. Das ist Neurowissenschaft für KI und KI für Neurowissenschaften.

In der medizinischen KI gelten Daten von Verbrauchergeräten oft auch als verrauscht oder unzuverlässig. Aber auch hier können sich ML-Systeme anpassen, wie dieses neue Papier aus Yale zeigt. Die Forschung soll uns näher an Wearables bringen, die uns vor Herzproblemen warnen, bevor sie akut werden.

Schüler demonstrieren ihre App zum Finden leerer Stühle.

Eine der ersten praktischen Anwendungen von GPT-4 war die Verwendung in Be My Eyes, einer App, die blinden Menschen hilft, mithilfe eines Remote-Partners zu navigieren. Studierende der EPFL zwei weitere Apps entwickelt Das könnte für jeden mit einer Sehbehinderung ganz nett sein. Der eine weist den Benutzer einfach auf einen freien Platz in einem Raum und der andere liest nur die relevanten Informationen aus den Medikamentenflaschen vor: den Wirkstoff, die Dosierung usw. Was für einfache, aber notwendige Aufgaben!

Schließlich haben wir noch das Kleinkind-Äquivalent „RoboAgent“, entwickelt von CMU und MetaZiel ist es, alltägliche Fähigkeiten wie das Aufheben von Dingen oder das Verstehen von Objektinteraktionen zu erlernen, indem man einfach Dinge ansieht und berührt – so wie es ein Kind tut.

„Ein Agent, der zu dieser Art des Lernens fähig ist, bringt uns einem allgemeinen Roboter näher, der eine Vielzahl von Aufgaben in verschiedenen, unsichtbaren Umgebungen erledigen kann und sich kontinuierlich weiterentwickelt, wenn er mehr Erfahrungen sammelt“, sagte Shubham Tulsiani von der CMU. Nachfolgend erfahren Sie mehr über das Projekt: