Mit einer so schnelllebigen Branche wie der KI Schritt zu halten, ist eine große Herausforderung. Bis eine KI dies für Sie tun kann, finden Sie hier eine praktische Zusammenfassung der Geschichten der letzten Woche in der Welt des maschinellen Lernens, zusammen mit bemerkenswerten Forschungsergebnissen und Experimenten, die wir allein nicht behandelt haben.

Die größte Neuigkeit der letzten Woche (wir ziehen unsere Anthropic-Geschichte höflich aus der Betrachtung zurück) war die Ankündigung von Bedrock, Amazons Dienst, der eine Möglichkeit bietet, generative KI-Apps über vortrainierte Modelle von Startups zu erstellen, darunter AI21-Labors, Anthropische und Stabilitäts-KI. Bedrock ist derzeit in der „eingeschränkten Vorschau“ verfügbar und bietet auch Zugriff auf Titan FMs (Foundation Models), eine Familie von KI-Modellen, die von Amazon intern trainiert wurden.

Es macht durchaus Sinn, dass Amazon ein Pferd im generativen KI-Rennen haben möchte. Schließlich könnte der Markt für KI-Systeme, die Text, Audio, Sprache und mehr erstellen, bis 2030 mehr als 100 Milliarden US-Dollar wert sein. nach zu Grand View Research.

Aber Amazon hat ein anderes Motiv, als sich ein Stück von einem wachsenden neuen Markt zu schnappen.

In einem kürzlich erschienenen Motley Fool Stück, TImothy Green legte überzeugende Beweise dafür vor, dass sich das Cloud-Geschäft von Amazon verlangsamen könnte. Das Unternehmen meldete im dritten Quartal 2022 ein Umsatzwachstum von 27 % gegenüber dem Vorjahr für seine Cloud-Dienste, aber der Anstieg verlangsamte sich bis zum Ende auf eine Rate von mittleren 20 % des Quartals. Unterdessen ging die operative Marge der Cloud-Sparte von Amazon im gleichen Quartal im Jahresvergleich um 4 Prozentpunkte zurück, was darauf hindeutet, dass Amazon zu schnell expandiert hat.

Amazon setzt eindeutig große Hoffnungen in Bedrock und geht sogar so weit, die oben genannten internen Modelle vor dem Start zu trainieren – was wahrscheinlich keine unbedeutende Investition war. Und damit niemand Zweifel an der Ernsthaftigkeit des Unternehmens in Bezug auf generative KI aufkommen lässt, hat Amazon nicht alle Eier auf einen Korb gelegt. Es hat diese Woche CodeWhisperer, sein System, das Code aus Texteingabeaufforderungen generiert, für einzelne Entwickler kostenlos gemacht.

Wird Amazon also einen bedeutenden Teil des Bereichs der generativen KI erobern und dabei sein Cloud-Geschäft neu beleben? Es gibt viel zu hoffen – insbesondere angesichts der inhärenten Risiken der Technologie. Die Zeit wird es letztendlich zeigen, wenn sich der Staub in der generativen KI legt und große und kleine Konkurrenten auftauchen.

Hier sind die anderen bemerkenswerten KI-Schlagzeilen der letzten Tage:

- Die weite, weite Welt der KI-Regulierung: Jeder scheint seine eigenen Vorstellungen davon zu haben, wie man KI regulieren kann, und das bedeutet etwa 20 verschiedene Rahmenbedingungen in allen größeren Ländern und Wirtschaftszonen. Natasha geht mit dieser (derzeit) erschöpfenden Liste von Regulierungsrahmen (einschließlich vollständiger Verbote wie dem von ChatGPT in Italien) und ihren potenziellen Auswirkungen auf die KI-Branche, wo sie sich befinden, tief ins Wesentliche. China macht jedoch sein eigenes Ding.

- Musk nimmt es mit OpenAI auf: Elon Musk ist nicht zufrieden mit der Demontage von Twitter und plant Berichten zufolge, es mit seinem ehemaligen Verbündeten OpenAI aufzunehmen, und versucht derzeit, das Geld und die dafür erforderlichen Leute zu sammeln. Der vielbeschäftigte Milliardär nutzt möglicherweise die Ressourcen seiner verschiedenen Unternehmen, um die Arbeit zu beschleunigen, aber es gibt guten Grund, diesem Unterfangen skeptisch gegenüberzustehen, Devin schreibt.

- Der Elefant im Zimmer: KI-Forschungsstartup Anthropisch will in den nächsten zwei Jahren bis zu 5 Milliarden US-Dollar aufbringen, um es mit dem Rivalen OpenAI aufzunehmen und in mehr als ein Dutzend wichtiger Branchen einzusteigen, so die von Tech erhaltenen Unternehmensdokumente. In den Dokumenten sagt Anthropic, dass es plant, ein „Grenzmodell“ – vorläufig „Claude-Next“ genannt – zu bauen, das zehnmal leistungsfähiger ist als die derzeit leistungsstärkste KI, aber dass dies in den nächsten 18 Monaten eine Milliarde Dollar an Ausgaben erfordern wird .

- Erstellen Sie Ihren eigenen Chatbot: Eine App namens Poe ermöglicht es Benutzern nun, ihre eigenen Chatbots zu erstellen, indem sie Eingabeaufforderungen in Kombination mit einem vorhandenen Bot wie ChatGPT von OpenAI als Basis verwenden. Poe wurde erstmals im Februar öffentlich vorgestellt und ist das neueste Produkt der Q&A-Site Quotedas Websuchern seit langem Antworten auf die am häufigsten gegoogelten Fragen liefert.

- Jenseits der Verbreitung: Obwohl die Diffusionsmodelle, die von beliebten Tools wie Midjourney und Stable Diffusion verwendet werden, wie die besten erscheinen, die wir haben, kommt immer das Nächste – und OpenAI könnte mit „Konsistenzmodellen“ darauf gestoßen sein, die bereits einfache Aufgaben erledigen können Größenordnung schneller als solche wie DALL-E, berichtet Devin.

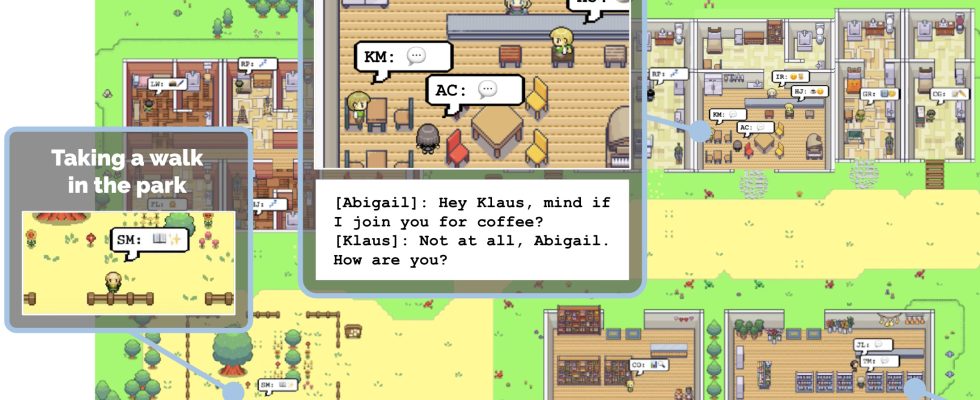

- Eine kleine Stadt mit KI: Was würde passieren, wenn Sie eine virtuelle Stadt mit KIs füllen und sie loslassen würden? Forscher von Stanford und Google wollten dies in einem kürzlich durchgeführten Experiment mit ChatGPT herausfinden. Ihr Versuch, eine „glaubwürdige Simulation menschlichen Verhaltens“ zu schaffen, war allem Anschein nach erfolgreich – die 25 ChatGPT-gestützten KIs waren in ihren Interaktionen überzeugend und überraschend menschenähnlich.

Bildnachweis: Google / Stanford University

- Generative KI im Unternehmen: In einem Stück für TC+, Ron schreibt darüber, wie transformativ Technologien wie ChatGPT sein könnten, wenn sie auf die Unternehmensanwendungen angewendet würden, die Menschen täglich nutzen. Er merkt jedoch an, dass es Kreativität erfordern wird, um dorthin zu gelangen, um die neuen KI-gestützten Schnittstellen auf elegante Weise zu gestalten, damit sie sich nicht angeschraubt fühlen.

Mehr maschinelles Lernen

Bildnachweis: Meta

Meta Open-Source ein beliebtes Experiment mit denen Menschen Zeichnungen von Menschen animieren konnten, so grob sie auch waren. Es ist eine dieser unerwarteten Anwendungen der Technologie, die sowohl reizvoll als auch völlig trivial ist. Trotzdem hat es den Leuten so gut gefallen, dass Meta den Code frei laufen lässt, damit jeder ihn in etwas einbauen kann.

Ein weiteres Meta-Experiment, genannt Alles segmentierenDabei sorgte sie überhaupt für ein überraschend großes Aufsehen. LLMs sind im Moment so heiß, dass man Computer Vision leicht vergisst – und selbst dann einen bestimmten Teil des Systems, an den die meisten Leute nicht denken. Aber die Segmentierung (Identifizieren und Umreißen von Objekten) ist ein unglaublich wichtiger Teil jeder Roboteranwendung, und da die KI weiterhin „die reale Welt“ infiltriert, ist es wichtiger denn je, dass sie … nun, alles segmentieren kann.

Bildnachweis: Meta

Professor Stuart Russell hat die Tech-Bühne schon früher beehrt, aber unsere halbstündigen Gespräche kratzen nur an der Oberfläche des Feldes. Glücklicherweise hält der Mann regelmäßig Vorlesungen und Vorträge und Kurse zu dem Thema, die aufgrund seiner langen Vertrautheit mit dem Thema sehr fundiert und interessant sind, auch wenn sie provokative Namen tragen wie „Wie man KI nicht die Welt zerstören lässt“.

Sie sollten sich diese aktuelle Präsentation ansehen, die von einem anderen TC-Freund, Ken Goldberg, vorgestellt wurde: