KI ist nur der neueste und hungrigste Markt für Hochleistungsrechnen, und Systemarchitekten arbeiten rund um die Uhr daran, jeden Tropfen Leistung aus jedem Watt herauszuholen. Schwedisches Startup Null Punkteausgestattet mit 5 Millionen Euro (5,5 Millionen US-Dollar) an neuen Mitteln, möchte ihnen mit einer neuartigen Speicherkomprimierungstechnik im Nanosekundenbereich helfen – und ja, sie ist genauso kompliziert, wie sie klingt.

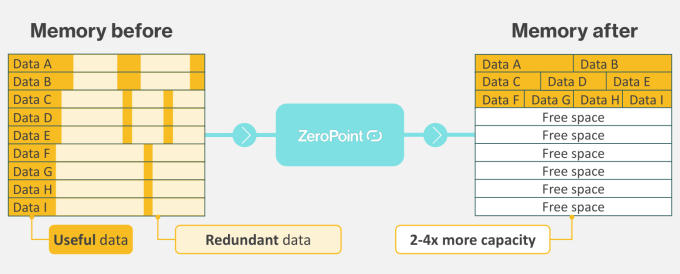

Das Konzept besteht darin, Daten verlustfrei zu komprimieren, bevor sie in den RAM gelangen, und sie anschließend zu dekomprimieren, wodurch der Speicherkanal effektiv um 50 % oder mehr erweitert wird, indem nur ein kleiner Teil zum Chip hinzugefügt wird.

Komprimierung ist natürlich eine grundlegende Technologie im Computerwesen; Klas Moreau, CEO von ZeroPoint (links im Bild oben, mit den Mitbegründern Per Stenström und Angelos Arelakis), betonte: „Wir würden heute keine Daten mehr auf der Festplatte speichern, ohne sie zu komprimieren.“ Untersuchungen legen nahe, dass 70 % der Daten im Speicher unnötig sind. Warum also nicht im Speicher komprimieren?“

Die Antwort ist, wir haben nicht die Zeit. Das Komprimieren einer großen Datei zum Speichern (oder Kodieren, wie wir sagen, wenn es sich um Video oder Audio handelt) ist eine Aufgabe, die je nach Bedarf Sekunden, Minuten oder Stunden dauern kann. Aber Daten durchlaufen den Speicher in einem winzigen Bruchteil einer Sekunde und werden so schnell hinein und heraus verschoben, wie die CPU das kann. Eine einzige Mikrosekunde Verzögerung, um die „unnötigen“ Bits aus einem Datenpaket zu entfernen, das in das Speichersystem gelangt, wäre katastrophal für die Leistung.

Der Arbeitsspeicher entwickelt sich nicht unbedingt im gleichen Tempo wie die CPU-Geschwindigkeit, obwohl beide (sowie viele andere Chipkomponenten) untrennbar miteinander verbunden sind. Wenn der Prozessor zu langsam ist, stauen sich die Daten im Arbeitsspeicher – und wenn der Arbeitsspeicher zu langsam ist, verschwendet der Prozessor Zyklen, während er auf den nächsten Stapel Bits wartet. Wie zu erwarten, arbeitet alles zusammen.

Obwohl eine superschnelle Speicherkomprimierung nachgewiesen wurde, führt sie zu einem zweiten Problem: Im Wesentlichen müssen Sie die Daten genauso schnell dekomprimieren, wie Sie sie komprimiert haben, und sie in ihren ursprünglichen Zustand zurückversetzen, sonst weiß das System nicht, wie das geht damit umzugehen. Wenn Sie also nicht Ihre gesamte Architektur auf diesen neuen Modus für komprimierten Speicher umstellen, ist das sinnlos.

ZeroPoint behauptet, beide Probleme durch eine hyperschnelle Speicherkomprimierung auf niedriger Ebene gelöst zu haben, die keine wirklichen Änderungen am Rest des Computersystems erfordert. Sie fügen ihre Technologie Ihrem Chip hinzu und es ist, als ob Sie Ihren Speicher verdoppelt hätten.

Obwohl die wesentlichen Details wahrscheinlich nur für Leute auf diesem Gebiet verständlich sein werden, sind die Grundlagen für den Uneingeweihten leicht zu verstehen, wie Moreau bewies, als er es mir erklärte.

„Wir nehmen eine sehr kleine Datenmenge – eine Cache-Zeile, manchmal 512 Bit – und identifizieren darin Muster“, sagte er. „Es liegt in der Natur von Daten, dass sie mit nicht so effizienten Informationen gefüllt sind, Informationen, die spärlich lokalisiert sind. Es kommt auf die Daten an: Je zufälliger sie sind, desto weniger komprimierbar sind sie. Aber wenn wir uns die meisten Datenlasten ansehen, sehen wir, dass wir im Bereich von 2–4 liegen [more data throughput than before].“

Dass Speicher komprimiert werden kann, ist kein Geheimnis. Moreau sagte, dass jeder in der Großrechnerbranche diese Möglichkeit kenne (er zeigte mir ein Paper aus dem Jahr 2012, das sie demonstriert), sie aber mehr oder weniger als akademisch und unmöglich in großem Maßstab umsetzbar abtut. Aber ZeroPoint, sagte er, habe die Probleme der Komprimierung – die komprimierten Daten werden neu organisiert, um noch effizienter zu sein – und der Transparenz gelöst, sodass die Technologie nicht nur funktioniert, sondern auch ziemlich nahtlos in bestehende Systeme integriert werden kann. Und das alles geschieht in einer Handvoll Nanosekunden.

„Die meisten Komprimierungstechnologien, sowohl Software als auch Hardware, liegen im Bereich von Tausenden von Nanosekunden. CXL [compute express link, a high-speed interconnect standard] „Wir können das auf Hunderte reduzieren“, sagte Moreau. „Wir können es auf 3 oder 4 reduzieren.“

Hier erklärt es CTO Angelos Arelakis auf seine Weise:

Das Debüt von ZeroPoint kommt sicherlich zum richtigen Zeitpunkt, da Unternehmen auf der ganzen Welt auf der Suche nach schnelleren und kostengünstigeren Rechenleistungen sind, mit denen sie eine weitere Generation von KI-Modellen trainieren können. Die meisten Hyperscaler (wenn man sie so nennen darf) sind an jeder Technologie interessiert, die ihnen mehr Leistung pro Watt liefern oder die Stromrechnung ein wenig senken kann.

Der wichtigste Vorbehalt bei all dem ist einfach, dass dies, wie erwähnt, auf dem Chip enthalten und von Grund auf integriert werden muss – man kann nicht einfach einen ZeroPoint-Dongle in das Rack stecken. Zu diesem Zweck arbeitet das Unternehmen mit Chipherstellern und Systemintegratoren zusammen, um die Technik und das Hardwaredesign für Standardchips für Hochleistungsrechner zu lizenzieren.

Natürlich sind das Ihre Nvidias und Ihre Intels, aber zunehmend auch Unternehmen wie Meta, Google und Apple, die maßgeschneiderte Hardware entwickelt haben, um ihre KI und andere kostenintensive Aufgaben intern auszuführen. ZeroPoint positioniert seine Technologie jedoch als Kosteneinsparung und nicht als Prämie: Es ist denkbar, dass sich die Technologie durch die effektive Verdoppelung des Speichers schon bald amortisiert.

Die gerade abgeschlossene A-Runde in Höhe von 5 Millionen Euro wurde von Matterwave Ventures angeführt, wobei Industrifonden als lokaler nordischer Lead fungierte und die bestehenden Investoren Climentum Capital und Chalmers Ventures ebenfalls einen Beitrag leisteten.

Moreau sagte, dass das Geld es ihnen ermöglichen sollte, in US-Märkte zu expandieren und ihre Aktivitäten in den schwedischen Märkten, die sie bereits verfolgen, zu verdoppeln.