Die ultimative Errungenschaft für einige in der KI-Branche ist die Schaffung eines Systems mit künstlicher allgemeiner Intelligenz (AGI) oder der Fähigkeit, jede Aufgabe zu verstehen und zu lernen, die ein Mensch kann. Lange in den Bereich der Science-Fiction verbannt, wurde vorgeschlagen, dass AGI Systeme hervorbringen würde, die in der Lage sind, zu argumentieren, zu planen, zu lernen, Wissen darzustellen und in natürlicher Sprache zu kommunizieren.

Nicht jeder Experte ist davon überzeugt, dass AGI ein realistisches Ziel – oder überhaupt möglich – ist. Aber es könnte argumentiert werden, dass DeepMind, das von Alphabet unterstützte Forschungslabor, diese Woche mit der Veröffentlichung eines KI-Systems namens Gato,

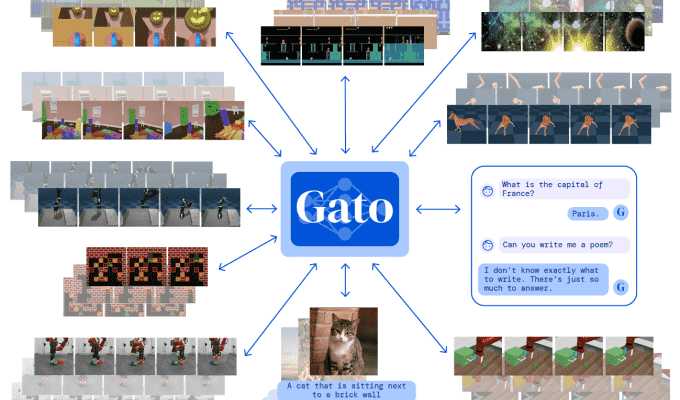

Gato ist das, was DeepMind als „Allzweck“-System beschreibt, ein System, dem beigebracht werden kann, viele verschiedene Arten von Aufgaben auszuführen. Die Forscher von DeepMind haben Gato trainiert, 604 zu vollenden, um genau zu sein, einschließlich Bildunterschriften, Dialoge, das Stapeln von Blöcken mit einem echten Roboterarm und das Spielen von Atari-Spielen.

Jack Hessel, Forscher am Allen Institute for AI, weist darauf hin, dass ein einzelnes KI-System, das viele Aufgaben lösen kann, nicht neu ist. Beispielsweise hat Google vor kurzem damit begonnen, ein System in der Google-Suche namens Multitask Unified Model (MUM) zu verwenden, das Text, Bilder und Videos verarbeiten kann, um Aufgaben auszuführen, von der Suche nach interlingualen Variationen in der Schreibweise eines Wortes bis hin zur Zuordnung einer Suchanfrage zu einem Bild . Aber was ist potentiell neuer sei hier, so Hessel, die Vielfältigkeit der angegangenen Aufgaben und der Trainingsmethode.

Gato-Architektur von DeepMind.

„Wir haben bereits früher Beweise dafür gesehen, dass einzelne Modelle überraschend unterschiedliche Arten von Eingaben verarbeiten können“, sagte Hessel per E-Mail gegenüber Tech. „Die Kernfrage beim Multitasking-Lernen ist aus meiner Sicht … ob sich die Aufgaben ergänzen oder nicht. Sie könnten sich einen langweiligeren Fall vorstellen, wenn das Modell die Aufgaben vor dem Lösen implizit trennt, z. ‚ Für diese Nullhypothese könnte eine ähnliche Leistung erzielt werden, indem A und B getrennt trainiert würden, was nicht gerade berauschend ist. Wenn dagegen das gemeinsame Training von A und B bei einem (oder bei beiden!) zu Verbesserungen führt, dann ist die Sache spannender.“

Wie alle KI-Systeme lernte Gato anhand von Beispielen, indem es Milliarden von Wörtern, Bilder aus realen und simulierten Umgebungen, Tastendrücke, Gelenkdrehmomente und mehr in Form von Token aufnahm. Diese Token dienten dazu, Daten so darzustellen, dass Gato es verstehen konnte, und ermöglichten es dem System, beispielsweise die Mechanik von Breakout herauszuarbeiten oder herauszufinden, welche Wortkombination in einem Satz grammatikalisch sinnvoll sein könnte.

Gato übernimmt diese Aufgaben nicht unbedingt Gut. Wenn Sie beispielsweise mit einer Person chatten, antwortet das System häufig mit einer oberflächlichen oder sachlich falschen Antwort (z. B. „Marseille“ als Antwort auf „Was ist die Hauptstadt von Frankreich?“). In Bildunterschriften verdreht Gato Menschen. Und das System stapelt Blöcke mit einem echten Roboter nur in 60 % der Fälle korrekt.

Aber bei 450 der 604 oben genannten Aufgaben behauptet DeepMind, dass Gato mehr als die Hälfte der Zeit besser abschneidet als ein Experte.

„Wenn Sie der Meinung sind, dass wir General brauchen [systems]also viele Leute im Bereich KI und maschinelles Lernen [Gato is] eine große Sache“, sagte Matthew Guzdial, Assistenzprofessor für Informatik an der University of Alberta, Tech per E-Mail. „Ich denke, die Leute, die sagen, es sei ein großer Schritt in Richtung AGI, übertreiben es etwas, da wir immer noch nicht bei der menschlichen Intelligenz angelangt sind und wahrscheinlich (meiner Meinung nach) nicht bald dorthin gelangen werden. Ich persönlich stehe eher im Lager der vielen kleinen Modelle [and systems] nützlicher, aber diese allgemeinen Modelle haben definitiv Vorteile in Bezug auf ihre Leistung bei Aufgaben außerhalb ihrer Trainingsdaten.“

Seltsamerweise unterscheidet sich Gato aus architektonischer Sicht nicht wesentlich von vielen der heute in Produktion befindlichen KI-Systeme. Es teilt Eigenschaften mit OpenAIs GPT-3 in dem Sinne, dass es ein „Transformer“ ist. Seit 2017 ist der Transformer zur Architektur der Wahl für komplexe Denkaufgaben geworden und hat gezeigt, dass er in der Lage ist, Dokumente zusammenzufassen, Musik zu erzeugen, Objekte in Bildern zu klassifizieren und Proteinsequenzen zu analysieren.

Die verschiedenen Aufgaben, die Gato zu erledigen gelernt hat.

Vielleicht noch bemerkenswerter ist, dass Gato in Bezug auf die Parameteranzahl um Größenordnungen kleiner ist als Single-Task-Systeme, einschließlich GPT-3. Parameter sind die Teile des Systems, die aus Trainingsdaten gelernt wurden, und definieren im Wesentlichen die Fähigkeiten des Systems bei einem Problem, wie z. B. der Generierung von Text. Gato hat nur 1,2 Milliarden, während GPT-3 mehr als 170 Milliarden hat.

DeepMind-Forscher hielten Gato absichtlich klein, damit das System einen Roboterarm in Echtzeit steuern konnte. Aber sie gehen davon aus, dass Gato – wenn es vergrößert wird – jede „Aufgabe, jedes Verhalten und jede Verkörperung von Interesse“ bewältigen könnte.

Unter der Annahme, dass dies der Fall ist, müssten mehrere andere Hürden überwunden werden, um Gato in bestimmten Aufgaben gegenüber hochmodernen Single-Task-Systemen überlegen zu machen, wie z. B. Gatos Unfähigkeit, kontinuierlich zu lernen. Wie die meisten Transformer-basierten Systeme basiert Gatos Wissen über die Welt auf den Trainingsdaten und bleibt statisch. Wenn Sie Gato eine datumskritische Frage stellen, wie z. B. den aktuellen Präsidenten der USA, würde er wahrscheinlich falsch antworten.

Der Transformer – und im weiteren Sinne Gato – hat eine weitere Einschränkung in seinem Kontextfenster oder der Menge an Informationen, an die sich das System im Kontext einer bestimmten Aufgabe „erinnern“ kann. Selbst die besten Transformer-basierten Sprachmodelle können keinen langen Aufsatz schreiben, geschweige denn ein Buch, ohne sich an wichtige Details zu erinnern und so den Überblick über die Handlung zu verlieren. Das Vergessen passiert bei jeder Aufgabe, ob beim Schreiben oder beim Steuern eines Roboters, weshalb einige Experten dies getan haben namens Es ist die „Achillesferse“ des maschinellen Lernens.

„Es ist nicht so, dass Gato neue Dinge möglich macht“, fügte Guzdial hinzu und wies auf die Mängel des Systems hin. „[B]Aber es macht deutlich, dass wir mit modernen maschinellen Lernmodellen mehr erreichen können, als wir dachten.“