Ein Verkaufsargument für Googles Vorzeigemodelle für generative KI, Gemini 1.5 Pro und 1.5 Flash, ist die Menge an Daten, die sie angeblich verarbeiten und analysieren können. In Pressekonferenzen und Demos hat Google wiederholt behauptet, dass die Modelle dank ihres „langen Kontexts“ bisher unmögliche Aufgaben bewältigen können, wie etwa das Zusammenfassen mehrerer hundertseitiger Dokumente oder das Durchsuchen von Szenen in Filmmaterial.

Doch neue Forschungsergebnisse deuten darauf hin, dass die Modelle für diese Dinge tatsächlich nicht besonders gut sind.

Zwei separate Studien untersuchten, wie gut Googles Gemini-Modelle und andere Modelle aus einer enormen Datenmenge einen Sinn ableiten – man denke an Werke in der Länge von „Krieg und Frieden“. Beide kamen zu dem Ergebnis, dass Gemini 1.5 Pro und 1.5 Flash Schwierigkeiten haben, Fragen zu großen Datensätzen richtig zu beantworten; in einer Reihe dokumentenbasierter Tests gaben die Modelle nur in 40 % bis 50 % der Fälle die richtige Antwort.

„Obwohl Modelle wie Gemini 1.5 Pro technisch gesehen lange Kontexte verarbeiten können, haben wir viele Fälle gesehen, die darauf hinweisen, dass die Modelle den Inhalt nicht wirklich ‚verstehen‘“, sagte Marzena Karpinska, Postdoc an der UMass Amherst und Co-Autorin einer der Studien, gegenüber Tech.

Das Kontextfenster von Gemini fehlt

Der Kontext oder das Kontextfenster eines Modells bezieht sich auf Eingabedaten (z. B. Text), die das Modell berücksichtigt, bevor es eine Ausgabe (z. B. zusätzlichen Text) generiert. Eine einfache Frage – „Wer hat die US-Präsidentschaftswahl 2020 gewonnen?“ – kann als Kontext dienen, ebenso wie ein Filmskript, eine Show oder ein Audioclip. Und wenn Kontextfenster größer werden, wächst auch die Größe der Dokumente, die in sie passen.

Die neuesten Versionen von Gemini können über 2 Millionen Token als Kontext verarbeiten. („Token“ sind unterteilte Rohdaten, wie etwa die Silben „fan“, „tas“ und „tic“ im Wort „fantastic“.) Das entspricht etwa 1,4 Millionen Wörtern, zwei Stunden Video oder 22 Stunden Audio – der größte Kontext aller kommerziell erhältlichen Modelle.

In einem Briefing Anfang des Jahres zeigte Google mehrere aufgezeichnete Demos, die das Potenzial der Long-Context-Fähigkeiten von Gemini veranschaulichen sollten. In einer dieser Demos durchsuchte Gemini 1.5 Pro das Transkript der Fernsehübertragung der Mondlandung von Apollo 11 – rund 402 Seiten – nach Zitaten mit Witzen und fand dann eine Szene in der Übertragung, die einer Bleistiftskizze ähnelte.

Oriol Vinyals, Vizepräsident für Forschung bei Google DeepMind, der die Besprechung leitete, beschrieb das Modell als „magisch“.

„[1.5 Pro] führt diese Art von Denkaufgaben auf jeder einzelnen Seite, bei jedem einzelnen Wort durch“, sagte er.

Das war möglicherweise übertrieben.

In einer der oben genannten Studien, in denen diese Fähigkeiten getestet wurden, baten Karpinska und Forscher des Allen Institute for AI und Princeton die Modelle, Wahr/Falsch-Aussagen über englischsprachige Romane zu bewerten. Die Forscher wählten aktuelle Werke aus, damit die Modelle nicht auf Vorwissen „schummeln“ konnten, und sie würzten die Aussagen mit Verweisen auf bestimmte Details und Handlungspunkte, die ohne die vollständige Lektüre der Bücher unmöglich zu verstehen wären.

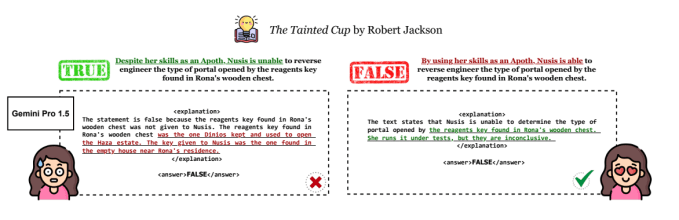

Bei einer Aussage wie „Durch den Einsatz ihrer Fähigkeiten als Apoth ist Nusis in der Lage, den Portaltyp zurückzuentwickeln, der durch den Reagenzienschlüssel geöffnet wird, der sich in Ronas Holztruhe befindet“, mussten Gemini 1.5 Pro und 1.5 Flash – nachdem sie das entsprechende Buch gelesen hatten – sagen, ob die Aussage wahr oder falsch war, und ihre Begründung begründen.

Bei einem Test mit einem Buch mit rund 260.000 Wörtern (~520 Seiten) Länge stellten die Forscher fest, dass 1.5 Pro die Richtig/Falsch-Aussagen in 46,7 % der Fälle richtig beantwortete, während Flash nur in 20 % der Fälle richtig antwortete. Das bedeutet, dass eine Münze Fragen zu dem Buch deutlich besser beantworten kann als Googles neuestes maschinelles Lernmodell. Im Durchschnitt aller Benchmark-Ergebnisse erreichte keines der Modelle eine höhere Genauigkeit bei der Beantwortung von Fragen als der Zufall.

„Wir haben festgestellt, dass die Modelle größere Schwierigkeiten haben, Behauptungen zu verifizieren, die die Betrachtung größerer Teile des Buches oder sogar des gesamten Buches erfordern, als Behauptungen, die durch das Abrufen von Beweisen auf Satzebene gelöst werden können“, sagte Karpinska. „Qualitativ haben wir auch festgestellt, dass die Modelle Schwierigkeiten haben, Behauptungen über implizite Informationen zu verifizieren, die für einen menschlichen Leser klar sind, aber nicht explizit im Text angegeben sind.“

Die zweite der beiden Studien, die von Forschern der UC Santa Barbara gemeinsam verfasst wurde, testete die Fähigkeit von Gemini 1.5 Flash (aber nicht 1.5 Pro), Videos zu „durchdenken“ – das heißt, den Inhalt der Videos zu durchsuchen und Fragen dazu zu beantworten.

Die Co-Autoren erstellten einen Datensatz mit Bildern (z. B. ein Foto einer Geburtstagstorte) und fügten Fragen zu den in den Bildern dargestellten Objekten hinzu, die das Modell beantworten sollte (z. B. „Welche Zeichentrickfigur ist auf dieser Torte?“). Um die Modelle zu bewerten, wählten sie nach dem Zufallsprinzip eines der Bilder aus und fügten davor und danach „Ablenker“-Bilder ein, um diashowähnliches Filmmaterial zu erstellen.

Flash schnitt nicht so gut ab. In einem Test, bei dem das Modell sechs handgeschriebene Ziffern aus einer „Diashow“ mit 25 Bildern transkribieren musste, machte Flash etwa 50 % der Transkriptionen richtig. Bei acht Ziffern sank die Genauigkeit auf etwa 30 %.

„Bei echten Frage-Antwort-Aufgaben zu Bildern scheint es für alle von uns getesteten Modelle besonders schwierig zu sein“, sagte Michael Saxon, Doktorand an der UC Santa Barbara und einer der Co-Autoren der Studie, gegenüber Tech. „Diese geringe Menge an Denkvermögen – das Erkennen, dass eine Zahl in einem Rahmen steht und das Lesen dieser Zahl – könnte der Grund sein, warum das Modell nicht funktioniert.“

Google verspricht mit Gemini zu viel

Keine der Studien wurde von Experten begutachtet, noch untersuchen sie die Versionen von Gemini 1.5 Pro und 1.5 Flash mit 2-Millionen-Token-Kontexten. (Beide testeten die Versionen mit 1-Millionen-Token-Kontext.) Und Flash soll in puncto Leistung nicht so leistungsfähig sein wie Pro; Google bewirbt es als kostengünstige Alternative.

Dennoch gießen beides Öl ins Feuer, dass Google mit Gemini von Anfang an zu viel versprochen – und zu wenig geliefert – hat. Keines der von den Forschern getesteten Modelle, darunter GPT-4o von OpenAI und Claude 3.5 Sonnet von Anthropics, schnitt gut ab. Aber Google ist der einzige Modellanbieter, der dem Kontextfenster in seinen Anzeigen den höchsten Stellenwert einräumt.

„An der einfachen Behauptung ‚Unser Modell kann eine bestimmte Anzahl von Token aufnehmen‘ ist aufgrund der objektiven technischen Details nichts auszusetzen“, sagte Saxon. „Aber die Frage ist, was man damit Nützliches tun kann.“

Generative KI gerät im Allgemeinen zunehmend ins Blickfeld der Kritik, da Unternehmen (und Investoren) zunehmend frustriert über die Einschränkungen dieser Technologie sind.

In zwei aktuellen Umfragen der Boston Consulting Group gaben etwa die Hälfte der Befragten – allesamt Führungskräfte der obersten Führungsebene – an, dass sie nicht erwarten, dass generative KI zu wesentlichen Produktivitätssteigerungen führt, und dass sie sich über das Potenzial für Fehler und Datenkompromittierungen sorgen, die durch generative KI-gestützte Tools entstehen. PitchBook hat kürzlich gemeldet dass in zwei aufeinanderfolgenden Quartalen die Zahl der generativen KI-Geschäftsabschlüsse in den frühesten Phasen zurückgegangen ist und gegenüber dem Höchststand im dritten Quartal 2023 um 76 % eingebrochen ist.

Angesichts von Chatbots, die Besprechungen zusammenfassen und fiktive Details über Personen ausspucken, und KI-Suchplattformen, die im Grunde genommen Plagiatsgeneratoren sind, suchen Kunden nach vielversprechenden Differenzierungsmerkmalen. Google – das, wenn auch manchmal unbeholfen, versucht hat, seine generative KI-Konkurrenten einzuholen – versuchte verzweifelt, den Kontext von Gemini zu einem dieser Differenzierungsmerkmale zu machen.

Doch die Wette war offenbar verfrüht.

„Wir haben uns noch nicht auf eine Methode geeinigt, um wirklich zu beweisen, dass ‚Argumentation‘ oder ‚Verständnis‘ über lange Dokumente hinweg stattfindet, und im Grunde bastelt jede Gruppe, die diese Modelle veröffentlicht, ihre eigenen Ad-hoc-Bewertungen zusammen, um diese Behauptungen aufzustellen“, sagte Karpinska. „Ohne das Wissen darüber, wie lange Kontextverarbeitung implementiert ist – und Unternehmen geben diese Details nicht preis – ist es schwer zu sagen, wie realistisch diese Behauptungen sind.“

Google hat auf eine Bitte um Stellungnahme nicht geantwortet.

Saxon und Karpinska sind beide der Meinung, dass die Gegenmittel zu den übertriebenen Behauptungen rund um generative KI bessere Benchmarks und, in diesem Sinne, eine stärkere Betonung der Kritik durch Dritte seien. Saxon weist darauf hin, dass einer der gebräuchlichsten Tests für lange Kontexte (der von Google in seinen Marketingmaterialien großzügig zitiert wird), die „Nadel im Heuhaufen“, nur die Fähigkeit eines Modells misst, bestimmte Informationen wie Namen und Zahlen aus Datensätzen abzurufen – und nicht komplexe Fragen zu diesen Informationen zu beantworten.

„Alle Wissenschaftler und die meisten Ingenieure, die diese Modelle verwenden, sind sich im Wesentlichen einig, dass unsere bestehende Benchmark-Kultur nicht funktioniert“, sagte Saxon. „Deshalb ist es wichtig, dass die Öffentlichkeit versteht, dass diese riesigen Berichte mit Zahlen wie ‚allgemeine Intelligenz über Benchmarks hinweg‘ mit einer gehörigen Portion Skepsis betrachtet werden müssen.“