Heutzutage kann man kaum eine Stunde verbringen, ohne über generative KI zu lesen. Während wir uns noch in der embryonalen Phase dessen befinden, was manche haben Angesichts der „Dampfmaschine“ der vierten industriellen Revolution besteht wenig Zweifel daran, dass die „GenAI“ dabei ist, praktisch jede Branche umzugestalten – von der Finanz- und Gesundheitsbranche bis hin zur Rechtsbranche und darüber hinaus.

Coole, benutzerorientierte Anwendungen mögen zwar den größten Wirbel verursachen, aber die Unternehmen, die diese Revolution vorantreiben, profitieren derzeit am meisten davon. Erst in diesem Monat hat der Chiphersteller Nvidia wurde kurzzeitig das wertvollste Unternehmen der Welt, ein 3,3 Billionen Dollar schwerer Gigant, der maßgeblich von der Nachfrage nach KI-Rechenleistung getrieben wird.

Doch zusätzlich zu den GPUs (Graphics Processing Units) benötigen Unternehmen auch eine Infrastruktur zur Verwaltung des Datenflusses – zum Speichern, Verarbeiten, Trainieren, Analysieren und letztendlich zum Ausschöpfen des gesamten KI-Potenzials.

Ein Unternehmen, das davon profitieren möchte, ist Ein Hausein drei Jahre altes kalifornisches Startup, gegründet von Vinoth Chandarder Open Source erstellt hat Apache Hudi Projekt, während er als Datenarchitekt bei Uber arbeitete. Hudi bringt die Vorteile von Data Warehouse Zu Datenseenwodurch ein sogenanntes „Data Lakehouse“ entsteht, das Aktionen wie die Indizierung und Durchführung von Echtzeitabfragen für große Datensätze unterstützt, seien es strukturierte, unstrukturierte oder halbstrukturierte Daten.

Ein E-Commerce-Unternehmen beispielsweise, das kontinuierlich Kundendaten sammelt, darunter Bestellungen, Feedback und damit verbundene digitale Interaktionen, benötigt ein System, das all diese Daten aufnimmt und sicherstellt, dass sie auf dem neuesten Stand bleiben. So kann es Produkte basierend auf der Aktivität eines Benutzers empfehlen. Hudi ermöglicht die Aufnahme von Daten aus verschiedenen Quellen mit minimaler Latenz und unterstützt das Löschen, Aktualisieren und Einfügen („Upsert“), was für solche Echtzeit-Datenanwendungsfälle von entscheidender Bedeutung ist.

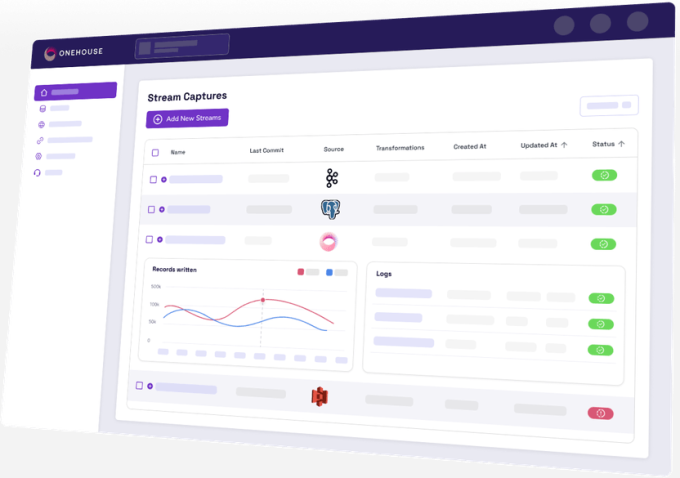

Onehouse baut darauf mit einem vollständig verwalteten Data Lakehouse auf, das Unternehmen bei der Bereitstellung von Hudi unterstützt. Oder, wie Chandar es ausdrückt: Es „startet die Aufnahme und Standardisierung von Daten in offene Datenformate“, die mit fast allen wichtigen Tools in den Ökosystemen für Datenwissenschaft, KI und maschinelles Lernen verwendet werden können.

„Onehouse abstrahiert den Ausbau der Dateninfrastruktur auf niedriger Ebene und hilft KI-Unternehmen, sich auf ihre Modelle zu konzentrieren“, sagte Chandar gegenüber Tech.

Heute gab Onehouse bekannt, dass es in einer Finanzierungsrunde der Serie B 35 Millionen US-Dollar aufgebracht hat, um zwei neue Produkte auf den Markt zu bringen, die die Leistung von Hudi verbessern und die Kosten für Cloud-Speicher und -Verarbeitung senken sollen.

Unten im (Daten-)Seehaus

Chandar hat Hudi 2016 als internes Projekt bei Uber ins Leben gerufen. Seitdem ist das Fahrdienstunternehmen spendete das Projekt zur Apache Foundation im Jahr 2019, Hudi wurde angenommen bis zum wie AmazonDisney und Walmart.

Chandar verließ Uber 2019 und gründete nach einer kurzen Zeit bei Confluent Onehouse. Das Startup tauchte 2022 mit 8 Millionen Dollar Startkapital aus dem Verborgenen auf und folgte kurz darauf mit einer Serie-A-Finanzierungsrunde über 25 Millionen Dollar. Beide Runden wurden gemeinsam von Greylock Partners und Addition geleitet.

Diese VC-Firmen haben sich für die Folgerunde der Serie B erneut zusammengeschlossen, dieses Mal führt jedoch David Sacks‘ Craft Ventures die Runde an.

„Das Data Lakehouse entwickelt sich schnell zur Standardarchitektur für Organisationen, die ihre Daten zentralisieren möchten, um neue Dienste wie Echtzeitanalysen, prädiktives ML und GenAI zu betreiben“, sagte Michael Robinson, Partner von Craft Ventures, in einer Erklärung.

Zum Kontext: Data Warehouses und Data Lakes sind sich in ihrer Funktion als zentrales Repository zum Zusammenführen von Daten ähnlich. Sie tun dies jedoch auf unterschiedliche Weise: Ein Data Warehouse ist ideal für die Verarbeitung und Abfrage historischer, strukturierter Daten, während sich Data Lakes als flexiblere Alternative zur Speicherung großer Mengen von Rohdaten in ihrem ursprünglichen Format herausgestellt haben, da sie mehrere Datentypen und Hochleistungsabfragen unterstützen.

Dadurch eignen sich Data Lakes ideal für KI- und Machine-Learning-Workloads, da die Speicherung bereits transformierter Rohdaten kostengünstiger ist und gleichzeitig komplexere Abfragen unterstützt werden, da die Daten in ihrer ursprünglichen Form gespeichert werden können.

Der Kompromiss besteht jedoch in einer ganzen Reihe neuer Komplexitäten im Datenmanagement, die angesichts der großen Vielfalt an Datentypen und -formaten die Gefahr bergen, dass sich die Datenqualität verschlechtert. Dies ist teilweise das, was Hudi lösen möchte, indem es einige Schlüsselfunktionen von Data Warehouses in Data Lakes überträgt, wie zum Beispiel ACID-Transaktionen um die Datenintegrität und -zuverlässigkeit zu unterstützen und die Metadatenverwaltung für vielfältigere Datensätze zu verbessern.

Da es sich um ein Open-Source-Projekt handelt, kann jedes Unternehmen Hudi einsetzen. Ein kurzer Blick auf die Logos auf der Website von Onehouse zeigt einige beeindruckende Benutzer: AWS, Google, Tencent, Disney, Walmart, Bytedance, Uber und Huawei, um nur einige zu nennen. Aber die Tatsache, dass so namhafte Unternehmen Hudi intern nutzen, zeigt den Aufwand und die Ressourcen, die erforderlich sind, um es als Teil eines lokalen Data-Lakehouse-Setups aufzubauen.

„Während Hudi umfangreiche Funktionen zum Aufnehmen, Verwalten und Transformieren von Daten bietet, müssen Unternehmen immer noch etwa ein halbes Dutzend Open-Source-Tools integrieren, um ihr Ziel eines Data Lakehouse in Produktionsqualität zu erreichen“, sagte Chandar.

Aus diesem Grund bietet Onehouse eine vollständig verwaltete, Cloud-native Plattform, die die Daten in einem Bruchteil der Zeit aufnimmt, transformiert und optimiert.

„Benutzer können ein Open Data Lakehouse in weniger als einer Stunde zum Laufen bringen, mit breiter Interoperabilität mit allen wichtigen Cloud-nativen Diensten, Warehouses und Data Lake Engines“, sagte Chandar.

Das Unternehmen war zurückhaltend bei der Nennung seiner gewerblichen Kunden, abgesehen von dem Paar, das in Fallstudienwie das indische Einhorn Apna.

„Da wir ein junges Unternehmen sind, geben wir die vollständige Liste der gewerblichen Kunden von Onehouse derzeit nicht öffentlich bekannt“, sagte Chandar.

Mit frischen 35 Millionen Dollar auf der Bank erweitert Onehouse seine Plattform nun um ein kostenloses Tool namens Onehouse LakeView, das Einblick in die Lakehouse-Funktionalität bietet und Einblicke in Tabellenstatistiken, Trends, Dateigrößen, Zeitleistenverlauf und mehr bietet. Dies baut auf vorhandenen Beobachtungsmetriken auf, die vom Hudi-Kernprojekt bereitgestellt werden, und bietet zusätzlichen Kontext zu Arbeitslasten.

„Ohne LakeView müssen Benutzer viel Zeit damit verbringen, Metriken zu interpretieren und den gesamten Stack gründlich zu verstehen, um Leistungsprobleme oder Ineffizienzen in der Pipeline-Konfiguration zu ermitteln“, sagte Chandar. „LakeView automatisiert dies und bietet E-Mail-Benachrichtigungen zu guten oder schlechten Trends und weist auf Datenmanagementbedarf zur Verbesserung der Abfrageleistung hin.“

Darüber hinaus führt Onehouse ein neues Produkt namens Table Optimizer ein, einen verwalteten Cloud-Dienst, der vorhandene Tabellen optimiert, um die Datenaufnahme und -konvertierung zu beschleunigen.

„Offen und interoperabel“

Es gibt unzählige andere namhafte Akteure in diesem Bereich, die nicht ignoriert werden können. Unternehmen wie Databricks und Snowflake sind zunehmend Das Lakehouse-Paradigma annehmen: Früher in diesem Monat, Berichten zufolge verteilte Databricks 1 Milliarde US-Dollar für die Übernahme eines Unternehmens namens Tabular mit dem Ziel, einen gemeinsamen Lakehouse-Standard zu schaffen.

Onehouse ist definitiv in einem heiklen Bereich tätig, hofft aber, dass der Fokus auf ein „offenes und interoperables“ System, das die Abhängigkeit von einem bestimmten Anbieter leichter vermeidet, ihm dabei helfen wird, sich zu behaupten. Im Wesentlichen verspricht es die Möglichkeit, eine einzige Kopie der Daten universell von praktisch überall aus zugänglich zu machen, einschließlich Databricks, Snowflake, Cloudera und nativen AWS-Diensten, ohne dass für jeden davon separate Datensilos aufgebaut werden müssen.

Wie bei Nvidia im GPU-Bereich kann man die Chancen, die jedes Unternehmen im Bereich Datenmanagement erwartet, nicht ignorieren. Daten sind der Eckpfeiler der KI-Entwicklung, und der Mangel an ausreichenden Daten guter Qualität ist ein Hauptgrund warum viele KI-Projekte scheitern. Aber selbst wenn die Daten in Massen vorhanden sind, benötigen Unternehmen immer noch die Infrastruktur, um sie aufzunehmen, zu transformieren und zu standardisieren, damit sie nutzbar werden. Das verheißt Gutes für Onehouse und seinesgleichen.

„Aus Sicht der Datenverwaltung und -verarbeitung glaube ich, dass qualitativ hochwertige Daten, die von einer soliden Dateninfrastruktur bereitgestellt werden, eine entscheidende Rolle dabei spielen werden, diese KI-Projekte in reale Produktionsanwendungsfälle zu bringen – um Probleme mit Garbage-in/Garbage-out-Daten zu vermeiden“, sagte Chandar. „Wir sehen eine solche Nachfrage bei Data-Lakehouse-Benutzern, da sie Schwierigkeiten haben, die Datenverarbeitungs- und Abfrageanforderungen für den Aufbau dieser neueren KI-Anwendungen auf Daten im Unternehmensmaßstab zu skalieren.“