Ist es möglich, dass eine KI nur auf Daten trainiert wird, die von einer anderen KI generiert wurden? Es mag wie eine verrückte Idee klingen. Aber es gibt sie schon seit geraumer Zeit – und da es immer schwieriger wird, an neue, echte Daten zu kommen, gewinnt sie zunehmend an Bedeutung.

Anthropic nutzte einige synthetische Daten, um eines seiner Flaggschiffmodelle, Claude 3.5 Sonnet, zu trainieren. Meta hat seine Llama 3.1-Modelle mithilfe von KI-generierten Daten verfeinert. Und OpenAI soll für die kommende Zeit synthetische Trainingsdaten von o1, seinem „Reasoning“-Modell, beziehen Orion.

Aber warum braucht KI überhaupt Daten – und welche? Art an Daten braucht es? Und können diese Daten Wirklich durch synthetische Daten ersetzt werden?

Die Bedeutung von Anmerkungen

KI-Systeme sind statistische Maschinen. Anhand vieler Beispiele lernen sie die Muster in diesen Beispielen, um Vorhersagen zu treffen, wie zum Beispiel das „an wen“ in einer E-Mail normalerweise vor „es könnte etwas bedeuten“ steht.

Anmerkungen, in der Regel Text, der die Bedeutung oder Teile der von diesen Systemen erfassten Daten kennzeichnet, sind in diesen Beispielen ein Schlüsselelement. Sie dienen als Wegweiser und „lehren“ ein Modell zur Unterscheidung zwischen Dingen, Orten und Ideen.

Betrachten Sie ein Fotoklassifizierungsmodell, das viele Bilder von Küchen zeigt, die mit dem Wort „Küche“ beschriftet sind. Während des Trainings beginnt das Modell, Assoziationen zwischen „Küche“ und „Allgemein“ herzustellen Eigenschaften von Küchen (z. B. dass sie Kühlschränke und Arbeitsplatten enthalten). Nach dem Training sollte das Modell anhand eines Fotos einer Küche, das nicht in den ersten Beispielen enthalten war, in der Lage sein, diese als solche zu identifizieren. (Wenn die Bilder von Küchen natürlich mit „Kuh“ gekennzeichnet wären, wären sie natürlich als Kühe gekennzeichnet, was die Bedeutung guter Anmerkungen unterstreicht.)

Der Appetit auf KI und die Notwendigkeit, gekennzeichnete Daten für ihre Entwicklung bereitzustellen, haben den Markt für Annotationsdienste in die Höhe getrieben. Dimension Marktforschung Schätzungen dass es heute 838,2 Millionen US-Dollar wert ist – und in den nächsten zehn Jahren 10,34 Milliarden US-Dollar wert sein wird. Es gibt zwar keine genauen Schätzungen darüber, wie viele Menschen im Jahr 2022 an der Kennzeichnungsarbeit beteiligt sind Papier beziffert die Zahl auf „Millionen“.

Große und kleine Unternehmen verlassen sich auf Mitarbeiter von Datenannotationsfirmen, um Etiketten für KI-Trainingssätze zu erstellen. Einige dieser Jobs werden einigermaßen gut bezahlt, insbesondere wenn die Bezeichnung spezielle Kenntnisse erfordert (z. B. Mathematikkenntnisse). Andere können anstrengend sein. Kommentatoren in Entwicklungsländern werden im Durchschnitt nur ein paar Dollar pro Stunde bezahlt ohne irgendwelche Vorteile oder Garantien für zukünftige Auftritte.

Ein trocknender Datenbrunnen

Es gibt also humanistische Gründe, nach Alternativen zu von Menschen erstellten Etiketten zu suchen. Aber es gibt auch praktische.

Menschen können nur so schnell beschriften. Annotatoren haben auch Vorurteile, die sich in ihren Annotationen und in der Folge auch in allen darauf trainierten Modellen manifestieren können. Kommentatoren machen Fehleroder durch die Kennzeichnung von Anweisungen stolpern. Und es ist teuer, Menschen dafür zu bezahlen, Dinge zu tun.

Daten im Allgemeinen ist übrigens teuer. Shutterstock verlangt von KI-Anbietern Dutzende Millionen Dollar für den Zugriff darauf Archivwährend Reddit Hunderte Millionen durch die Lizenzierung von Daten an Google, OpenAI und andere verdient hat.

Schließlich wird es auch immer schwieriger, Daten zu beschaffen.

Die meisten Modelle werden auf der Grundlage umfangreicher öffentlicher Datensammlungen trainiert – Daten, die Eigentümer immer häufiger zurückhalten, weil sie befürchten, dass ihre Daten plagiiert werden könnten oder dass sie dafür keine Anerkennung oder Zuschreibung erhalten. Mehr als 35 % der 1.000 besten Websites der Welt Blockieren Sie jetzt den Web Scraper von OpenAI. Und etwa 25 % der Daten aus „hochwertigen“ Quellen wurden kürzlich aus den wichtigsten Datensätzen, die zum Trainieren von Modellen verwendet werden, ausgeschlossen Studie gefunden.

Sollte sich der aktuelle Trend zur Zugangssperre fortsetzen, wird die Forschungsgruppe Epoch AI Projekte dass den Entwicklern zwischen 2026 und 2032 die Daten zum Trainieren generativer KI-Modelle ausgehen werden. Dies, gepaart mit der Befürchtung, dass Urheberrechtsklagen und anstößiges Material in offene Datensätze gelangen könnten, hat die KI-Anbieter zu einer Abrechnung gezwungen.

Synthetische Alternativen

Auf den ersten Blick scheinen synthetische Daten die Lösung all dieser Probleme zu sein. Benötigen Sie Anmerkungen? Generiere sie. Weitere Beispieldaten? Kein Problem. Der Himmel ist die Grenze.

Und bis zu einem gewissen Grad stimmt das auch.

„Wenn ‚Daten das neue Öl‘ sind, stellen sich synthetische Daten als Biokraftstoff dar, der ohne die negativen externen Effekte der realen Sache erzeugt werden kann“, sagte Os Keyes, ein Doktorand an der University of Washington, der die ethischen Auswirkungen neuer Technologien untersucht, gegenüber Tech . „Man kann einen kleinen Ausgangsdatensatz nehmen und daraus neue Einträge simulieren und extrapolieren.“

Die KI-Branche hat das Konzept übernommen und umgesetzt.

Diesen Monat stellte Writer, ein unternehmensorientiertes Unternehmen für generative KI, ein Modell vor, Palmyra X 004, das fast ausschließlich auf synthetischen Daten trainiert wurde. Die Entwicklung habe nur 700.000 US-Dollar gekostet, behauptet der Autor – verglichen Schätzungen gehen von 4,6 Millionen US-Dollar für ein OpenAI-Modell vergleichbarer Größe aus.

Die offenen Phi-Modelle von Microsoft wurden teilweise mithilfe synthetischer Daten trainiert. Das galt auch für die Gemma-Modelle von Google. Nvidia diesen Sommer stellte eine Modellfamilie vor, die zur Generierung synthetischer Trainingsdaten entwickelt wurde, und das KI-Startup Hugging Face veröffentlichte kürzlich das, was es angeblich ist größter KI-Trainingsdatensatz von synthetischem Text.

Die Generierung synthetischer Daten ist zu einem eigenständigen Geschäft geworden – und das könnte es auch sein Wert 2,34 Milliarden US-Dollar bis 2030. Gartner prognostiziert dass 60 % der in diesem Jahr für KI- und Analytics-Projekte verwendeten Daten synthetisch generiert werden.

Luca Soldaini, leitender Forschungswissenschaftler am Allen Institute for AI, stellte fest, dass synthetische Datentechniken verwendet werden können, um Trainingsdaten in einem Format zu generieren, das nicht einfach durch Scraping (oder sogar durch Inhaltslizenzierung) zu erhalten ist. Beim Training seines Videogenerators Movie Gen verwendete Meta beispielsweise Llama 3, um Untertitel für Filmmaterial in den Trainingsdaten zu erstellen, die dann von Menschen verfeinert wurden, um weitere Details wie Beschreibungen der Beleuchtung hinzuzufügen.

In diesem Sinne sagt OpenAI, dass es GPT-4o mithilfe synthetischer Daten verfeinert hat, um die skizzenblockähnliche Canvas-Funktion für ChatGPT zu erstellen. Und Amazon hat sagte dass es synthetische Daten generiert, um die realen Daten zu ergänzen, die es zum Trainieren von Spracherkennungsmodellen für Alexa verwendet.

„Synthetische Datenmodelle können verwendet werden, um die menschliche Intuition schnell zu erweitern und herauszufinden, welche Daten benötigt werden, um ein bestimmtes Modellverhalten zu erreichen“, sagte Soldaini.

Synthetische Risiken

Synthetische Daten sind jedoch kein Allheilmittel. Sie leidet unter dem gleichen „Müll rein, Müll raus“-Problem wie alle KI. Modelle erstellen synthetische Daten, und wenn die zum Training dieser Modelle verwendeten Daten Verzerrungen und Einschränkungen aufweisen, werden ihre Ergebnisse in ähnlicher Weise verfälscht. Beispielsweise sind Gruppen, die in den Basisdaten schlecht repräsentiert sind, auch in den synthetischen Daten nicht vertreten.

„Das Problem ist, dass man nur eine begrenzte Menge tun kann“, sagte Keyes. „Angenommen, Sie haben nur 30 Schwarze in einem Datensatz. Eine Hochrechnung könnte hilfreich sein, aber wenn diese 30 Personen alle aus der Mittelschicht stammen oder alle hellhäutig sind, werden die „repräsentativen“ Daten alle so aussehen.“

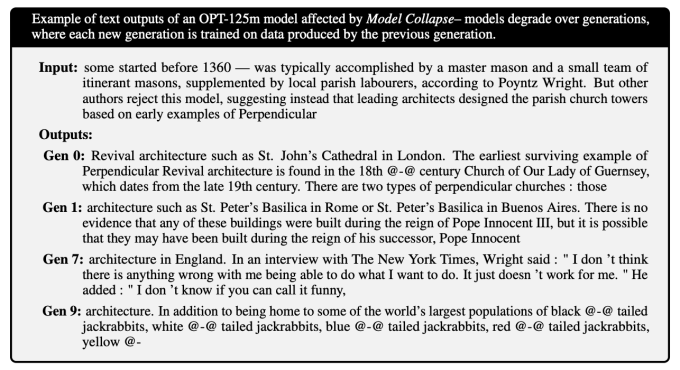

Bis hierher ein 2023 Studie Forscher der Rice University und Stanford fanden heraus, dass eine übermäßige Abhängigkeit von synthetischen Daten während des Trainings zu Modellen führen kann, deren „Qualität oder Vielfalt zunehmend abnimmt“. Die Stichprobenverzerrung – eine schlechte Darstellung der realen Welt – führt laut den Forschern dazu, dass sich die Diversität eines Modells nach einigen Generationen des Trainings verschlechtert (obwohl sie auch herausfanden, dass das Einmischen einiger Daten aus der realen Welt dazu beiträgt, dies zu mildern).

Keyes sieht zusätzliche Risiken in komplexen Modellen wie o1 von OpenAI, die seiner Meinung nach zu schwerer erkennbaren Halluzinationen in ihren synthetischen Daten führen könnten. Dies wiederum könnte die Genauigkeit der auf den Daten trainierten Modelle verringern – insbesondere, wenn die Quellen der Halluzinationen nicht leicht zu identifizieren sind.

„Komplexe Modelle halluzinieren; „Daten, die von komplexen Modellen erzeugt werden, enthalten Halluzinationen“, fügte Keyes hinzu. „Und bei einem Modell wie o1 können die Entwickler selbst nicht unbedingt erklären, warum Artefakte auftreten.“

Sich verschlimmernde Halluzinationen können zu Modellen führen, die Kauderwelsch spucken. A Studie Die in der Fachzeitschrift Nature veröffentlichte Studie enthüllt, wie Modelle, die auf fehlerbehafteten Daten trainiert werden, generieren noch mehr fehlerbehaftete Daten und wie diese Rückkopplungsschleife zukünftige Modellgenerationen beeinträchtigt. Die Forscher stellten fest, dass Modelle im Laufe der Generationen ihr Verständnis für esoterischeres Wissen verlieren – sie werden allgemeiner und liefern oft Antworten, die für die ihnen gestellten Fragen irrelevant sind.

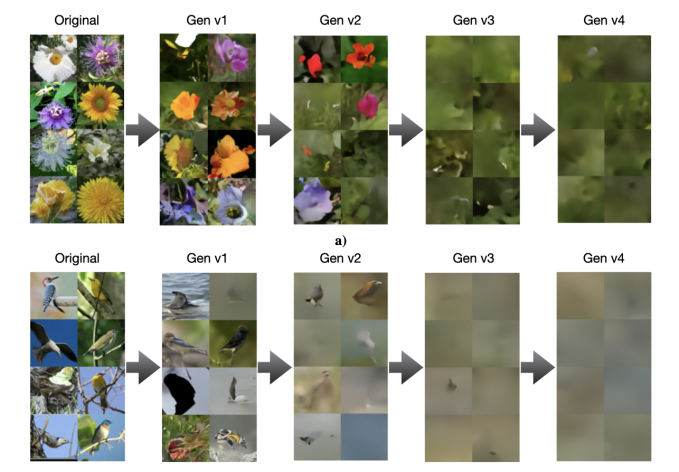

Ein Nachtrag Studie zeigt, dass auch andere Modelltypen, wie z. B. Bildgeneratoren, nicht immun gegen diese Art von Zusammenbruch sind:

Soldaini stimmt zu, dass man „rohen“ synthetischen Daten nicht trauen kann, zumindest wenn das Ziel darin besteht, das Training vergesslicher Chatbots und homogener Bildgeneratoren zu vermeiden. Um es „sicher“ nutzen zu können, erfordert er seiner Meinung nach eine gründliche Prüfung, Kuratierung und Filterung und idealerweise die Verknüpfung mit frischen, echten Daten – so wie Sie es mit jedem anderen Datensatz tun würden.

Geschieht dies nicht, könnte es irgendwann passieren zum Zusammenbruch des Modells führenbei dem ein Modell in seinen Ausgaben weniger „kreativ“ – und voreingenommener – wird, was schließlich seine Funktionalität ernsthaft beeinträchtigt. Obwohl dieser Prozess erkannt und gestoppt werden könnte, bevor er ernst wird, stellt er ein Risiko dar.

„Forscher müssen die generierten Daten untersuchen, den Generierungsprozess wiederholen und Sicherheitsmaßnahmen identifizieren, um Datenpunkte von geringer Qualität zu entfernen“, sagte Soldaini. „Synthetische Datenpipelines sind keine sich selbst verbessernde Maschine; Ihre Ergebnisse müssen sorgfältig geprüft und verbessert werden, bevor sie für Schulungen verwendet werden.“

Sam Altman, CEO von OpenAI, argumentierte einmal, dass KI dies tun wird eines Tages erzeugt synthetische Daten, die gut genug sind, um sich selbst effektiv zu trainieren. Aber – vorausgesetzt, das ist überhaupt machbar – die Technologie existiert noch nicht. Kein großes KI-Labor hat ein trainiertes Modell veröffentlicht allein auf synthetischen Daten.

Zumindest auf absehbare Zeit scheinen wir Menschen auf dem Laufenden zu brauchen irgendwo um sicherzustellen, dass das Training eines Models nicht schief geht.