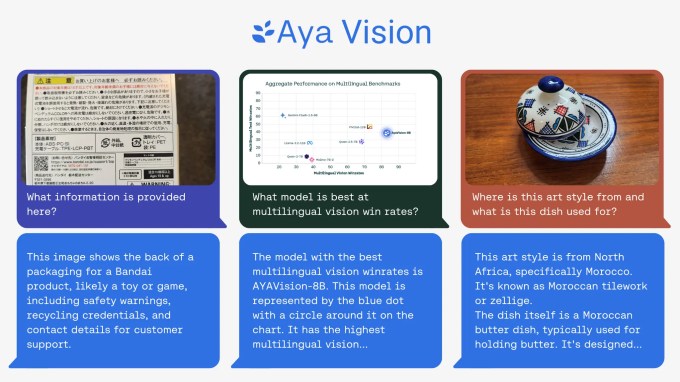

Cohere für AI, AI Startup Coheres gemeinnütziges Forschungslabor, veröffentlichte diese Woche ein multimodales „Open“ -KI-Modell Aya Vision, wie das Labor behauptet, erstklassig.

Aya Vision kann Aufgaben wie das Schreiben von Bildunterschriften, das Beantworten von Fragen zu Fotos, das Übersetzen von Text und das Erstellen von Zusammenfassungen in 23 Hauptsprachen ausführen. Cohere, das auch Aya Vision kostenlos über WhatsApp zur Verfügung stellt, nannte es „einen erheblichen Schritt, um technische Durchbrüche für Forscher weltweit zugänglich zu machen“.

„Während die KI erhebliche Fortschritte erzielt hat, gibt es immer noch eine große Lücke, wie gut Modelle in verschiedenen Sprachen abschneiden – eine, die bei multimodalen Aufgaben, die sowohl Text als auch Bilder beinhalten, noch deutlicher wird“, schrieb Cohere in a Blog -Beitrag. „Aya Vision zielt darauf ab, diese Lücke ausdrücklich zu schließen.“

Aya Vision gibt es in ein paar Geschmacksrichtungen: Aya Vision 32b und Aya Vision 8b. Die anspruchsvollere der beiden Aya Vision 32b setzt eine „neue Grenze“, sagte Cohere und übertroffene Modelle 2x seine Größe, einschließlich Metas Lama-3.2 90b Vision auf bestimmte visuelle Verständnis-Benchmarks. Aya Vision 8b erzielt nach einigen Bewertungen laut Cohere besser als die Modelle 10x seine Größe.

Beide Modelle sind verfügbar Von der AI Dev Platform umarmt das Gesicht unter einer Creative Commons 4.0 -Lizenz mit Coheres akzeptabler Gebrauchszusatz. Sie können nicht für kommerzielle Anwendungen verwendet werden.

Coher sagte, dass Aya Vision mit einem „vielfältigen Pool“ englischer Datensätze geschult wurde, das das Labor übersetzt und zur Erstellung von synthetischen Annotationen verwendet wurde. Annotationen, auch als Tags oder Bezeichnungen bezeichnet, helfen Modellen, Daten während des Schulungsprozesses zu verstehen und zu interpretieren. Beispielsweise kann die Annotation zum Ausbilden eines Bildkennungsmodells in Form von Markierungen um Objekte oder Untertitel in Anspruch nehmen, die sich auf jede Person, Stelle oder Objekt beziehen, die in einem Bild abgebildet ist.

Die Verwendung synthetischer Anmerkungen durch Cohere – dh durch KI erzeugte Anmerkungen, ist im Trend. Trotz seiner potenziellen Nachteile nutzen Konkurrenten einschließlich OpenAI zunehmend synthetische Daten, um Modelle zu schulen, da das Bohrloch der realen Daten ausgeht. Forschungsunternehmen Gartner Schätzungen Dass 60% der Daten für KI- und Analyseprojekte im vergangenen Jahr verwendet wurden, wurden synthetisch erstellt.

Laut Cohere ermöglichte das Training von Aya Vision in synthetischen Anmerkungen das Labor, weniger Ressourcen zu verwenden und gleichzeitig die Wettbewerbsleistung zu erzielen.

„Dies zeigt unseren kritischen Fokus auf Effizienz und [doing] Mehr mit weniger Berechnen “, schrieb Cohere in seinem Blog. „Dies ermöglicht auch eine größere Unterstützung für die Forschungsgemeinschaft, die häufig einen eingeschränkteren Zugang zu Rechenressourcen hat.“

Zusammen mit Aya Vision veröffentlichte Cohere auch eine neue Benchmark-Suite, AyavisionBench, die die Fähigkeiten eines Modells in „Vision-Sprach-Aufgaben“ wie die Identifizierung von Unterschieden zwischen zwei Bildern und der Konvertierung von Screenshots in Code untersuchen soll.

Die KI -Industrie befindet sich inmitten dessen, was einige als „Bewertungskrise“ bezeichnet haben, eine Folge der Populalisierung von Benchmarks, die aggregierte Werte bieten, die schlecht mit den Aufgaben korrelieren. Cohere behauptet, dass AyavisionBench ein Schritt zur Behebung dessen ist und ein „breites und herausforderndes“ Rahmen für die Beurteilung des bringenden und multimodalen Verständnisses eines Modells bietet.

Mit etwas Glück ist das tatsächlich der Fall.

“[T]Der Datensatz dient als robuster Benchmark für die Bewertung von Visionsprachmodellen in mehrsprachigen und realen Umgebungen “ schrieb in einem Beitrag auf umarmtes Gesicht. „Wir stellen diese Bewertungsset für die Forschungsgemeinschaft zur Verfügung, um mehrsprachige multimodale Bewertungen voranzutreiben.“